つい先日、 DeepSeek-V3 がやばい(語彙力・・・)と話題になりましたが、その直後に DeepSeek-R1 がリリースされ、これまたやばいと噂です。

なんと、最大6710億パラメータのMoEモデルのDeepSeek-V3をベースとして、強化学習によってその能力を飛躍的に向上させているのです! AIME 2024においては79.8%、MATH-500においては97.3%の正解率を叩き出し、あのOpenAIのo1-1217モデルに匹敵する性能を示しています。これは、まさにAIの歴史の新たな1ページを刻む出来事と言えるでしょう。DeepSeek-R1は、従来の教師あり学習に頼らず、自己学習によって推論能力を獲得する革新的なアプローチを採用しています。

この記事では、DeepSeek-R1の概要、その革新的な技術、学習プロセス、性能評価、将来展望、そして、失敗した試みなどについて詳細に解説します。

DeepSeek-R1とは?

DeepSeek-R1の概要

DeepSeek-R1は、深層学習モデルの推論能力を向上させるために開発された、新しいAIモデルです。従来のモデルとは異なり、教師あり学習ではなく、強化学習(RL)を主要な学習手法として採用しています。このアプローチにより、DeepSeek-R1は、人間が事前に用意したデータセットに依存することなく、自ら試行錯誤を繰り返しながら、複雑な問題解決能力を獲得することができます。

DeepSeek-R1は、特に数学、コーディング、科学的推論などの分野で優れた性能を発揮します。例えば、数学オリンピックの問題を解いたり、プログラムのコードを生成したり、科学的な仮説を検証したりすることが可能です。これらのタスクは、従来のAIモデルにとっては非常に難易度が高く、人間レベルの推論能力が要求されます。DeepSeek-R1は、強化学習によって、これらのタスクを高い精度で実行する能力を獲得しました。

DeepSeek-R1は、DeepSeek-V3-Baseというモデルをベースに開発されました。DeepSeek-V3-Baseは、6710億のパラメータを持つ、MoE(Mixture of Experts)アーキテクチャを採用した大規模言語モデルです。DeepSeek-R1は、この強力なベースモデルに、強化学習によるファインチューニングを施すことで、推論能力をさらに向上させています。

皆さんは、AIがどのようにして複雑な問題を解決しているのか、疑問に思ったことはありませんか?DeepSeek-R1は、その疑問に答える一つの鍵となるかもしれません。

DeepSeek-V3についてはこちらに詳細を記載していますので、ぜひご覧ください!

関連記事:DeepSeek v3 の実力と活用法:6710億パラメータのオープンソースMoEモデル

DeepSeek-R1の特徴

DeepSeek-R1の最大の特徴は、以下の通りです。

- 強化学習(RL)の採用:

- 従来の教師あり学習ではなく、強化学習を主要な学習手法として採用

- 自ら試行錯誤を繰り返しながら、最適な行動を学習

- 人間が新しいスキルを習得する過程に類似

- 高い推論能力:

- 数学、コーディング、科学的推論などの分野で人間レベルの性能を発揮

- 複雑な問題解決や高度な推論タスクを高精度で実行可能

- 推論過程の透明性:

- 思考プロセスを「”<think>”」と「”</think>”」のタグで囲んで出力

- 最終的な答えを「”<answer>”」と「”</answer>”」のタグで囲んで出力

- ユーザーはAIの意思決定プロセスを詳細に追跡可能

- DeepSeek-V3-Baseベース:

- 6710億パラメータのMoEモデルであるDeepSeek-V3-Baseをベースに開発

- 強力なベースモデルに強化学習によるファインチューニングを実施

では、この透明性は、なぜ重要なのでしょうか?それは、AIの意思決定プロセスを理解することで、AIへの信頼を高め、より効果的に活用できるようになるからです。

DeepSeek-R1の性能評価

DeepSeek-R1は、様々なベンチマークテストにおいて、従来のAIモデルを凌駕する驚異的な性能を示しています。以下に、その一部を紹介します。

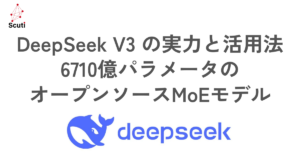

まず、DeepSeek-R1を含む複数のモデルにおける各種ベンチマークの性能比較を示したグラフをご覧ください。

上記のグラフは、複数のモデルにおける各種ベンチマークにおける性能比較を示しています。

特に、数学オリンピックの問題セットであるAIME 2024に着目すると、DeepSeek-R1が他のモデルと比較して高い性能を示していることがわかります。これは、DeepSeek-R1が強化学習とその他の技術によって、高い推論能力を獲得していることを示唆する結果です。他にも以下のような結果が読み取れます。

- MMLU (4択問題における多分野の知識を評価):DeepSeek-R1は、OpenAIのo1-1217モデルにわずかに及ばないものの、他のモデルを上回る90.8%の正解率を達成。

- MATH-500 (大学レベルの数学問題): DeepSeek-R1は、他のモデルを大きく引き離し、97.3%という非常に高い正解率を達成。

次に、DeepSeek-R1と他の代表的なAIモデルの性能を、複数のベンチマークテストで比較した結果を見てみましょう。

一般性能(問題と回答は英語)

| Benchmark (Metric) | 評価内容 | Claude-3.5-Sonnet-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| MMLU (Pass@1) | 4択問題における多分野の知識を評価 | 88.3 | 87.2 | 88.5 | 85.2 | 91.8 | 90.8 |

| MMLU-Redux (EM) | 4択問題における多分野の知識を評価(曖昧な選択肢を除外) | 88.9 | 88.0 | 89.1 | 86.7 | – | 92.9 |

| MMLU-Pro (EM) | 6択問題における多分野の知識を評価 | 78.0 | 72.6 | 75.9 | 80.3 | – | 84.0 |

| DROP (3-shot F1) | 文章読解における推論能力を評価 | 88.3 | 83.7 | 91.6 | 83.9 | 90.2 | 92.2 |

| IF-Eval (Prompt Strict) | 指示への正確な応答能力を評価 | 86.5 | 84.3 | 86.1 | 84.8 | – | 83.3 |

| GPQA-Diamond (Pass@1) | 専門家レベルの科学的知識を評価 | 65.0 | 49.9 | 59.1 | 60.0 | 75.7 | 71.5 |

| SimpleQA (Correct) | 事実に基づく質問への回答能力を評価 | 28.4 | 38.2 | 24.9 | 7.0 | 47.0 | 30.1 |

| FRAMES (Acc.) | 長い文脈の理解能力を評価 | 72.5 | 80.5 | 73.3 | 76.9 | – | 82.5 |

| AlpacaEval2.0 (LC-winrate) | 文章生成能力を評価 | 52.0 | 51.1 | 70.0 | 57.8 | – | 87.6 |

| ArenaHard (GPT-4-1106) | 複雑な推論タスクにおける性能を評価 | 85.2 | 80.4 | 85.5 | 92.0 | – | 92.3 |

コーディング能力

| Benchmark (Metric) | 評価内容 | Claude-3.5-Sonnet-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| LiveCodeBench (Pass@1-COT) | 実際のソフトウェア開発タスクを模倣した問題セット | 33.8 | 34.2 | – | 53.8 | 63.4 | 65.9 |

| Codeforces (Percentile) | プログラミングコンテストの問題セット | 20.3 | 23.6 | 58.7 | 93.4 | 96.6 | 96.3 |

| Codeforces (Rating) | プログラミングコンテストの問題セット | 717 | 759 | 1134 | 1820 | 2061 | 2029 |

| SWE Verified (Resolved) | ソフトウェアエンジニアリングのタスク | 50.8 | 38.8 | 42.0 | 41.6 | 48.9 | 49.2 |

| Aider-Polyglot (Acc.) | 複数のプログラミング言語を扱う能力 | 45.3 | 16.0 | 49.6 | 32.9 | 61.7 | 53.3 |

数学能力

| Benchmark (Metric) | 評価内容 | Claude-3.5-Sonnet-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| AIME 2024 (Pass@1) | アメリカ数学招待試験 | 16.0 | 9.3 | 39.2 | 63.6 | 79.2 | 79.8 |

| MATH-500 (Pass@1) | 大学レベルの数学問題 | 78.3 | 74.6 | 90.2 | 90.0 | 96.4 | 97.3 |

| CNMO 2024 (Pass@1) | 中国数学オリンピック | 13.1 | 10.8 | 43.2 | 67.6 | – | 78.8 |

中国語能力

| Benchmark (Metric) | 評価内容 | Claude-3.5-Sonnet-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| CLUEWSC (EM) | 中国語の文章理解能力 | 85.4 | 87.9 | 90.9 | 89.9 | – | 92.8 |

| C-Eval (EM) | 中国語の多肢選択式問題 | 76.7 | 76.0 | 86.5 | 68.9 | – | 91.8 |

| C-SimpleQA (Correct) | 中国語の事実に基づく質問への回答能力 | 55.4 | 58.7 | 68.0 | 40.3 | – | 63.7 |

DeepSeek-R1は、特に数学とコーディングの分野で、他のモデルを圧倒する性能を示しています。これは、DeepSeek-R1の強力な推論能力の証と言えるでしょう。

さらに、DeepSeek-R1は、知識を問うタスクや、一般的なタスクにおいても優れた性能を示しました。例えば、MMLU(4択問題における多分野の知識を評価)においては90.8%、MMLU-Pro(6択問題における多分野の知識を評価)においては84.0%、GPQA Diamond(専門家レベルの科学的知識を評価)においては71.5%、C-Eval(中国語の多肢選択式問題)においては91.8%の正解率を達成しました。また、AlpacaEval 2.0(文章生成能力を評価)とArenaHard(複雑な推論タスクにおける性能を評価)においては、それぞれ87.6%と92.3%という高い勝率を達成しました。これらの結果から、DeepSeek-R1は、幅広い分野の知識を持ち、様々なタスクをこなすことができる、汎用的なAIモデルであることがわかります。

DeepSeek-R1は、長い文脈を理解する能力にも優れています。例えば、FRAMES(長い文脈の理解能力を評価)やDROP(文章読解における推論能力を評価)というベンチマークでは、長い文書を読解し、それに基づいて質問に答える能力が評価されます。DeepSeek-R1は、このベンチマークにおいて、それぞれ82.5%、92.2%の正解率を達成し、他のモデルを大きく上回りました。この結果は、DeepSeek-R1が、長い文書や複雑な状況を理解し、それに基づいて推論を行う能力を持っていることを示しています。

DeepSeek-R1の革新的技術

強化学習による推論能力の獲得

DeepSeek-R1の革新性は、強化学習(RL)を用いて推論能力を獲得している点にあります。従来のAIモデルは、主に教師あり学習によって訓練されてきました。教師あり学習では、人間が事前に用意した大量のデータセットを用いて、モデルに入力と出力の対応関係を学習させます。しかし、このアプローチでは、モデルの性能はデータセットの質と量に大きく依存してしまいます。また、人間が想定していないような、新しい問題や状況に対応することが難しいという課題もありました。

一方、DeepSeek-R1は、強化学習によって、自ら試行錯誤を繰り返しながら、最適な行動を学習します。強化学習では、モデルは環境と相互作用しながら、報酬を最大化するように行動を学習します。DeepSeek-R1の場合、環境は推論タスクであり、報酬はタスクの正解率です。モデルは、タスクを解くための様々な方策を試し、正解率が高くなるような方策を学習していきます。

- 教師あり学習: 人間が用意したデータセットから学習

- 強化学習: 環境との相互作用を通じて、報酬を最大化するように学習

この学習プロセスは、人間が新しいスキルを習得する過程に似ています。人間は、最初から完璧な方法を知っているわけではなく、何度も失敗を繰り返しながら、徐々に上達していきます。DeepSeek-R1も同様に、強化学習によって、失敗から学び、推論能力を向上させていきます。

では、強化学習は、具体的にどのようにして推論能力の向上に貢献しているのでしょうか?次のセクションでは、その具体的なメカニズムについて解説します。

DeepSeek-R1-Zero:純粋な強化学習の可能性

DeepSeek-R1の開発に先立ち、純粋な強化学習のみで推論能力を獲得できるかを検証するために、DeepSeek-R1-Zeroというモデルが開発されました。DeepSeek-R1-Zeroは、教師あり学習による事前学習を一切行わず、強化学習のみで訓練されました。

DeepSeek-R1-Zeroの訓練には、GRPO(Group Relative Policy Optimization)というアルゴリズムが用いられました。GRPOは、従来の強化学習アルゴリズムで必要とされていた、方策モデルと同じサイズの価値モデルを必要としません。代わりに、方策モデルからサンプリングされた複数の出力の報酬を比較することで、価値を推定します。これにより、計算コストを削減し、効率的な学習を実現しています。

DeepSeek-R1-Zeroの訓練では、ルールベースの報酬システムが採用されました。具体的には、以下のようなルールに基づいて報酬が与えられました。

- 数学の問題であれば、最終的な答えが正しいかどうかを判定し、正しければ報酬を与える。

- 思考プロセスを「”<think>”」と「”</think>”」のタグで囲むように、フォーマットに関する報酬を与える。

例えば、数学の問題を解く際には、以下のようなフォーマットで出力するように学習されます。

出力フォーマット:

“<think>”

問題を解くための思考プロセスをここに記述します。

“</think>”

“<answer>”

最終的な答えをここに記述します。

“</answer>”

このように、DeepSeek-R1-Zeroは、人間が問題解決の過程で辿る思考プロセスを模倣するように学習されます。このフォーマットに従うことで、モデルは、問題解決のための論理的なステップを、より明確に、そして順序立てて表現することを学びます。

DeepSeek-R1-Zeroの実験結果は、純粋な強化学習のみでも、高度な推論能力を獲得できることを示しました。例えば、AIME 2024という数学オリンピックの問題セットにおいて、DeepSeek-R1-Zeroは、15.6%から71.0%へと正解率を大幅に向上させました。これは、OpenAIのo1-0912モデルに匹敵する性能です。

| 質問: | a > 1 の時、実数解の合計 √a − √a + x = x はいくつになるか? |

| 応答: | <think> 式 √a − √a + x = x を解くために、まず両辺を2乗します… (√a − √a + x)² = x² ⟹ a − √a + x = x². 内側の平方根の項を分離するために並べ替えます: (a − x)² = a + x ⟹ a² − 2ax² + (x²)² = a + x ⟹ x⁴ − 2ax² − x + (a² − a) = 0 … 待てよ、待て、待て。ここが「ひらめき」の瞬間だ。 正しい合計を特定するために、このステップを再評価してみよう… 我々は以下の式から始めた: √a − √a + x = x まず、両辺を2乗します: a − √a + x = x² ⟹ √a + x = a − x² 次に、両辺を再度2乗します、式を扱うために: … … |

さらに、DeepSeek-R1-Zeroは、学習の過程で、「ひらめき」とも言えるような、興味深い挙動を示しました。例えば、ある数学の問題を解いている際に、一度は間違った方向に進みかけたものの、途中で「Wait, wait. Wait. That’s an aha moment I can flag here.」と自問自答し、正しい解法にたどり着くということがありました。これは、DeepSeek-R1-Zeroが、単に問題を解くだけでなく、自分の思考プロセスを反省し、修正する能力を獲得したことを示唆しています。

この「ひらめき」は、どのようにして生まれたのでしょうか?それは、強化学習によって、モデルが膨大な試行錯誤を繰り返す中で、偶然にも効果的な推論パターンを発見したからです。これは、人間が新しいアイデアを生み出すプロセスとよく似ています。DeepSeek-R1-Zeroの「ひらめき」は、AIが人間のように思考し、学習する能力を持っていることを示す、興味深い事例と言えるでしょう。

DeepSeek-R1:人間の知識の活用

DeepSeek-R1-Zeroの実験結果は、純粋な強化学習の可能性を示しましたが、一方で、いくつかの課題も明らかになりました。例えば、DeepSeek-R1-Zeroの出力は、人間にとって読みにくく、複数の言語が混在していることがありました。また、学習の初期段階では、不安定な挙動を示すこともありました。

これらの課題を解決するために、DeepSeek-R1では、人間の知識を活用するアプローチが採用されました。具体的には、少量の高品質なデータセットを用いて、モデルを事前に教師あり学習でファインチューニングしました。このデータセットには、人間が作成した、論理的で読みやすい推論プロセスが含まれています。

この事前学習により、DeepSeek-R1は、

- より安定した学習が可能

- 人間にとって理解しやすい推論プロセスを生成

- 人間の知識を活用して、より効率的に推論能力を獲得

といったことが可能になりました。

具体的には、数千件のCoT(Chain of Thought)データを用いて、DeepSeek-V3-Baseモデルをファインチューニングしました。このCoTデータは、人間が推論問題を解く際の思考プロセスを、自然言語で記述したものです。このデータを用いることで、モデルは、人間がどのように推論を行うかを学習することができます。さらに、このCoTデータは、読みやすさや論理性を考慮して、厳選されたものです。そのため、モデルは、人間にとって理解しやすい、質の高い推論プロセスを生成することを学習できます。

では、この人間の知識の活用は、具体的にどのような効果をもたらしたのでしょうか?次のセクションでは、DeepSeek-R1の段階的な学習プロセスについて詳しく見ていきましょう。

段階的な学習プロセス

DeepSeek-R1の学習プロセスは、複数の段階に分かれています。具体的には以下の4つの段階があります。

- Cold Start: 少量の高品質なCoTデータセットを用いて、モデルを教師あり学習でファインチューニング。

- Reasoning-oriented Reinforcement Learning: 推論タスクに特化した強化学習を実施。数学、コーディング、科学的推論などのタスクを用いて、モデルの推論能力を集中的に向上。

- Rejection Sampling and Supervised Fine-Tuning: 強化学習の収束後、モデルの出力をさらに改善するために、リジェクションサンプリングと教師あり学習を組み合わせた手法を実施。具体的には、モデルに様々な推論タスクを解かせ、その中から正解したサンプルのみを抽出。そして、これらのサンプルを用いて、再度モデルを教師あり学習でファインチューニング。

- Reinforcement Learning for all Scenarios: 最後に、モデルの汎用性を高めるために、様々なタスクを含むデータセットを用いて、再度強化学習を実施。

具体的には、推論タスクに特化した強化学習の段階では、ルールベースの報酬システムを用いて、モデルの推論能力を向上させます。例えば、数学の問題であれば、最終的な答えが正しいかどうかを判定し、正しければ報酬を与えます。また、コード生成タスクであれば、生成されたコードが正しく動作するかどうかをテストし、正しく動作すれば報酬を与えます。さらに、推論プロセスが論理的で、人間にとって理解しやすいかどうかを評価し、それに応じて報酬を与えます。これらの報酬に基づいて、モデルは、より正確で、人間にとって理解しやすい推論プロセスを生成するように学習していきます。

リジェクションサンプリングと教師あり学習を組み合わせた段階では、約60万件の推論関連のトレーニングサンプルと、約20万件の非推論関連のトレーニングサンプルを用いて、モデルをファインチューニングします。非推論関連のトレーニングサンプルには、文章生成、質問応答、要約などのタスクが含まれます。これらのタスクを学習することで、モデルは、推論能力だけでなく、幅広いタスクに対応できる汎用性を獲得します。

この段階的な学習プロセスによって、DeepSeek-R1は、高い推論能力を獲得しているのです。

DeepSeek-R1の将来展望

さらなる能力向上に向けて

DeepSeek-R1は、AIの推論能力を飛躍的に向上させる可能性を示しましたが、まだ発展途上の技術です。今後、さらなる能力向上に向けて、以下のような研究開発が進められる予定です。

- 汎用的なタスクにおける能力の向上: 文章生成や質問応答など、一般的なタスクにおける性能向上を目指す。

- 多言語対応: 英語と中国語だけでなく、より多くの言語に対応させる。

- プロンプトエンジニアリングの研究: DeepSeek-R1の能力を最大限に引き出すための最適なプロンプト設計方法を研究。

- ソフトウェアエンジニアリングへの応用: コード生成、バグ検出など、ソフトウェア開発を支援する機能を強化。

- 小規模モデルへの知識蒸留: より効率的にDeepSeek-R1の能力を利用するための技術開発。

- 知識蒸留と強化学習の組み合わせ: 両者を組み合わせた、より効果的な学習方法の研究。

ソフトウェアエンジニアリングへの応用

DeepSeek-R1の推論能力は、ソフトウェアエンジニアリングの分野においても、大きな可能性を秘めています。例えば、コードの自動生成、バグの自動検出、ソフトウェアの自動テストなど、様々なタスクにDeepSeek-R1を応用することが考えられます。

しかし、現在のDeepSeek-R1は、ソフトウェアエンジニアリングのタスクにおいては、まだ十分な性能を発揮できていません。これは、ソフトウェアエンジニアリングのタスクが、他の推論タスクと比較して、より複雑で、多様な知識を必要とするためです。

今後は、ソフトウェアエンジニアリングに特化したデータセットを用いて、DeepSeek-R1を学習させることで、この分野における性能を向上させることが期待されます。また、ソフトウェアエンジニアリングの専門家と協力して、DeepSeek-R1を実世界のソフトウェア開発に適用するための研究開発も進められる予定です。具体的には、ソフトウェアエンジニアが日常的に使用するプログラミング言語や開発ツールに、DeepSeek-R1を統合することが検討されています。これにより、ソフトウェアエンジニアは、DeepSeek-R1の支援を受けながら、より効率的にソフトウェアを開発できるようになります。

さらに、DeepSeek-R1を用いて、ソフトウェアの品質を向上させることも期待されます。例えば、DeepSeek-R1に、ソフトウェアの仕様書とコードを入力し、仕様書とコードの間に矛盾がないかを検証させることができます。また、DeepSeek-R1に、コードの潜在的なバグを検出させることもできます。これらの技術が実用化されれば、ソフトウェアの品質が向上し、より安全で信頼性の高いソフトウェアを開発できるようになります。

小規模モデルへの知識蒸留

DeepSeek-R1は、6710億のパラメータを持つ巨大なモデルであり、その運用には膨大な計算リソースが必要です。そのため、DeepSeek-R1の推論能力を、より効率的に利用するための方法として、知識蒸留が注目されています。

知識蒸留とは、大規模なモデル(教師モデル)の知識を、より小さなモデル(生徒モデル)に転移する技術です。DeepSeek-R1の開発では、この知識蒸留を用いて、DeepSeek-R1の推論能力を、QwenやLlamaなどの小規模なモデルに転移する実験が行われました。

その結果、DeepSeek-R1から知識蒸留を受けた小規模モデルは、元のモデルを大幅に上回る性能を示しました。例えば、DeepSeek-R1-Distill-Qwen-32Bは、AIME 2024において72.6%、MATH-500において94.3%、LiveCodeBenchにおいて57.2%の正解率を達成しました。これらの結果は、知識蒸留が、DeepSeek-R1の推論能力を効率的に利用するための有効な手段であることを示しています。

| Model | AIME 2024 pass@1 | AIME 2024 cons@64 | MATH-500 pass@1 | GPQA Diamond pass@1 | LiveCodeBench pass@1 | CodeForces rating |

|---|---|---|---|---|---|---|

| GPT-4o-0513 | 9.3 | 13.4 | 74.6 | 49.9 | 32.9 | 759 |

| Claude-3.5-Sonnet-1022 | 16.0 | 26.7 | 78.3 | 65.0 | 38.9 | 717 |

| o1-mini | 63.6 | 80.0 | 90.0 | 60.0 | 53.8 | 1820 |

| QwQ-32B-Preview | 44.0 | 60.0 | 90.6 | 54.5 | 41.9 | 1316 |

| DeepSeek-R1-Distill-Qwen-1.5B | 28.9 | 52.7 | 83.9 | 33.8 | 16.9 | 954 |

| DeepSeek-R1-Distill-Qwen-7B | 55.5 | 83.3 | 92.8 | 49.1 | 37.6 | 1189 |

| DeepSeek-R1-Distill-Qwen-14B | 69.7 | 80.0 | 93.9 | 59.1 | 53.1 | 1481 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 | 57.2 | 1691 |

| DeepSeek-R1-Distill-Llama-8B | 50.4 | 80.0 | 89.1 | 49.0 | 39.6 | 1205 |

| DeepSeek-R1-Distill-Llama-70B | 70.0 | 86.7 | 94.5 | 65.2 | 57.5 | 1633 |

知識蒸留は、計算リソースが限られている環境でも、DeepSeek-R1の推論能力を利用できるという点で、非常に有用です。例えば、スマートフォンやタブレットなどのモバイルデバイスでも、DeepSeek-R1の推論能力を活用できるようになります。また、知識蒸留によって、モデルのサイズが小さくなるため、推論速度が向上し、消費電力も削減できます。これらの利点から、知識蒸留は、DeepSeek-R1の実用化に向けた重要な技術の一つと考えられています。

蒸留と強化学習の比較

では、知識蒸留と強化学習は、どちらが優れた方法なのでしょうか?

DeepSeek-R1の開発では、知識蒸留と強化学習の比較実験も行われました。具体的には、Qwen-32B-Baseというモデルに対して、DeepSeek-R1から知識蒸留を行った場合と、強化学習を行った場合の性能を比較しました。

その結果、知識蒸留を行ったモデル(DeepSeek-R1-Distill-Qwen-32B)は、強化学習を行ったモデル(DeepSeek-R1-Zero-Qwen-32B)を大幅に上回る性能を示しました。この結果は、小規模なモデルにおいては、知識蒸留が強化学習よりも効果的な学習方法であることを示唆しています。

| Model | AIME 2024 | MATH-500 | GPQA Diamond | LiveCodeBench |

|---|---|---|---|---|

| pass@1 | cons@64 | pass@1 | pass@1 | |

| QwQ-32B-Preview | 50.0 | 60.0 | 90.6 | 54.5 |

| DeepSeek-R1-Zero-Qwen-32B | 47.0 | 60.0 | 91.6 | 55.0 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 |

しかし、一方で、強化学習は、知識蒸留では獲得できないような、新しい推論能力を獲得できる可能性を秘めています。そのため、今後は、知識蒸留と強化学習を組み合わせた、より効果的な学習方法の研究開発が期待されます。例えば、知識蒸留によって、モデルに基本的な推論能力を学習させた後、強化学習によって、さらに高度な推論能力を獲得させることが考えられます。また、強化学習によって獲得された新しい推論能力を、知識蒸留によって、他のモデルに転移することもできるでしょう。

知識蒸留と強化学習を組み合わせることで、AIの推論能力をさらに向上させ、より複雑な問題解決や、より高度なタスクの実行が可能になると期待されます。これらの技術の発展は、AIの可能性を大きく広げ、人間社会に貢献するAIの実現に繋がっていくでしょう。

今後の展望

では、これらの技術は、具体的にどのような形で社会に貢献していくのでしょうか?

DeepSeek-R1は、AIの推論能力を飛躍的に向上させる可能性を示しましたが、まだ発展途上の技術です。今後は、さらなる能力向上に向けて、様々な研究開発が進められる予定です。

具体的には、汎用的なタスクにおける能力の向上、多言語対応、プロンプトエンジニアリングの研究、ソフトウェアエンジニアリングへの応用、小規模モデルへの知識蒸留、そして、知識蒸留と強化学習を組み合わせた学習方法の研究などが挙げられます。

これらの研究開発を通じて、DeepSeek-R1は、より高度な推論能力を獲得し、人間社会に貢献するAIとして、さらなる進化を遂げることが期待されます。例えば、DeepSeek-R1が、人間の専門家と同等、あるいはそれ以上のレベルで、複雑な問題を解決できるようになるかもしれません。また、DeepSeek-R1が、人間と自然な対話を行い、人間の指示を理解し、それに基づいて行動できるようになるかもしれません。さらに、DeepSeek-R1が、新しい知識を発見し、創造的なアイデアを生み出すようになるかもしれません。

DeepSeek-R1の進化は、AIの可能性を大きく広げ、人間社会に大きな影響を与えるでしょう。DeepSeek-R1は、人間とAIが協働する未来社会の実現に向けた、重要な一歩となることが期待されます。

DeepSeek-R1は、まだ完璧なAIではありません。しかし、その可能性は無限大です。今後の研究開発によって、DeepSeek-R1がどのように進化していくのか、目が離せません。

その他の情報

失敗した試み

DeepSeek-R1の開発過程では、成功だけでなく、いくつかの失敗した試みもありました。その中でも、特に重要なのが、PRM(Process Reward Model)とMCTS(Monte Carlo Tree Search)を用いたアプローチです。

PRMは、推論の過程を細かくステップに分け、各ステップの正しさを評価することで、モデルの推論能力を向上させようとする手法です。しかし、DeepSeek-R1の開発においては、PRMは期待したほどの効果を発揮しませんでした。その理由として、一般的な推論タスクにおいて、推論のステップを明確に定義することが難しいこと、各ステップの正しさを自動的に評価することが困難であること、そして、モデルが報酬を最大化するために、不正なショートカットを学習してしまう「報酬ハッキング」の問題などが挙げられます。

MCTSは、ゲームAIなどで用いられる探索アルゴリズムであり、可能な行動をツリー状に展開し、最も有望な行動を選択していく手法です。DeepSeek-R1の開発では、MCTSを用いて、推論の過程を探索し、最適な解を導き出そうとしました。しかし、MCTSもまた、期待したほどの効果を発揮しませんでした。その理由として、推論タスクにおいては、可能な行動の数が膨大であり、効率的な探索が難しいこと、そして、探索の方向性を導くための適切な評価関数を設計することが困難であることが挙げられます。

これらの失敗した試みから、DeepSeek-R1の開発チームは、推論能力の向上には、単に既存の手法を適用するだけでなく、推論タスクの特性に合わせた、新しいアプローチが必要であることを学びました。そして、その学びが、DeepSeek-R1の成功に繋がったのです。

失敗から学ぶことは、成功への近道です。DeepSeek-R1の開発における失敗談は、今後のAI研究開発において、貴重な教訓となるでしょう。

結論、制限、および今後の課題

DeepSeek-R1は、強化学習を用いてAIモデルの推論能力を向上させるという、新しいアプローチの有効性を示しました。特に、DeepSeek-R1-Zeroは、教師あり学習を一切用いずに、純粋な強化学習のみで、高度な推論能力を獲得できることを実証しました。これは、AIの自己学習能力の可能性を示す、重要な成果です。

しかし、DeepSeek-R1には、まだいくつかの制限があります。例えば、現在のDeepSeek-R1は、主に英語と中国語にしか対応していません。また、ソフトウェアエンジニアリングのタスクにおいては、まだ十分な性能を発揮できていません。さらに、DeepSeek-R1は、プロンプトの与え方によって、性能が大きく変化するため、最適なプロンプトを設計するための技術開発が必要です。

今後は、これらの制限を克服し、DeepSeek-R1の能力をさらに向上させるための研究開発が進められる予定です。具体的には、以下のような取り組みが計画されています。

- 多言語対応の強化: 様々な言語のデータセットを用いて学習させることで、英語と中国語以外の言語にも対応できるようにします。

- ソフトウェアエンジニアリングタスクへの最適化: ソフトウェアエンジニアリングに特化したデータセットを用いて学習させ、コード生成やバグ検出などのタスクにおける性能を向上させます。

- プロンプトエンジニアリングの研究: 様々なプロンプトの効果を検証し、DeepSeek-R1の能力を最大限に引き出すための最適なプロンプト設計方法を開発します。

- 知識蒸留と強化学習の組み合わせ: 知識蒸留と強化学習を組み合わせた、より効率的かつ効果的な学習方法を開発します。

これらの取り組みを通じて、DeepSeek-R1は、より汎用的で、高性能なAIモデルへと進化していくことが期待されます。そして、将来的には、様々な分野で人間を支援する、強力なツールとなるでしょう。

活用方法とライセンス

DeepSeek-R1は、Hugging Faceのプラットフォーム上で公開されており、誰でも自由にダウンロードして使用することができます。また、DeepSeek-R1のAPIも公開されており、開発者は自分のアプリケーションにDeepSeek-R1の推論能力を組み込むことができます。さらに、DeepSeek-R1のチャットウェブサイトも公開されており、ユーザーはDeepSeek-R1と直接対話することができます。具体的には、chat.deepseek.comにアクセスし、”DeepThink”ボタンをオンにすることで、DeepSeek-R1との対話が可能です。

DeepSeek-R1のモデルとコードは、MITライセンスの下で公開されています。これは、商用利用を含め、誰でも自由にDeepSeek-R1を使用、改変、再配布できることを意味します。ただし、DeepSeek-R1から派生したモデルについては、それぞれのモデルのライセンスに従う必要があります。例えば、DeepSeek-R1-Distill-Qwen-1.5B、DeepSeek-R1-Distill-Qwen-7B、DeepSeek-R1-Distill-Qwen-14B、DeepSeek-R1-Distill-Qwen-32Bは、Qwen-2.5シリーズをベースとしており、Apache 2.0ライセンスの下で公開されています。また、DeepSeek-R1-Distill-Llama-8Bはllama3.1ライセンス、DeepSeek-R1-Distill-Llama-70Bはllama3.3ライセンスの下で公開されています。

DeepSeek-R1のモデルをローカルで実行するには、DeepSeek-V3リポジトリを参照してください。また、DeepSeek-R1-Distillモデルは、QwenやLlamaモデルと同様の方法で使用することができます。例えば、vLLMを用いて、DeepSeek-R1-Distill-Qwen-32Bのサービスを開始するには、以下のコマンドを実行します。

vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --tensor-parallel-size 2 --max-model-len 32768 --enforce-eagerまた、SGLangを用いてサービスを開始するには、以下のコマンドを実行します。

python3 -m sglang.launch_server --model deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --trust-remote-code --tp 2DeepSeek-R1を使用する際には、温度パラメータを0.5から0.7の間に設定することをお勧めします。また、システムプロンプトは追加せず、すべての指示をユーザープロンプトに含めるようにしてください。さらに、数学の問題を解く際には、”put your final answer within \boxed{}”のような指示をプロンプトに含めると、性能が向上する可能性があります。そして、モデルの性能を評価する際には、複数のテストを実施し、結果を平均化することをお勧めします。

これらの情報を活用することで、DeepSeek-R1の能力を最大限に引き出し、様々なタスクに適用することができるでしょう。