こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

AIシステムを自社サーバー上で運用することに興味がある方々へ。特にプライバシーの確保やコスト削減を重視する企業や開発者にとって、自社サーバーで動作するAIシステムは魅力的な選択肢です。従来のクラウドベースのサービスではデータの外部送信が避けられず、セキュリティやプライバシーに懸念を抱く方も多いですが、ローカルでAIを運用することで、データを自社内で安全に管理し、外部への依存を減らすことが可能となります。

本記事では、リライト元記事に基づいた自社サーバー上で動くAIシステムのメリットと、具体的な6つのツールの詳細な機能や特徴、さらに比較表を用いた情報整理と各見出し毎の十分な文章量を盛り込んだ解説を行います。

以下、各ツールおよび運用上の利点を図表や箇条書き、ボールドなどを活用して詳述いたします。

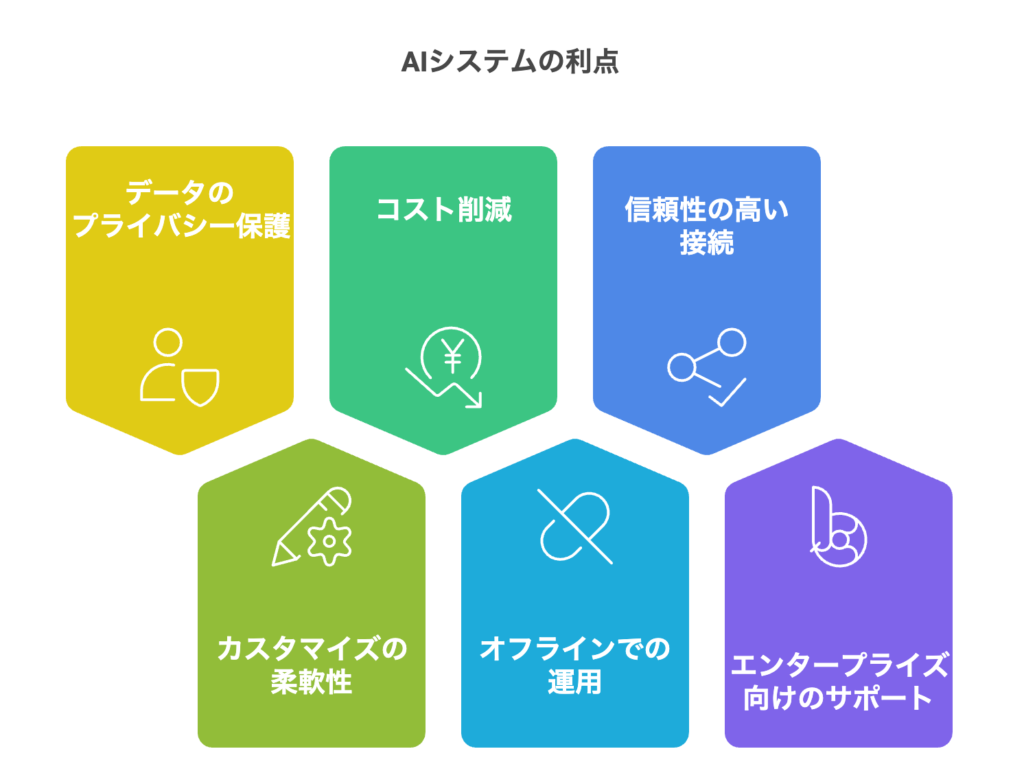

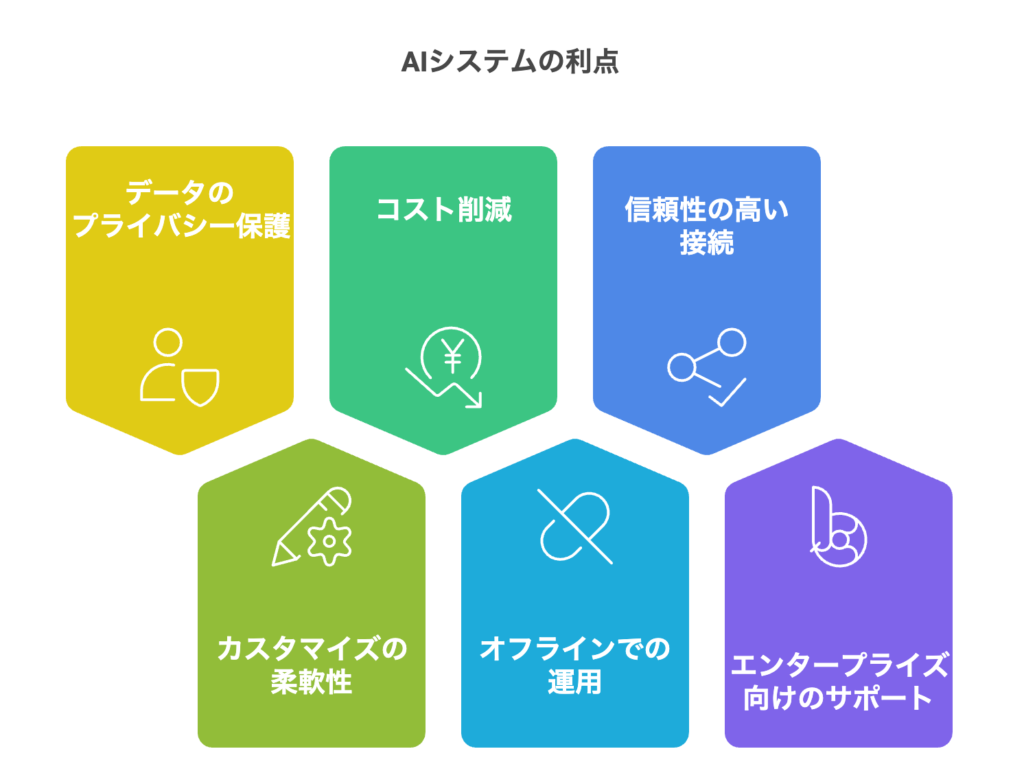

自社サーバー上で動くAIシステムの利点

まずMetaについて知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:Metaが最新言語モデルLlama 3.1を発表!脅威のGPT-4o超え!?

次に、Llama 3.2 について知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:Llama 3.2 の概要:マルチモーダル/オンデバイス対応モデル

次に、Llama 3.3 について知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:Meta社がLlama 3.3を発表|Llama 3.1の405Bに匹敵する性能を70Bで実現!

データのプライバシー保護

自社サーバー上でAIシステムを運用する最大の利点の一つは、データのプライバシー保護です。クラウドベースのサービスでは、ユーザーのデータが外部サーバーに送信されるため、機密情報が漏洩するリスクがあります。

一方、ローカル環境ではデータが完全に社内のデバイスへと留まり、外部からのアクセスを遮断できます。例えば、企業内に閉じたネットワーク環境では、顧客情報、取引先情報、内部資料などの機密データを、暗号化、多段階認証、アクセス制御、監査ログ管理などの独自のセキュリティ対策と連動させることで、外部攻撃のリスクを大幅に軽減できます。

さらに、リライト元記事に記載されている通り、ローカルでの運用はエンドツーエンドの暗号化と同様の高い安全性を実現しており、一部のサービスでは「月間25万人以上のアクティブユーザー」により検証された手法も取り入れられています。こうした徹底したデータ保護の仕組みにより、企業は安心してAIシステムを利用でき、取引先や顧客からの信頼向上につながります。

以下の箇条書きにより、具体的なセキュリティ対策のポイントを整理しました。

- データの完全ローカル保持:外部サーバーに依存せず、データがデバイス内に保管される。

- 暗号化と多段階認証:アクセス制御や監査ログ管理と連動して高度なセキュリティを実現。

- 独自のセキュリティポリシー:企業ごとのセキュリティ基準で運用可能。

- 外部攻撃リスク削減:ネットワークを社内に限定することで、サイバー攻撃のリスクを最小化。

これらの取り組みにより、企業は自社のセキュリティ基準を厳格に維持しつつ、安心してシステムを利用できる環境を確実に整えることができます。内部ネットワークでのデータ保護は、コンプライアンス遵守およびリスク管理の両面で大きな効果を発揮し、将来のシステム拡張時にも柔軟な対応を可能とします.

カスタマイズの柔軟性

自社サーバー上でAIシステムを導入する大きなメリットは、そのカスタマイズ性の高さにあります。従来のクラウドサービスでは、利用可能なパラメーターや設定項目が限られているため、業務固有のニーズに完全に応えることが難しい場合がありました。

しかし、ローカル環境では、以下のような各種パラメーターを自由に調整できます。CPUスレッド数、GPU構成、LLMの温度パラメーター、コンテキストの長さ、さらには社内用の辞書拡充やカスタム設定の反映といった多彩な調整が可能です。この柔軟性により、特定の業務プロセスやユースケースに合わせた最適な応答速度や精度が実現され、内部の運用ノウハウを最大限に活かすことができます。

また、オープンソースコミュニティによる継続的な改善も取り入れやすく、急な業務要件の変更にも迅速に対応可能です。たとえば、独自のAIチャットボットや解析ツールの開発において、各パラメーターの詳細な設定は、システムの性能最適化と長期的なコスト削減に直結します。

これにより、企業は業務効率を着実に向上させることが可能となり、戦略的なシステム運用を実現できます.

コスト削減効果

ローカルで動作するAIシステムの導入は、長期的には大幅なコスト削減を実現します。従来のクラウドサービスでは、API呼び出し毎に料金が発生するため、運用規模が拡大するにつれてコストが増大します。

一方、ローカル環境で利用できる多くのAIツールはオープンソースであり、初期投資とハードウェアコストは必要なものの、従量課金の発生がないため、長期的な運用コストを大幅に削減できます。具体的なメリットとして、外部APIへの依存がなく、追加料金が発生しない点、内部リソースでの保守体制を整えることで外部委託費用を抑制できる点、大量のデータ処理においても送信量に起因する費用負担が発生しない点などが挙げられます。

さらに、削減された資金は研究開発や新技術導入への再投資に充てることができ、企業全体の競争力強化にも寄与します。リライト元記事で示されているように、月間25万人以上のアクティブユーザーを有する実績あるローカルLLMツールも存在しており、その高い費用対効果は証明済みです。

こうした取り組みは、企業の長期的な成長戦略にも大きなプラス要因となります.

オフラインでの運用

自社サーバー上で動作するAIシステムは、オフライン運用が可能な点でも大きなメリットを有しています。インターネット環境が不安定な地域や、災害時、セキュリティ上の理由から完全オフラインでの運用が求められる現場において、ローカルでの実行は大いに役立ちます。例えば、遠隔地の拠点、工場、あるいは医療施設などにおいて、外部回線の影響を受けることなく、内部ネットワーク内で処理が完結するため、安定したサービス提供が可能となります。外部回線への依存がなくなることで、ネットワークの遅延や切断による業務停止リスクが低減され、セキュリティリスクも大幅に下がります。

また、大容量のデータ処理も高速に実行できるため、リアルタイム性が求められる現場での運用にも最適です。こうしたオフライン運用の強みは、企業の事業継続計画としても非常に有効であり、計画外のシステムダウン時にも迅速な対応が可能となる点で信頼性を大きく向上させます.

信頼性の高い接続

クラウドベースのAIシステムでは、インターネット接続状態によってサービスの質が左右されることが多々あります。しかし、自社サーバー上で動作するシステムは、全ての処理が内部ネットワークで完結するため、外部の不安定な通信環境の影響を受けません。内部ネットワークを活用することで、接続の安定性が格段に向上し、リアルタイムな監視体制を組み合わせることで異常が発生した際には即座に原因の特定と対処が可能です。金融機関や医療機関、大企業などミッションクリティカルな業務においては、このような安定した接続環境が求められます。

さらに、ダウンタイムの短縮やトラブル管理が容易になるため、全体の業務効率が向上し、信頼性の高いシステム運用が実現されます。内部ネットワークによる堅牢なデータ通信は、企業の事業継続にも大いに寄与し、安心して業務を遂行するための基盤となります.

エンタープライズ向けのサポート

自社サーバー上で動作するAIツールの多くは、エンタープライズ向けのサポート体制を整備しています。専用のサポート窓口や、強化されたセキュリティ機能、デバイスごとのライセンス管理など、企業規模に合わせた柔軟な運用オプションが提供され、企業は導入後の運用リスクや追加コストを最小限に抑えることができます。具体的には、企業向けの専用窓口による迅速なトラブル対応、企業独自のセキュリティ要件に合わせた機能拡張、さらには定期的なアップデートや運用状況のフィードバックの提供などが挙げられます。

これにより、企業は長期的な視点でシステムを安全かつ安定的に運用できるだけでなく、内部のシステム管理部門との連携もスムーズに進めることが可能となります。エンタープライズ向けのサポートは、企業にとって信頼性と安心感を提供する重要な要素であり、ミッションクリティカルな運用環境においては非常に価値があります.

自社サーバー上で動くAIシステムを実現する6つのツール

GPT4ALL

GPT4ALLは、プライバシーを重視して設計されたローカルAIツールであり、AppleのMシリーズチップを含む幅広いコンシューマーハードウェアに対応しています。このツールを使用することで、インターネット接続を必須とせず、複数の大規模言語モデル(LLM)を安全に実行できます。GPT4ALLは、各種パラメーター(温度、バッチサイズ、コンテキスト長など)のカスタマイズが可能であり、内部ドキュメントの統合解析も実現します。

さらに、リライト元記事に記載されている通り、最大1,000のオープンソースモデルが用意され、LLama、Mistralなど多彩なモデルから選択できる点が大きな魅力です。エンタープライズ向けのサポートも充実しており、ユーザーライセンスの細分管理や強化されたセキュリティ対策、そして活発なGitHubやDiscordコミュニティが支援を提供しています。こうした実績は、月間25万人以上のアクティブユーザーによって裏付けられており、多くの企業や開発者にとって信頼性の高いソリューションとなっています.

主要な特徴:

- 完全なオフライン操作

- 柔軟なパラメーター設定

- 豊富なモデルライブラリ(最大1,000モデル)

- ローカルドキュメントの統合解析

- エンタープライズサポートの提供

Ollama

Ollamaは、OpenAIなどの外部APIに依存せず、LLMを完全にローカル環境で実行できるツールです。ユーザーはこのツールを用いてカスタムチャットボットなどを容易に構築でき、APIサブスクリプションやクラウド依存のコストを回避することが可能です。Ollamaは、gguf形式のモデルファイル変換に対応し、

さらにPyTorchからの直接モデルインポートも実現するため、既存のモデル資産をそのまま活用できます。

また、Webアプリケーションやデスクトップアプリ、さらにはモバイルプラットフォームとのシームレスな統合を可能にする機能も備えており、データベース接続機能も充実しています。

これにより、幅広いユースケースに柔軟に対応できる点が大きな魅力です。

主要な特徴:

- 柔軟なモデルカスタマイズ

- .ggufファイル変換対応

- PyTorchからの直接モデルインポート

- 多様なプラットフォームとの統合性

- データベース接続サポート

LLaMa.cpp

LLaMa.cppは、多くのローカルLLMツールのバックエンドとして利用される、軽量で効率的なツールです。シンプルなセットアップと高いパフォーマンスが特徴であり、Mistral 7B、DBRX、Falconなど幅広い人気モデルをサポートしています。さらに、 MindWorkAI/AI-Studioやiohub/collamaといったフロントエンドとの連携が容易で、直感的なユーザーインターフェイスを提供するため、技術者に非常に人気があります。各種ハードウェアに柔軟に適用できる設計も、エッジ環境での利用を可能にしています.

主要な特徴:

- 簡単なインストールとセットアップ

- 高いパフォーマンスを実現する軽量設計

- 多数の人気モデルに対応(Mistral 7B、DBRX、Falcon)

- 各種フロントエンドとの連携が容易

LM Studio

LM Studioは、Llama 3.1、Mistral、Gemmaなど複数のプロバイダーから提供される「gguf」形式のモデルファイルに対応した強力なローカルLLMツールです。Mac、Windows、Linuxといった複数プラットフォームで利用可能で、ユーザーフレンドリーな直感的インターフェイスを特徴としています。ユーザーは、温度、最大トークン数、頻度ペナルティなど各種パラメーターを細かくカスタマイズできるほか、プロンプト履歴の保存やUIガイダンスにより、初心者でも安心して利用しやすくなっています。さらに、開発者向けのローカル推論サーバーを構築する機能があり、OpenAIのAPIとシームレスに連携できる点も大きな魅力です.

主要な特徴:

- クロスプラットフォーム対応(Mac/Windows/Linux)

- 詳細なパラメーターのカスタマイズ

- プロンプト履歴とUIガイダンスの提供

- ローカル推論サーバーによるAPI互換性

Jan

Janは、ChatGPTなど既存ツールに対するオープンソースの代替手段として、完全にオフラインで動作するよう設計されたツールです。MistralやLlamaなど複数のAIモデルがプリインストールされ、必要に応じて追加モデルのインポートが可能な柔軟性があります。最大トークン数、温度、ストリーミング設定、頻度ペナルティなど各種パラメーターを自由にカスタマイズでき、TensorRTやInference Nitroなどの拡張機能とも統合されています。完全無料でオープンソースであるため、企業や個人利用において高いコストパフォーマンスを実現し、GitHub、Discord、Hugging Faceコミュニティによる充実したサポートを享受できます.

主要な特徴:

- 完全オフラインでの運用が可能

- 70以上のプリインストールモデルを搭載

- 柔軟な推論パラメーターのカスタマイズ

- 拡張機能との統合(TensorRT、Inference Nitro)

- 無料かつオープンソース、強固なコミュニティサポート

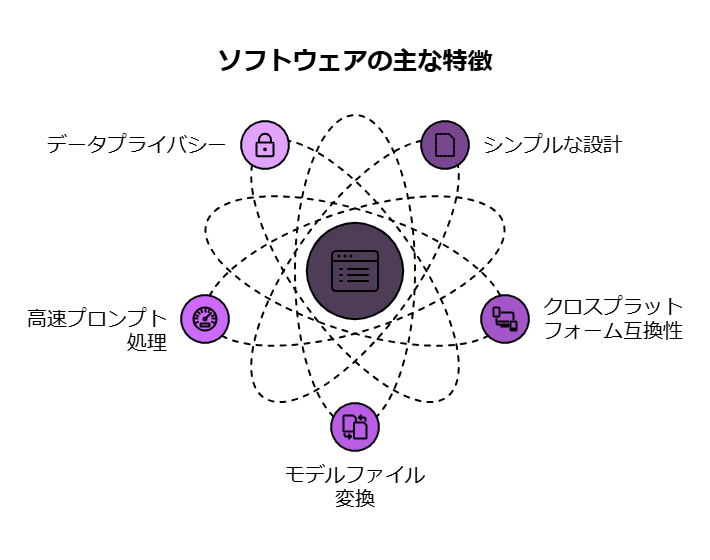

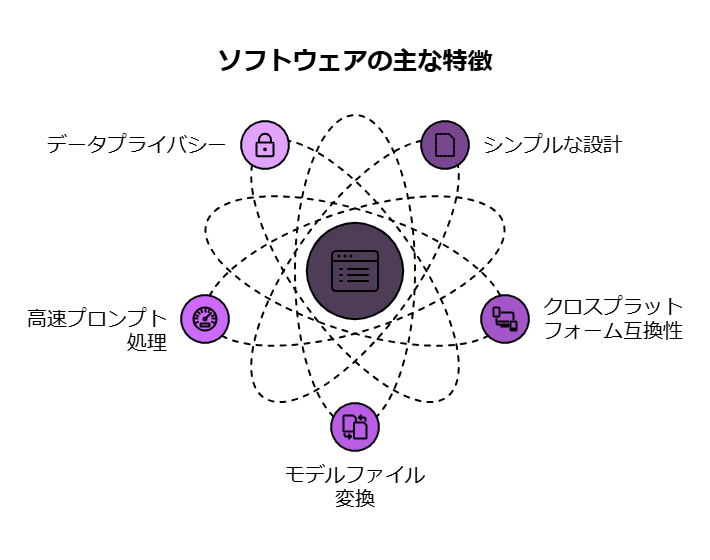

Llamafile

LlamafileはMozillaが提供する、LLMをローカルで実行するためのシンプルかつ効率的なツールです。単一の実行可能ファイルにより、追加のSDKや複雑なセットアップを必要とせず、Windows、macOS、Linux、Intel、ARM、FreeBSDなど、幅広いアーキテクチャ上で動作します。さらに、.gguf形式のモデルファイルを1コマンドで迅速に変換できるため、高速なプロンプト処理や長文の要約、リアルタイムデータ処理が求められる環境においても、その性能を発揮します。完全にオフラインで運用されるため、データプライバシーが保証され、企業の機密情報の保持にも適しています.

主要な特徴:

- 単一の実行可能ファイルで完結するシンプルな設計

- 多種多様なアーキテクチャに対応(Windows, macOS, Linux等)

- .gguf形式のモデルファイルを迅速に変換

- 高速なプロンプト処理と高性能な実行環境

- 完全オフラインによるデータプライバシー保証

自社サーバー上で動くAIシステムのユースケース

プライベートドキュメントのクエリ

自社サーバー上で運用されるAIシステムは、プライベートドキュメントのクエリに最適です。企業の機密文書、顧客情報、内部報告書などの外部に漏らすことができない重要なデータを、クラウドへ送信するリスクなしに解析できます。ローカル環境では、内部専用の暗号化技術やアクセス制御、監査ログ管理などの仕組みが統合され、解析結果も外部に漏れることなく、常にセキュアな状態が維持されます。コンプライアンス遵守や業務効率の向上という観点からも、この手法は非常に有効であり、企業内の機密性の高い情報分析に最適です。以下のポイントが、その効果を具体的に示しています.

- 機密データの漏洩リスクを徹底的に回避

- 社内ネットワーク内で安全なデータ解析を実現

- 内部暗号化技術と多段階認証による情報保護

- コンプライアンス遵守の強固なサポート

このようなシステム運用により、企業は安心して重要データの解析を行いながら、高いセキュリティ基準を維持することができます.

リモートおよびオフライン環境での運用

インターネット接続に依存しない自社サーバー上でのAIシステムは、リモートやオフライン環境での運用に最適です。遠隔地の支店、工場、医療施設など、ネットワーク環境が不安定な状況下でも、内部ネットワーク内で処理が完結するため、安定したサービス提供が保証されます。外部回線の影響を受けないため、システムが常に稼働し、緊急時でも迅速に対応可能な体制を構築できます。また、この方法により、セキュリティリスクの大幅な低減も実現され、現場での安心感を確保することができます.

ポイント:

- 外部回線の影響を受けない安定した処理環境

- セキュリティリスクの大幅な低減

- 緊急時にも継続可能なオフライン運用

- 内部ポリシーによる迅速な対応体制の確立

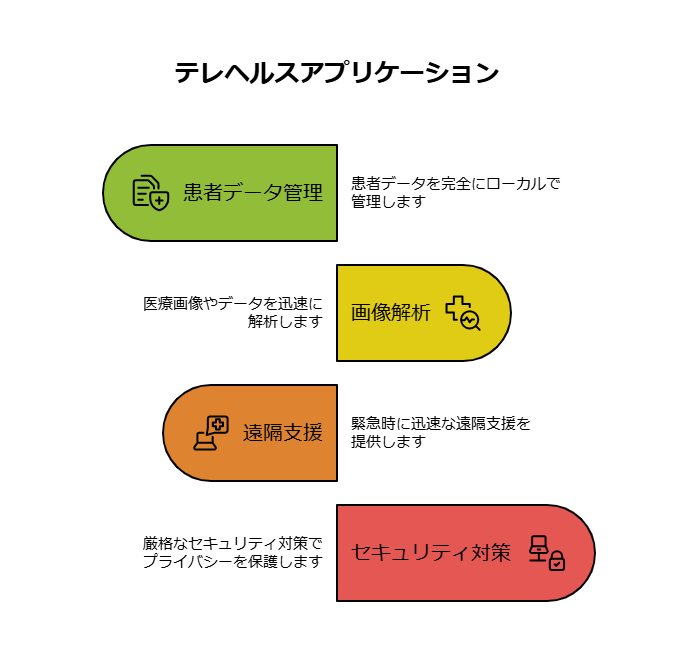

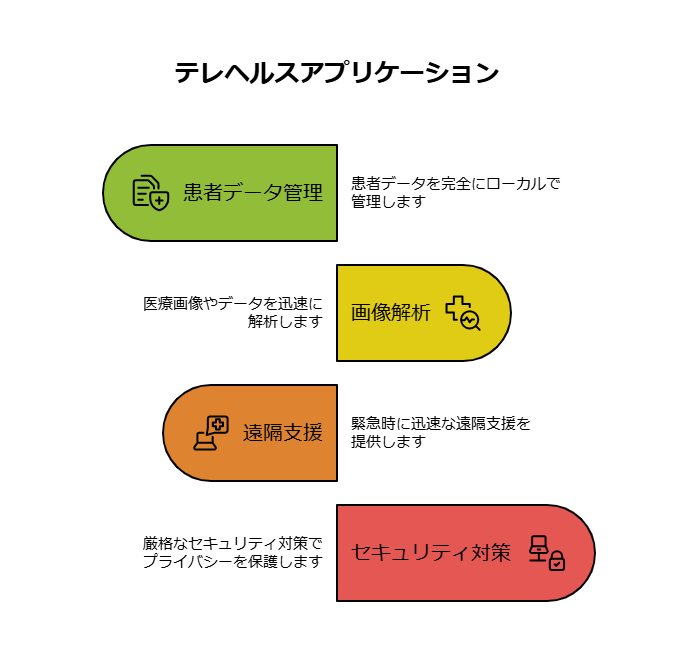

テレヘルスアプリケーション

テレヘルス分野においても、自社サーバー上で動作するAIシステムは大きな効果を発揮します。医療機関では、患者情報、診断データ、医療記録など、非常に機密性の高い情報を扱う必要があるため、クラウドへのデータ送信は大きなリスクとなります。ローカル環境でAIを実行することで、データが外部に流れることなく、即時かつ正確な解析が可能となります。これにより、緊急時の診断支援や遠隔医療診断において、患者のプライバシーを保持しつつ高度な医療サービスの提供が実現されます。また、厳格なセキュリティ対策と連動することで、医療現場でも安心して運用できるシステムが構築されます.

ポイント:

- 患者データの完全なローカル管理

- 迅速な医療画像やデータの解析

- 緊急時における迅速な遠隔支援の実現

- 厳格なセキュリティ対策によるプライバシー保護

ローカルでの使用のためのLLMの評価方法

トレーニングデータ

ローカルで実行するAIモデルの選定においては、まずそのトレーニングデータの内容、質、量が非常に重要な評価ポイントとなります。企業は、モデルがどのようなデータセットでトレーニングされたか、そのデータが持つ多様性や潜在的なバイアスの有無を十分に検証する必要があります。リライト元記事にあるように、学術研究や技術ドキュメントに基づいた評価が推奨されており、企業固有のデータに合わせたカスタマイズが求められる場合、トレーニングデータの背景や実験結果が明示されていることが大切です。これにより、企業は安全かつ効果的なローカルLLM導入の判断材料を確かなものとし、潜在リスクの低減を図ることが可能となります.

カスタマイズの柔軟性

評価プロセスのもう一つの重要なポイントは、モデルのカスタマイズ性です。企業固有の業務やデータフローに合わせ、LLMの各種パラメーター(最大トークン数、温度、頻度ペナルティ、コンテキスト長など)を柔軟かつ詳細に調整できるかどうかが大きな判断基準となります。リライト元記事に記載されている通り、各ツールには豊富なカスタマイズオプションが用意されており、これらを最大限に活用することで、想定外の業務要件の変更にも迅速に対応できるようになります。詳しい設定項目の調整が可能であることは、システム導入後の改善や拡張性を考慮する上で非常に有用であり、企業の運用戦略に大きく寄与します.

学術研究

最後に、AIモデルの信頼性を評価する上で不可欠なのは、その開発元が発行している学術論文や技術ドキュメントの存在です。リライト元記事でも示されているように、詳細な研究成果に基づくモデル設計、アルゴリズムの技術的根拠、及び実験結果などを確認することが推奨されます。これにより、企業は自社の業務要件や法令遵守の観点から最適なモデルを選定するための根拠を得ることができ、安心してシステム導入を進めることが可能となります。

まとめ

本記事では、自社サーバー上で動作するAIシステムの多くのメリットと、それを実現するためのツールの詳細な機能や特徴について解説してきました。データのプライバシー保護、カスタマイズの柔軟性、コスト削減、オフライン運用、安定したネットワーク接続、そしてエンタープライズ向けのサポートといった各観点から、ローカルでのAI運用が企業にとってどのような利点をもたらすかについて掘り下げました。また、各ツール(GPT4ALL、Ollama、LLaMa.cpp、LM Studio、Jan、Llamafile)の具体的な特徴や動作環境、実装事例を通じて、専門的な運用情報も提供しました。さらに、ローカルで使用するLLMの評価方法として、トレーニングデータ、カスタマイズ性、学術研究の観点を示し、各企業が自社の要件に合わせた最適な選定を行うための判断基準を整理しました。

これらの情報は、企業がシステム導入を検討する際の有効な資料として活用できるでしょう。今後、各ツールのアップデートや新たな技術動向にも注意を払いながら、柔軟かつ安全なシステム運用の実現を目指すことが求められます.

本記事では自社サーバー上で動くAIシステムのメリットと、具体的な6つのツールの詳細な機能や特徴、さらに比較表を用いた情報整理と各見出し毎の十分な文章量を盛り込んだ解説を行いました。弊社では、より柔軟で多様な業界ニーズに対応した生成AIコンサルティングサービスを提供しています。生成AIを活用した業務効率化や新たな価値創出にお悩みの方はぜひご連絡ください。