こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

Manusという自律型AIエージェントが発表され、Xを中心に界隈がいまだにざわついている中、その発表のほんの数日後、今度はなんとManusのOSS版が公開されました・・・!本記事執筆時点でManusを使用するにはWaitlistに登録して待たなければいけませんが、OSS版であれば、自分で環境さえ構築できれば使用できます!

この記事では、OpenManusとは何か、その仕組みや使い方、他のAIエージェントとの違いについて、初心者にも分かりやすく解説します。

OpenManusとは? ~誰でも使えるAIエージェント~

AIエージェントとは何かを知りたい方は、まずこちらの記事をぜひご覧ください!

関連記事:最近話題の AIエージェント ってなに? AIエージェント 完全ガイド

OpenManusの概要と従来のManusとの違い

OpenManusは、MetaGPTチームが中心となって開発した、オープンソースのAIエージェントです。従来のManusは招待コードが必要でしたが、OpenManusはその制限を撤廃し、誰もが自由に利用できるようになりました。

OpenManusは、ユーザーの指示を理解し、様々なタスクを実行できます。具体的には、Web検索や情報収集、データ分析など、多岐にわたる作業を自動化できます。OpenManusは、 GitHubで公開されており、誰でも自由に利用、改変、再配布が可能です。「スター」の数が多いほど、多くのユーザーからの支持を得ていることを示しています。

Manusってなに?という方はまずこちらの記事をご覧ください!Manusの概要をまとめています。

関連記事:Manus : 中国発、自律型AIエージェントがすごすぎる!その全貌を徹底解説!

OpenManusの特徴:強化学習による進化

OpenManusの最大の特徴は、強化学習(RL)と呼ばれる技術を用いている点です。強化学習とは、AIが試行錯誤を通じて最適な行動を学習していく仕組みです。

OpenManusは、ユーザーからの指示やフィードバック、そしてタスクの結果を基に、より良い結果を出せるように、その行動を最適化していきます。具体的には、OpenManusは、与えられたタスクに対して、様々な行動を試みます。それぞれの行動に対して、報酬(良い結果)または罰(悪い結果)が与えられます。エージェントは、報酬を最大化するように、行動の戦略を改善していきます。この過程を繰り返すことで、エージェントは徐々にタスクを効率的にこなせるようになります。OpenManusは、この強化学習の仕組みを利用することで、人間が細かく指示を与えなくても、自律的にタスクを遂行できる能力を獲得しています。

OpenManusでは、この強化学習のプロセスを、Reasoning-Interaction Chain Optimization (RICO) と呼ばれる独自のアルゴリズムを用いて効率化しています。RICOは、LLMが推論(考えること)と行動(ツールを使うこと)を交互に行うことで、より複雑なタスクを解決できるように設計されています。

LLMはまず、現在の状況を分析し、次にどのような行動を取るべきかを考えます(推論)。そして、その考えに基づいて行動を実行し、その結果を観察します(相互作用)。この一連の流れを繰り返すことで、LLMは徐々にタスクを解決するための最適な戦略を学習していきます。

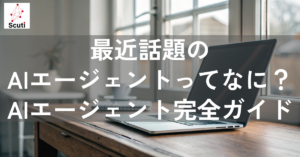

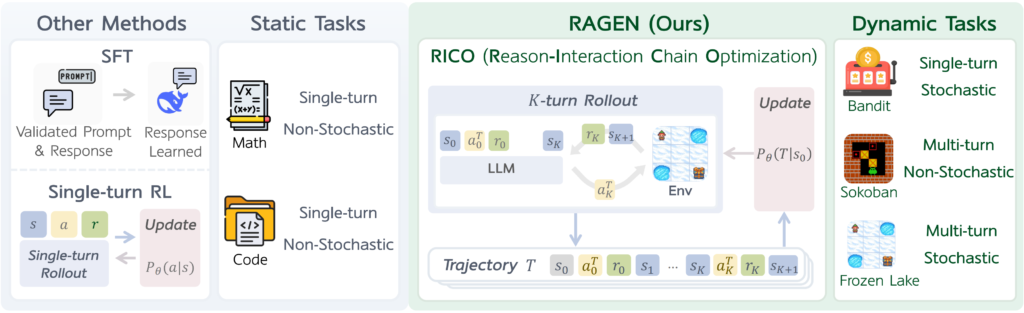

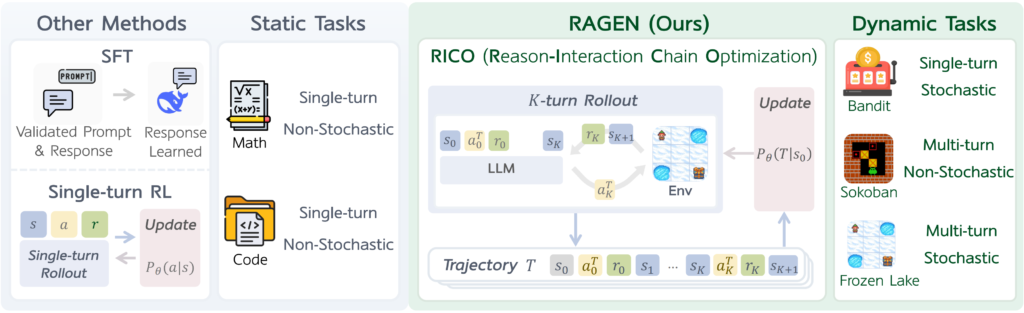

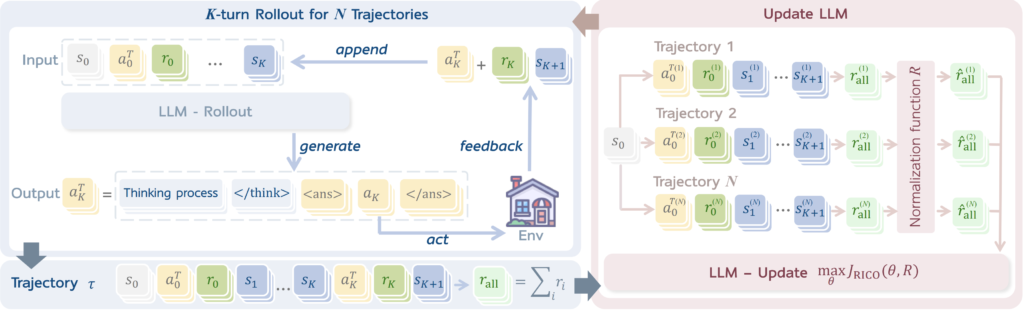

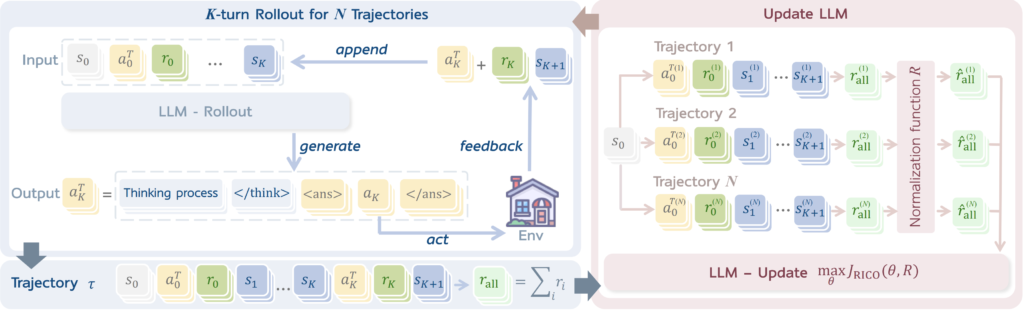

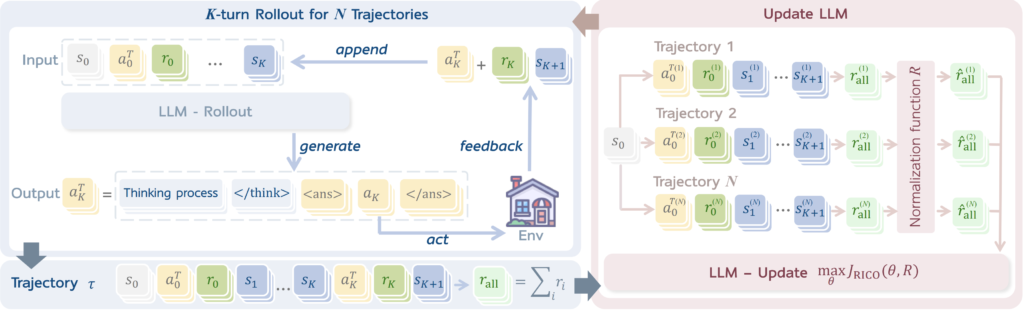

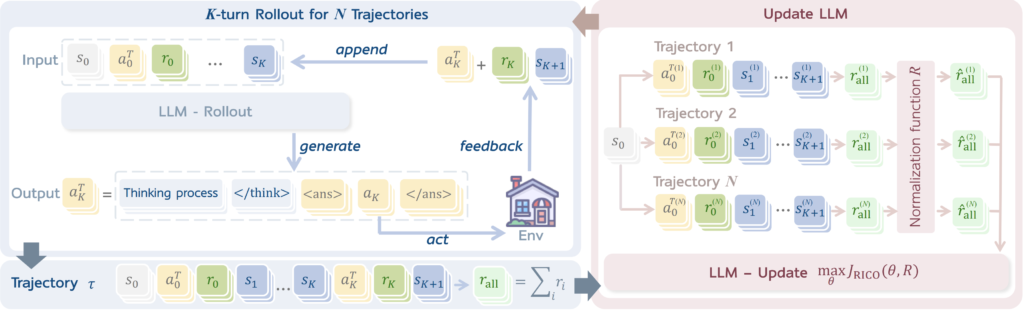

上の図は、RAGENという強化学習フレームワークが、LLMの推論能力をどのように強化しているかを示しています。具体的には、LLMは、与えられたタスクに対して、様々な推論パス(思考の連鎖)を生成し、それぞれのパスの有効性を評価します。そして、最も有効なパスを選択し、そのパスに基づいて行動を実行します。

上の図は、RICOフレームワークの概要を示しています。RICOは、Rollout StageとUpdate Stageの2つの段階を交互に繰り返すことで、LLMエージェントの学習を効率化します。Rollout Stageでは、LLMは現在の状態に基づいて行動を生成し、環境との相互作用を通じて新しい情報を収集します。Update Stageでは、収集された情報に基づいてLLMのポリシー(行動戦略)を更新し、より良い行動が取れるように学習します。

OpenManusの応用範囲

OpenManusは、その柔軟性と学習能力から、様々なタスクに応用できます。具体的には、Webサイトの構築を自動化したり、ソフトウェア開発のプロセスをサポートしたり、強化学習を用いたLLMエージェントのチューニングを行うなど、幅広い分野で活用可能です。OpenManusは、これらのタスクを自動化することで、人間の負担を軽減し、生産性を向上させることが期待されています。OpenManusは、16,000以上の実世界のAPIと連携できるToolLLM (Qin et al., 2023) を基盤としており、多様なタスクに対応できます。また、OpenManus-RLという強化学習に特化したプロジェクトもあり、より高度な問題解決能力を持つエージェントの開発も進められています。

OpenManusの仕組みと技術的背景

OpenManusの基盤技術:LLMとエージェント、そして多様なツール群

OpenManusは、大規模言語モデル(LLM)を「頭脳」として活用し、強化学習によってその能力を継続的に向上させる自律型AIエージェントのためのフレームワークです。LLMは、インターネット上にある膨大なテキストデータを学習することで、人間のように自然な文章を生成したり、質問に答えたり、プログラミングコードを書くことさえできるAIです。OpenManusは、このLLMを「エージェント」として機能させます。エージェントとは、自ら考え、行動し、目標を達成するために働くAIのことです。

OpenManusは、エージェントに様々な「ツール」を使う能力を与えている点が特徴的です。人間が道具を使うように、OpenManusもツールを駆使して、複雑なタスクをこなします。OpenManusは、Manus AIに触発されて開発されたオープンソースプロジェクトであり、Manusと同様に、エージェントが様々なツールを活用してタスクを解決するという基本的な考え方を共有しています。

Manusで利用可能なツールの例:

- 質問応答システム: 質問に答えます。具体的には、別のLLMをベースとした質問応答システムであるAtlasを利用しています。

- 電卓: 正確な計算が必要な場面では、電卓ツールが活躍します。四則演算が可能です。

- Wikipedia検索: 世界最大のオンライン百科事典Wikipediaを検索し、必要な情報を素早く見つけ出します。BM25検索エンジンを利用しています。

- 翻訳システム: 言葉の壁を越えて、6億パラメータのNLLB(No Language Left Behind)モデルが、様々な言語間の翻訳を行います。

- カレンダー: 今日の日付を提供します。

OpenManusは、これら4つのツールはあくまで基本機能であり、実際には16,000以上の実世界のAPIと連携できるToolLLM (Qin et al., 2023) を基盤としており、その応用範囲は非常に広いです。

OpenManusは、Manusのシステムプロンプトから、以下のようなエージェントの動作に関する一般的なガイドラインも参考にしています。

- ユーザーとの対話形式でタスクを進める

- 様々なツールを使いこなす

- タスクを段階的に実行する

- エラーが発生した場合は、原因を分析し、対処する

OpenManusのアーキテクチャ

OpenManusは、LLMを中核とするエージェントが、様々なツールを使いこなしながらタスクを遂行するためのフレームワークです。その中心には、強化学習アルゴリズムであるRICOと、エージェントの機能を自動的に更新・改善するAgentOptimizerがあります。

RICOは、LLMが「推論(考えること)」と「行動(ツールを使うこと)」を交互に行うエージェントの学習に特化した強化学習アルゴリズムです。具体的には、以下のステップで学習が進みます。

- Rollout Stage(試行段階): LLMは現在の状況(Webページの表示内容や、これまでの操作履歴など)を基に、次に行うべき行動を決定します。この時、LLMは単に行動を選ぶだけでなく、「なぜその行動を選ぶのか」という理由(推論)も同時に生成します(例:「〇〇について調べるために、検索エンジンで△△と検索する」)。生成された行動は、WebブラウザやAPIなどの「環境」を通じて実行され、その結果(検索結果やWebページの表示内容の変化など)がLLMにフィードバックされます。

- Update Stage(更新段階): Rollout Stageで得られた結果(行動とその結果、報酬など)を基に、LLMの行動戦略(ポリシー)を更新します。具体的には、報酬が高かった行動はより選択されやすくなり、報酬が低かった行動は選択されにくくなるように、Generalized Reward Policy Optimization (GRPO) (DeepSeek-AI, 2025)を用いてポリシーを最適化します。

この2つの段階を繰り返すことで、LLMは徐々にタスクを解決するための最適な戦略を学習していきます。RICOは、この推論と行動のサイクルを最適化することで、LLMエージェントの学習効率を高めています。

AgentOptimizerは、LLM自身を活用して、エージェントの機能を更新するための提案を自動生成する仕組みです。現在のエージェントの機能、過去の実行履歴、タスクの成功率などの情報を基に、LLMが「新しい機能を追加する」、「既存の機能を修正する」、「不要な機能を削除する」といった提案を自然言語で生成します。生成された提案は、人間、または別の評価システムによって評価され、有効と判断された提案が採用されてエージェントの機能が更新されます。

OpenManusを支える技術:AgentTuning、AgentOptimizer、そしてOpenManus-RL

OpenManusの性能は、AgentTuning、AgentOptimizer、そしてOpenManus-RLという複数の技術によって支えられています。これらはそれぞれ独立した要素技術ではなく、互いに連携し、OpenManus全体の性能向上に貢献しています。

OpenManus-RLは、OpenManusフレームワーク上での強化学習によるエージェントのチューニングに特化したプロジェクトです。UIUCとMetaGPTの研究者によって共同開発され、LLMエージェントのチューニングに強化学習(RL)ベースの手法(GRPOなど)を用いることを目的としています。

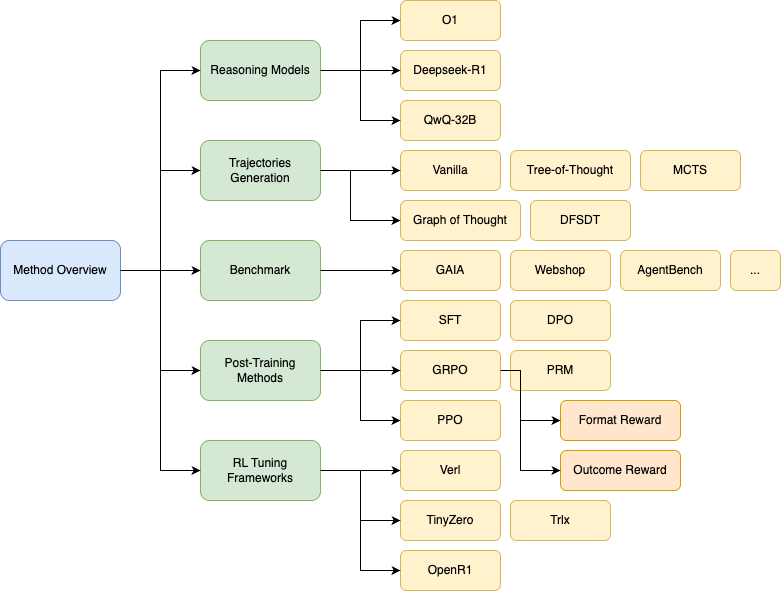

この図は、OpenManus-RLの全体像を示しています。OpenManus-RLは、UIUC-UlabとMetaGPTの共同プロジェクトであり、LLMエージェントの強化学習によるチューニングに焦点を当てています。

OpenManus-RLでは、多様な推論モデルや、複数の探索戦略を比較・検討することで、最適な学習方法を探求しています。具体的には、GPT-o1、Deepseek-R1 (DeepSeek-AI, 2025)、QwQ-32Bといった異なる特性を持つLLMを複数組み合わせ、それぞれのモデルの強みを活かし、弱点を補完します。また、方策探索戦略として、Tree-of-Thoughts (ToT)、Graph-of-Thoughts (GoT)、DFSDT (Depth-First Search Decision Trees)、Monte Carlo Tree Search (MCTS)といった多様な手法を採用しています。

- Tree-of-Thoughts (ToT) (Yao et al., 2023, Figure 1(d)): ToTは、探索木を生成することで、複数の推論パスを並行して探索します。各ノードは、現在の状態とそこに至るまでの思考の連鎖を表します。エージェントは、各ノードで複数の可能な思考ステップを生成し、それぞれの思考ステップを評価して、最も有望なものを選択します。このプロセスを繰り返すことで、エージェントは問題解決のための最良のパスを見つけます。

- Graph-of-Thoughts (GoT): GoTは、ToTをさらに発展させたもので、思考の過程をグラフ構造として表現します。ToTが木構造に限定されるのに対し、GoTはより柔軟な思考のつながりを表現できます。これにより、エージェントはより複雑な問題に対して、より効率的に解決策を見つけることができます。(GoTの図は提供されていません。)

- DFSDT (Depth-First Search Decision Trees): 深さ優先探索を用いて決定木を構築し、有望なパスを優先的に探索します。深さ優先探索は、探索木を深く掘り下げていくため、ToTやGoTに比べて、より少ない計算量で解を見つけられる可能性があります。(DFSDTの図は提供されていません。)

- Monte Carlo Tree Search (MCTS): モンテカルロ法を用いて探索木を構築し、有望な行動を重点的に探索します。MCTSは、ランダムサンプリングを用いて探索木の各ノードの価値を推定し、その推定値に基づいて探索するノードを選択します。これにより、不確実性の高い状況でも、より robust な意思決定が可能になります。

上記にでてきたDeepSeek-R1については以下の記事をご覧ください!

関連記事:DeepSeek-R1 : 最大6710億パラメータで推論能力を飛躍的に向上させたAI

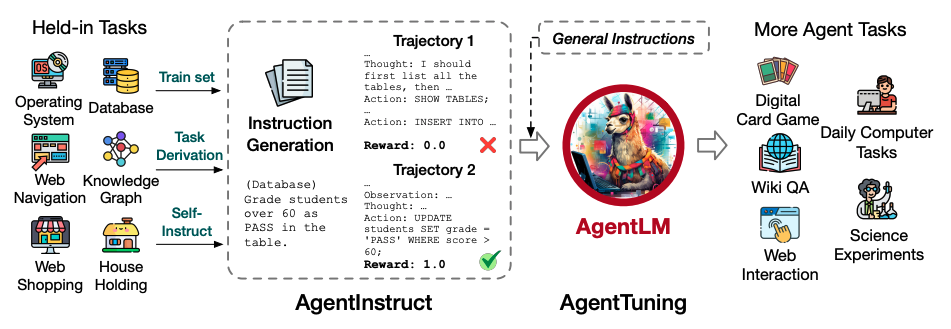

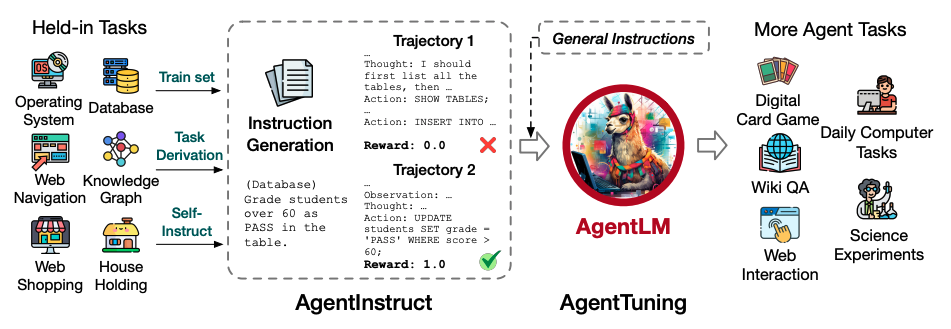

AgentTuningは、LLMエージェントの汎用的な能力を向上させるための学習手法であり、その中心となるのがAgentInstructというデータセットです。

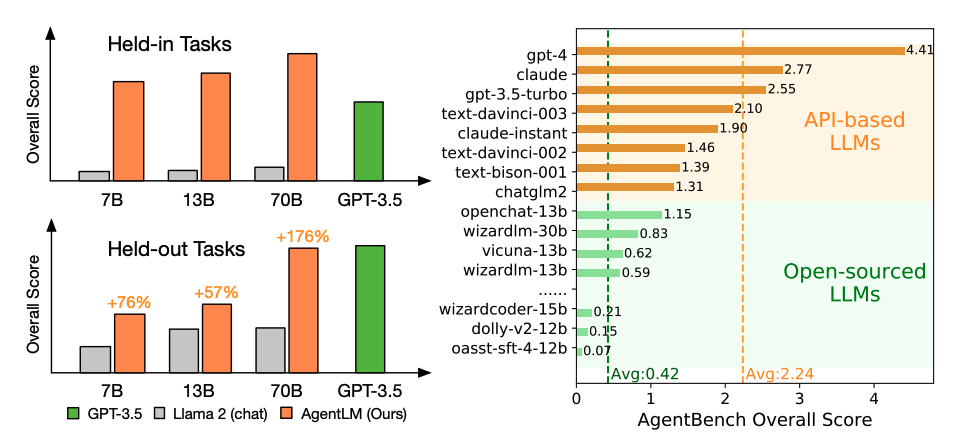

この図は、AgentLMのパフォーマンスを他のモデルと比較したものです。左側(a)はAgentLM、Llama 2、GPT-3.5の既知タスク(held-in tasks)と未知タスク(held-out tasks)での性能を示しており、AgentLMが特に未知タスクで最大176%の性能向上を達成していることがわかります。右側(b)ではAPI-based LLM(GPT-4、Claude等)とOpen-source LLM(chatglm2、vicuna等)のAgentBenchスコアを比較しており、オープンソースモデルが商用モデルより大幅に劣ることを示しています。

出典:Zeng et al., 2023, AgentTuning: Enabling Generalized Agent Abilities for LLMs, Figure 2

この図は、AgentTuningの全体的な流れを示しています。AgentTuningでは、まず多様なタスクから高品質なエージェントの行動軌跡(interaction trajectories)を収集してAgentInstructデータセット(左側)を構築します。データセット構築は3段階のプロセス:指示構築(Instruction Generation)、軌跡対話(Trajectory Interaction)、軌跡フィルタリング(Trajectory Filter)で行われます。

そして、このAgentInstructと一般的な指示データ(General Instructions)を最適な比率(η=0.2)で組み合わせてLlama 2をファインチューニングし、AgentLMを作成します。このハイブリッド指示チューニング戦略により、エージェント能力と一般能力のバランスを維持しながら性能向上を実現しています。

以下は、AgentInstructデータセットの詳細な内訳を示す表です。

| タスク | 指示文の入手元 | 指示文の数 | フィルタリング後の軌跡数 | 平均ターン数 | フィルタリング後の割合 |

|---|---|---|---|---|---|

| ALFWorld (家庭環境でのタスク実行) | 訓練用データ | 954 | 336 | 13.52 | 35.2% |

| WebShop (オンラインショッピング) | 訓練用データ | 1,485 | 351 | 3.68 | 23.6% |

| Mind2Web (Webサイトの操作) | 訓練用データ | 23,378 | 122 | 1.001 | 0.52% |

| Knowledge Graph (知識グラフの操作) | 訓練用データ | 2,501 | 324 | 6.04 | 13.0% |

| Operating System (オペレーティングシステムの操作) | Self-Instruct | 647 | 195 | 3.85 | 30.1% |

| Database (データベースの操作) | Self-Instruct | 1,074 | 178 | 2.13 | 16.6% |

| Database (データベースの操作) | タスク派生 | 5,302 | 360 | 2.03 | 6.79% |

| AgentInstruct合計 | – | 35,341 | 1,866 | 5.24 | 5.29% |

Mind2Webは、1ステップのタスクに分解されているため、平均ターン数は1.00となります。

この表から、AgentInstructデータセットは多様なエージェントタスクを含んでいることがわかります。各対話軌跡にはChain-of-Thought(CoT)を使用した推論過程(thought)が含まれており、モデルが意思決定の理由づけを学習できるようになっています。フィルタリング率が低い(特にMind2Webでは0.52%)のは、GPT-4でさえエージェントタスクの成功率が低いことを示しており、高品質な対話軌跡の収集が難しいことを示唆しています。

論文によれば、フィルタリングされたデータでの訓練はフィルタリングされていないデータよりも大幅に性能が向上しており、エージェントタスクにおいてはデータ量よりもデータ品質が重要であることが示されています。また、AgentTuningの実験では、エージェントデータと一般データを混合する比率(η)として0.2が最適であることが判明しており、一般的な能力がエージェントタスクの汎化に重要な役割を果たしていることを示しています。

OpenManusの導入と利用方法

OpenManusの導入手順

OpenManusを利用するには、GitHubリポジトリからコードをクローンし、必要なライブラリをインストールする必要があります。具体的な手順は以下の通りです。

condaを使用する場合 (推奨)

conda環境を作成: OpenManusは、Python 3.12以上の環境で動作します。

conda create -n open_manus python=3.12

conda activate open_manusリポジトリのクローン: 以下のコマンドを実行して、OpenManusのリポジトリをクローンします。

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus依存関係のインストール: 必要なライブラリは、以下のいずれかの方法でインストールできます。

pip install -r requirements.txtuvを使用する場合 (推奨)

uvをインストール

curl -LsSf https://astral.sh/uv/install.sh | shリポジトリのクローン: 以下のコマンドを実行して、OpenManusのリポジトリをクローンします。

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus仮想環境構築: 仮想環境を構築し、有効化します。

uv venv

source .venv/bin/activate # Unix/macOS環境の場合

# Windows環境の場合:

# .venv\Scripts\activate依存関係のインストール: 必要なライブラリは、以下のいずれかの方法でインストールできます。

uv pip install -r requirements.txtAPIキーの設定: OpenManusは、LLMのAPIを使用するため、config/config.tomlファイルにAPIキーを設定する必要があります。config/config.example.tomlファイルをコピーして、config.tomlファイルを作成し、APIキーを記入してください。OpenManusは、デフォルトでOpenAIのGPTシリーズのモデルを使用するように設定されていますが、config.tomlファイルを編集することで、他のLLMモデルを使用することも可能です。

config.tomlファイルには、使用するLLMモデルの種類、APIキー、ベースURL、最大トークン数、温度などの設定項目があります。これらの設定項目を適切に設定することで、OpenManusの動作をカスタマイズできます。

model には利用したいモデル名を正確に記述します (例: gpt-4o, gpt-3.5-turbo)。base_url は通常変更不要です。api_key には、OpenAI などから取得したAPIキーを記述します。max_tokens で応答の長さを、temperature で応答の多様性を調整できます。 以下に、config.tomlファイルの設定例を示します。

# LLMの共通設定

[llm]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # あなたのAPIキー

max_tokens = 4096

temperature = 0.0

# 特定のLLMに対する設定(任意)

[llm.vision]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # Replace with your actual API keyOpenManusの使い方

OpenManusを起動するには、以下のコマンドを実行します。

python main.pyその後、ターミナルにアイデアを入力するだけで、OpenManusが自動的にタスクを実行します。例えば、「〇〇について調べて」と入力すると、OpenManusはWeb検索ツールを使って〇〇に関する情報を収集し、その結果を要約して提示してくれます。OpenManusは、ユーザーからの指示を解釈し、適切なツールを選択し、必要な情報を収集・処理し、最終的な結果を提示するという一連のプロセスを自動的に実行します。

より高度な使い方として、python run_flow.pyコマンドを実行することで、不安定版の機能を利用することも可能です。このコマンドを実行すると、OpenManusは、より実験的な機能や、まだ開発中の機能を利用できるようになります。ただし、これらの機能は、まだ十分にテストされていない可能性があるため、注意して使用する必要があります。

OpenManusの今後の展望と課題

OpenManusの今後の展望:更なる機能拡張、多様なモデルと戦略の導入

OpenManusは、今後も継続的な改善と機能拡張が予定されており、より強力で使いやすいAIエージェントへと進化していくことが期待されます。具体的には、以下のような取り組みが計画されています。

- プランニング能力の強化: 現在のOpenManusは、比較的単純なタスクの実行に強みを持っていますが、より複雑なタスクをこなすためには、タスクをより小さなサブタスクに分解し、それぞれのサブタスクを効率的に実行するための高度なプランニング能力が必要です。今後の開発では、このプランニング能力を強化し、タスクの分解と実行ロジックの最適化を目指します。具体的には、#リライト元記事 のRoadmapに記載されている「Enhance Planning capabilities, optimize task breakdown and execution logic」に対応する部分です。OpenManus-RLでは、この計画能力を強化するために、強化学習を用いて、より効率的な計画を立てる方法を学習します。具体的には、Tree-of-Thoughts (ToT)やGraph-of-Thoughts (GoT)といった、複数の思考パスを探索する手法や、DFSDT (Depth-First Search Decision Trees)やMonte Carlo Tree Search (MCTS)といった、探索と活用のバランスを取りながら最適な行動を選択する手法を活用します。

- 標準化された評価指標の導入: OpenManusの性能を客観的に評価し、改善につなげるためには、標準化された評価指標が必要です。現在、OpenManus-RLでは、GAIAやTAU-Benchといった既存のベンチマークを参考に、継続的な性能評価と最適化が行われています。これは、#リライト元記事 のRoadmapに記載されている「Introduce standardized evaluation metrics (based on GAIA and TAU-Bench) for continuous performance assessment and optimization」に対応する部分です。具体的には、タスクの成功率だけでなく、タスク完了までにかかった時間や、使用したツールの数、生成されたテキストの品質など、多角的な評価指標を導入することが考えられます。また、GAIAやTAU-Benchといった既存のベンチマークとの比較も継続的に行い、OpenManusの性能を客観的に評価していく予定です。

- 低コストなアプリケーションシナリオの拡大: 現在のOpenManusは、高性能なLLMを基盤としているため、実行には比較的高い計算コストがかかります。今後は、より軽量なモデルの採用や、計算資源の効率的な利用方法を検討することで、低コストなアプリケーションシナリオを拡大していくことが期待されます。例えば、スマートフォンやタブレットなどのモバイルデバイスでも動作するような、軽量なOpenManusの開発が考えられます。これは、#リライト元記事 のRoadmapに記載されている「Expand model adaptation and optimize low-cost application scenarios」に対応する部分です。具体的には、モデルの蒸留や量子化といった技術を用いて、モデルのサイズを削減し、計算コストを低減することが考えられます。

- コンテナ化されたデプロイメント: OpenManusの利用をより簡単にするために、コンテナ化されたデプロイメントの導入が検討されています。コンテナ化とは、アプリケーションの実行に必要なすべての要素(コード、ライブラリ、設定ファイルなど)を一つのパッケージにまとめ、異なる環境でも同じように動作させる技術です。これにより、ユーザーは、複雑な環境構築の手間を省き、OpenManusをすぐに使い始めることができます。これは、#リライト元記事 のRoadmapに記載されている「Implement containerized deployment to simplify installation and usage workflows」に対応する部分です。具体的には、Dockerなどのコンテナ技術を利用して、OpenManusの実行環境をパッケージ化し、配布することが考えられます。

- 実践的なケーススタディの充実: OpenManusの有効性を示すためには、成功例だけでなく、失敗例も含めた、より多くの実践的なケーススタディが必要です。今後は、様々なタスクにおけるOpenManusの適用事例を収集・分析し、成功例と失敗例の両方から学びを得ることで、OpenManusの改善につなげていくことが期待されます。これは、#リライト元記事 のRoadmapに記載されている「Enrich example libraries with more practical cases, including analysis of both successful and failed examples」に対応する部分です。具体的には、WebサイトのSEO対策、ソフトウェア開発、データ分析など、様々な分野におけるOpenManusの活用事例を収集し、公開することが考えられます。

- ユーザーエクスペリエンス向上のための開発: OpenManusの使いやすさを向上させるためには、ユーザーインターフェース(UI)の改善が不可欠です。具体的には、より直感的で分かりやすいUIを設計し、ユーザーが簡単にOpenManusを操作できるようにすることが求められます。これは、#リライト元記事 のRoadmapに記載されている「Frontend/backend development to improve user experience」に対応する部分です。具体的には、Webブラウザ上で動作するグラフィカルなUIを開発したり、音声入力に対応したりすることが考えられます。また、ユーザーからのフィードバックを収集し、UIの改善に役立てることも重要です。

OpenManusの課題:LLMの限界と安全性

OpenManusは、まだ発展途上のプロジェクトであり、いくつかの課題も残されています。

- LLMの限界: OpenManusは、LLMを基盤としているため、LLMの限界に影響を受けます。例えば、LLMは、時として誤った情報や偏った情報を生成したり、予期せぬ動作をしたりすることがあります。これは、LLMが学習データに基づいて動作するため、学習データに偏りがあったり、誤った情報が含まれていたりすると、それがモデルの出力に反映されてしまうためです。OpenManusでは、この問題に対処するために、複数のLLMを組み合わせたり、人間によるフィードバックを活用したりするなどの工夫を行っていますが、完全に問題を解決するには至っていません。LLMの性能向上や、より信頼性の高い学習データの構築などが今後の課題となります。

- 安全性: OpenManusは、ユーザーの指示に基づいて動作するため、悪意のある指示や不適切な指示が与えられた場合、意図しない結果が生じる可能性があります。例えば、Webサイトの改ざんや、個人情報の漏洩などのリスクが考えられます。OpenManusでは、この問題に対処するために、利用規約を設けたり、ユーザー認証を導入したりするなどの対策を講じていますが、完全にリスクを排除することは困難です。より安全な利用方法の確立や、悪意のある利用を検知する技術の開発などが今後の課題となります。

今後の研究開発により、これらの課題が克服され、より安全で信頼性の高いAIエージェントが実現されることが期待されます。OpenManusは、そのための重要な一歩となるでしょう。