こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

近年、アパレル業界では製品企画から生産、販売に至る各プロセスにおいて、正確な素材情報の迅速な取得が求められています。従来の手作業によるデータ入力は膨大な工数やヒューマンエラーのリスクを伴うため、AIと画像処理、そしてCAD連携などの先進技術を利用した自動抽出システムの実用化が注目されています。

本記事では、フラットスケッチ解析、エッジ検出、深層学習による特徴抽出、転移学習を用いた画像分類、AI OCRによる素材情報の抽出、さらに3Dボディスキャン画像を活用したランドマーク補正技術など、AI × 画像処理に基づく8つの最新技術について、技術的な詳細および評価実験の結果とともに網羅的に解説します。

AI×画像処理による衣料画像解析プロセス

まず、OCR について知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:Tesseract OCRの完全解説:インストールから活用事例、最新技術との比較まで

関連記事:olmOCR : PDFテキスト抽出を1/32のコストで実現!?

関連動画:【2025最新】生成AI-OCRで作業90%削減!ファッション系のカタログをが一瞬で自動化!

フラットスケッチ要素の自動抽出とその詳細な実験評価

- 専門家作成のエッジマップを含むFFIED(250点)の婦人服画像を活用

- CNNベースのDexiNedモデルを回転・ミラーリング・ガンマ補正により拡張された57,600ペアで訓練

- 抽出エッジマップはRNNベースのベクトル化モデルでSVG形式に変換、グラフ探索アルゴリズムにより閉じた形状へ統合

- 混同行列に基づく適合率、再現率、F1スコア、p値の定量評価により、従来モデルとの性能向上を確認

従来の手作業によるフラットスケッチ作成の非効率さと作業負担を解消するため、AIと画像処理を組み合わせた自動抽出手法が提案されています。専門家が手描きしたエッジマップを含む婦人服250点(トップス110点、アウター35点、ドレス35点、スカート35点、パンツ35点)の専用データセット「FFIED」を用い、CNNベースのDexiNedモデルを回転、ミラーリング、ガンマ補正などで最大288枚に拡張した57,600ペアのデータで訓練。バッチサイズ8、20エポック、ADAMオプティマイザにより高精度なエッジ抽出を実現。抽出されたエッジマップは、RNNベースのベクトル化モデルによりSVG形式へ変換され、途切れ線統合や線延長、ルールベースの画像補正で最終的な閉じた形状をグラフ探索アルゴリズムを用いて抽出します。実験評価では、テスト画像1に対して従来モデルが適合率0.6894、再現率0.7856、F1スコア0.7344、p値0.5803であったのに対し、FFIEDで訓練されたモデルでは適合率0.7990、再現率0.8545、F1スコア0.8258、p値0.7033となるなど、各評価指標で顕著な向上が確認されています。各工程の詳細な実験結果や図表を通じ、不要な線やノイズ除去の効果とともに、デザイン支援や素材情報抽出への応用可能性が裏付けられています。

「手書きや複雑なレイアウトの資料は、従来のOCRでは精度が不安…」そんな現場の声をよく耳にします。生成AI-OCRサービスなら、表やメタ情報、タグなども正確に読み取り、アパレル文書をスムーズにデータ化。OCRの常識が変わります。これ、もう任せたいかも…。

CNN×画像処理を応用したエッジ検出と実験結果の詳細解説

- 深層学習技術の導入により、従来手法では見逃しがちな縫製線やディテールも正確に抽出

- FFIEDデータセットで学習することで、柄物衣料でも重要な内部エッジをノイズやしわを抑えながら検出

- 定量評価としてF1スコアやp値で従来モデルとの比較を実施、各テスト画像で大幅な性能向上を確認

- 定性的検証の図では、無地および柄物衣料両面での改善が視覚的に確認可能

深層学習を利用したエッジ検出技術では、DexiNedモデルが従来のキャニー法などによる検出手法よりも細かなエッジ情報の抽出が可能となっています。特に、柄物衣料においては、ノイズや不要なしわを効果的に抑えつつ重要な内部エッジを抽出。実験では、複数のテスト画像に対し、定量評価として適合率、再現率、F1スコア、p値が従来の手法に比べ大幅に改善され、図や表で具体的な結果が示されています。これにより、抽出されたエッジ情報を基に再利用可能なフラットスケッチ要素の高速取得が可能となり、実用性の高さが確認されました。

衣料デザイン画像のAI認識と特徴抽出技術

CNNベースの衣料デザイン要素抽出モデルの構築と評価

- 画像前処理として拡大、縮小、トリミング、回転、明るさ補正等を適用

- 各ピクセルの標準化((x – x_min)/(x_max – x_min) および zスコア)により入力データの安定化を実現

- 複数の畳み込み層、プーリング層、全結合層、Dropout層を導入したCNNアーキテクチャを採用

- L2正則化、バッチ正規化、転移学習によりImageNetなど事前学習済み重みを活用し、汎化能力が向上

- 実験結果ではテストセットで95.15%の精度、再現率97.8%、F1スコア96.3%、ROC曲線でも高いTPR/低FPRが確認

衣料品画像から主要なデザイン要素を自動識別するCNNベースのモデルでは、画像前処理として拡大縮小、トリミング、回転、明るさ補正などで学習データの質を向上。さらに、各ピクセルの正規化や複数層のCNN構築、Dropout、L2正則化、バッチ正規化などにより、過学習を防止しつつ高精度な抽出を実現。転移学習を用い、ImageNetなどから事前学習済み重みをファインチューニングすることで、テストセットで95.15%の精度、97.8%の再現率、96.3%のF1スコアと高い性能が得られ、ROC曲線により各種閾値下での堅牢性も確認されました。これにより、抽出された要素がそのままCADシステムへ連携され、ドラッグ&ドロップによるデザインプロトタイプの迅速な生成が可能となる仕組みを裏付けています。

画像分類と転移学習による素材情報抽出のアプローチ

CNNと転移学習を用いた衣料品分類モデルの構築と実験結果

- 「myFashion」データセット(2,567枚)を用いて10クラス(Bag、Coat、Dress、Hat、Pullover、Shirt、Shoes、Suit、Trousers、T-Shirt)に分類

- AlexNet系アーキテクチャに基づいたモデルで、画像回転、反転、拡大縮小、トリミング等のデータ拡張を実施

- Dropout層導入により過学習が抑制され、検証精度は71.04%から79.16%に向上

- Fashion MNISTで事前学習した場合は検証精度63.12%に留まったが、ImageNetで事前学習されたVGG-16は83.96%、GoogLeNetは76.63%と高い精度を示す

- 混同行列、分類レポート、図表により各モデルの性能が定量的に示され、特にVGG-16は上半身衣類も優れた識別性能を発揮

画像分類技術は、アパレル素材情報抽出の最初のステップとして非常に重要です。2,567枚の「myFashion」データセットを用い、Bag、Coat、Dress、Hat、Pullover、Shirt、Shoes、Suit、Trousers、T-Shirtの10クラスに分類するタスクを設定。AlexNet系アーキテクチャに基づいたモデルでは、画像の回転、反転、拡大縮小、トリミングといったデータ拡張を施し、Dropout層を導入することで検証精度が71.04%から79.16%に改善。さらに、転移学習によりFashion MNISTでの事前学習では精度が63.12%に留まったものの、ImageNetで事前学習されたVGG-16は83.96%、GoogLeNetは76.63%と高精度を達成。各実験結果はグラフ、混同行列、分類レポートにより詳細に提示され、素材分類や今後の素材特性自動抽出に向けた有望なシステムとして示されています。

AIによるデータ抽出とアパレル業界への応用事例

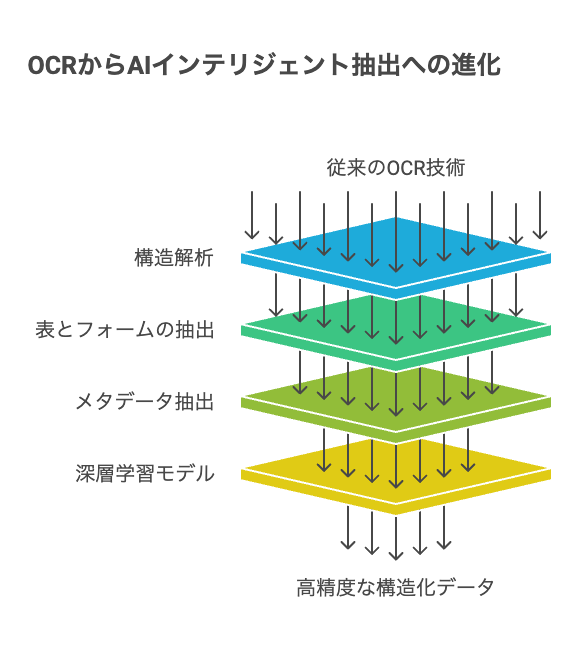

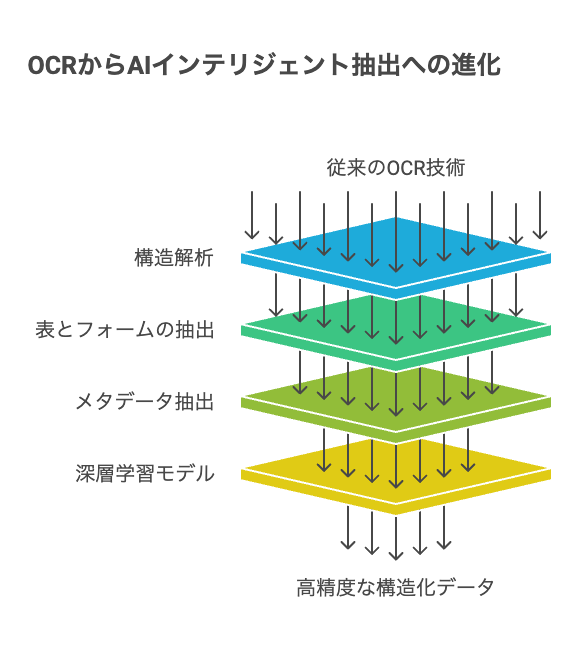

OCRの限界とAIインテリジェント抽出技術の進化

- 従来のOCRは複雑なレイアウトや手書き文字に対して精度が低い

- 最新のインテリジェントデータ抽出ソリューションは、文書の構造解析、表・フォーム、メタデータ抽出まで実現

- Amazonの深層学習モデルなどを活用し、製品タグや仕様書などアパレルに必要な情報を高精度に構造化

- これにより、従来のOCRによる膨大な手作業やエラーが大幅に削減され、業務プロセスの自動化が促進

従来のOCR技術は、スキャン文書からのテキスト抽出に一定の成果を挙げてきたものの、手書き文字や複雑なレイアウトに対しては限界がありました。最新のインテリジェントデータ抽出ソリューションでは、Amazonの深層学習モデルを含むAI・機械学習技術を活用し、文字認識に加え文書構造、表・フォーム、メタデータなどを高精度に抽出。アパレル製品においては、製品タグ、品質表示、仕様書など重要な情報を迅速に構造化することで、従来のOCRに比べ大幅な業務効率化を実現しています。下記図は、AIを活用したデータ抽出の全体的なフレームワークを示し、各ステップの解析内容と抽出結果の連携を視覚的に表現しています。

手書き文字や複雑なレイアウトが混在する資料では、従来のOCRだけでは限界があります。生成AI-OCRサービスなら、構造を正確に認識し、表や仕様書の情報を高精度に抽出。現場の作業効率を根本から見直すチャンスです。これ、もう任せたいかも…。

画像エッジ抽出技術:キャニーとスネークの応用

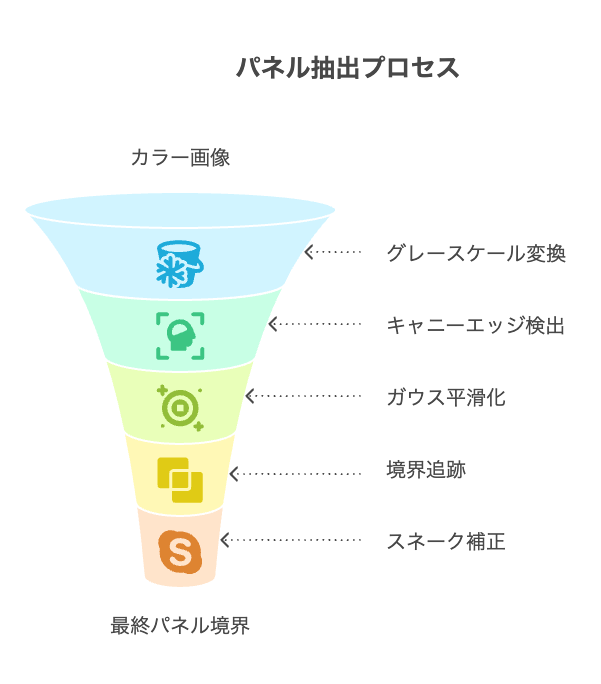

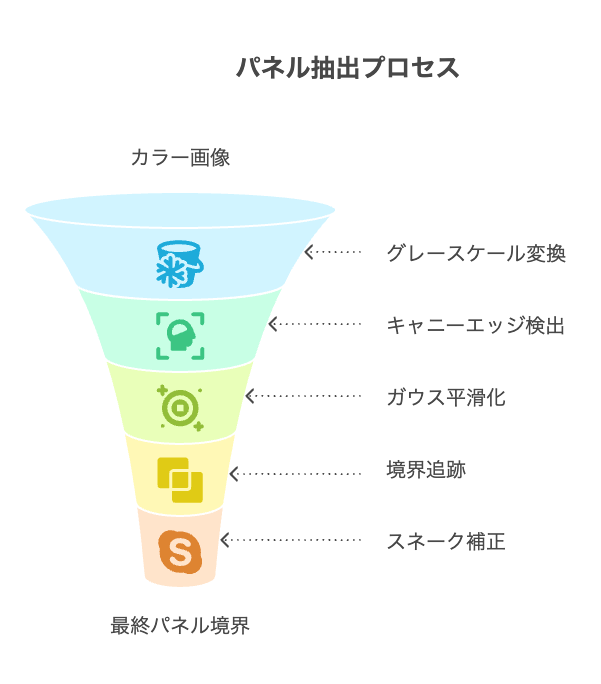

パネル抽出プロセス:キャニーエッジ検出とスネーク技術の応用

- カラー画像はまずグレースケールに変換後、キャニーエッジ検出器が適用される

- ガウスローパスフィルタ(標準偏差σ付き)と勾配演算子∇を用い、平滑化画像 I₍gg₎(x,y) を生成

- 平滑化画像からキャニーエッジ検出を再適用し、ユーザーがクリックした位置 Pu から最短距離にあるエッジ点 Pe を探索

- 境界追跡アルゴリズムで大まかなパネル境界 z を生成、その後GVFに基づくスネーク技術でエネルギー E₍b₎最小化により滑らかな境界に補正

- ダーツを含む場合は、ハフ変換とハリスコーナー検出により交点・コーナーを抽出し、適切な位置に挿入、最終的には3次ベジェ曲線フィッティングで平滑化

古いパターンブック等の2Dパターン画像から布パネルの境界を自動抽出するため、まずカラー画像をグレースケールに変換し、キャニーエッジ検出器を適用します。しかし、ぼやけた境界やノイズが問題となるため、標準偏差σ付きのガウスローパスフィルタをかけ、勾配∇I(x,y)と乗算した平滑化画像 I₍gg₎(x,y) を作成。さらに、平滑化画像から再度エッジ検出を行い、ユーザーが指定した位置 Pu に最も近いエッジ点 Pe を起点として境界追跡を実施。GVFに基づくスネーク技術を適用することで、エネルギー E₍b₎を最小化し、正確なパネル境界へと補正されます。ダーツを含む場合は、ハフ変換とハリスコーナー検出により交点とコーナー点を抽出し、パネル境界に統合。その後、3次ベジェ曲線フィッティングで全体が平滑化され、実験では手動抽出との平均誤差が2.3~2.7mmという極めて小さい値となり、実用性が確認されています。

3DボディスキャンとGrasshopperによる身体ランドマーク自動抽出

上半身15ランドマーク定義とGrasshopper実装の詳細

- 上半身の主要ランドマーク(前頸点、側頸点、後頸点、肩先点、前・後腋窩点、腋窩点、バストポイント、ウエストポイント、肩甲骨点、背部突出点)を計15点定義

- 従来のSizeKoreaプロジェクトの基準を再検証し、3Dスキャンデータに適した再定義を実施

- RhinoのプラグインGrasshopperを用い、直感的な操作で自動抽出および補正を実現

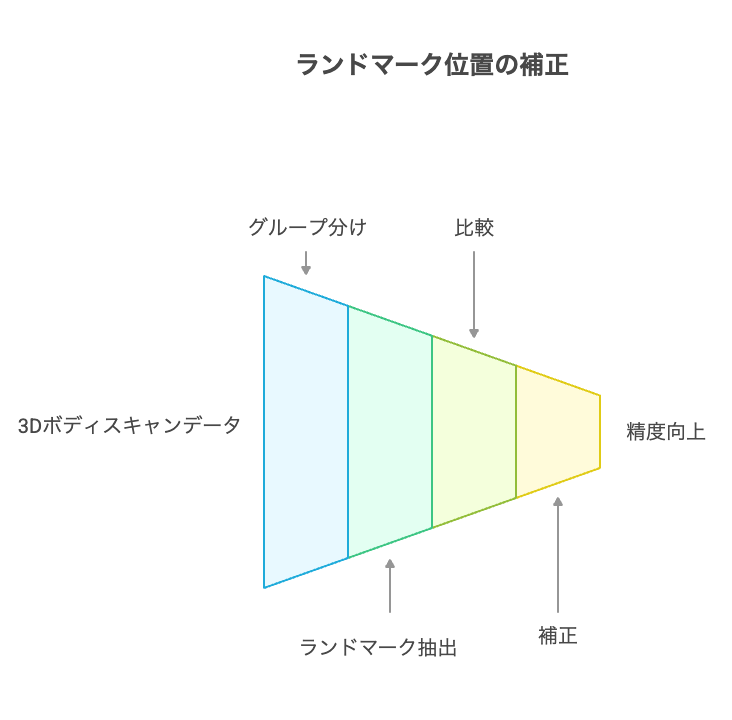

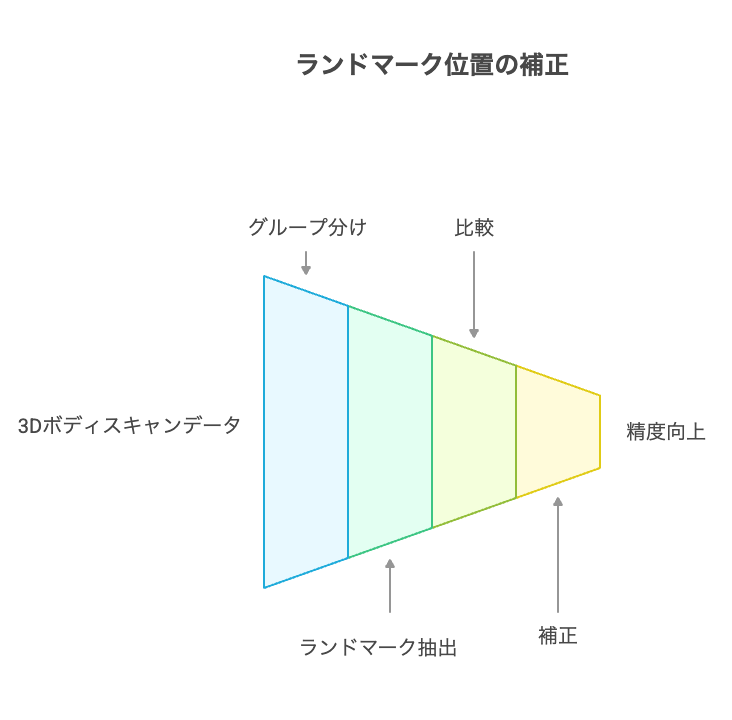

- 実験では、819名の被験者データをBMIや首・上半身・肩の傾斜に基づきグループ分けし、各ランドマークの抽出位置と従来基準との比較を実施

カスタムフィット衣服の設計やパターン作成に不可欠な身体測定を、3DボディスキャンとGrasshopperを活用して自動抽出する技術が提案されています。前頸点、側頸点、後頸点、肩先点、前・後腋窩点、腋窩点、バストポイント、ウエストポイント、肩甲骨点、背部突出点などの15のランドマークが、従来のSizeKorea基準に基づきながら、3D環境に合わせて再定義されました。Grasshopperの直感的なインターフェースにより、ユーザーは3Dスキャンデータ上で各ランドマークを自動抽出し、必要に応じた補正操作が可能となります。実験では、痩せ型では後頸点が平均1.1cm高く抽出される傾向が見られ、補正処理として1.1cm下方に調整。肥満型では腋窩点が平均3.7~6.8cm低く出る傾向に対し、適切な上方補正が施され、各測定値がISO 20685の許容誤差に近い精度となりました。下記表および図は、各ランドマークの再定義と抽出結果、補正前後の比較を示しています。

| ランドマーク | 定義 |

|---|---|

| 前頸点 | 胸骨上切痕の直上に位置する点 |

| 後頸点 | 第7頚椎の棘突起の先端 |

| 肩先点 | 肩峰の最も外側に位置する点 |

上記表は、再定義された上半身15の主要ランドマークを示し、各ランドマークが解剖学的およびパターン作成上どのように機能するかを明確に説明しています。

体型別検証とランドマーク位置の補正実験

- 819名の女性被験者の3Dボディスキャンデータを用いて、BMI、首の傾斜、上半身・肩の傾斜に基づきグループ分け

- 各ランドマークの抽出位置と従来のSizeKorea基準との比較実験を実施

- 痩せ型では後頸点が平均1.1cm高い結果が得られ、補正処理として1.1cm下げる調整を実施

- 肥満型では腋窩点が平均3.7~6.8cm低く検出されるため、適切な上方補正が適用

- 各ランドマーク抽出後の誤差がISO 20685の許容誤差に近づけられたことが統計的に確認

実験では、819名の女性被験者の3Dボディスキャンデータを用い、BMI、首の傾斜、上半身・肩の傾斜に基づいて分類し、各ランドマークの抽出位置を従来基準と比較。痩せ型では後頸点が平均1.1cm高く出る傾向が確認され、補正処理により正確な位置へ調整。肥満型では腋窩点が平均3.7~6.8cm低く抽出され、適切な上方補正が施されました。下記図は、補正処理前後の抽出結果を比較したもので、統計的に有意な改善が確認されています。