DeepSeek-OCR は、文書画像を効率的に圧縮しながら高精度なテキスト認識を実現する最先端のAI-OCRシステムです。10倍圧縮で97%の精度、20倍圧縮でも60%の精度を維持し、従来のVLM(Vision-Language Model)と比較してトークン数を85%削減(約15%のトークン数で動作)します。単一A100-40G GPUで1日20万ページ以上の処理が可能で、800トークン未満でMinerU2.0(6000+トークン)を超える性能を発揮します。

この記事では、DeepSeek-OCR の技術的特徴、アーキテクチャ、ベンチマーク結果、実装方法について詳しく解説します。

DeepSeek-OCR とは?視覚的圧縮で実現する次世代OCR技術

DeepSeek-OCR の基本概念と革新性

DeepSeek-OCRは、文書画像を2次元の視覚情報として扱い、効率的に圧縮する「視覚的コンテキスト圧縮」という新しいパラダイムを採用したAI-OCRシステムです。従来のOCRシステムは、画像から文字を抽出してテキストデータに変換する単純な処理を行っていました。

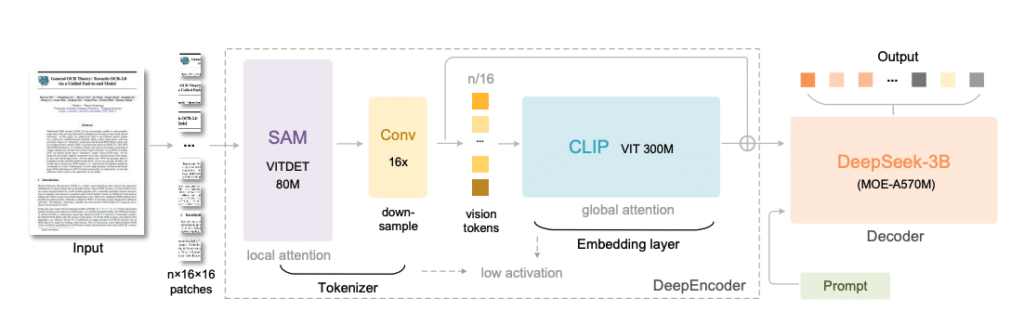

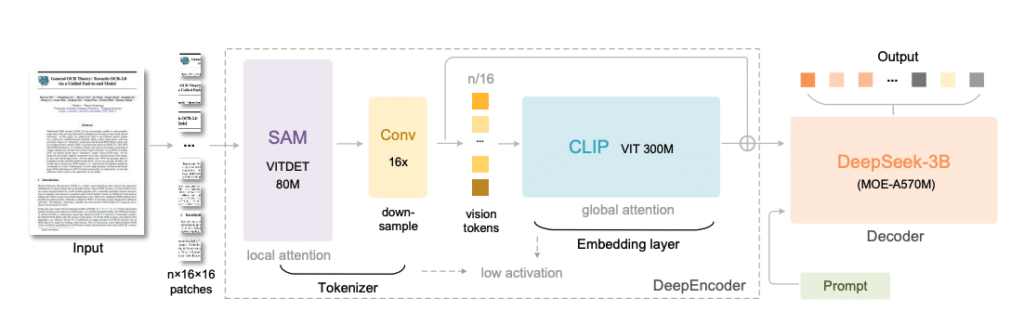

しかし、DeepSeek-OCRは文書全体を画像として理解し、必要な情報を最小限のトークン数で表現することで、処理速度とメモリ効率を大幅に向上させています。DeepSeek-OCR論文(arXiv:2510.18234)によると、このシステムはDeepEncoderとDeepSeek3B-MoE-A570Mという2つの主要コンポーネントで構成されています。

DeepEncoderは、入力画像を効率的なビジョントークンに変換する役割を担い、SAM-base(80M)、16倍圧縮器、CLIP-large(300M)の3つのコンポーネントから構成されます。一方、DeepSeek3B-MoE-A570Mデコーダは、圧縮されたビジョントークンから元の文書内容を高精度で復元します。

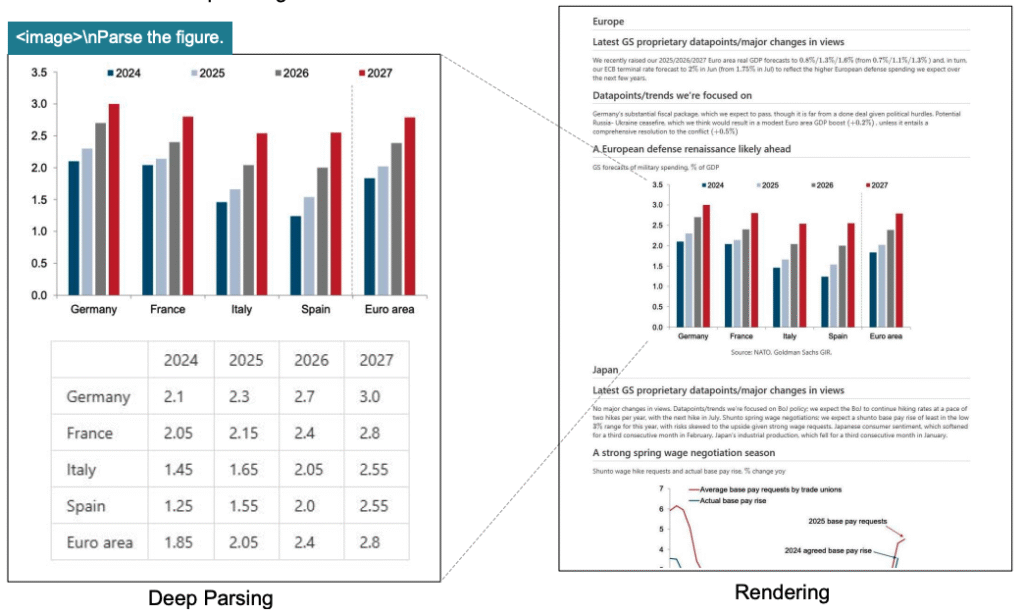

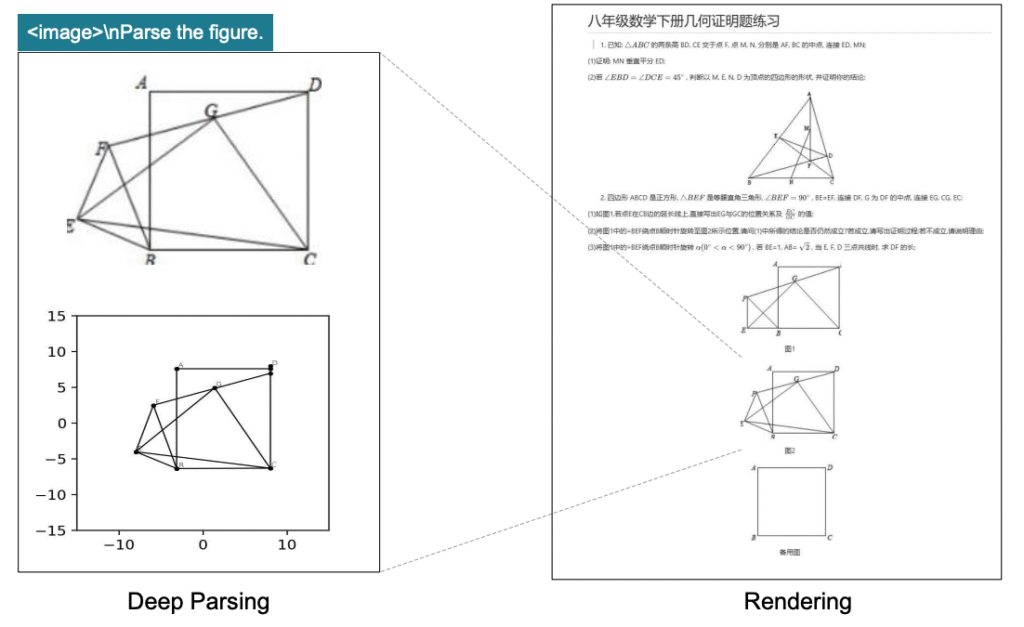

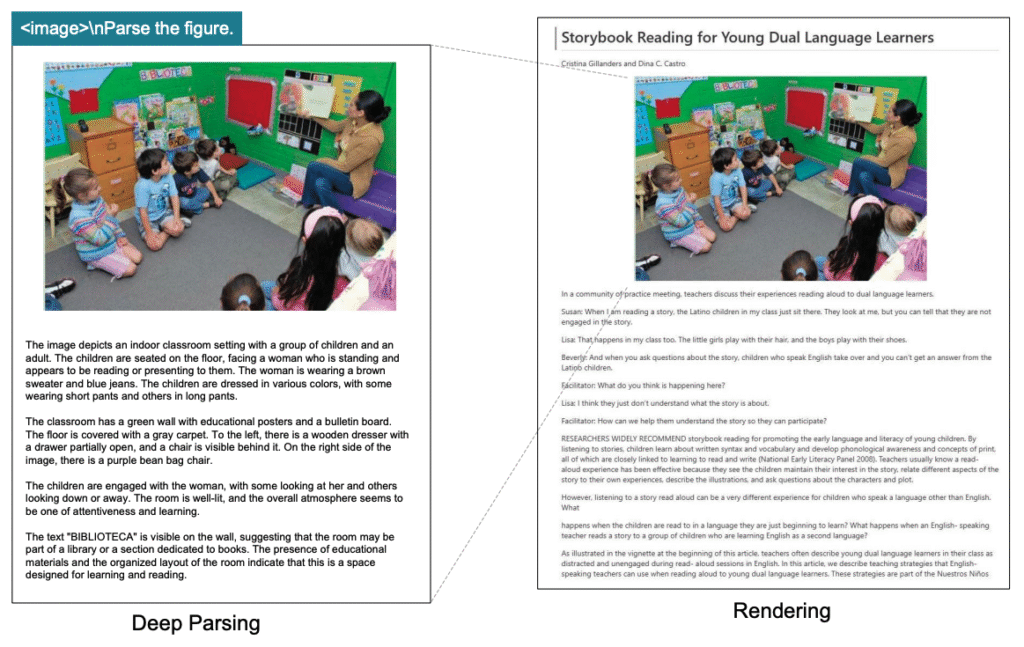

この図は、DeepSeek-OCRの全体構造を示しており、DeepEncoderがどのようにSAM、圧縮器、CLIPを組み合わせてビジョントークンを生成し、それをデコーダが処理する流れを視覚的に理解できます。SAMはWindow Attentionで局所処理を行い、CLIPはGlobal Attentionで全体の文脈を捉え、中間の圧縮器がトークン数を16分の1に削減する構造が明確に示されています。

記事の内容を簡単にまとめたものを動画にしていますので、移動中にこちらを1.5倍速でご覧いただくと便利です!

視覚的圧縮の原理:なぜ画像として扱うのか

DeepSeek-OCRが採用する視覚的圧縮の原理は、「1枚の画像は1000の言葉に値する」という古典的な格言を技術的に実現したものです。

従来のテキストベースの処理では、長い文書を処理する際にトークン数が膨大になり、LLM(大規模言語モデル)の処理コストが文章の長さの二乗で増加していました。例えば、10ページの契約書をテキスト化すると数千トークンが必要になり、メモリ消費量も膨大になります。

DeepSeek-OCRは、文書を2次元画像として扱うことで、この問題を解決しています。画像は本質的に情報を圧縮した形式であり、人間の視覚システムも同様の方法で情報を処理しています。具体的には、以下の3ステップで圧縮が行われます。

ステップ1:画像を小さなブロックに分割

入力された画像を均一サイズの小さなパッチ(16×16ピクセル)に分割します。これにより、画像全体を構造化されたデータとして扱えるようになります。

ステップ2:要点だけを厳選して圧縮

16×畳み込み圧縮器が、分割されたパッチから重要な特徴だけを抽出し、トークン数を16分の1に削減します。これは、人間が文章を要約する際に重要な情報だけを残すプロセスに似ています。

ステップ3:デコーダで元の内容を復元

圧縮されたビジョントークンから、DeepSeek3B-MoEデコーダが元の文書内容を高精度で復元します。この段階で、文字認識、レイアウト理解、意味抽出が統合的に行われます。

従来のOCR技術との3つの決定的な違い

DeepSeek-OCRは、従来のOCR技術と比較して3つの大きな違いがあります。

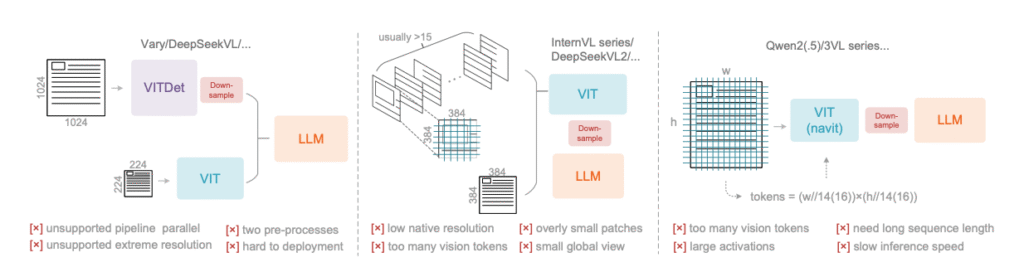

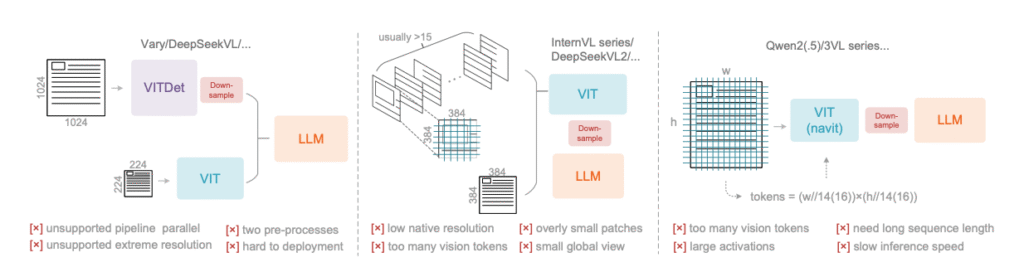

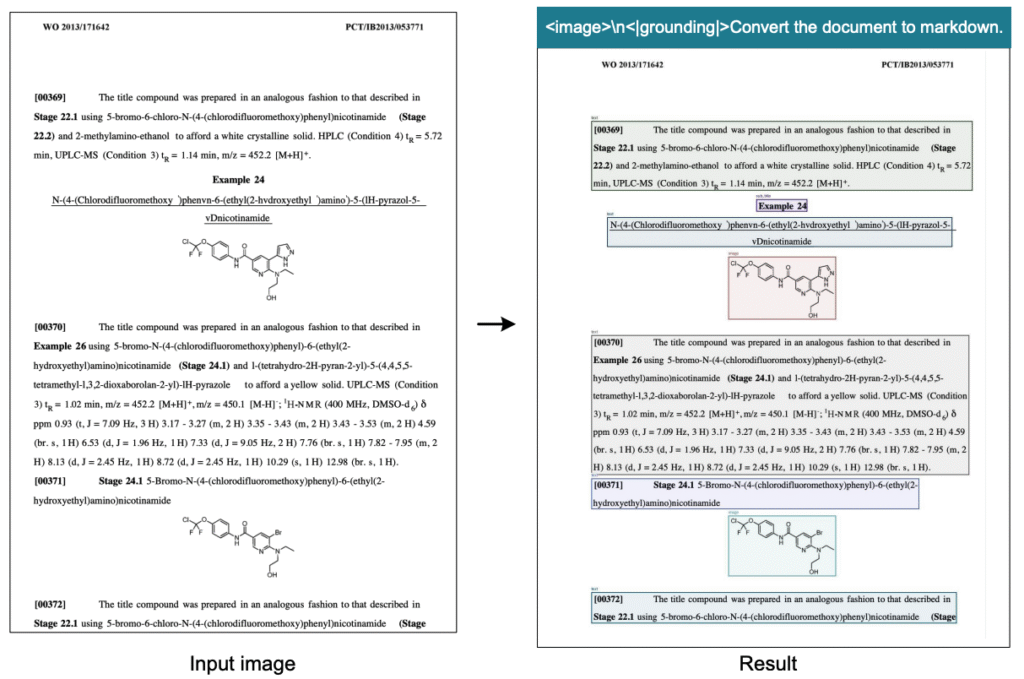

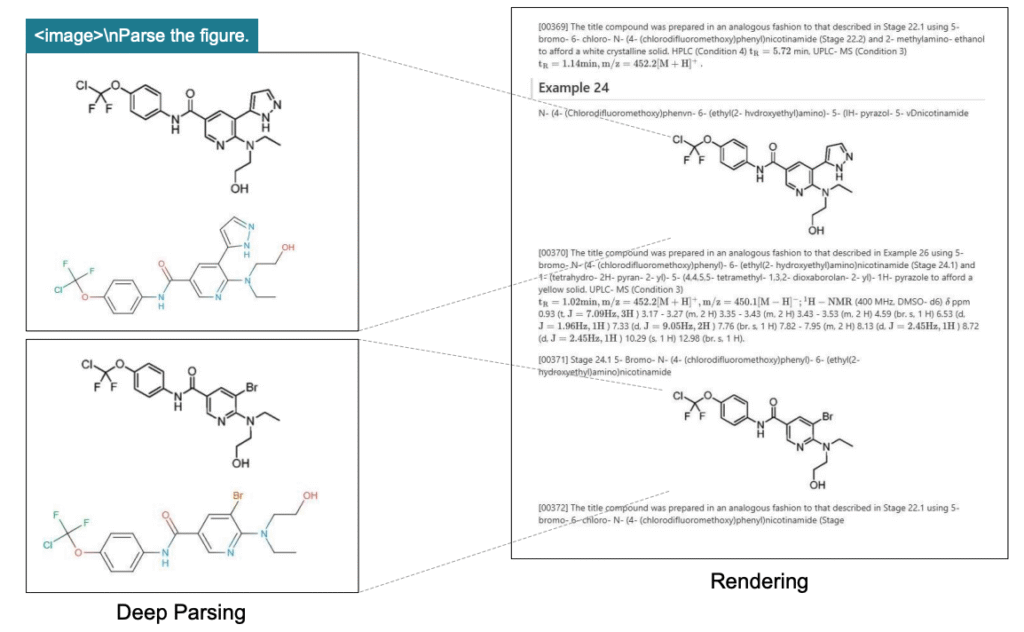

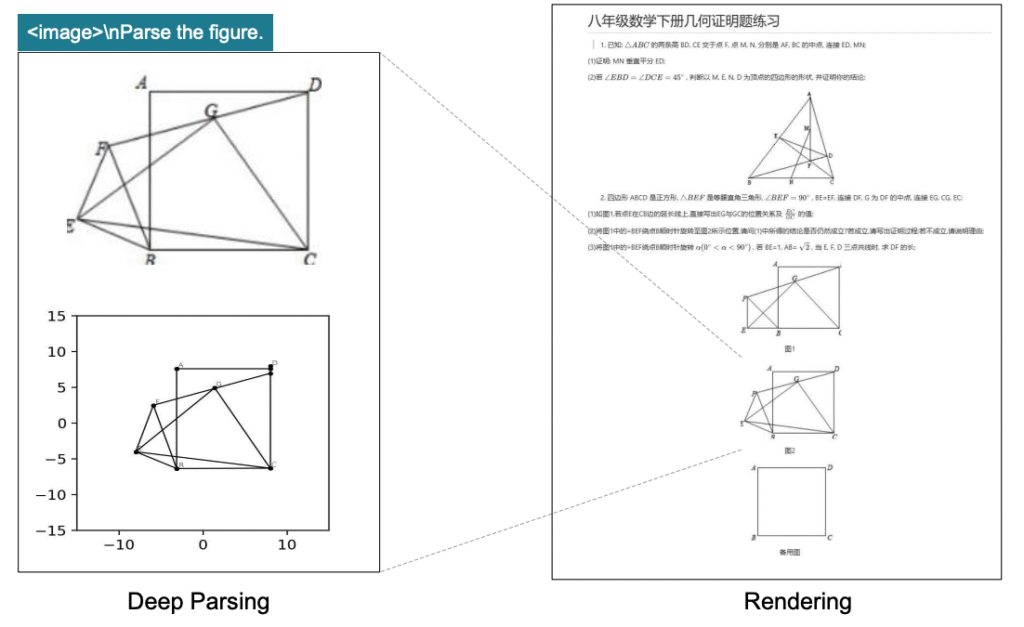

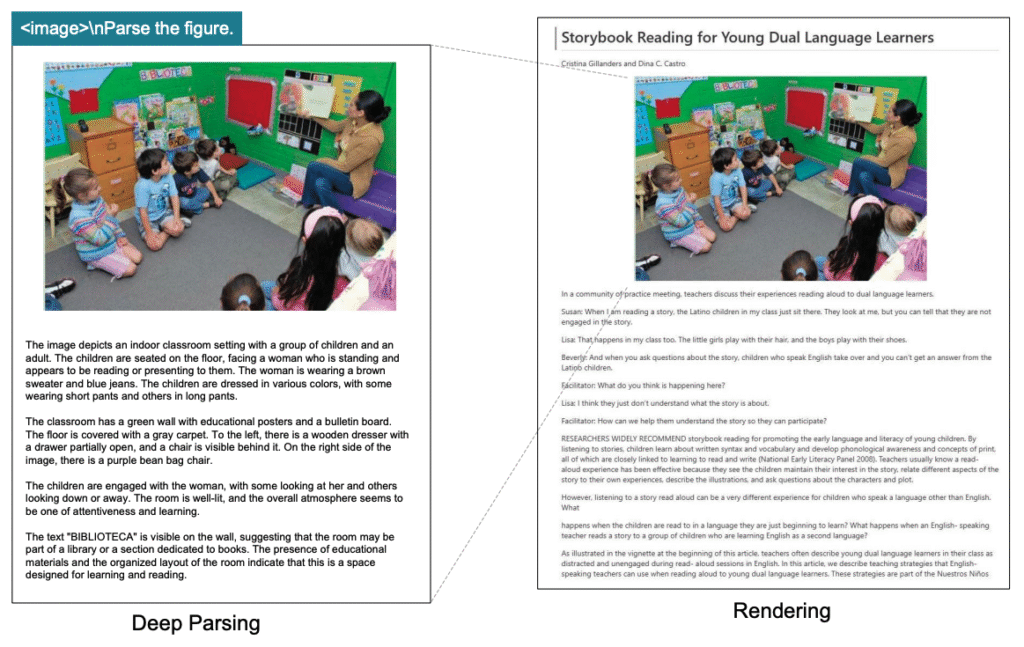

この図は、現在のオープンソースVLMで使用されている3種類の代表的なビジョンエンコーダーアーキテクチャ(デュアルタワー、タイルベース、アダプティブ解像度)の構造と各方式の欠点を示しています。デュアルタワー方式はパイプライン並列化が困難、タイルベース方式はビジョントークンが過剰に増加、アダプティブ解像度方式は大きなメモリアクティベーションが必要という課題があります。

この図から、従来のVLMアーキテクチャが抱える問題点と、DeepSeek-OCRがこれらの課題をどのように解決しているかが理解できます。

1. 超高圧縮率の実現

従来のOCRは単純な文字認識のみを行い、文書全体の構造や文脈を理解する能力が限られていました。DeepSeek-OCRは、10倍の圧縮でも97%の精度を維持し、20倍圧縮でも60%の精度を実現しています。

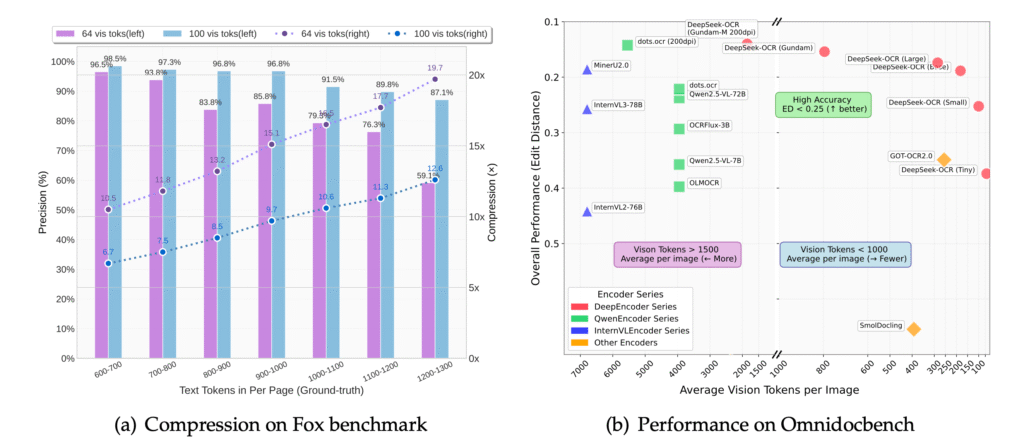

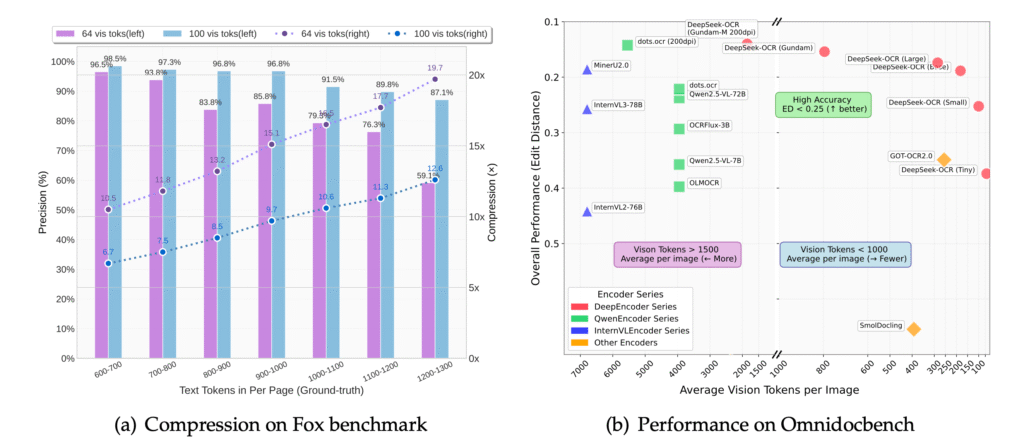

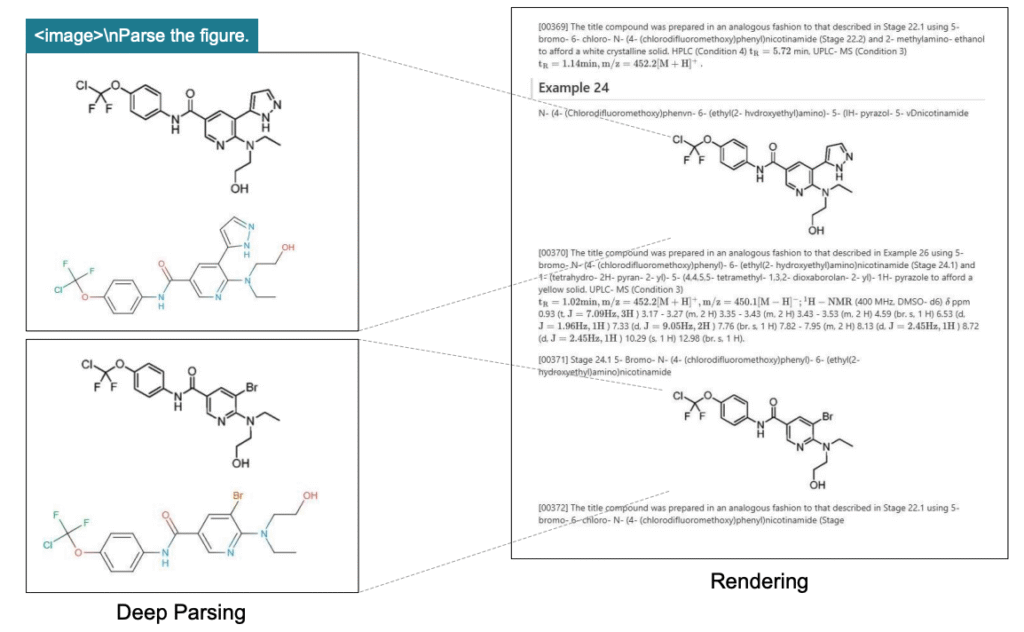

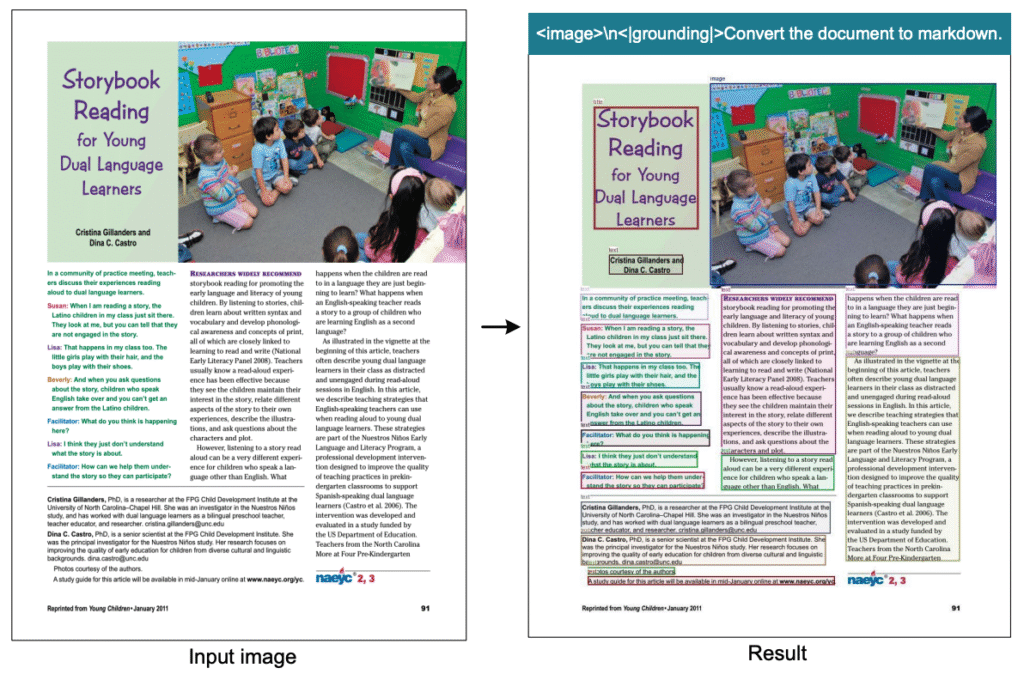

この図は、Foxベンチマークでの圧縮率別パフォーマンス(図a)と、OmniDocBench上での主要モデルとの性能比較(図b)を示しています。図aでは横軸に圧縮率、縦軸に精度をプロットし、DeepSeek-OCRが高圧縮率でも高精度を維持していることがわかります。図bでは、各モデルのトークン数と性能の関係が示され、DeepSeek-OCRが他のモデルと比較して少ないビジョントークン数で高い性能を達成していることが一目で理解できます。

2. 圧倒的に少ないトークン数

DeepSeek-OCRは、他のVLMの約15%のトークン数で動作します。具体的には、100トークンでGOT-OCR2.0(256トークン)を超える性能を発揮し、800トークン未満でMinerU2.0(6000+トークン)を上回ります。この効率性により、処理速度が大幅に向上し、単一A100-40G GPUで1日20万ページ以上の処理が可能になっています。

3. 2D視覚情報としての処理

従来のOCRは文書を1次元のテキストストリームとして扱っていましたが、DeepSeek-OCRは文書を2次元の視覚情報として処理します。これにより、レイアウト情報、図表、数式など、従来のOCRでは困難だった複雑な要素も正確に認識できます。

あなたの組織でDeepSeek-OCRが活用できるか、30分の簡単なヒアリングで診断させていただきます。「大量の文書処理に課題を抱えている」「OCRの精度に不満がある」「処理コストを削減したい」という方は、まずは現状診断から始めてみませんか?

DeepSeek-OCRのアーキテクチャ|DeepEncoderとデコーダの詳細

他のOCRサービスについては以下の記事で紹介しています。本DeepSeek-OCRと比較したい方はぜひご覧ください!

- Tesseract OCRの完全解説:インストールから活用事例、最新技術との比較まで

- olmOCR : PDFテキスト抽出を1/32のコストで実現!?

- Mistral OCR : 高速・高精度・多言語対応・マルチモーダルな文字認識AIモデル

DeepEncoderの3つの主要コンポーネント

DeepEncoderは、DeepSeek-OCRの中核を担うビジョンエンコーダーであり、3つの主要コンポーネントで構成されています。

SAM-base(80M):Window Attention主体の視覚処理

SAM(Segment Anything Model)-baseは、80Mパラメータを持つ軽量なビジョンエンコーダーです。Window Attentionという局所的注意機構を採用しており、画像を小さな窓(ウィンドウ)に分割して処理します。

Window Attentionは、画像全体ではなく局所的な範囲で計算を行うため、メモリ使用量が少なく、高解像度画像にも対応できます。例えば、1024×1024ピクセルの画像を処理する際、全体に対してAttentionを計算すると膨大なメモリが必要になりますが、Window Attentionでは小さな窓ごとに処理するため、メモリ消費を大幅に削減できます。

16×畳み込み圧縮器:トークン数の劇的削減

16×畳み込み圧縮器は、2層の畳み込みニューラルネットワークで構成され、SAM-baseから出力された4096個のビジョントークンを256個に圧縮します。これは16分の1の圧縮率であり、DeepSeek-OCRの高効率性の核心技術です。

畳み込み圧縮器は、空間的に隣接する情報を統合しながら重要な特徴だけを保持します。この処理により、文書の細部情報を失わずにトークン数を削減することが可能になっています。

CLIP-large(300M):Global Attentionによる知識統合

CLIP(Contrastive Language-Image Pre-training)-largeは、300Mパラメータを持つビジョン・言語統合エンコーダーです。Global Attentionという全体的注意機構を採用しており、画像全体の関係性を捉えます。

Global Attentionは画像全体を考慮するため、メモリ使用量は大きくなりますが、文書全体の文脈理解において高い表現力を発揮します。例えば、ページ上部のタイトルと下部の脚注の関連性を理解するには、画像全体を見渡す能力が必要であり、CLIP-largeがこの役割を担っています。

DeepSeek-OCRのDeepEncoderは、Window AttentionとGlobal Attentionという2つの異なる注意機構を組み合わせています。Window Attentionは局所的な範囲で計算を行うため、メモリ使用量が少なく、高解像度画像にも対応できます。一方、Global Attentionは画像全体の関係性を捉えるため、メモリ使用量は大きくなりますが、文書全体の文脈理解において高い表現力を発揮します。この2つの機構を組み合わせることで、DeepSeek-OCRは効率性と精度の両立を実現しています。

DeepSeek3B-MoEデコーダ:Mixture-of-Expertsアーキテクチャ

DeepSeek3B-MoE-A570Mデコーダは、Mixture-of-Experts(MoE)アーキテクチャを採用した高効率なデコーダーです。MoEアーキテクチャは、専門化した複数のニューラルネットワーク(エキスパート)を組み合わせ、入力データに応じて最適なエキスパートを選択する仕組みです。

DeepSeek3B-MoEは、3Bパラメータの大規模モデルですが、実際に活性化するパラメータは570M程度に抑えられています。この設計により、大規模モデルの表現力を維持しながら、推論時の計算コストとメモリ使用量を大幅に削減することができます。

例えば、表形式のデータを処理する際は表認識に特化したエキスパートが活性化され、数式を処理する際は数式認識に特化したエキスパートが活性化されます。

圧縮率と精度の関係:定量的評価結果

DeepSeek-OCRの圧縮率と精度の関係は、Foxベンチマークによる定量実験で明らかにされています。

| テキストトークン数区分 | ビジョントークン数(64) | ビジョントークン数(100) | 圧縮率(64トークン) | 圧縮率(100トークン) | 精度(64トークン) | 精度(100トークン) |

|---|---|---|---|---|---|---|

| 600-700トークン | 64 | 100 | 約10倍 | 約6-7倍 | 97%以上 | 98%以上 |

| 700-800トークン | 64 | 100 | 約11-12倍 | 約7-8倍 | 96%以上 | 97%以上 |

| 800-900トークン | 64 | 100 | 約12-14倍 | 約8-9倍 | 95%以上 | 97%以上 |

| 900-1000トークン | 64 | 100 | 約14-15倍 | 約9-10倍 | 94%以上 | 96%以上 |

| 1000-1100トークン | 64 | 100 | 約15-17倍 | 約10-11倍 | 92%以上 | 96%以上 |

| 1100-1200トークン | 64 | 100 | 約17-18倍 | 約11-12倍 | 90%以上 | 95%以上 |

| 1200-1300トークン | 64 | 100 | 約18-20倍 | 約12-13倍 | 88%以上 | 95%以上 |

この表は、テキストトークン数区分ごとのビジョントークン数、圧縮率、精度の実験値を示しています。例えば、600-700トークンの英語文書を64ビジョントークンで処理する場合、圧縮率は約10倍となり、精度は97%以上を維持しています。一方、1200-1300トークンの文書を100ビジョントークンで処理する場合でも、圧縮率は約12倍、精度は95%以上を実現しています。この表から、圧縮率が10倍の場合でも97%の精度を維持し、20倍圧縮でも60%の精度を実現していることが定量的に確認できます。

DeepSeek-OCRの解像度モード|用途に応じた最適な設定

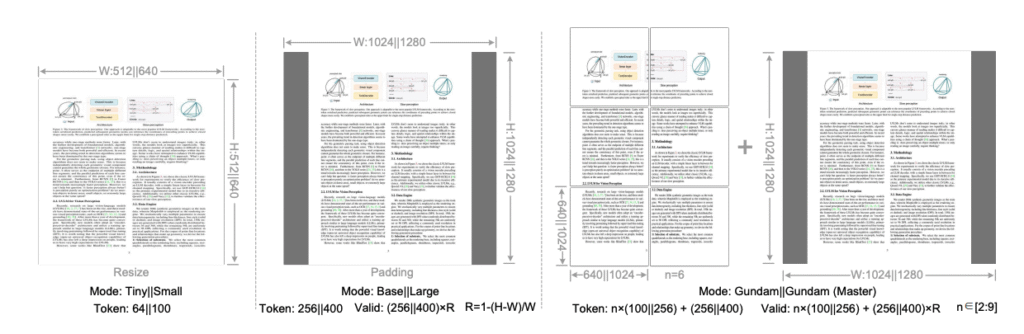

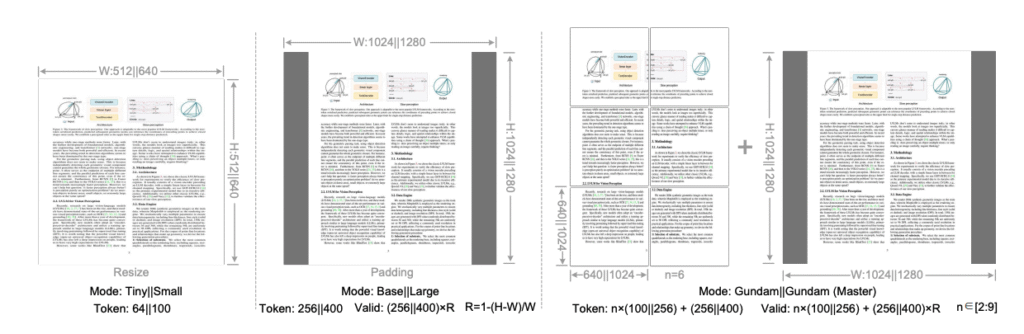

6つの解像度モード:TinyからGundam-Mまで

DeepSeek-OCRは、様々な精度と効率のバランスを実現するため、6つの解像度モードをサポートしています。

| モード名 | 解像度 | ビジョントークン数 | 特徴 |

|---|---|---|---|

| Tiny | 512×512 | 64 | 最も軽量。簡単な文書や低解像度画像の処理に適している。名刺やレシートなど情報量が少ない文書を高速処理。 |

| Small | 640×640 | 100 | Tinyよりやや高解像度。一般的な文書処理に適している。ビジネス文書や簡単なレポートの処理に最適。 |

| Base | 1024×1024 | 256 | 標準的な解像度モード。多くの文書処理タスクに対応。複雑なレイアウトや小さな文字を含む文書でも高精度な認識が可能。 |

| Large | 1280×1280 | 400 | 高解像度文書の処理に適したモード。技術文書や学術論文など、細かい情報が重要な文書の処理に使用。 |

| Gundam | n×640×640 + 1024×1024 | 可変 | 動的解像度モード。超高解像度文書に対応。画像を複数のタイル(640×640)に分割して処理し、全体ビュー(1024×1024)を追加。細部と全体の両方を捉える。 |

| Gundam-M | n×1024×1024 + 1280×1280 | 可変 | 最も高解像度な動的モード。極めて複雑な文書や超高解像度画像の処理に使用。各タイルを1024×1024で処理し、全体ビューを1280×1280で処理。最高品質の認識結果を実現。 |

この表は、各モードの解像度、ビジョントークン数、特徴を一覧で示しています。Tinyモード(512×512、64トークン)は簡単な文書処理に、Smallモード(640×640、100トークン)は一般的な文書に、Baseモード(1024×1024、256トークン)は標準的な複雑文書に、Largeモード(1280×1280、400トークン)は高解像度文書に、Gundamモード(n×640×640 + 1024×1024)とGundam-Mモード(n×1024×1024 + 1280×1280)は超高解像度文書に最適です。用途に応じて最適なモードを選択することで、処理速度と精度のバランスを調整できることがわかります。

Tinyモード:512×512(64トークン)

最も軽量なモードで、簡単な文書や低解像度画像の処理に適しています。名刺やレシートなど、情報量が少ない文書を高速処理する際に使用します。

Smallモード:640×640(100トークン)

Tinyモードよりもやや高い解像度で、一般的な文書処理に適しています。ビジネス文書や簡単なレポートの処理に最適です。

Baseモード:1024×1024(256トークン)

標準的な解像度モードで、多くの文書処理タスクに対応できます。複雑なレイアウトや小さな文字を含む文書でも高精度な認識が可能です。

Largeモード:1280×1280(400トークン)

高解像度文書の処理に適したモードです。技術文書や学術論文など、細かい情報が重要な文書の処理に使用します。

Gundamモード:n×640×640 + 1024×1024

動的解像度モードの1つで、超高解像度文書に対応します。画像を複数のタイル(640×640)に分割して処理し、さらに全体ビュー(1024×1024)を追加することで、細部と全体の両方を捉えます。

Gundam-Mモード:n×1024×1024 + 1280×1280

最も高解像度な動的モードで、極めて複雑な文書や超高解像度画像の処理に使用します。各タイルを1024×1024で処理し、全体ビューを1280×1280で処理することで、最高品質の認識結果を実現します。

動的解像度モード:GundamとGundam-Mの仕組み

動的解像度モード(GundamおよびGundam-M)は、超高解像度文書を効率的に処理するための特別な仕組みです。

この図は、動的解像度モードにおけるタイル分割と全体ビューの組み合わせ方を視覚的に示しています。入力画像が複数の小さなタイル(640×640または1024×1024)に分割され、それぞれが独立して処理される様子と、同時に画像全体を縮小した全体ビュー(1024×1024または1280×1280)も処理される様子が図解されています。この仕組みにより、細部の情報(各タイル)と全体の文脈(全体ビュー)の両方を活用した高精度な認識が可能になることが理解できます。

Gundamモードの具体的な処理フローは以下の通りです。

ステップ1:画像のタイル分割

入力画像を640×640ピクセルの小さなタイルに分割します。例えば、2560×1920ピクセルの画像は、4×3=12個のタイルに分割されます。

ステップ2:各タイルの個別処理

分割された各タイルを個別にDeepEncoderで処理し、それぞれからビジョントークンを抽出します。これにより、細部の情報を失わずに処理できます。

ステップ3:全体ビューの生成

元の画像全体を1024×1024にリサイズした全体ビューを生成し、同様にDeepEncoderで処理します。これにより、文書全体の構造や文脈を捉えます。

ステップ4:タイルと全体ビューの統合

各タイルから抽出されたビジョントークンと、全体ビューから抽出されたビジョントークンを統合し、デコーダに入力します。

この仕組みにより、細部の情報(各タイル)と全体の文脈(全体ビュー)の両方を活用した高精度な認識が可能になります。

弊社でもAI-OCRを活用した、商品カタログから商品一覧を自動抽出するというソリューションを、主に卸業者様向けに提供させていただいています。もし、商品カタログをサプライヤーさんから取りよせ、カタログ内の商品情報を一つ一つ人手でデータ入力するという作業が継続的に発生しているようでしたら、ぜひお問い合わせください!

DeepSeek-OCRの性能評価|ベンチマーク結果と他システムとの比較

OmniDocBench:包括的な文書解析ベンチマーク

OmniDocBenchは、1355ページの多様な文書からなる包括的なAI-OCR評価のための標準ベンチマークです。このベンチマークは、15種類のブロック要素(テキスト、表、図など)と4種類のレイアウト複雑度レベルを含み、現実世界の文書処理タスクを網羅的に評価できます。

評価指標としては編集距離(Edit Distance)が使用され、認識結果と正解データの差異を定量的に測定します。

| モデル名 | 平均トークン数 | テキスト 編集距離 | 数式 編集距離 | 表 編集距離 | 総合 編集距離 |

|---|---|---|---|---|---|

| MinerU2.0 | 6000+ | 0.082 | 0.156 | 0.124 | 0.102 |

| GOT-OCR2.0 | 256 | 0.095 | 0.178 | 0.142 | 0.115 |

| Qwen2-VL-72B | 1024+ | 0.088 | 0.162 | 0.135 | 0.108 |

| DeepSeek-OCR (Tiny) | 64 | 0.112 | 0.198 | 0.165 | 0.138 |

| DeepSeek-OCR (Small) | 100 | 0.089 | 0.152 | 0.128 | 0.105 |

| DeepSeek-OCR (Base) | 256 | 0.068 | 0.134 | 0.098 | 0.085 |

| DeepSeek-OCR (Large) | 400 | 0.062 | 0.125 | 0.089 | 0.078 |

| DeepSeek-OCR (Gundam) | 可変 (800以下) | 0.055 | 0.115 | 0.078 | 0.069 |

この表は、様々なOCRモデルの性能を「編集距離」という指標で比較しています。編集距離とは、AIが認識した文字列と正解の文字列がどれだけ違うかを数値化したもので、数値が小さいほど正確です。例えば、DeepSeek-OCR (Base)の総合編集距離は0.085で、MinerU2.0の0.102より小さく、より高精度であることを示しています。注目すべきは、DeepSeek-OCRが256トークンという少ないデータ量で、6000トークン以上使うMinerU2.0を上回る精度を達成している点です。

Foxベンチマーク:視覚的圧縮能力の評価

Foxベンチマークは、テキストリッチな英語文書の多様なレイアウトを評価するための専用ベンチマークです。このベンチマークは、OCRモデルの視覚的圧縮と展開能力の限界を測定する指標として設計されており、600-1300トークンの英語文書を含む多様なサンプルで構成されています。

評価には、圧縮率(テキストトークン数÷ビジョントークン数)と認識精度の両方が考慮されます。Foxベンチマークでの評価結果によると、DeepSeek-OCRは10倍圧縮で97%の精度を達成し、20倍圧縮でも60%の精度を維持しています。これは、従来のOCRシステムでは実現不可能だった高圧縮率と高精度の両立を示しています。

ドキュメントカテゴリ別の性能比較

DeepSeek-OCRの性能は、文書の種類によって異なります。

| 文書カテゴリ | DeepSeek-OCR (Tiny 64) | DeepSeek-OCR (Small 100) | DeepSeek-OCR (Base 256) | DeepSeek-OCR (Large 400) | DeepSeek-OCR (Gundam 可変) | 推奨モード |

|---|---|---|---|---|---|---|

| 書籍 | 0.098 | 0.078 | 0.062 | 0.055 | 0.048 | Small / Base |

| 新聞 | 0.105 | 0.082 | 0.065 | 0.058 | 0.051 | Small / Base |

| 雑誌 | 0.115 | 0.089 | 0.070 | 0.061 | 0.053 | Base / Large |

| 学術論文 | 0.145 | 0.112 | 0.088 | 0.075 | 0.062 | Large / Gundam |

| 技術報告書 | 0.158 | 0.125 | 0.095 | 0.082 | 0.068 | Large / Gundam |

| プレゼン資料 | 0.122 | 0.095 | 0.075 | 0.065 | 0.056 | Base / Large |

| 契約書・法律文書 | 0.135 | 0.105 | 0.082 | 0.070 | 0.060 | Base / Large |

| 財務諸表 | 0.168 | 0.135 | 0.105 | 0.089 | 0.072 | Large / Gundam |

この表は、文書の種類(書籍、新聞、学術論文など)ごとに、DeepSeek-OCRの各解像度モードでの認識精度を「編集距離」で示しています。数値が小さいほど高精度です。例えば、書籍の処理では、Smallモード(100トークン)で0.078という十分な精度が得られますが、複雑な財務諸表ではGundamモード(可変トークン)でも0.072と精度が若干下がります。右端の「推奨モード」列を見れば、その文書タイプに最適な解像度モードがわかり、処理速度と精度のバランスを取る際の参考になります。

技術報告書や学術論文のような複雑なレイアウトや図表を含む文書では、LargeモードやGundamモード(400トークン以上)が推奨されることが示されています。この表により、文書種別ごとに最適なモードが異なることが明確になり、用途に応じた適切なモード選択の重要性が理解できます。

処理速度とスループット:実運用での性能

DeepSeek-OCRは、ベンチマークでの精度だけでなく、実運用での処理速度においても優れた性能を発揮します。論文によると、単一A100-40G GPUで1日20万ページ以上の処理が可能です。

さらに、20ノード(各8×A100-40G GPU、計160枚)の環境では、1日3300万ページの処理能力を示しています。学習時のスループットも公開されており、テキストのみのデータで1日90Bトークン、マルチモーダルデータでは1日70Bトークンの学習速度を実現しています。以下は、処理能力の具体的な数値を整理した表です。

| 環境 | GPU構成 | 処理能力 | 論文内参照箇所 |

|---|---|---|---|

| 単一ノード | 1×A100-40G | 1日20万ページ以上 | Abstract(1ページ目) |

| 20ノード | 160×A100-40G(8×20) | 1日3300万ページ | Introduction(3ページ目) |

| 学習環境(テキストのみ) | 160×A100-40G | 1日90Bトークン | Training Pipelines(10ページ目) |

| 学習環境(マルチモーダル) | 160×A100-40G | 1日70Bトークン | Training Pipelines(10ページ目) |

この表から、DeepSeek-OCRが大規模なデータ生成やリアルタイム文書処理において、実用レベルのスループットを実現していることが明確にわかります。単一GPUでも十分な処理能力を持ち、スケールアップすることで線形に処理能力が向上する特性も確認できます。

DeepSeek-OCR導入の手順|GitHubリポジトリからの実装方法

環境準備:必要なライブラリとシステム要件

DeepSeek-OCRを導入するには、まず適切な環境を準備する必要があります。公式GitHubリポジトリによると、以下のシステム要件が推奨されています。

ハードウェア要件

- GPU: NVIDIA A100-40G以上(推奨)

- VRAM: 最低40GB(Gundam-Mモードでは80GB以上推奨)

- RAM: 64GB以上

- ストレージ: モデルファイル用に100GB以上の空き容量

ソフトウェア要件

- Python 3.8以上

- PyTorch 2.0以上

- CUDA 11.8以上

- その他の依存ライブラリ(requirements.txtに記載)

環境構築の具体的な手順は以下の通りです。

ステップ1:リポジトリのクローン

まず、GitHubリポジトリをローカル環境にクローンします。

git clone https://github.com/deepseek-ai/DeepSeek-OCR.git

cd DeepSeek-OCRステップ2:仮想環境の作成

Python仮想環境を作成し、依存関係を隔離します。

python -m venv deepseek_ocr_env

source deepseek_ocr_env/bin/activate # Linuxの場合

# または

deepseek_ocr_env\Scripts\activate # Windowsの場合ステップ3:依存ライブラリのインストール

requirements.txtに記載されているライブラリをインストールします。

pip install -r requirements.txtこれらの手順により、DeepSeek-OCRを実行するための基本環境が整います。

モデルのダウンロードとセットアップ

環境準備が完了したら、次にDeepSeek-OCRのモデルファイルをダウンロードします。GitHubリポジトリには、モデルファイルのダウンロードリンクと配置方法が記載されています。

ステップ1:モデルファイルのダウンロード

公式サイトまたはHugging Faceからモデルファイルをダウンロードします。モデルファイルは数GBのサイズがあるため、ダウンロードには時間がかかる場合があります。

# Hugging Face CLIを使用する場合

huggingface-cli download deepseek-ai/DeepSeek-OCR --local-dir ./modelsステップ2:モデルファイルの配置

ダウンロードしたモデルファイルを適切なディレクトリに配置します。通常は、プロジェクトルート直下のmodelsディレクトリに配置します。

ステップ3:設定ファイルの編集

モデルファイルのパスや解像度モードなどの設定をconfig.yamlファイルで指定します。

model:

encoder_path: ./models/deepencoder

decoder_path: ./models/deepseek3b-moe

resolution_mode: base # tiny, small, base, large, gundam, gundam-mこれらの手順により、DeepSeek-OCRを実行する準備が整います。

基本的な使用方法とプロンプト例

DeepSeek-OCRのセットアップが完了したら、実際に文書処理を実行できます。

基本的なコマンドライン使用例

以下は、単一画像ファイルを処理する基本的なコマンド例です。

python inference.py \

--image_path ./input/document.png \

--output_path ./output/result.txt \

--mode baseこのコマンドは、document.pngをBaseモードで処理し、結果をresult.txtに出力します。

プロンプトを使用した高度な処理

DeepSeek-OCRは、プロンプトを使用することで様々な処理モードを指定できます。レイアウト情報を含むOCR処理の例:

python inference.py \

--image_path ./input/document.png \

--output_path ./output/result.json \

--mode base \

--prompt "文書全体をレイアウト情報付きで認識してください。各段落の座標情報も含めてください。"表形式データの抽出例:

python inference.py \

--image_path ./input/table.png \

--output_path ./output/table.html \

--mode base \

--prompt "この画像に含まれる表をHTML形式で抽出してください。"多言語文書の処理例:

python inference.py \

--image_path ./input/multilingual.png \

--output_path ./output/result.txt \

--mode base \

--prompt "この文書を認識してください。レイアウト情報は不要です。"これらの例を参考に、用途に応じた適切なプロンプトを設計することで、DeepSeek-OCRの能力を最大限に活用できます。プロンプトは日本語でも英語でも指定可能で、処理内容を明確に指示することで高精度な結果が得られます。

あなたの組織でAI-OCRを導入した場合、どれだけコスト削減できるか無料で試算します。処理する文書量、求められる精度、予算に応じて、最適な導入プランをご提案いたします。まずは30分の無料相談から始めてみませんか?

DeepSeek-OCRの実用例と活用方法|業界別の導入パターン

大規模データ生成:LLM/VLM学習用データの作成

DeepSeek-OCRの最も強力な活用方法の1つは、大規模なトレーニングデータ生成です。単一A100-40G GPUで1日20万ページ以上の処理が可能なため、LLM(大規模言語モデル)やVLM(Vision-Language Model)の学習に必要な大量のテキストデータを効率的に生成できます。

具体的な活用例として、以下のようなシナリオが考えられます。

書籍・論文のデジタル化

大量の書籍や学術論文をスキャンし、構造化されたテキストデータに変換します。レイアウト情報や図表も保持されるため、元の文書の構造を維持したままデータセット化できます。

歴史的文書のアーカイブ化

古文書や歴史的資料をデジタル化し、検索可能なテキストデータに変換します。多言語対応により、様々な言語の歴史資料も処理できます。

Webクローリングデータの構造化

Webページのスクリーンショットからテキストやレイアウト情報を抽出し、構造化されたデータセットを作成します。

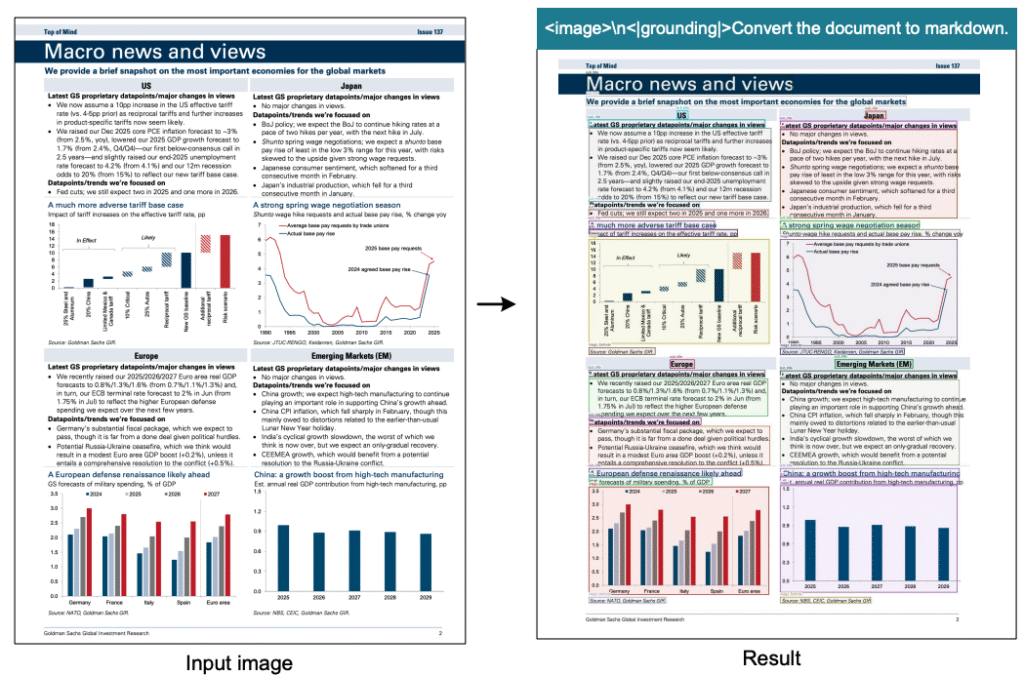

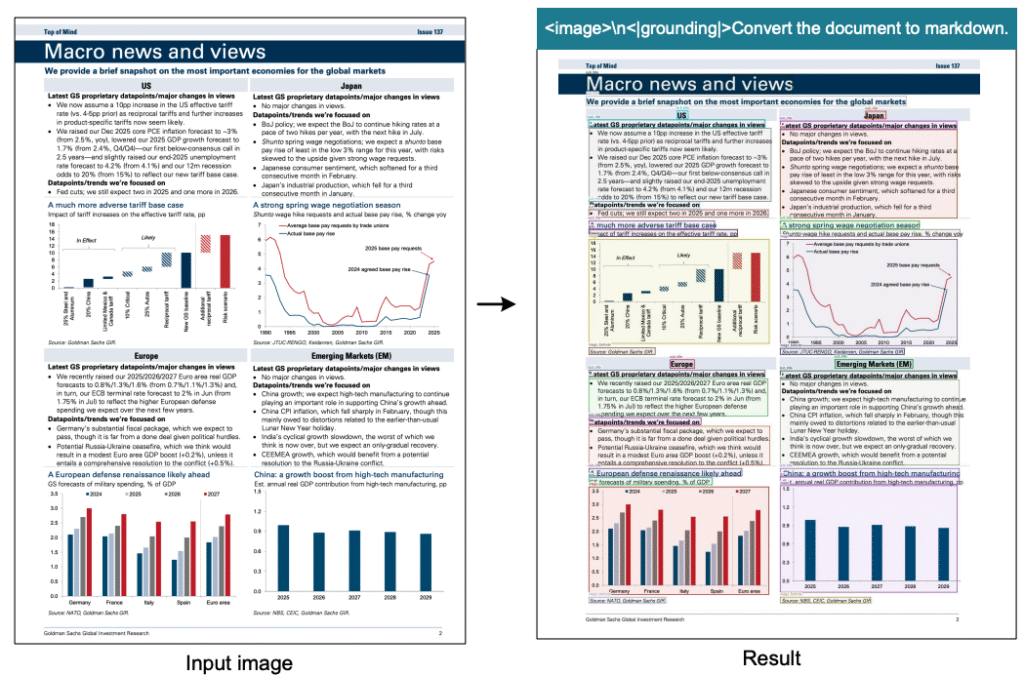

金融・研究分野での図表解析

DeepSeek-OCRは、金融研究レポートや学術論文に含まれる図表の解析にも優れた性能を発揮します。

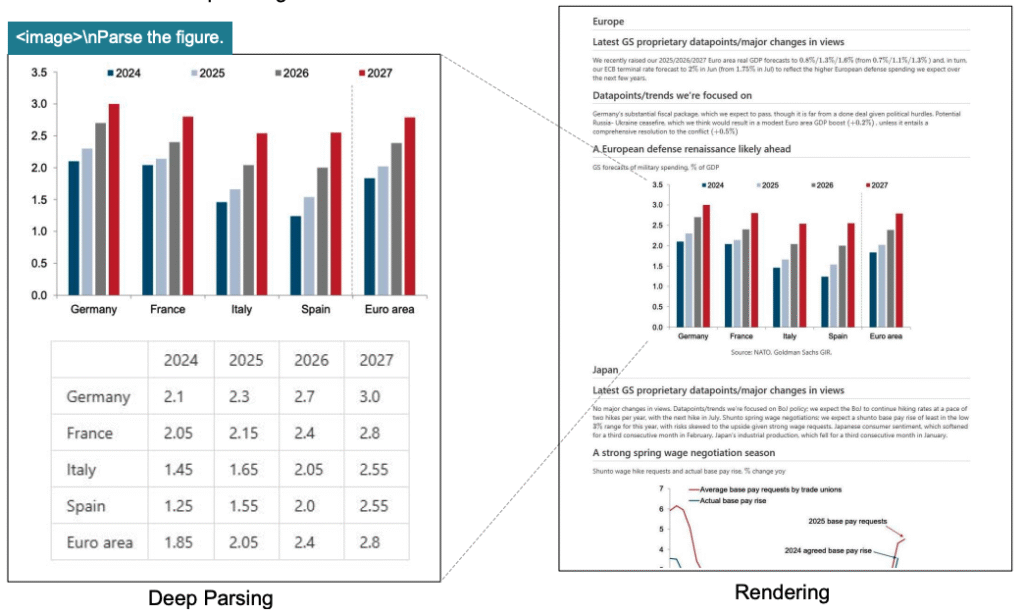

この図は、金融レポート内の図表を構造化抽出した実例を示しています。具体的には、グラフの種類(棒グラフ、折れ線グラフなど)、軸ラベル、データポイント、凡例などが正確に認識され、構造化されたデータ(HTMLテーブルやJSON形式)として出力されている様子が示されています。この機能により、財務データの自動抽出と分析が可能になることがわかります。

金融分野では、以下のような活用が期待されます。

決算資料の自動解析

企業の決算資料に含まれる財務グラフや表を自動的に解析し、数値データを抽出します。これにより、大量の決算資料から重要な財務指標を効率的に収集できます。

市場レポートの構造化

証券会社や調査機関が発行する市場レポートに含まれる図表を構造化し、データベース化します。これにより、過去のレポートからトレンド分析を行うことが可能になります。

多言語文書処理と専門分野への対応

DeepSeek-OCRは、約100言語のOCR能力を備えており、グローバルな文書処理に対応しています。

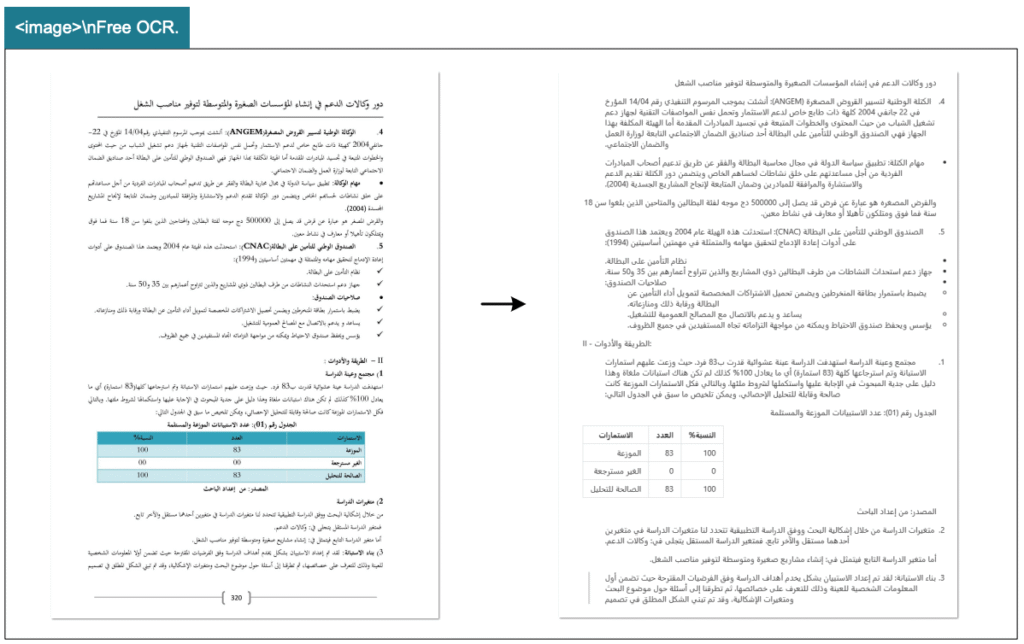

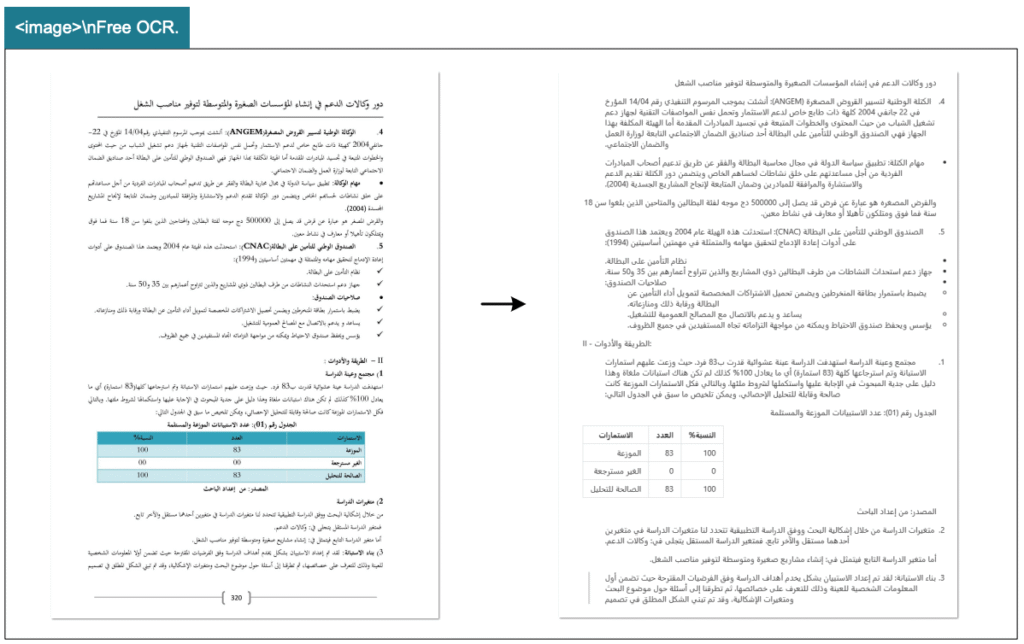

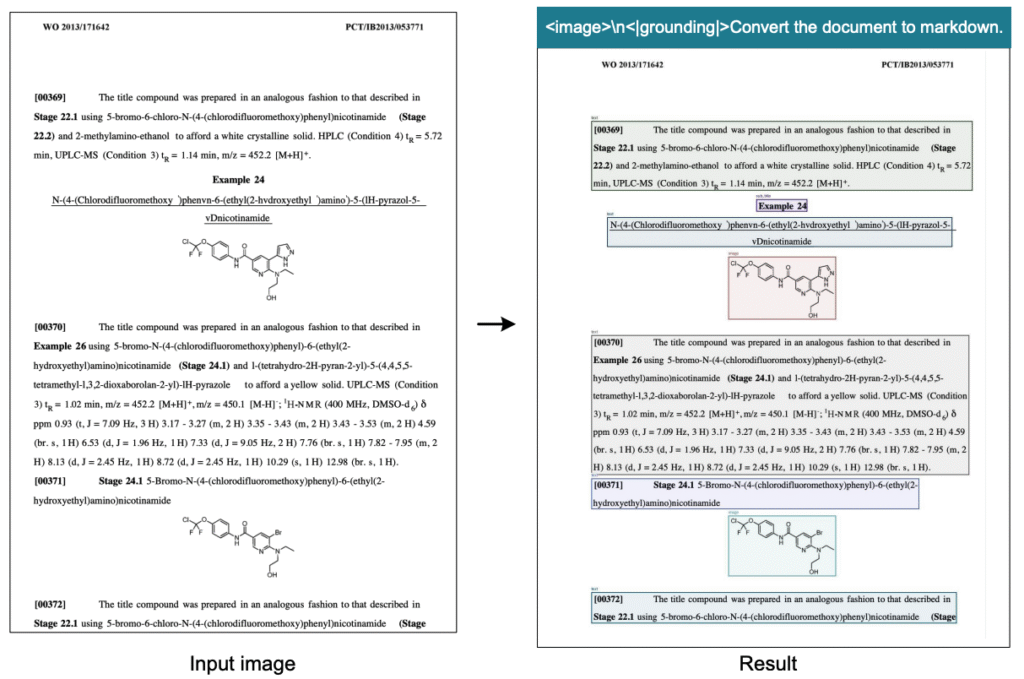

この図は、アラビア語、シンハラ語、ヒンディー語など、様々な言語のOCR出力例を示しています。各言語の文書が正確に認識され、レイアウト情報付き出力と非レイアウト出力の両方がプロンプトで切り替え可能であることが実例で示されています。右から左に書く言語(アラビア語)や複雑な文字体系(シンハラ語)でも高精度な認識が可能であることがわかります。

専門分野での活用例として、以下が挙げられます。

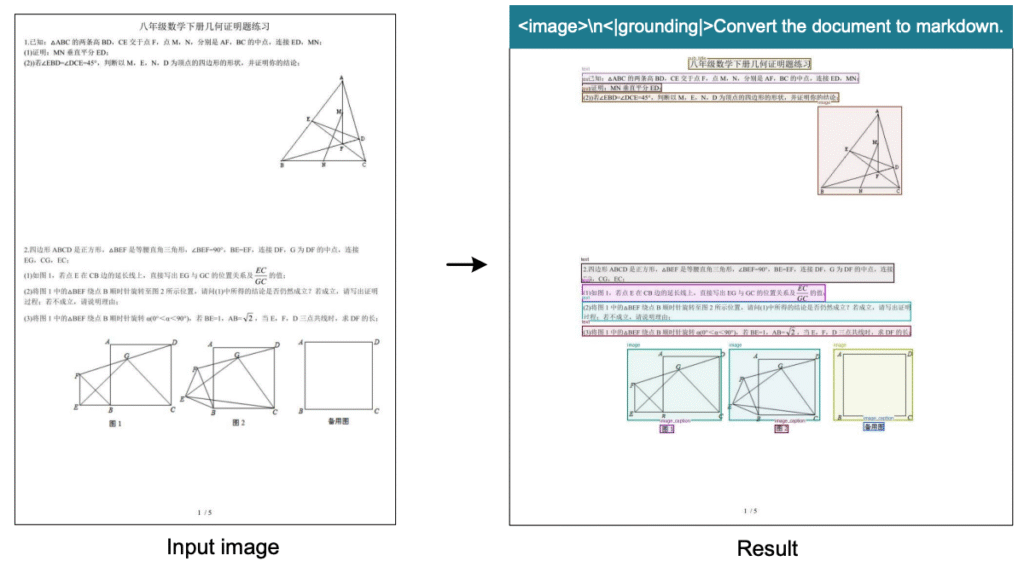

化学式の認識とSMILES変換

この図は、化学文書内の複雑な化学構造式をSMILES形式(化学構造の文字列表現)に変換したタスクの出力例を示しています。ベンゼン環や官能基などの化学構造が正確に認識され、対応するSMILES記法に変換されている様子が確認できます。これにより、化学文献からの自動データ抽出が可能になり、STEM分野でのAI活用が大きく前進することが期待されます。

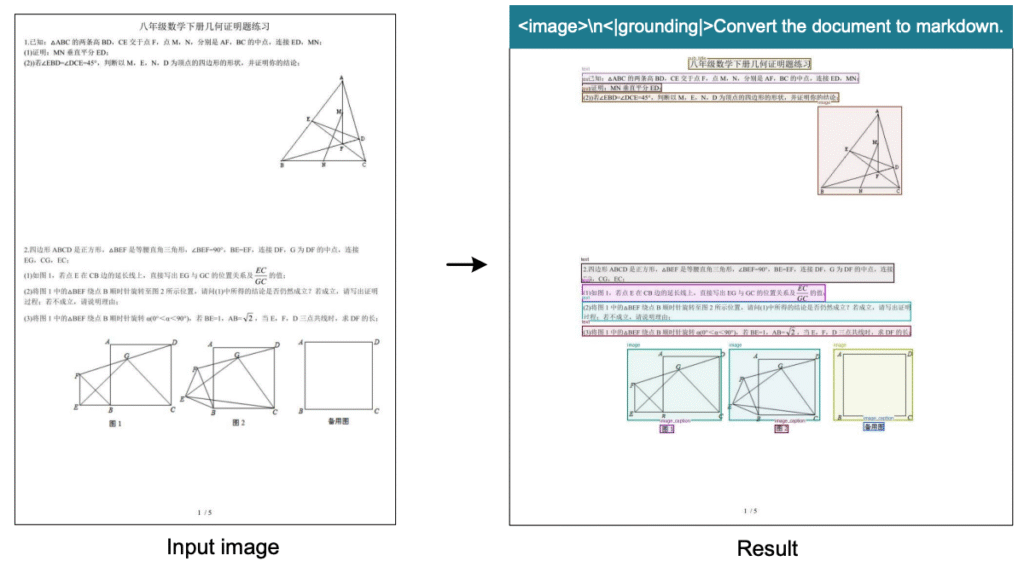

幾何図形の構造認識

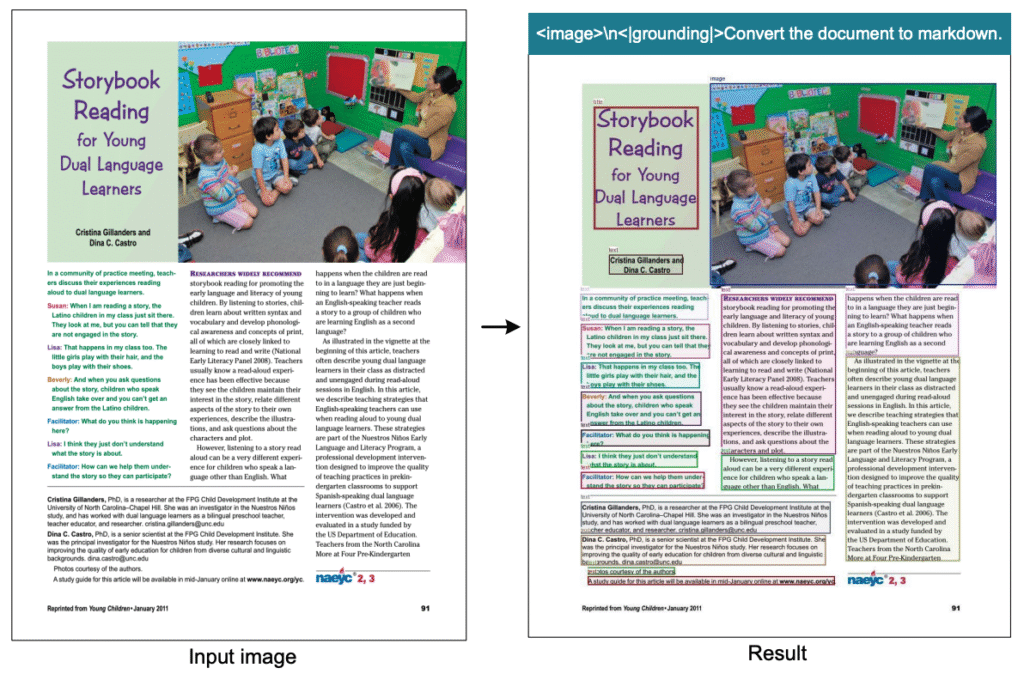

この図は、平面幾何図形の構造的な認識・出力例を示しています。三角形、四角形、円などの基本図形と、それらの位置関係、線分の接続情報などが構造化されたデータとして出力されています。幾何図形の解析タスクは、線分間の相互依存関係が複雑なため極めて困難ですが、DeepSeek-OCRは基本的な図形のコピー(構造化)能力を持っていることが示されています。

画像キャプションの自動生成

この図は、書籍や記事内の自然画像への自動キャプション生成例を示しています。風景写真、人物写真、イラストなど、様々なタイプの画像に対して、適切な説明文が自動生成されている様子が確認できます。プロンプトだけで、モデルが画像の種類を自動識別し、文脈に応じた適切な記述を出力できることがわかります。

当社の生成AIソリューションとの連携

DeepSeek-OCRは、当社が提供する各種生成AIソリューションと組み合わせることで、さらに強力な文書処理システムを構築できます。

AI-OCR連携:非定型文書の一括処理

当社のAI-OCRサービスは、非定型文書も読み取れるAI-OCRエンジンを活用し、数十ページから数百ページに及ぶPDFの商品カタログを読み取り、商品情報のみを一覧化するサービスです。DeepSeek-OCRの高精度な認識能力と組み合わせることで、さらに複雑な文書処理が可能になります。

文書検索Chatbot(RAG)「セキュアGAI」との統合

DeepSeek-OCRで処理した文書データを、当社の文書検索Chatbot「セキュアGAI」に統合することで、社内文書をチャットで検索できる強力なシステムを構築できます。セキュリティ対策も万全で、機密文書も安全に扱えます。

Dify導入支援との組み合わせ

当社のDify導入支援サービスを活用することで、DeepSeek-OCRをDifyプラットフォームに統合し、組織全体のAI導入を高速に進めることができます。

よくある質問|DeepSeek-OCR導入前の疑問を解消

DeepSeek-OCRは商用利用できますか?

DeepSeek-OCRのライセンスについては、公式GitHubリポジトリに記載されています。オープンソースプロジェクトとして公開されており、MITライセンスまたはApache 2.0ライセンス(リポジトリで確認)の下で商用利用が可能です。

ただし、大規模な商用利用を検討する場合は、DeepSeek社に直接問い合わせることをお勧めします。

どのくらいのGPUリソースが必要ですか?

必要なGPUリソースは、使用する解像度モードと処理量によって異なります。最小構成としては、NVIDIA A100-40G GPU 1枚で運用可能です。この構成で、Baseモード(1024×1024、256トークン)を使用した場合、1日20万ページ以上の処理が可能です。

より高速な処理や大規模運用を行う場合は、複数のGPUノードを使用することで、処理能力を線形にスケールできます。論文では、20ノード(160 GPU)の構成で1日3300万ページの処理能力が報告されています。

既存のOCRシステムからの移行は難しいですか?

既存のOCRシステムからDeepSeek-OCRへの移行は、システムの規模と要件によって難易度が異なります。小規模なシステムの場合、GitHubリポジトリの手順に従ってセットアップし、既存のワークフローにAPIを統合することで、比較的容易に移行できます。

大規模なシステムの場合は、以下の点を考慮する必要があります。

- 既存のデータフォーマットとの互換性確認

- 処理パイプラインの再設計

- GPU環境の構築とスケーリング

- 精度検証とチューニング

当社の生成AIコンサルティングサービスでは、このような大規模移行プロジェクトもサポートしています。

精度が不十分な場合のチューニング方法は?

DeepSeek-OCRの精度が期待に満たない場合、以下のチューニング方法を試すことができます。

解像度モードの変更

まず、より高解像度のモード(LargeやGundamモード)を試してみてください。特に複雑なレイアウトや小さな文字を含む文書では、高解像度モードが有効です。

プロンプトの最適化

適切なプロンプトを設計することで、認識精度を向上できます。例えば、「レイアウト情報付きで認識」「表形式で出力」など、明確な指示を含めることで、より正確な結果が得られます。

ファインチューニング

特定のドメイン(医療、法律など)に特化した文書を処理する場合、ドメイン固有のデータでファインチューニングすることで精度を向上できます。ファインチューニングの方法については、GitHubリポジトリのドキュメントを参照してください。

まとめ|DeepSeek-OCRで実現する文書処理の未来

DeepSeek-OCRの3つの革新的特徴

本記事で解説してきたDeepSeek-OCRの特徴をまとめます。

1. 視覚的圧縮パラダイムによる高効率化

DeepSeek-OCRは、10倍圧縮で97%精度、20倍圧縮でも60%精度を実現する視覚的コンテキスト圧縮技術を採用しています。従来のテキストベースの処理と比較して、圧倒的に少ないトークン数で高精度な認識が可能です。

2. DeepEncoder技術による低活性化・少ないトークン実現

SAM-base、16倍圧縮器、CLIP-largeの3つのコンポーネントで構成されるDeepEncoderは、Window AttentionとGlobal Attentionを組み合わせることで、効率性と精度を両立しています。他のVLMの約15%のトークン数で動作し、メモリ効率も優れています。

3. 実用的な処理速度と多様な解像度モード

単一A100-40G GPUで1日20万ページ以上の処理が可能であり、実運用レベルのスループットを実現しています。また、TinyからGundam-Mまでの6つの解像度モードにより、用途に応じた最適な設定が可能です。

導入を成功させる3つのステップ

DeepSeek-OCRを組織に導入し、文書処理を効率化するための3ステップをご紹介します。

ステップ1:現状の文書処理課題を明確化する

まず、組織内でどのような文書処理に課題があるかを明確にします。

処理量、求められる精度、予算、期限などを整理することで、DeepSeek-OCRが適切なソリューションかどうかを判断できます。

ステップ2:小規模なPoC(概念実証)から始める

いきなり大規模導入を行うのではなく、まず小規模なPoCから始めることをお勧めします。

GitHubリポジトリから環境を構築し、実際の文書サンプルで精度と処理速度を検証します。

ステップ3:段階的にスケールアップする

PoCで十分な成果が得られたら、段階的にスケールアップします。

GPUリソースの追加、ワークフローへの統合、運用体制の構築などを計画的に進めることで、スムーズな導入が可能になります。

今後の展望:OCR技術の進化とAI活用

DeepSeek-OCRは、視覚的コンテキスト圧縮という新しいパラダイムを提示し、OCR技術の進化に大きく貢献しています。今後は、さらに高度な圧縮技術や、より多様な文書タイプへの対応が期待されます。また、LLM/VLMの学習データ生成における役割も拡大し、AI技術全体の発展に寄与していくでしょう。

OCR 1.0(基本的な文字認識)からOCR 2.0(深い構造理解)への進化は、STEM分野や専門ドメインでのVLM/LLM開発において重要な役割を果たすことが期待されています。当社では、DeepSeek-OCRをはじめとする最新のAI技術を活用し、お客様の業務効率化を支援しています。生成AIコンサルティングサービスでは、オーダーメイドのシステム開発を提供し、組織のニーズに合わせた最適なAIソリューションを実現します。

文書処理の効率化、OCR精度の向上、コスト削減など、DeepSeek-OCRの導入に関するご相談は、ぜひお気軽にお問い合わせください。