こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

DeepSeekDeepSeek R1 0528を公開しました。DeepSeek R1 0528 は、AIの進化の最前線に立つ、非常に高性能な大規模言語モデルです。特に、数学やプログラミング、論理的な思考といった複雑なタスクで驚くべき成果を上げており、その実力はOpenAIのGPT-4.5やGoogleのGemini 2.5 Proに匹敵するとも言われています。また、知識を小さなモデルに凝縮する「蒸留」という技術を使って、より手軽に利用できるバージョンも開発されるなど、活用の幅も広がっています。

この記事では、DeepSeek R1 0528の基本的な情報から、その驚異的な性能、具体的な使い方、さらにはUnslothが提供するGGUFという形式での活用方法まで、初心者の方にも、そして専門家の方にも満足いただけるよう、詳細かつ分かりやすく解説していきます。

DeepSeek R1 0528 とは?~AI界の新星を徹底解剖~

DeepSeek R1 0528の概要を解説

DeepSeek R1 0528は、中国のDeepSeek社が開発した高性能なAIです。以前のバージョンから「考える力」が大幅に向上し、特に数学、プログラミング、論理的思考が得意です。その賢さは、GPT-4.5やGemini 2.5 Proといった世界トップクラスのAIに迫ると言われています。これは、より多くの計算資源と改良されたアルゴリズムによって達成されました。単に情報を記憶するだけでなく、深く思考し新しい答えを導き出す能力が特徴です。

何がすごい?DeepSeek R1 0528の主な特徴と進化点

DeepSeek R1 0528の主な進化点は以下の通りです。

- 推論能力と論理的思考の深化:計算資源の増強とアルゴリズム最適化により、複雑な問題解決能力が向上しました。

- 卓越したベンチマーク性能:数学、プログラミング、一般論理など多岐にわたる評価で高スコアを記録。

- AIME 2025テストでの大幅な精度向上:正答率が前バージョンの70%から87.5%に向上。これは1問あたりの平均使用トークン数が12Kから23Kへと増加し、より深く思考できるようになったためです。

- その他改善点:幻覚率の低減、関数呼び出し機能の強化、Vibeコーディング体験向上、JSON出力対応など、実用性も向上しています。

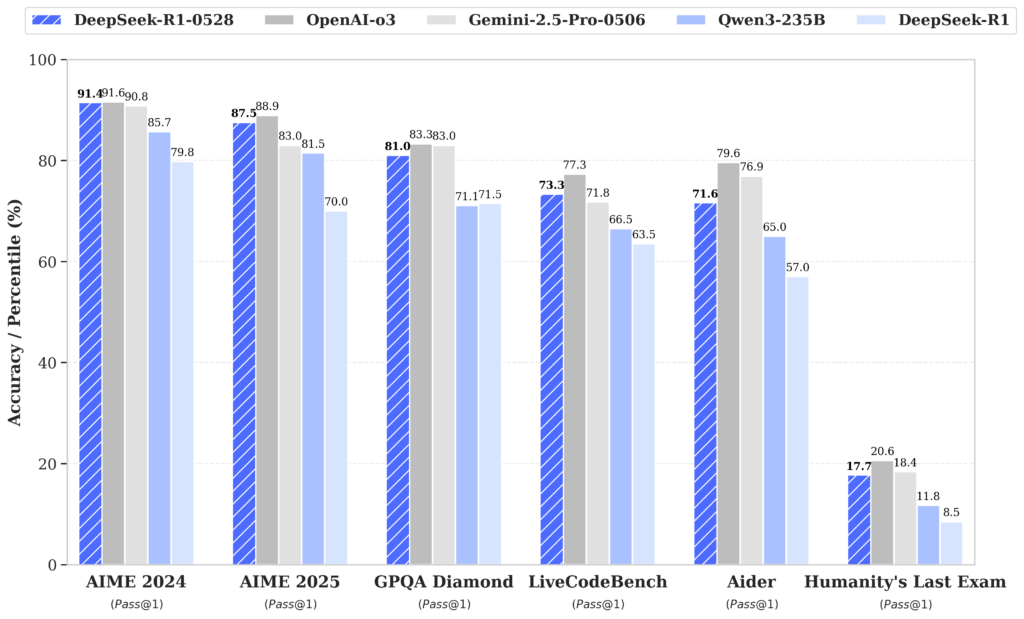

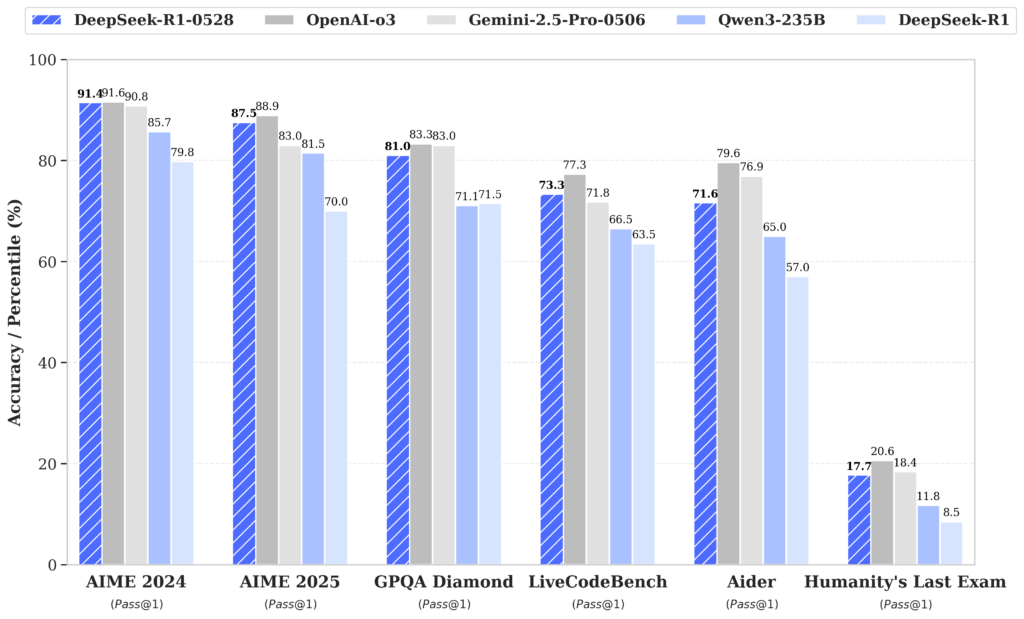

従来モデルや競合との比較:DeepSeek R1 0528の強み

DeepSeek R1 0528は、従来モデルや競合AIと比較して、特に複雑な推論タスクでの性能向上が顕著です。OpenAIのGPTシリーズやGoogleのGeminiシリーズといった最先端モデルと比較しても、多くのベンチマークで同等以上の性能を示し、特に数学やコーディング分野での強さが際立っています。

また、オープンソース(一部派生モデル)として提供されている点も大きな強みです。さらに、DeepSeek R1 0528の思考の連鎖(Chain-of-Thought)を小規模なQwen3-8Bモデルに蒸留したDeepSeek-R1-0528-Qwen3-8Bは、元の8Bモデルを大幅に上回り、巨大なQwen3-235Bモデルに匹敵する性能を達成しました。これは、DeepSeek R1 0528の高度な思考プロセスが他モデルの能力向上にも貢献できることを示しています。

前のバージョンのDeepSeek R1についてはこちらの記事をご覧ください!

関連記事:DeepSeek-R1 : 最大6710億パラメータで推論能力を飛躍的に向上させたAI

また、DeepSeekを利用する前に、利用規約とプライバシーポリシーを注意深く確認しておくことをおすすめします。

関連記事:DeepSeek 利用規約・プライバシーポリシー 要約【2025年1月28日現在】

DeepSeek R1 0528の驚異的な性能~ベンチマーク結果詳報~

各種ベンチマークでのDeepSeek R1 0528のスコア

下の表は、DeepSeek R1とDeepSeek R1 0528のベンチマークスコアを比較したものです。多くの項目で新バージョンが大幅な性能向上を達成していることがわかります。

| Category | Benchmark (Metric) | DeepSeek R1 | DeepSeek R1 0528 |

|---|---|---|---|

| General | |||

| MMLU-Redux (EM) | 92.9 | 93.4 | |

| MMLU-Pro (EM) | 84.0 | 85.0 | |

| GPQA-Diamond (Pass@1) | 71.5 | 81.0 | |

| SimpleQA (Correct) | 30.1 | 27.8 | |

| FRAMES (Acc.) | 82.5 | 83.0 | |

| Humanity’s Last Exam (Pass@1) | 8.5 | 17.7 | |

| Code | |||

| LiveCodeBench (2408-2505) (Pass@1) | 63.5 | 73.3 | |

| Codeforces-Div1 (Rating) | 1530 | 1930 | |

| SWE Verified (Resolved) | 49.2 | 57.6 | |

| Aider-Polyglot (Acc.) | 53.3 | 71.6 | |

| Math | |||

| AIME 2024 (Pass@1) | 79.8 | 91.4 | |

| AIME 2025 (Pass@1) | 70.0 | 87.5 | |

| HMMT 2025 (Pass@1) | 41.7 | 79.4 | |

| CNMO 2024 (Pass@1) | 78.8 | 86.9 | |

| Tools | |||

| BFCL_v3_MultiTurn (Acc) | – | 37.0 | |

| Tau-Bench (Pass@1) | – | 53.5(Airline)/63.9(Retail) |

DeepSeek R1 0528は、各種ベンチマークで非常に高いスコアを記録しています。例えば、一般能力を測るGPQA-Diamond (Pass@1)では71.5から81.0へ、コーディング能力を測るLiveCodeBench (Pass@1)では63.5から73.3へ、数学能力を測るAIME 2024 (Pass@1)では79.8から91.4へと大幅に向上しています。これらの結果は、DeepSeek R1 0528が多岐にわたる分野で卓越した能力を持つことを示しています。

上のグラフは、DeepSeek R1 0528(濃い青色のバー)と、OpenAIのGPT-4oやGPT-4 Turbo (0125)、GoogleのGemini 1.5 Pro (0514)、AnthropicのClaude 3 Opusといった世界トップレベルのAIモデルとの性能を6つの主要なベンチマーク(MMLU、GPQA、HumanEval、MBPP、MATH、AIME 2024)で比較したものです。

このグラフから、DeepSeek R1 0528が多くの評価軸でこれらの最先端モデルと互角以上に渡り合っていることが明確に読み取れます。特に、プログラミング能力を測るHumanEvalやMBPPではGPT-4oに次ぐ高いスコアを、そして高度な数学的能力が試されるMATHやAIME 2024では、他のどのモデルよりも優れた、あるいは同等のトップクラスの性能を示しており、DeepSeek R1 0528の推論能力、特に数理論理分野における卓越した実力が際立っていることがわかります。全体として、DeepSeek R1 0528がAIの性能競争において非常に高い競争力を持つことを示しています。

幻覚率の低減と関数呼び出し機能の強化

DeepSeek R1 0528は、実用性を高める改善も施されています。AIが誤った情報を生成する「幻覚」が低減され、信頼性が向上しました。また、外部ツールと連携する「関数呼び出し」機能が強化され、JSON形式での出力もサポートされたため、開発者にとっての利便性が向上しています。DeepSeek APIドキュメントのニュースでは、これらの改善点がGIF画像と共に紹介されており、例えばJSON出力や関数呼び出しの具体的な動作例が示されている可能性があります。

上のGIF画像は、DeepSeek R1 0528の動作例を示しており、改善された機能(JSON出力や関数呼び出しなど)のデモンストレーションです。

DeepSeek R1 0528の派生モデルと技術詳細

DeepSeek-R1-0528-Qwen3-8B:小規模モデルへの知識蒸留

下の表は、DeepSeek-R1-0528-Qwen3-8Bと他の主要モデルとの性能比較です。AIME 24でトップのスコアを記録しています。

| AIME 24 | AIME 25 | HMMT Feb 25 | GPQA Diamond | LiveCodeBench (2408-2505) | |

|---|---|---|---|---|---|

| Qwen3-235B-A22B | 85.7 | 81.5 | 62.5 | 71.1 | 66.5 |

| Qwen3-32B | 81.4 | 72.9 | – | 68.4 | – |

| Qwen3-8B | 76.0 | 67.3 | – | 62.0 | – |

| Phi-4-Reasoning-Plus-14B | 81.3 | 78.0 | 53.6 | 69.3 | – |

| Gemini-2.5-Flash-Thinking-0520 | 82.3 | 72.0 | 64.2 | 82.8 | 62.3 |

| o3-mini (medium) | 79.6 | 76.7 | 53.3 | 76.8 | 65.9 |

| DeepSeek-R1-0528-Qwen3-8B | 86.0 | 76.3 | 61.5 | 61.1 | 60.5 |

DeepSeek AIは、DeepSeek R1 0528の高度な思考プロセス(Chain-of-Thought)を、より小規模なQwen3 8B Baseモデルに学習させる「知識蒸留」により、DeepSeek-R1-0528-Qwen3-8Bを開発しました。この80億パラメータモデルは、AIME 2024ベンチマークでオープンソースモデル中最高水準の性能を達成し、元のQwen3 8Bを大幅に上回り、巨大なQwen3-235Bモデルに匹敵する結果を出しました。これは、DeepSeek R1 0528の優れた推論能力が、小規模モデルの性能向上にも大きく貢献できることを示しています。

DeepSeek R1 0528を実際に使ってみよう~利用ガイド~

公式チャットサイトとAPIプラットフォームの利用方法

DeepSeek R1 0528は、公式チャットサイトで「DeepThink」ボタンをオンにすることで体験できます。開発者向けには、OpenAI互換APIがDeepSeekプラットフォームで提供されており、自身のアプリケーションに組み込むことが可能です。APIの詳細は公式ドキュメントを参照してください。

DeepSeek R1 0528のローカル環境での実行と設定

DeepSeek R1 0528は、クラウドサービスを介さずに、ご自身のローカルPC環境で直接実行することも可能です。これにより、データセキュリティの向上や、オフラインでの利用、あるいは特定のカスタマイズといったメリットが期待できます。ただし、ローカル実行には一定の技術的準備と、モデルの挙動を最適化するための設定知識が必要になります。

技術的な詳細や具体的な導入手順については、開発元であるDeepSeek AI社が公開しているGitHubのDeepSeek-R1公式リポジトリが主要な情報源となります。

DeepSeek R1 0528をローカル環境でセットアップし、実際に利用する上で、以前のバージョンと比較して知っておくべき重要な変更点(モデルの扱い方や設定に関する改善点)がいくつかあります。これらは直接的なインストール手順ではありませんが、ローカルでモデルの能力を最大限に引き出すために役立ちます。

- システムプロンプトによる初期動作制御の柔軟性向上 DeepSeek R1 0528では、「システムプロンプト」が正式にサポートされました。これは、ローカルでモデルを起動し対話を開始する前に、モデルの基本的な振る舞い(役割、応答のトーン、前提とすべき知識など)を定義できる初期指示のことです。例えば、特定の専門分野のアシスタントとして動作させたい場合や、特定の応答スタイルを求めたい場合に、このシステムプロンプトをローカル実行時の設定として組み込むことで、モデルの応答の一貫性を高め、より目的に合った出力を得やすくなります。 DeepSeek公式がWeb/Appで使用しているシステムプロンプトの日本語訳例は以下の通りです。ローカルで利用する際も、このような形式で

{current date}部分を実行日の日付に置き換えて設定します。 このアシスタントはDeepSeek-R1であり、DeepSeek社によって創造されました。 本日は{current date}です。 このようにシステムプロンプトをローカルで設定することで、モデルは自身のアイデンティティと現在の日時を認識し、より文脈に沿った応答を生成することが期待できます。 - より自然な対話が可能に:思考パターンの明示的指示が不要 以前のバージョンでは、モデルに詳細な思考プロセスを経させる(いわゆるChain-of-Thoughtを促す)ために、ローカルでプロンプトを送信する際、出力の冒頭に特定の指示子(

<think>\n)をユーザーが付加する必要がありました。しかし、DeepSeek R1 0528ではこの操作が不要となりました。これは、モデル自体の推論能力が向上し、特別な指示なしでも、より自然に深い思考を行うようになったことを意味します。ローカルで利用する際、以前のような一手間が省けるため、よりスムーズな対話やプロンプトエンジニアリングが可能になります。

また、DeepSeek R1 0528の技術を応用した派生モデル「DeepSeek-R1-0528-Qwen3-8B」も、アーキテクチャはQwen3-8Bに準拠しつつ、トークナイザー設定はDeepSeek R1 0528と共通であり、Qwen3-8Bと同様の手法でローカル実行が可能です。

ローカル実行の一般的な流れとしては、まずモデルのパラメータファイル(通称「ウェイトファイル」)をHugging Face等のリポジトリからダウンロードします。次に、Pythonプログラミング環境と、Hugging Face TransformersのようなAIモデル操作用ライブラリをセットアップし、これらのツールを用いてモデルをロード・実行します。実行に必要なPCのスペック(特にGPUのVRAM容量やシステムメモリ容量)はモデルのサイズや量子化の度合いによって大きく異なるため、公式ドキュメントや後述するUnsloth GGUFのような軽量化手法の情報を参照し、ご自身の環境に適した準備を行う必要があります。

応答の生成に関する主要なパラメータとして、「温度(temperature)」は0.6が推奨されています(DeepSeek公式、Unsloth推奨)。これは応答のランダム性を調整するもので、0に近いほど決定的、1に近いほど多様な応答になります。また、ファイルアップロードやWeb検索機能を利用する際のプロンプトの記述方法(テンプレート)も公式情報で提供されているため、これに従うことで最適な結果が得られやすくなります。

UnslothによるDeepSeek R1 0528のGGUF活用法

DeepSeek R1 0528のような非常に高性能なAIモデルは、その能力と引き換えに膨大な計算リソースを必要とします。そのため、一般のユーザーが手軽に自分のPCで動かすのは難しいという課題がありました。この章では、この課題を解決するための一つのアプローチとして、「Unsloth」というプロジェクトが提供する技術と、「GGUF」というファイル形式を活用する方法について解説します。これらを利用することで、DeepSeek R1 0528をより少ない計算資源で、効率的にローカル環境で実行できるようになります。

UnslothとGGUF入門:巨大AIを身近にする技術

まず、この章で頻出する2つの重要なキーワード、「Unsloth」と「GGUF」について説明します。

Unslothとは?

Unslothは、大規模言語モデル(LLM)のファインチューニング(特定のタスクに合わせて追加学習させること)や推論(実際にモデルを使って答えを生成させること)を、より高速かつメモリ効率良く行うためのオープンソースプロジェクトおよび関連技術を提供する企業です。特に、少ないGPUメモリでも大規模なモデルを扱えるようにする技術に強みを持っています。DeepSeek R1 0528のような巨大モデルを、より多くの人が利用できるようにするための重要な役割を担っています。

GGUFとは?

GGUF (GPT-Generated Unified Format) は、大規模言語モデルのパラメータ(モデルの知識や能力を数値化したもの、通称「重み」)を保存するためのファイル形式の一つです。この形式は、特にllama.cppという、CPUやGPUでLLMを効率的に実行するための人気のオープンソースプロジェクトで広くサポートされています。GGUFの最大の特長は、「量子化(Quantization)」という技術に対応している点です。量子化については次に詳しく説明します。

Unslothは、DeepSeek R1 0528のような巨大モデルを、このGGUF形式を用いて量子化し、一般的なハードウェアでも扱いやすい形で提供しています。これにより、最先端AIのパワフルな機能を、より身近な環境で試すことが可能になります。

Unsloth Dynamic 2.0 GGUFとは?量子化のメリット

前述の通り、GGUF形式の大きな特徴は「量子化」をサポートしている点です。Unslothは特に「Unsloth Dynamic 2.0 GGUF」という独自の量子化技術をDeepSeek R1 0528に適用しています。

量子化(Quantization)とは、AIモデルの重みを表現するために使用する数値の精度を下げる(ビット数を減らす)技術です。通常、AIモデルの重みは32ビット浮動小数点数(FP32)や16ビット浮動小数点数(FP16またはBF16)といった比較的大きなデータサイズで表現されますが、量子化ではこれを8ビット整数(INT8)、4ビット整数(INT4)、あるいはUnslothの例では1.78ビットや2.71ビットといった極めて低いビット数にまで圧縮します。

量子化の主なメリットは以下の通りです。

- モデルサイズの劇的な削減:ビット数を減らすことで、モデル全体のファイルサイズが非常に小さくなります。Unslothのブログ記事によると、DeepSeek R1の元々720GBあった671Bパラメータモデルを、量子化によって185GBまで、実に75%も削減できたと報告されています。これにより、モデルのダウンロード時間の短縮や、ストレージ容量の節約に直結します。

- メモリ使用量の低減:モデルをPCのメモリ(特にGPUのVRAM)に読み込む際の必要量が大幅に減るため、より少ないメモリ容量でも大規模なモデルを実行できるようになります。これは、高性能な専用ハードウェアを持たないユーザーにとって大きな福音です。

- 推論速度の向上可能性:一般的に、扱うデータサイズが小さくなれば、計算に必要なデータ転送量や演算量が減少し、結果としてAIが答えを出すまでの時間(推論速度)が向上する可能性があります。ただし、これは量子化の具体的な手法や、実行するハードウェアの対応状況にも左右されます。

Unslothの「Dynamic 2.0 GGUF」では、モデルの性能低下を最小限に抑えつつ最大限の圧縮効果を得るために、全ての部分を一律に量子化するのではなく、モデルの構造に応じて量子化の度合いを変える選択的な量子化戦略をとっていると説明されています。例えば、パラメータ数が多いが実際の計算では一部しか使われないMoE(Mixture of Experts)レイヤーはより積極的に低いビット数に量子化し、モデルの性能に特に重要なアテンションレイヤーなどは比較的高い精度(4ビットや6ビットなど)で残すといった工夫が凝らされています。これにより、精度とサイズの最適なバランスを追求しています。

DeepSeek R1 0528のライセンスとコミュニティ

DeepSeek R1 0528のライセンスと論文

DeepSeek R1 0528はMITライセンスで提供され、商用利用や知識蒸留を含む派生物の作成が可能です。

関連論文「DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning」はarXiv (2501.12948) で公開されています。引用時は以下のBibTeX形式が推奨されます。

@misc{deepseekai2025deepseekr1incentivizingreasoningcapability,

title={DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning},

author={DeepSeek-AI},

year={2025},

eprint={2501.12948},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2501.12948},

}関連情報とコミュニティ

最新情報やサポートは以下のチャネルで得られます。

- DeepSeek AI:ホームページ, Hugging Face, Discord, Twitter, Email

- Unsloth:Reddit, Discord, Twitter, Newsletter