こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

DeepSeek v3 という大規模言語モデル(LLM)がオープンソースで公開され、GPT-4oとほぼ同等の能力を持っているということで話題になっています。DeepSeek v3 は、6710億ものパラメータを持つMixture-of-Experts(MoE)アーキテクチャを採用し、オープンソースとして公開された最強のモデルです。しかし、これほどの巨大モデルは通常膨大な計算資源を必要とし、オープンソースでの公開は稀です。DeepSeek v3 は、その高性能にもかかわらずオープンソースとして提供され、AIコミュニティに大きな衝撃を与えました。

この記事では、DeepSeek v3 のアーキテクチャや学習データ、性能評価に加え、ローカル環境での実行方法について詳しく解説します。DeepSeek v3 の可能性と、AI開発の未来に与える影響について一緒に探っていきましょう。

技術の進化が速すぎて情報の入出力が追いつかない・・・

DeepSeek v3の概要

DeepSeek v3とは何か?

DeepSeek v3は、深層学習を用いた最新の言語モデルです。言語モデルとは、人間が使う言葉(自然言語)を理解し、生成することができる人工知能(AI)の一種です。

DeepSeek v3は、6710億個ものパラメータを持つ巨大なモデルであり、そのうち370億個のパラメータが、入力された各単語(トークン)ごとに活性化されます。パラメータとは、モデルが学習する際に調整される数値のことで、この数が多ければ多いほど、モデルは複雑な言葉のパターンを学習し、より人間らしい自然な文章を生成できるようになります。

また、DeepSeek v3は、効率的な推論とコスト効率の高いトレーニングを実現するために、Multi-head Latent Attention (MLA) とDeepSeekMoEというアーキテクチャを採用しています。これらのアーキテクチャは、先行研究であるDeepSeek-V2でその有効性が検証されています。

DeepSeek v3の何がすごいのか?

DeepSeek v3のすごさは、その圧倒的な性能と効率性にあります。

まず、性能面では、DeepSeek v3は他のオープンソースの言語モデルを凌駕し、世界的に見ても最高レベルのクローズドソースモデルに匹敵する性能を達成しています。これは、DeepSeek v3が非常に多くのパラメータを持ち、大量のテキストデータから学習することで、人間が使う言葉の複雑なパターンやニュアンスを深く理解できるようになったためです。

また、DeepSeek v3は、数学やプログラミングといった専門的な分野でも高い能力を発揮します。これは、学習データに数学やプログラミング関連のサンプルを多く含めたこと、そして「マルチトークン予測」という新しい学習目標を採用したことによるものです。マルチトークン予測とは、次の単語だけでなく、その先の複数の単語まで予測するタスクのことで、これによりモデルは文脈をより深く理解し、より正確な予測ができるようになります。

次に、効率性の面では、DeepSeek v3は、その巨大なサイズにも関わらず、学習にかかる時間とコストを大幅に削減することに成功しています。これは、MLAとDeepSeekMoEという効率的なアーキテクチャを採用したこと、そしてFP8という新しいデータフォーマットを用いた学習手法を開発したことによるものです。これらの技術革新により、DeepSeek v3は、従来のモデルと比べて、少ない計算資源で、より高速に学習することができます。

他の言語モデルとの違い

DeepSeek v3は、他の言語モデルと比較して、以下の点で優れています。

- パラメータ数が多く、より複雑な言語パターンを学習できる

- 数学やプログラミングなどの専門分野に強い

- 効率的なアーキテクチャと学習手法により、学習時間とコストを削減

- マルチトークン予測により、文脈理解能力が向上

- 補助損失なしの負荷分散戦略により、パフォーマンスの低下を抑制

これらの特徴により、DeepSeek v3は、従来の言語モデルよりも高性能かつ効率的であり、様々なタスクで優れた結果を達成しています。特に、専門的な知識を必要とするタスクや、長い文章を理解する必要があるタスクで、その強みを発揮します。

直近リリースされた他の言語モデルに関しては、以下の記事をご覧ください!

関連記事:GoogleがGemini-exp-1206を発表:200万トークンのコンテキストウィンドウとマルチモーダルAI

関連記事:Meta社がLlama 3.3を発表|Llama 3.1の405Bに匹敵する性能を70Bで実現!

関連記事:OpenAIが最新推論モデルのo1とo1 pro modeをリリース!

DeepSeek v3の性能評価

標準ベンチマークにおける性能比較

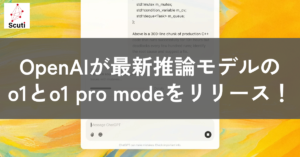

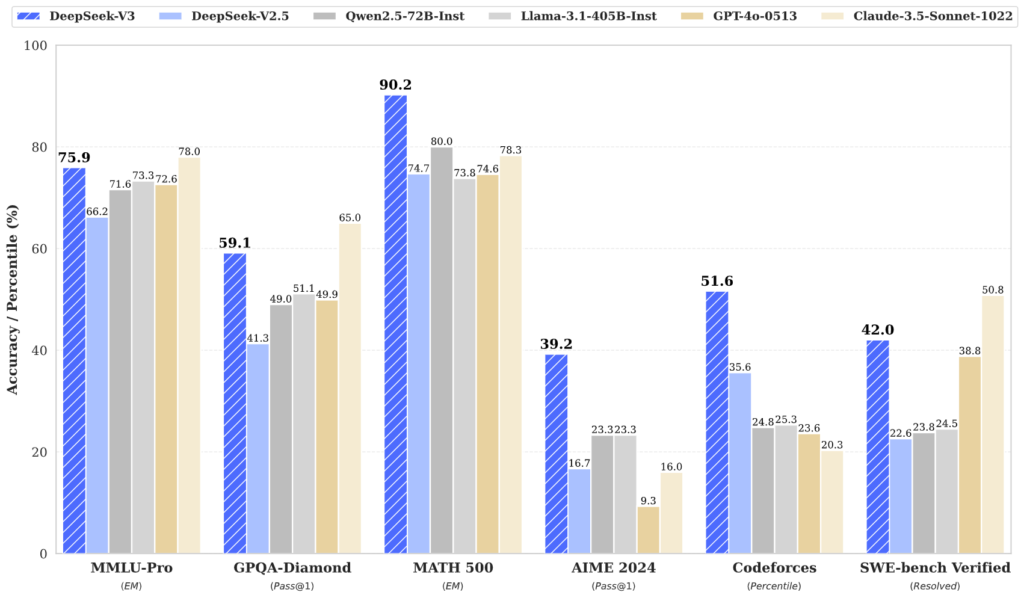

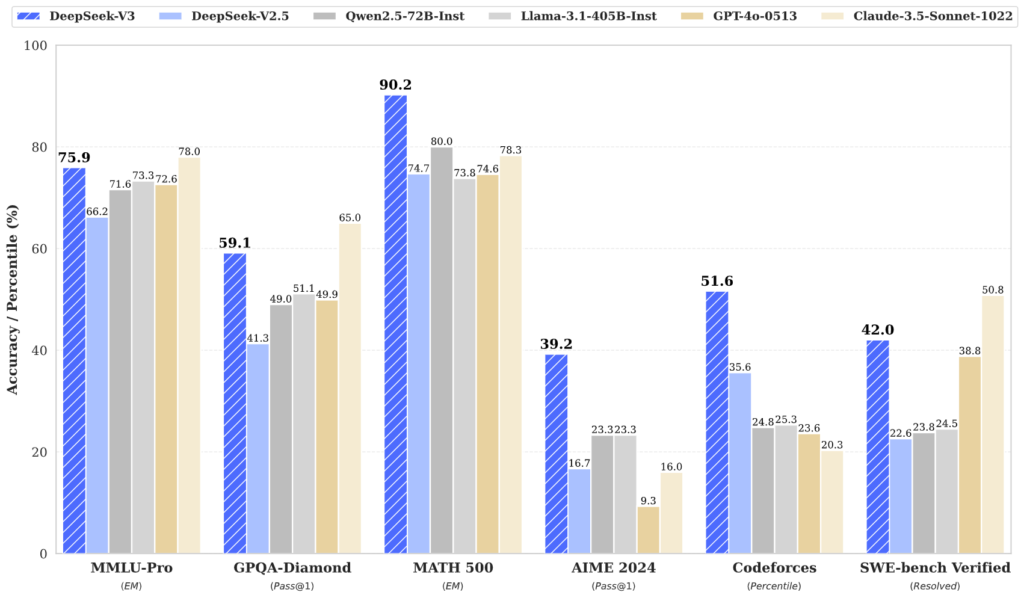

DeepSeek v3は、様々な標準ベンチマークにおいて、他の代表的なオープンソースのベースモデルと比較して優れた性能を示しています。特に、数学とコード関連のタスクで顕著な強みを発揮しています。以下は、主なベンチマークにおけるDeepSeek v3の性能を、他のモデルと比較した表です。

表からわかるように、DeepSeek v3は多くのベンチマークで最高レベルの性能を達成しています。特に、数学関連のベンチマークであるGSM8K、MATH、MGSM、CMathでは、他のモデルを大きく上回る結果を示しています。これは、DeepSeek v3が数学的な推論能力に優れていることを示しています。また、コード関連のベンチマークであるHumanEval、MBPP、LiveCodeBench-Base、CRUXEvalにおいても、DeepSeek v3は高い性能を示しており、プログラミング能力にも優れていることがわかります。

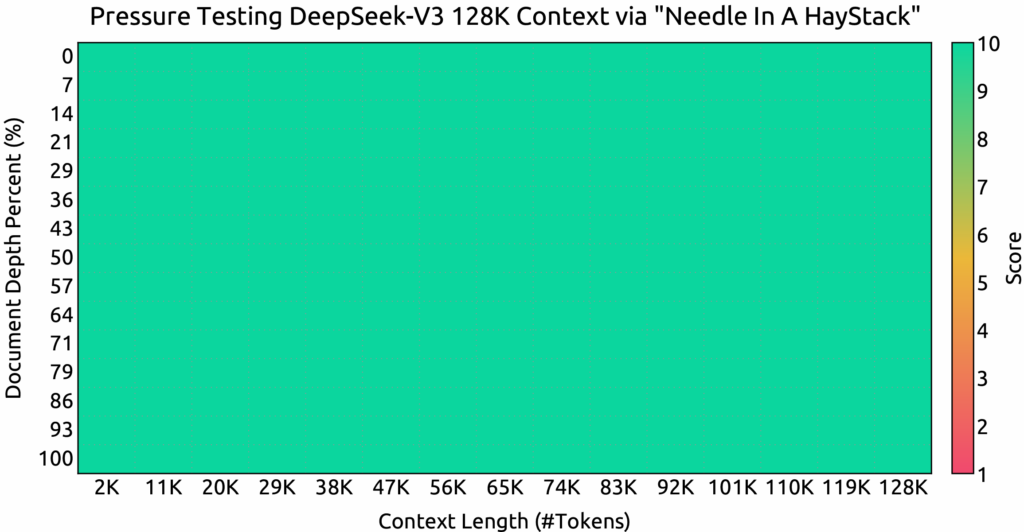

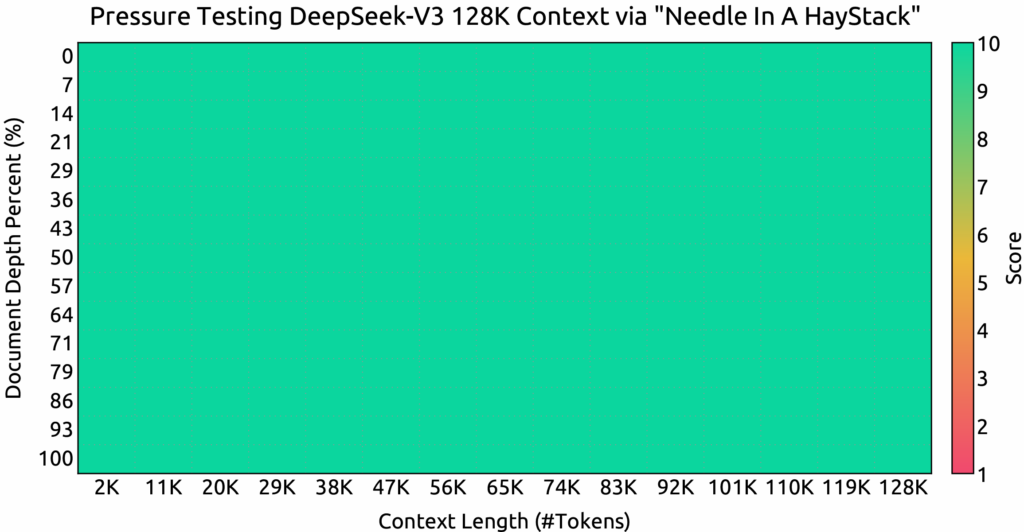

長文理解能力の評価

DeepSeek v3は、長い文章を理解する能力も優れています。これは、Needle In A Haystack (NIAH) テストによって評価されました。NIAHテストでは、長い文章の中に埋め込まれた特定の情報(Needle)を見つけ出す能力が評価されます。DeepSeek v3は、コンテキストウィンドウの長さが128Kまで、すべての長さで良好なパフォーマンスを示しました。これは、DeepSeek v3が長い文章でも文脈を正確に理解し、必要な情報を抽出できることを示しています。

文章生成能力の評価

DeepSeek v3は、自由形式の文章生成能力も優れています。これは、AlpacaEval 2.0とArena-Hardというベンチマークで評価されました。AlpacaEval 2.0では、DeepSeek v3は70.0という高いスコアを達成し、他のモデルを上回りました。Arena-Hardでも、85.5という驚異的なスコアを達成し、GPT-4oやClaude 3.5 Sonnetを上回る結果をだしています。これは、DeepSeek v3が、人間が書いたような自然で高品質な文章を生成できることを示しています。

| Model | Arena-Hard | AlpacaEval 2.0 |

|---|---|---|

| DeepSeek-V2.5-0905 | 76.2 | 50.5 |

| Qwen2.5-72B-Instruct | 81.2 | 49.1 |

| LLaMA-3.1 405B | 69.3 | 40.5 |

| GPT-4o-0513 | 80.4 | 51.1 |

| Claude-Sonnet-3.5-1022 | 85.2 | 52.0 |

| DeepSeek-V3 | 85.5 | 70.0 |

他の言語モデルとの比較

DeepSeek v3は、他の代表的なオープンソースのベースモデルであるDeepSeek-V2-Base、Qwen2.5 72B Base、LLaMA-3.1 405B Baseと比較して、多くのベンチマークで優れた性能を示しています。特に、数学、コード、推論などの分野で強みを発揮しています。また、クローズドソースの最先端モデルであるGPT-4oやClaude-3.5-Sonnetとも同等かそれ以上の性能を示しており、オープンソースモデルの新たなスタンダードを確立したと言えるでしょう。

DeepSeek v3の得意分野と用途

DeepSeek v3は、その優れた性能から、以下のような用途に適しています。

- 数学やプログラミングなどの専門的な知識を必要とするタスク

- 長い文章を理解し、要約や質問応答を行うタスク

- 人間らしい自然な文章を生成するタスク

- 多言語に対応したタスク

具体的には、数学の問題を解く、プログラムコードを生成する、長い文書を要約する、質問に答える、物語を創作する、などの用途が考えられます。また、DeepSeek v3はオープンソースモデルであるため、誰でも自由に利用、改変、再配布することができます。これにより、DeepSeek v3をベースとした様々なアプリケーションやサービスの開発が期待されます。

DeepSeek v3のアーキテクチャ

効率的な推論と学習のためのアーキテクチャ

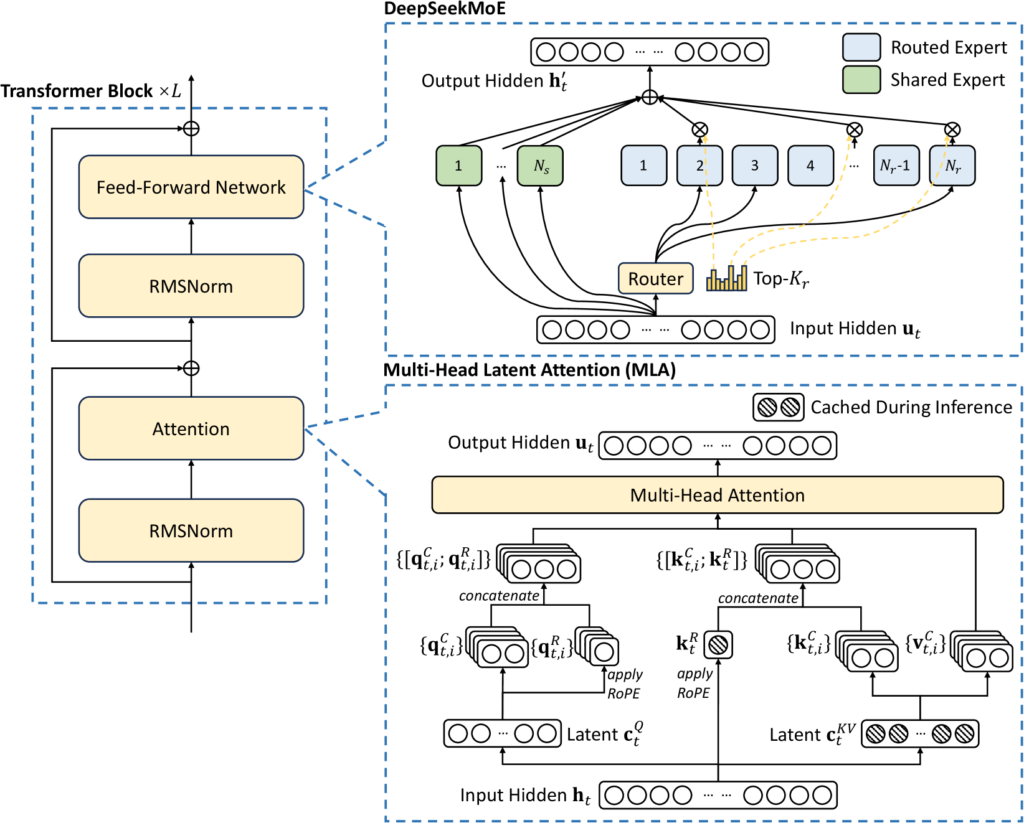

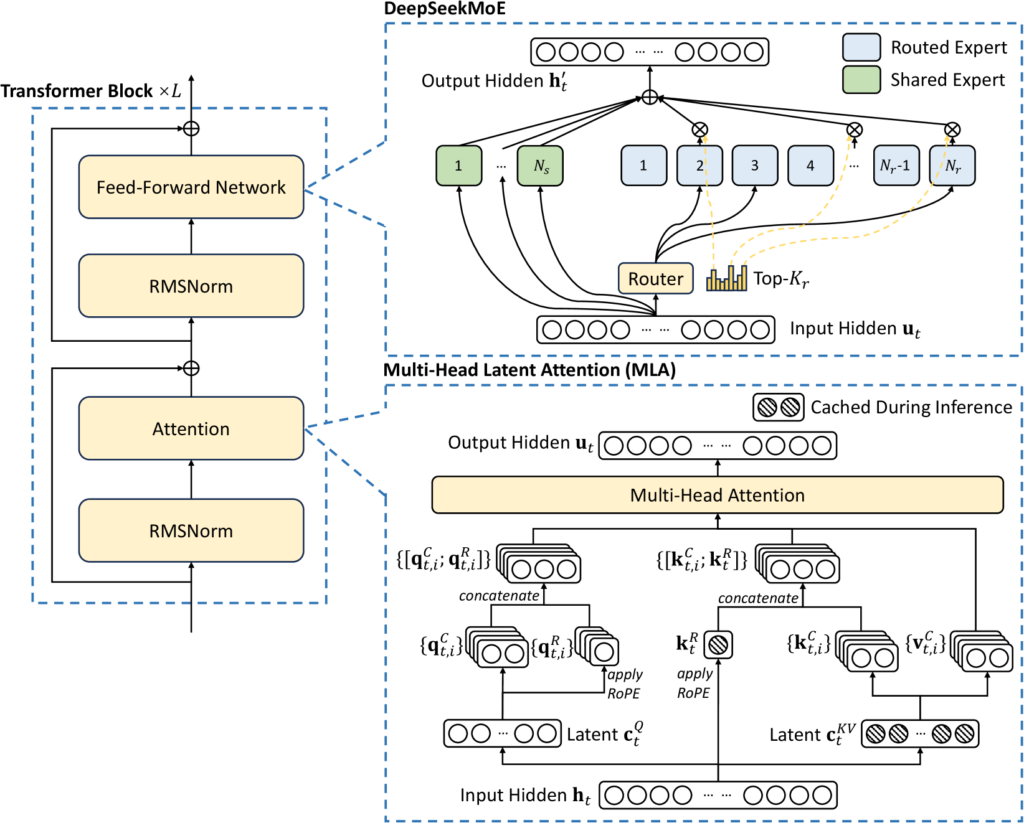

DeepSeek v3は、効率的な推論と学習を実現するために、マルチヘッド潜在アテンション(Multi-head Latent Attention, MLA)とDeepSeekMoEという2つの主要なアーキテクチャを採用しています。これらのアーキテクチャは、先行研究であるDeepSeek-V2でその有効性が検証されています。

マルチヘッド潜在アテンション(MLA)

マルチヘッド潜在アテンションMLAは、Transformerにおける標準的なアテンション機構であるマルチヘッドアテンション(MHA)を改良したものです。MHAでは、クエリ、キー、バリューの3つのベクトルを用いて、入力系列中の各単語間の関連性を計算します。しかし、MHAでは、系列長が長くなると、計算量とメモリ使用量が系列長の2乗に比例して増加するという問題がありました。

MLAでは、この問題を解決するために、キーとバリューを低次元の潜在ベクトルに圧縮します。具体的には、入力系列の各トークンに対して、まずクエリ、キー、バリューの3つのベクトルを計算します。次に、キーとバリューをそれぞれ別の線形層に通して、より低次元の潜在ベクトルに射影します。この潜在ベクトルをctKVと呼びます。そして、この潜在ベクトルを用いてアテンションを計算します。DeepSeek v3では、潜在ベクトルの次元dcは512に設定されています。

アーキテクチャの全体像を理解しやすくするために、以下の図をご覧ください。

この図は、DeepSeek-V3のアーキテクチャの全体像を示しています。入力トークンがどのように処理され、出力トークンが生成されるかの流れがわかります。特に、青枠で囲まれた部分が、MLAにおける潜在ベクトル

DeepSeekMoE

DeepSeekMoEは、Mixture-of-Experts (MoE) の一種であり、複数の小さな専門家モデル(エキスパート)を組み合わせることで、モデル全体のパラメータ数を抑えながら、高い性能を実現するアーキテクチャです。DeepSeek v3では、各MoE層に256個のエキスパートが配置されており、各トークンは、そのトークンに最も適した8つのエキスパートによって処理されます。

DeepSeekMoEでは、各エキスパートが異なるドメインの知識を学習するように、エキスパートを「共有エキスパート」と「ルーティングされたエキスパート」の2種類に分けています。共有エキスパートは、すべてのトークンに対して共通の処理を行い、ルーティングされたエキスパートは、特定のドメインに特化した処理を行います。DeepSeek v3では、各MoE層に1つの共有エキスパートと256のルーティングされたエキスパートを配置しています。

前項の図から、入力トークンがまずゲーティングネットワークに入力され、各エキスパートへのルーティング確率が計算されることがわかります。そして、上位k個のエキスパートが選択され、それぞれの専門知識に基づいてトークンが処理されます。最終的に、各エキスパートの出力が重み付けされて結合され、MoE層の出力となります。DeepSeek v3では、このアーキテクチャにより、効率的かつ高性能な言語モデルを実現しています。

また、DeepSeek v3では、負荷分散のための補助損失を必要としない新しい戦略を採用しています。従来のMoEモデルでは、各エキスパートの負荷が均等になるように、補助損失を用いて学習を行う必要がありました。しかし、この補助損失は、モデルの性能を低下させる原因となることが知られています。DeepSeek v3では、補助損失を用いずに負荷分散を実現することで、モデルの性能を維持しながら、効率的な学習を可能にしています。

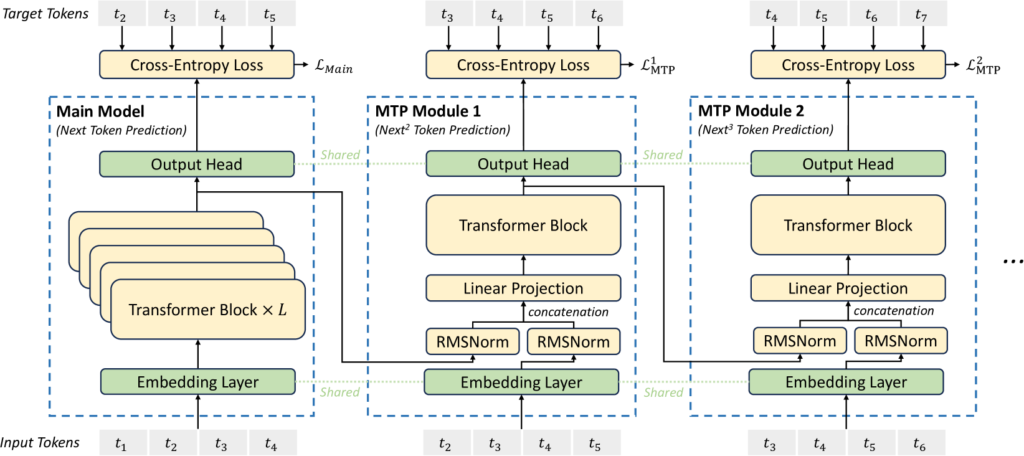

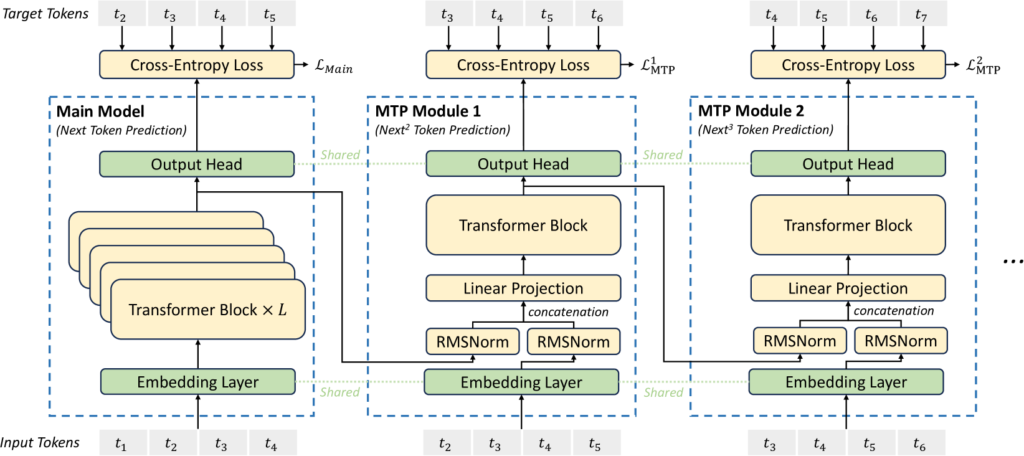

マルチトークン予測(MTP)

MTPは、Multi-Token Predictionの略で、次の1つのトークンだけでなく、その先の複数のトークンを同時に予測するタスクです。DeepSeek v3では、MTPのために、D個のシーケンシャルなモジュールを使用します。各MTPモジュールは、共有埋め込み層、共有出力ヘッド、Transformerブロック、および射影行列で構成されています。k番目のMTPモジュールは、i番目のトークンのk-1番目の深さの表現と、i+k番目のトークンの埋め込みを入力として受け取り、現在の深さの出力表現を生成します。最後に出力ヘッドが、k番目の追加予測トークンの確率分布を計算します。

以下の図は、MTPの実装を示しています。

この図は、MTPモジュールがどのように機能するかを示しています。図中のDは予測するトークン数を表しており、DeepSeek v3ではD=1、つまり次の2つのトークンを予測するように設定されています。各MTPモジュールは、Transformerブロックと線形層で構成されており、入力トークンから将来のトークンを予測するための表現を学習します。図中の青い矢印は情報の流れを表しており、入力トークンからどのようにして将来のトークンの予測値(Pで表される確率分布)が計算されるかを示しています。

また、各MTPモジュールの出力は、次のMTPモジュールの入力として使用されており、予測が連鎖的に行われていることがわかります。このMTPの仕組みにより、学習信号が密になり、データ効率が向上することが期待されます。また、MTPは、モデルが将来のトークンをより良く予測するために、表現を事前に計画することを可能にする可能性があります。

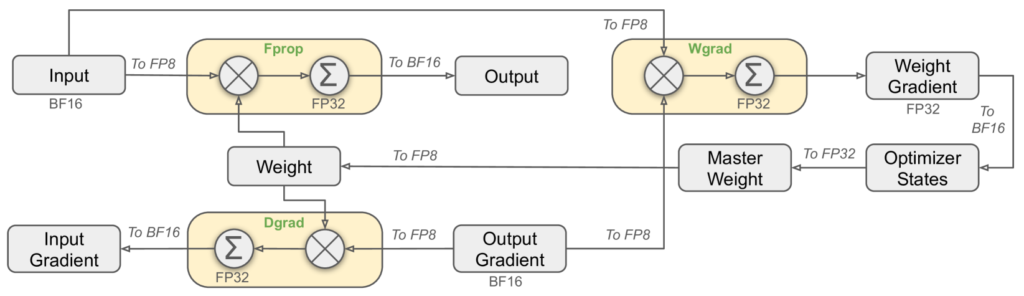

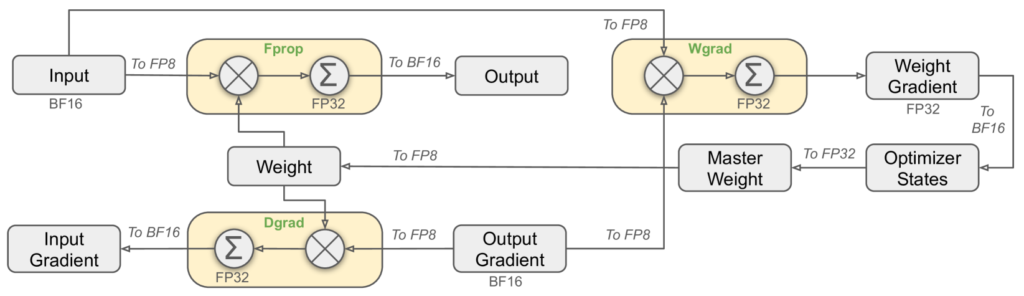

FP8混合精度学習による効率化

DeepSeek v3のトレーニングでは、計算効率とメモリ効率を向上させるために、FP8混合精度学習と呼ばれる手法が採用されています。これは、一部の計算を低精度のFP8(8ビット浮動小数点数)形式で実行することで、計算速度を向上させ、メモリ使用量を削減する技術です。従来のBF16(16ビット浮動小数点数)形式と比較して、FP8形式はメモリ使用量を約半分に削減できます。

しかし、FP8形式は表現できる数値の範囲が狭いため、単純にすべての計算をFP8で行うと、計算精度が低下し、学習が不安定になる可能性があります。特に、学習においては、勾配消失や発散といった問題が発生しやすくなります。そこで、DeepSeek v3では、計算の精度と効率のバランスを取るために、以下のような工夫を凝らした混合精度学習を導入しています。

計算精度の調整

DeepSeek v3では、計算の大部分をFP8で実行しつつ、数値的な安定性が求められる一部の演算(レイヤー正規化など)はBF16またはFP32で実行することで、精度低下を抑えています。具体的には、以下の図のように、行列乗算(GEMM)はFP8で実行し、その他の演算はBF16またはFP32で実行しています。

この図では、LinearオペレータにおけるFprop(順伝播)、Dgrad(アクティベーションの逆伝播)、Wgrad(重みの逆伝播)がすべてFP8で実行されていることがわかります。これにより、計算速度を向上させつつ、精度の低下を最小限に抑えています。

細粒度量子化

FP8形式は表現できる数値の範囲が狭いため、そのまま適用すると量子化誤差が大きくなる可能性があります。特に、値のばらつきが大きいアクティベーションや重みでは、量子化誤差が大きくなり、学習に悪影響を及ぼす可能性があります。DeepSeek v3では、この問題に対処するために、タイル単位またはブロック単位での細粒度量子化を導入しています。具体的には、以下のような方法で量子化を行います。

- アクティベーション:1×128のタイルごとにスケーリング係数を計算し、適用します。つまり、トークンごと、かつ128チャネルごとに異なるスケーリング係数を用いて量子化を行います。

- 重み:128×128のブロックごとにスケーリング係数を計算し、適用します。つまり、入力チャネルと出力チャネルをそれぞれ128個ずつまとめたブロックごとに、異なるスケーリング係数を用いて量子化を行います。

このように、小さなグループごとにスケーリング係数を計算することで、値のばらつきが大きい場合でも、量子化誤差を小さく抑えることができます。

高精度な累積

FP8形式でGEMM演算を行う場合、累積演算の精度が重要になります。DeepSeek v3では、NVIDIA H800 GPUのTensor Coreを利用して、FP8 GEMMを実行します。しかし、H800のTensor Coreは、累積演算を14ビットの精度でしか行いません。これは、FP32による累積と比べて精度が低く、特に学習の初期段階で問題となる可能性があります。そこで、DeepSeek v3では、NC=128個の要素ごとに、CUDAコアに昇格させてFP32精度で累積演算を行うことで、精度を向上させています。この昇格処理は、WGMMA (Warpgroup-level Matrix Multiply-Accumulate) 命令を4回実行するごとに行われます。

低精度の状態保存

さらに、メモリ使用量を削減するために、オプティマイザの状態(例:AdamWのモーメンタム)をBF16形式で保存しています。ただし、モデルの重みと勾配はFP32形式で保持し、数値的な安定性を確保しています。

これらの技術を組み合わせることで、DeepSeek v3は、FP8混合精度学習による効率化を実現しつつ、学習の安定性とモデルの性能を維持しています。特に、ファインチューニングにおいて、これらの技術は重要となります。

DeepSeek v3の学習データ

データセット

DeepSeek v3は、14.8兆トークンという膨大なデータセットで事前学習されています。このデータセットは、多様なソースから収集された高品質なテキストデータで構成されており、特に数学とプログラミングに関するサンプルの比率を高め、さらに英語と中国語以外の言語のデータも拡充することで、多言語対応能力を強化しています。また、データセットの冗長性を最小限に抑えつつ、多様性を維持するために、データ処理パイプラインも洗練されています。

具体的には、Pileデータセットを参考にしつつ、重複排除やデータ品質のフィルタリングを徹底することで、学習データの質を高めています。さらに、学習効率を高めるために、ドキュメントパッキングという手法を採用し、複数の短いサンプルを一つの長い系列にまとめることで、計算効率を向上させています。ただし、学習時にはサンプル間の関連性を排除するために、サンプル間のアテンションをマスクする工夫も施されています。

これらの取り組みにより、DeepSeek v3は、多様で高品質なデータセットから効率的に学習することができ、幅広いタスクに対して優れた汎用性を獲得しています。

FP8混合精度学習

DeepSeek v3では、学習の効率化とメモリ使用量の削減のために、FP8混合精度学習という新しい学習手法を採用しています。FP8混合精度学習に関する詳細は前章をご覧ください。

学習効率の向上

DeepSeek v3は、アーキテクチャの工夫に加えて、アルゴリズム、フレームワーク、ハードウェアの協調設計により、学習効率を大幅に向上させています。特に、MoEモデルの学習における課題であるノード間通信のボトルネックを、DualPipeアルゴリズムと効率的な通信カーネルの実装により克服しました。

DualPipeは、パイプライン並列処理の一種で、計算と通信のオーバーラップを最大化することで、通信の待ち時間を削減します。また、ノード間通信には、Infiniband (IB) とNVLinkを効率的に利用する専用の通信カーネルを開発し、通信帯域を最大限に活用しています。さらに、メモリ使用量を削減するために、アクティベーションの再計算や、オプティマイザ状態の低精度化などの工夫も施されています。

これらの取り組みにより、DeepSeek v3は、14.8兆トークンという膨大なデータセットに対しても効率的に学習を行うことができ、278.8万H800 GPU時間という、比較的少ない計算資源で学習を完了しています。これは、同規模のモデルと比較して、大幅な学習コストの削減を実現していると言えます。

DeepSeek v3のダウンロード

DeepSeek v3のモデルは、Hugging Faceからダウンロードすることができます。以下の表に主要なモデルとその詳細を示します。

| モデル | パラメータ数(合計) | パラメータ数(活性化) | コンテキスト長 | ダウンロード |

|---|---|---|---|---|

| DeepSeek-V3-Base | 6710億 | 370億 | 128K | HuggingFace |

| DeepSeek-V3 | 6710億 | 370億 | 128K | HuggingFace |

これらのモデルは、研究や商用利用に適しており、自由にダウンロードして使用することができます。さらに、Hugging Faceプラットフォームを利用することで、モデルのバージョン管理や更新情報を簡単に追跡することが可能です。これにより、ユーザーは常に最新のモデルを利用することができ、AI技術の進化に対応することができます。

DeepSeek v3のローカル実行

DeepSeek v3は、以下のハードウェアとオープンソースソフトウェアを使用してローカル環境で実行することが可能です。これにより、インターネット接続が不要な環境でも強力な言語モデルを活用できます。

- DeepSeek-Infer Demo: FP8およびBF16推論のためのシンプルで軽量なデモ

- SGLang: BF16およびFP8推論モードの両方でDeepSeek-V3モデルを完全にサポート

- LMDeploy: ローカルおよびクラウド展開のための効率的なFP8およびBF16推論を可能にする

- TensorRT-LLM: 現在BF16推論とINT4/8量子化をサポートしており、FP8サポートは近日中にリリース予定

- vLLM: テンソル並列処理とパイプライン並列処理のためのFP8およびBF16モードでDeepSeek-V3モデルをサポート

- AMD GPU: SGLangを介してAMD GPU上でDeepSeek-V3モデルを実行することを可能にする(BF16およびFP8モードの両方)

- Huawei Ascend NPU: Huawei Ascendデバイス上でDeepSeek-V3を実行することをサポート

これらのソフトウェアとハードウェアの組み合わせにより、DeepSeek v3は多様な環境での実行が可能となり、ユーザーのニーズに応じた柔軟な運用が可能です。さらに、これらのツールを活用することで、DeepSeek v3の性能を最大限に引き出し、様々なアプリケーションに応用することができます。

DeepSeek-Infer Demoを使用した推論

DeepSeek-Infer Demoを使用することで、FP8およびBF16推論を簡単に実行できます。以下の手順に従って、モデルの重みとデモコードを準備し、推論を行います。

git clone https://github.com/deepseek-ai/DeepSeek-V3.git

cd DeepSeek-V3/inference

pip install -r requirements.tHugging Faceからモデルの重みをダウンロードし、/path/to/DeepSeek-V3フォルダに配置します。

#モデルの重みの変換

python convert.py --hf-ckpt-path /path/to/DeepSeek-V3 --save-path /path/to/DeepSeek-V3-Demo --n-experts 256 --model-parallel 16DeepSeek-V3とチャットすることができます。

#実行

torchrun --nnodes 2 --nproc-per-node 8 generate.py --node-rank $RANK --master-addr $ADDR --ckpt-path /path/to/DeepSeek-V3-Demo --config configs/config_671B.json --interactive --temperature 0.7 --max-new-tokens 200または、指定されたファイルに対してバッチ推論を実行することもできます。

torchrun --nnodes 2 --nproc-per-node 8 generate.py --node-rank $RANK --master-addr $ADDR --ckpt-path /path/to/DeepSeek-V3-Demo --config configs/config_671B.json --input-file $FILEこのデモを使用することで、DeepSeek v3の強力な推論能力を簡単に体験することができます。さらに、デモを通じて、モデルの性能を実際に確認し、さまざまなタスクに応用することが可能です。これにより、ユーザーはDeepSeek v3の実力を実感し、具体的なプロジェクトに活用することができます。

SGLangを使用した推論

SGLangは、MLA最適化、FP8 (W8A8)、FP8 KVキャッシュ、Torch Compileをサポートしており、オープンソースフレームワークの中で最先端のレイテンシとスループット性能を提供します。SGLang v0.4.1は、NVIDIAとAMDの両方のGPU上でDeepSeek-V3を完全にサポートしており、非常に汎用性が高く堅牢なソリューションとなっています。これにより、SGLangを使用することで、DeepSeek v3の高性能を最大限に引き出すことが可能です。さらに、SGLangの利用により、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

LMDeployを使用した推論

LMDeployは、大規模言語モデル向けに調整された柔軟で高性能な推論およびサービングフレームワークであり、DeepSeek-V3をサポートしています。オフラインパイプライン処理とオンライン展開機能の両方を提供し、PyTorchベースのワークフローとシームレスに統合します。これにより、LMDeployを使用することで、DeepSeek v3の推論を効率的に行うことが可能です。さらに、LMDeployの利用により、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

TRT-LLMを使用した推論

TensorRT-LLMは、DeepSeek-V3モデルをサポートしており、BF16やINT4/INT8の重みのみなどの精度オプションを提供しています。FP8のサポートは現在進行中で、近日中にリリースされる予定です。これにより、TRT-LLMを使用することで、DeepSeek v3の推論を効率的に行うことが可能です。さらに、TRT-LLMの利用により、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

vLLMを使用した推論

vLLM v0.6.6は、NVIDIAとAMDの両方のGPU上でFP8およびBF16モードのDeepSeek-V3推論をサポートしています。標準的な手法に加えて、vLLMはパイプライン並列処理を提供しており、ネットワークで接続された複数のマシン上でこのモデルを実行することができます。これにより、vLLMを使用することで、DeepSeek v3の推論を効率的に行うことが可能です。さらに、vLLMの利用により、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

AMD GPUを使用した推論

AMDチームとの協力により、FP8とBF16の両方の精度に完全に対応したAMD GPUのDay-OneサポートをSGLangを使用して実現しました。これにより、AMD GPUユーザーもDeepSeek-V3の高性能を活用できます。さらに、AMD GPUを使用することで、DeepSeek v3の推論を効率的に行うことが可能です。これにより、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

Huawei Ascend NPUを使用した推論

Huawei AscendコミュニティのMindIEフレームワークは、DeepSeek-V3のBF16バージョンに正常に適応しています。これにより、Huawei Ascendデバイス上で効率的な推論が可能となっています。さらに、Huawei Ascend NPUを使用することで、DeepSeek v3の推論を効率的に行うことが可能です。これにより、ユーザーは効率的な推論を実現し、様々なアプリケーションに応用することができます。

DeepSeek v3のライセンス

DeepSeek v3 のコードライセンスについて

DeepSeek v3 のコードは、MIT License に基づいて公開されています。このライセンスは、非常に寛容で、商用利用を含む、コードの利用、改変、再配布を許可しています。 ただし、再配布する際には、著作権表示とライセンス条文を記載する必要があります。詳細は、リンク先をご確認ください。

DeepSeek v3 のモデルライセンスについて

DeepSeek v3 のモデルおよび派生物は、DEEPSEEK LICENSE AGREEMENT に基づいて利用する必要があります。このライセンスは、商用利用を許可する一方で、以下の様な使用制限を定めています。詳細は、リンク先をご確認ください。

- 法律に違反する行為、第三者の権利を侵害する行為を目的とした利用は禁止されています。

- 軍事目的での利用は禁止されています。

- 未成年者を搾取、危害する行為を目的とした利用は禁止されています。

- 虚偽の情報を広め、他者に危害を加えることを目的とした利用は禁止されています。

- 規制対象の不適切なコンテンツを生成、拡散する目的での利用は禁止されています。

- 許可なく個人情報を利用したり、不当な目的に使用したりする行為は禁止されています。

- 他者を中傷、侮辱、ハラスメントする行為は禁止されています。

- 個人の法的権利に悪影響を及ぼすような自動化された意思決定のための利用は禁止されています。

- 特定のグループを差別する目的や効果のある利用は禁止されています。

- 特定のグループの脆弱性を悪用し、危害を加える行為は禁止されています。

- また、生成された出力についても、上記のような問題がある利用は禁止されています。

- DeepSeek は、ライセンスに違反するモデルの利用を制限する権利を留保しています。

DeepSeek v3 の利用に関する重要な注意点

DeepSeek v3 は、個人情報や知的財産権を含む可能性のあるデータで学習されています。これらの情報を取り扱う際には、関連法令を遵守する必要があります。 DeepSeek のライセンスは、これらの情報の利用に対する正当な根拠を与えるものではないため、利用者は自己責任で適切に処理する必要があります。 また、モデルの利用によって発生した損害については、DeepSeek は責任を負いません。これらの点をご留意の上、DeepSeek v3をご利用ください。

利用者が許可されていること

DeepSeek v3 モデルの利用においては、以下の行為が許可されています。

- モデルのダウンロード、実行、評価、研究目的での利用。

- モデルを基にした派生物の作成、再配布。

- 商用目的での利用(ただし、上記の使用制限に違反しない範囲)。

- モデルのパラメータやアーキテクチャの改変、再学習。

- モデルの知識を他のモデルに転用(知識蒸留)

- モデルを使って生成したコンテンツの利用(ただし、出力内容やその利用に関する責任は利用者が負う必要があります)。

AIへの入力情報、学習させた情報の取り扱い

- DeepSeekは、利用者がモデルを使って生成した出力(Output)については、基本的に権利を主張しません。ただし、出力内容やその利用が、上記の使用制限に違反する場合は、DeepSeekが利用を制限する権利を留保します。

- モデルに入力する情報や、モデルが学習したデータには、個人情報や著作権などの知的財産権が含まれている可能性があるため、これらの情報を取り扱う際には、関連する法令や規制を遵守する必要があります。

- DeepSeekのライセンスは、これらの情報の利用に対する正当な根拠を与えるものではないため、利用者は自己責任で適切に処理する必要があります。

- DeepSeekは、モデルの学習に使用したデータ(Data)に対しては、ライセンスを付与していません。モデルそのものは利用できますが、学習に使われたデータをそのまま利用することはできません。また、学習させたモデルの重みも、派生モデルとして上記のライセンスに従う必要があります。

DeepSeek v3の今後の展望

DeepSeek v3は、オープンソースの大規模言語モデルとして、今後のAI開発に大きな影響を与える可能性を秘めています。DeepSeek v3の登場により、より多くの研究者や開発者が最先端のLLM技術にアクセスできるようになり、AI技術の進歩が加速することが期待されます。また、DeepSeek v3は商用利用も可能なライセンスで公開されているため、ビジネス分野でのAI活用も促進される可能性があります。これにより、様々な産業においてAIの恩恵を受ける機会が増え、社会全体の技術革新に寄与することが期待されています。さらに、DeepSeek v3のオープンソース化により、コミュニティによる改良や新機能の追加が期待され、モデルの進化が加速するでしょう。

まとめ

DeepSeek v3は、オープンソースの大規模言語モデルとして、非常に高い性能と効率性を兼ね備えています。その高性能にもかかわらず、オープンソースとして提供されていることから、研究者や開発者、そしてビジネスパーソンにとって魅力的な選択肢となっています。DeepSeek v3の登場は、AIコミュニティに大きなインパクトを与え、今後のAI開発を大きく前進させる可能性を秘めています。多様なタスクにおいて優れた性能を発揮するDeepSeek v3は、AI技術の未来を担う重要なモデルとして期待されています。さらに、DeepSeek v3のオープンソース化により、コミュニティによる改良や新機能の追加が期待され、モデルの進化が加速するでしょう。

DeepSeek v3に関する情報

- DeepSeekのウェブサイト

- DeepSeek v3の詳細については、DeepSeekの公式ウェブサイトをご覧ください。

- DeepSeekのチャット機能

- DeepSeek v3とチャットすることもできます。

- DeepSeekのAPIプラットフォーム

- DeepSeek v3のAPIは、DeepSeekのAPIプラットフォームから利用することができます。

- DeepSeekのGitHubリポジトリ

- DeepSeek v3のコードリポジトリは、GitHubで公開されています。

- DeepSeek v3の論文

- DeepSeek v3の技術的な詳細については、DeepSeek v3の論文をご覧ください。