こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

OpenAI社が2024/05/13に発表した最新のAIモデル「GPT-4o(読み方:ジーピーティーフォーオー)」は、従来のGPT-4 Turboをさらに進化させ、ベンチマークが圧倒的に向上し、レスポンスが驚くほど速くなりました。

これにより、ユーザーとのやり取りがよりスムーズになり、リアルタイムでの会話が可能になっています。また、教育やビジネス、日常生活での応用が期待されており、AIの未来を形作る重要な一歩となっています。

この記事では、GPT-4oの性能がどのように進化したか、そして、どのような機能が追加されたかについて解説し、どのような新しい体験が提供できるかを掘り下げます。控えめに言ってやばいです・・・!

本題に入る前に、生成AIとは何か?ChatGPTとは何か?を確認しておきたい方は、下記の記事を御覧ください。

GPT-4oの進化と特性

GPT-4oの概要

GPT-4oは、OpenAIによって開発された最新のAIモデルで、従来のモデルに比べて大幅に進化しています。このモデルは「オムニ」を意味する「o」が示す通り、テキスト、画像、音声といった多様なメディアを理解し、処理する能力を持っています。

GPT-4oのすごい点を簡単にまとめると、以下のようになります。

- 精度爆上がり。ベンチマークの結果は圧倒的。

- レスポンス速度がGPT-4 turboの2倍

- 音声での入出力が非常になめらか

- API使用料がGPT-4 turboの半分

- Rate limit(使用制限)がGPT-4 turboの5倍

- いろいろな機能が無料開放

GPT-4oはGPT-4 turboと比べてどのように進化したか

◉感情表現が可能に

Whisper(Sound to Text)、GPT-4 Turbo、TTS(Text to Sound)をパイプラインで組み合わせた以前のOpenAIのシステムでは、推論エンジンのGPT-4は話し言葉にしかアクセスできませんでした。

この方式では、声のトーンや背景の雑音、複数の話者による音声の知識などは単純に捨てられていたようです。そのため、GPT-4 turboは、感情や話し方の違いによる反応を表現することができませんでした。

しかし、GPT-4oはテキストと音声を推論できる単一のモデルを持つことで、豊富な音声情報を使用して、感情表現豊かな応答を可能にしています。

笑ったり(僕はこのジョークの何が面白いのか理解できなかったので笑うことができませんでした😂)、

歌ったり。これで十分お腹いっぱいですが。。。まだまだ多くの進化を見せてくれます。

◉ほぼリアルタイムな会話を実現

既存の言語モデルでは、ChatGPTに話しかけてから返答を得るまでにわずかな遅延がありました。

OpenAIの発表によると、Voiceモードの平均レイテンシはGPT-3.5で2.8秒、GPT-4で5.4秒。一方、GPT-4oの平均待ち時間は0.32秒で、GPT-3.5の9倍、GPT-4の17倍速いです。

GPT-4oの平均待ち時間は0.32秒というのは、人間の平均応答時間(0.21秒)にかなり近い数字のため、人間と人間が会話をするのとあまり違いを感じない位の体験を得ることができるということになります。

GPT-4oの待ち時間の短縮によって実現可能性が高まるユースケースのひとつに、音声のリアルタイム翻訳があります。実際、OpenAIは英語⇔スペイン語の同時通訳(実際は通訳の出力を待っているので「同時」ではありませn)のデモを公開しています。

かなり実用的な通訳。弊社でも使えそうです。

◉カメラ映像の解析

音声とテキストの統合に加え、GPT-4oは画像とビデオ機能を搭載しています。つまり、デスクトップアプリを介してPCの画面にアクセスさせれば、画面に映し出されたものを理解、説明したり、画面上の画像に関する質問に答えたり、作業のアシスタントとして振る舞うことができます。

下記のデモは、数学の宿題をGPT-4oが先生のように教えてくれるというものです。この仕組みを活用してリモートでの個性に合わせた教育が進みそうです。

AIの先生と会話しながら人間が学習を進める。とんでもない未来世界ですが、これが今起きていると思うと震えます。

◉他にも盛りだくさん!

「他にも」とまとめていいような内容では全然無いのですが、全部書いていると記事が長くなりそうなので、箇条書きでまとめたいと思います。

- 非ローマ字アルファベットのトークン化改善:GPT-4oはトークン化モデルが改善され、非ローマ字アルファベットの言語で必要なトークン数が減少。これは通常のChatGPT利用時にはあまり関係ありませんが、API使用料はトークン数に依存するためインパクトが大きいです。つまり、API使用料が安くなります。例えば、インドの言語(ヒンディー語、マラーティー語、タミル語、テルグ語、グジャラート語)は2.9~4.4倍、アラビア語は2倍、東アジアの言語(中国語、日本語、韓国語、ベトナム語)は1.4~1.7倍の削減を達成。

- 無料プランで使える機能が拡充:従来は有料プランのみだったGPT-4が無料プランでも使用できます(ただし、回数制限あり)。また、他にも画像解析やGPTsなども無料プランでも使用できるようになったようです。これは便利!

- ChatGPTデスクトップアプリのリリース:GPT-4oとは関係ありませんが、Mac版のデスクトップアプリも同時に発表されました。Windows版はまだのようです。これによって、MacのPCに表示されている情報をもとにAIに質問したりできます。以下のデモは、プログラミングの様子です。

AIとペアプロが普通の時代になりそうです。これからはオフィスでみんながPCに向かって独り言をつぶやくのが普通になる時代が来るのでしょうか・・・

GPT-4oのパフォーマンス評価

GPT-4oのテキスト評価

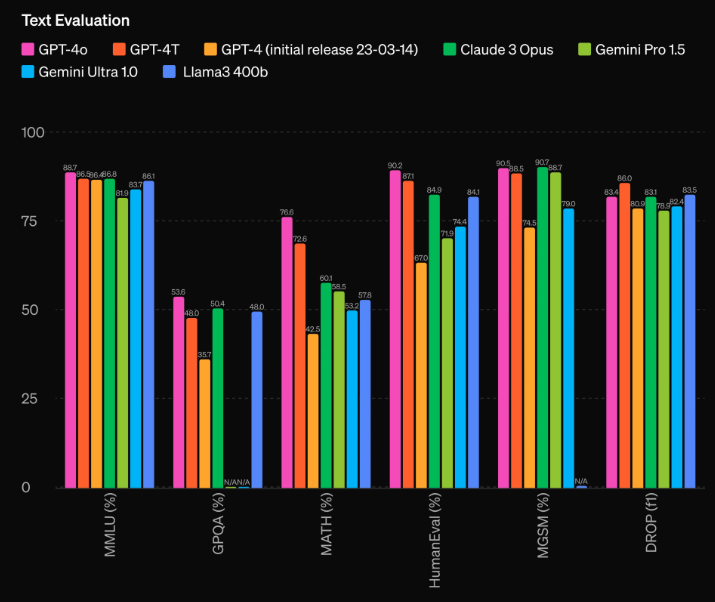

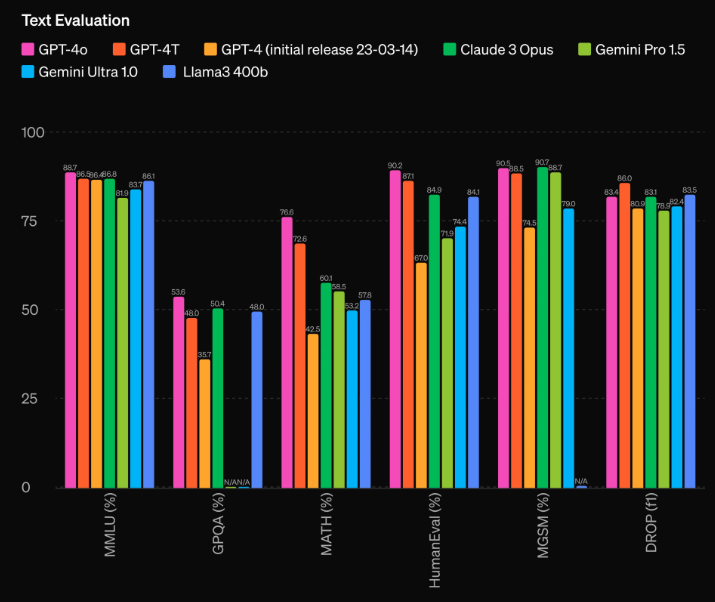

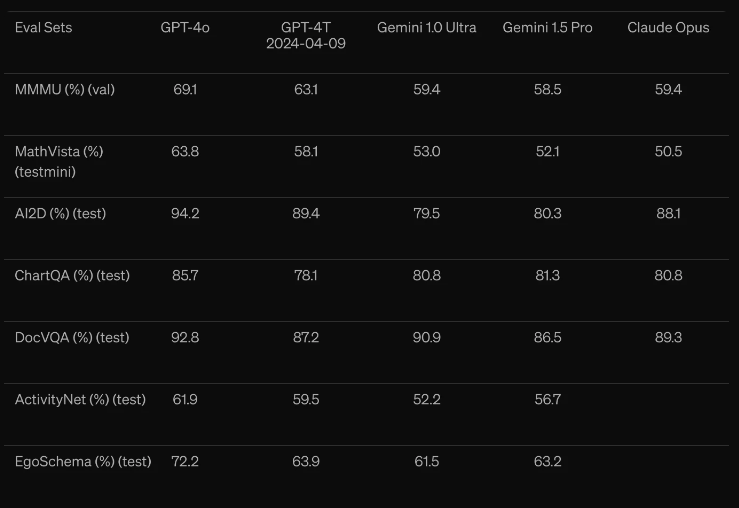

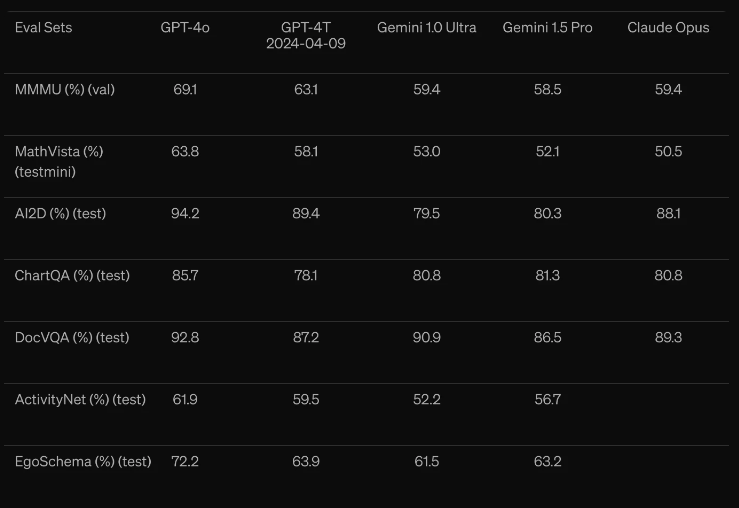

OpenAIが発表したベンチマーク結果によると、GPT-4oは、以前のGPT-4や、AnthropicのClaude 3 Opus、GoogleのGemini、MetaのLlama3といった他のLMMと比較して、テキストについては若干の改善、あるいは同等のスコアを示しています。

※比較対象にLlama 3 400Bがなぜか含まれていますが、このモデルはまだ正式にローンチされていません。

ちなみに各評価項目の意味は下記のようになります。

- 大規模マルチタスク言語理解(MMLU):初等数学、米国史、コンピュータサイエンス、法律などに関するタスク。このテストで高い精度を達成するためには、モデルが幅広い世界の知識と問題解決能力を持っている必要がある。

- 大学院レベルのGoogle-Proof Q&A (GPQA):生物学、物理学、化学の各分野の専門家による多肢選択問題。問題は質が高く、非常に難しい。対応するドメインの博士号を持っているか、取得を目指している専門家は、74%の精度を達成している。

- 数学 (MATH):数学中学・高校の数学の問題集。

- HumanEval:コンピュータプログラムの機能的な正しさのテストで、コード生成のチェックに使われる。

- Multilingual Grade School Math (MSGM):ベンガル語やスワヒリ語などの代表的でない言語を含む10ヶ国語に翻訳された小学校の数学の問題集。

- Discrete Reasoning Over Paragraphs (DROP):完全な段落を理解する必要のある問題。例えば、複数の文にまたがる値を足したり、数えたり、並べ替えたりする。

GPT-4oの音声関連機能

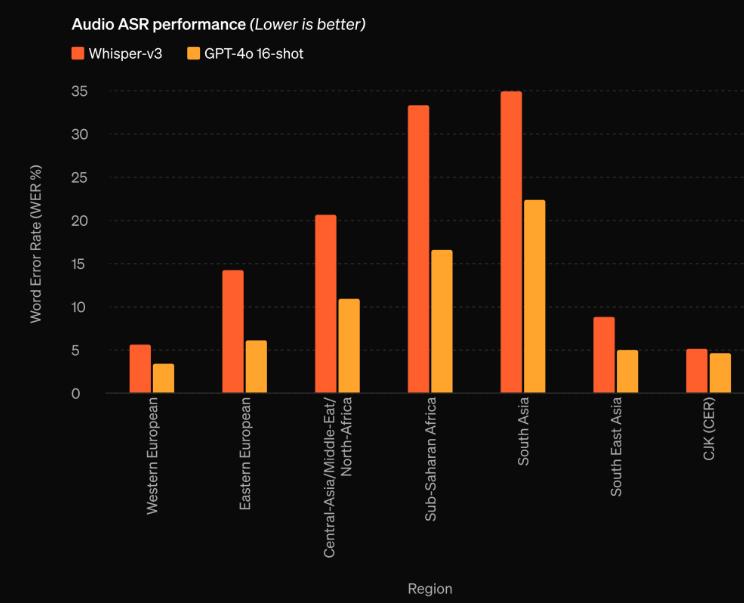

OpenAI発表のベンチマーク結果によると、GPT-4oは、自動音声認識(ASR)におけるこれまでの最先端であったOpenAI独自のWhisper-v3を上回る精度がでています。以下の図は自動音声認識(ASR)の精度について、Wisper-v3とGPT-4oを比較したものです。薄いオレンジがGPT-4oで、縦軸は単語エラー率なので低いほうがいい、というデータになります。

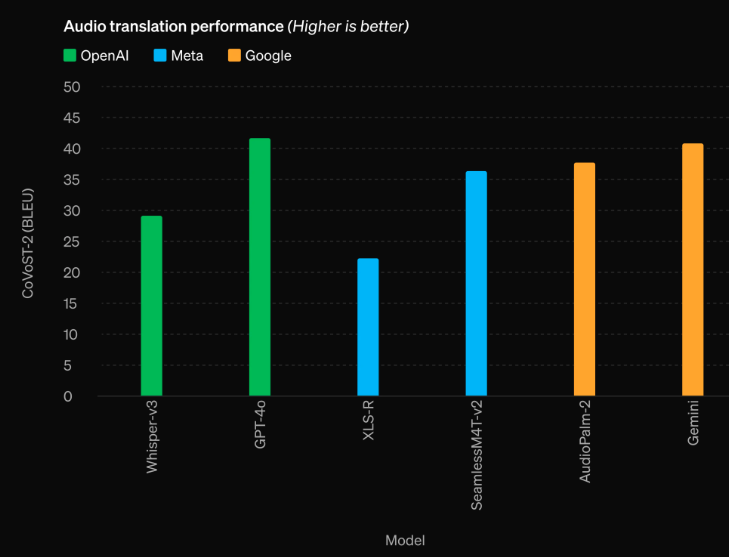

下記の図はモデルごとに翻訳の精度を比較したものです。GPT-4oは、GoogleのGeminiよりややいい結果となっており、全言語モデルの中でもトップの精度を出しています。

GPT-4oの視覚理解能力

こちらもOpenAI発表の視覚認識ベンチマーク結果では、GPT-4oは最先端の性能を達成しています。

以前、GPT-4とClaude 3の画像解析精度対決でGPT-4がうまくいかなかったケースを試してみました。

下記のGoogleストリートビューの適当な場所のスクリーンショットをアップロードし、場所を特定できるか試すというものです。プロンプトはこちら。

【添付した画像を解析し、どの場所の写真かを教えて下さい。】

回答:

【この画像は福岡市の天神地区にある交差点を写したものです。左側の建物には「STARBUCKS COFFEE」があり、その隣のビルには「北九州SPRAY」という看板が見えます。右側のビルには「福岡県信用保証協会」の看板が掲げられています。この場所は福岡市の中心地で、商業施設やオフィスビルが立ち並ぶエリアです。】

正解!GPT-4よりも進化してる!

GPT-4oのユースケース

すでにいくつかのユースケースは列挙しましたが、もう少しどのように最新のGPT-4oを活用できるか挙げてみたいと思います。

目の不自由な方の補助

動画をリアルタイムに解析することができるため、カメラで周りの様子を映しながらGPT-4oが目の不自由な方にその様子を伝えるというデモが公開されています。

安全性にかかわるので流石に盲導犬や他の方の補助が必要と思われますが、行動の自由度が上がりそうです。

同じ仕組みを利用して、観光案内にも使えそうです。

言語教育

先程は数学の宿題をやっていたので、言語に限らず教育全般に活用できそうですが、言語教育は特に相性が良さそうです。下記のデモでは、カメラで物を映して、「これはスペイン語でなんといいますか?」とGPT-4oに質問して教えてもらう、というやり取りをしています。

ロープレ

下記のデモは面接の練習ですが、営業のロープレ、商談、インフォメーションセンターの応対、カスタマーサポートなどにも応用できそうです。

GPT-4oが意味する未来とは?

AGIを創造するというOpenAIのビジョンとそのビジネスモデルにより、言語モデルより強化し、より幅広いタスクをこなせるようにするという方向性をしっかりと見せてきたものと考えました。

同時に、音声によるAIとのコミュニケーションを重視している点は印象深かったです。音声によるUXにおいてはレスポンススピードが最も重要であるという点の再認識。将来的には、人間が話す相手が人間なのかAIなのかを意識することはほとんど無くなる、そのような世界観を目指しているのではないでしょうか。

動画解析やデスクトップアプリにも対応したことで、「GPTに何かを聞く」ことができるユースケースが格段に増えたことも一つのポイントです。

人と人とがコミュニケーションを取らないといけないような業種は、しばらくAIに置き換わることは無いだろうと考えていましたが、今回のデモを見てむしろ、代替は一気に加速しそうだと感じました。本当にこの分野の技術的な進歩は速い・・・!だからこそ面白い!