2025年5月21日に Google I/O 2025 が開催され、AI、特に「Gemini」に関する数多くの発表がありました。AIが私たちの日常や仕事をどう変えるのか、その具体的な姿が見えてきました。Geminiは単なるチャットボットを超え、より自然な会話や複雑なタスク実行が可能になりつつあります。例えば、Eloスコア(AIモデルの性能指標)が第一世代のGemini Proから300ポイント以上向上し、Gemini 2.5 ProはLMArenaリーダーボードの全カテゴリでトップを獲得するなど、その進化は目覚ましいものがあります。

この記事では、Google I/O 2025で発表されたGeminiの進化と、それによってもたらされるAIの未来について、重要なポイントを凝縮してお伝えします。

Google I/O 2025 徹底解説:AIの進化と未来像

Google I/O 2025の超ダイジェスト版

Google I/O 2025 で発表された特に注目すべき「すごい点」をまとめると、以下のようになります。

- Geminiの圧倒的進化: 知的モデル「2.5 Pro」が各種ベンチマークでトップ性能を叩き出し、効率特化「2.5 Flash」も大幅効率化。AIの頭脳が格段に賢く、速くなりました。

- リアルタイム対話AI「Gemini Live」の無料化: カメラや画面共有で、見ているものをAIとリアルタイムで相談可能に。まるでSF映画のような体験が誰でも手軽に。

- AIがタスクを丸ごと代行「Agent Mode」: アパート探しのような複雑な作業も、AIに頼めば複数のウェブサイトを横断して情報収集から予約まで実行。面倒な手間から解放される未来。

- 検索が「質問応答」から「問題解決」へ: AI ModeやDeep Searchにより、複雑な質問や専門的な調査もGoogle検索だけで完結。自分だけのAIリサーチアシスタントを手に入れる感覚。

- クリエイティブAIの表現力が爆発: 画像生成「Imagen 4」はプロ級の仕上がり、動画生成「Veo 3」は音声付きで映画のような映像を自動生成。専門知識なしで高品質コンテンツ作成が可能に。

- Android XRで現実とデジタルが融合: 軽量メガネや高性能ヘッドセットで、AIアシスタントが現実世界と連携。リアルタイム翻訳や空間コンピューティングがより身近に。

- AIが社会課題解決の切り札に: 山火事早期発見「Firesat」や災害時ドローン配送「Wing」、難病解明「AlphaFold 3」など、AIが地球規模の課題解決に貢献。

これらの発表は、AIが私たちの生活、仕事、そして社会のあり方そのものを大きく変革する可能性を秘めていることを示しています。

Google I/O 2025の核心:AIによる日常と仕事の変革

Google I/O 2025では、AI(人工知能)が私たちの生活や働き方を根底から変える未来が具体的に示されました。

その中心は、Googleの高性能AIモデル「Gemini」の目覚ましい進化です。

これは、従来のAIアシスタントが単純な命令に応答するのに対し、Geminiは人間と自然に対話したり、複雑な情報を理解・整理したり、さらにはユーザーに代わって様々なタスクを実行したりする能力を持つ点が大きく異なります。

例えば、検索エンジンはより高度な質問に応じ、スマートフォンアシスタントはカメラで捉えた情報を基に対話できるようになります(例:ユーザーがゴミ収集車をコンバーチブルと間違えた際に「そのゴミ収集車をコンバーチブルと見間違えたようですね」と訂正)。

メール作成も個人のスタイルを学習したAIがサポートします。

Googleは、この1年でAI製品・機能のリリースを加速し、月間トークン処理数は昨年のI/O時点での9.7兆から480兆へと約50倍に増加。これは、AIがより多くの情報を処理し、より賢くなっていることを意味します。この進化は、特に情報収集や日常の雑務に多くの時間を費やしている人にとって、大幅な時間短縮と効率化をもたらすでしょう。

Geminiの大進化 – Google I/O 2025が示すAIの最前線

Gemini 2.5 ProとFlash:知性と効率性の融合

「Gemini 2.5 Pro」は、Google史上最も知的なモデルとされ、複雑な推論や高度なコーディング能力を誇ります。

従来のモデルが特定のタスクに特化していたのに対し、Gemini 2.5 Proは幅広い分野で高い性能を発揮し、LMArenaリーダーボードの全カテゴリでトップを獲得。

特にコーディングでは、Web開発特化の「WebDev arena」で前バージョンから142 Eloポイント差をつけて1位、AIコードエディタCursorでは毎分数十万行のコード追加に貢献しています。これは、専門的な開発者や研究者にとって、より高度な問題解決や革新的なアプリケーション開発を強力にサポートすることを意味します。

上の画像は、Gemini 2.5 Proがベンチマークで高い評価を得ていることを示しています。

一方、「Gemini 2.5 Flash」は効率性と速度に特化。応答速度が求められるチャットボットやリアルタイム分析など、コストを抑えつつ迅速な処理が必要な開発者にとって最適です。同じパフォーマンスでトークン数を削減し、22%の効率向上を達成。

Proは6月初旬、Flashも順次一般提供予定です。

Gemini DeepThink:思考の限界へ挑む新モード

「Gemini 2.5 Pro DeepThink」モードは、AIに「より深く考える時間」を与えることで、応答品質を極限まで高めることを目指す機能です。

従来のAIが速度と品質のバランスを取っていたのに対し、DeepThinkは複雑な問題解決に特化。数学ベンチマーク「USAMO 2025」やコーディングベンチマーク「LiveCodeBench」で優れた成績を収めました。

これは、科学研究や難解な技術開発など、人間の専門家でも時間を要するような高度な知的作業に取り組む人々にとって、新たな発見やブレークスルーを支援する強力なツールとなり得ます。ただし、最先端技術のため、まずは信頼できるテスターへGemini API経由で提供されます。

Gemini Live:リアルタイム対話型AIの新たな体験

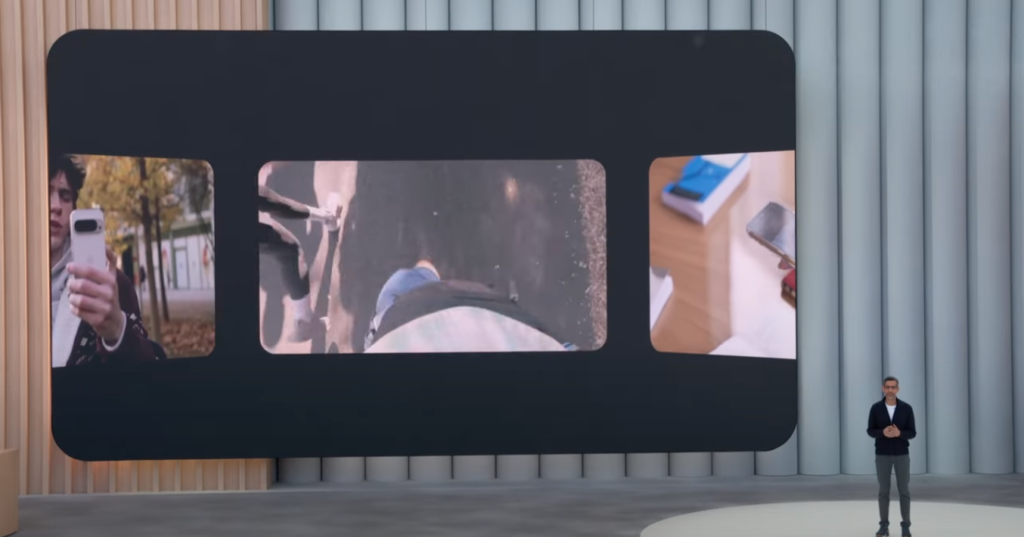

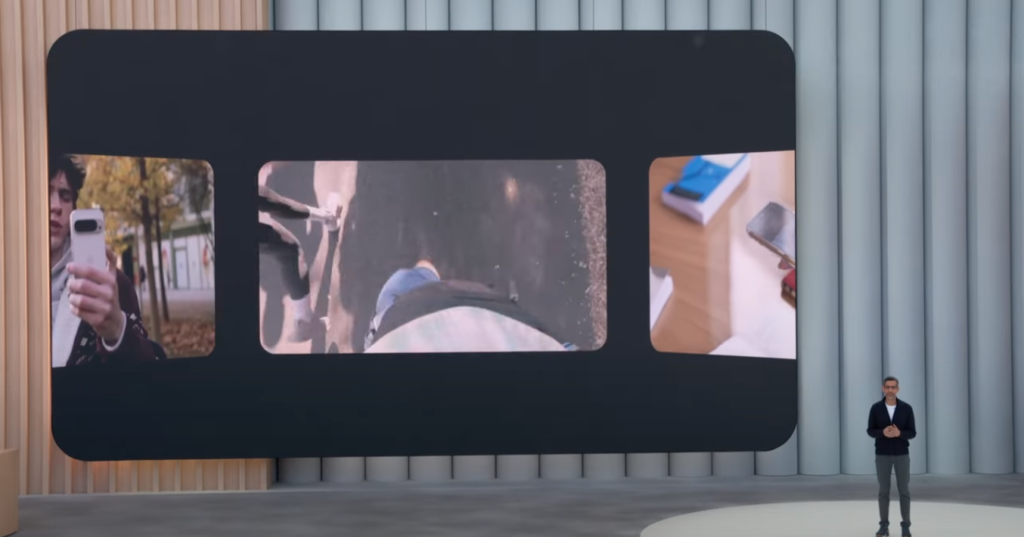

「Gemini Live」は、Geminiアプリを通じて、カメラや画面共有を使いながらリアルタイムでAIと対話できる機能です。

従来の音声アシスタントが主に音声コマンドに応答するのに対し、Gemini Liveは視覚情報も理解し、より文脈に沿ったインタラクションが可能です。.例えば、旅行先でカメラをかざして「この建物は何?」と尋ねたり、DIY作業中に手元を写して「次は何をすればいい?」とアドバイスを求めたりできます。これは、新しい場所を探索する旅行者や、複雑な作業手順を学ぶ人にとって非常に便利です。

45以上の言語に対応し、テキスト会話より5倍長い会話時間というデータも。AndroidおよびiOSのGeminiアプリで無料提供が開始されています。

上の画像は、Gemini Liveがカメラを通して現実の情報を認識し対話する様子です。

Gemini APIとSDK:開発者ツールの進化と新機能

開発者がGeminiの能力を自身のアプリに組み込むための「Gemini API」と「Gemini SDK」も進化。

主な新機能は以下の通りです。

- 思考サマリー:モデルの思考プロセスを可視化し、デバッグを容易にします。具体的には、モデルが行った推論のステップ、参照した情報源、呼び出したツール(外部APIなど)といった情報が、ヘッダーや主要な詳細情報と共に整理されて表示されます。

- 思考予算:応答品質とコスト・レイテンシのバランスを開発者が調整可能に。

- マルチモーダル機能強化:テキスト読み上げ(TTS)で2つの異なる声質を使い分けるマルチスピーカーサポート(24言語以上対応)。

これらの機能は、AIアプリケーション開発の効率化と高度化を求める開発者にとって、より柔軟で強力な開発環境を提供します。

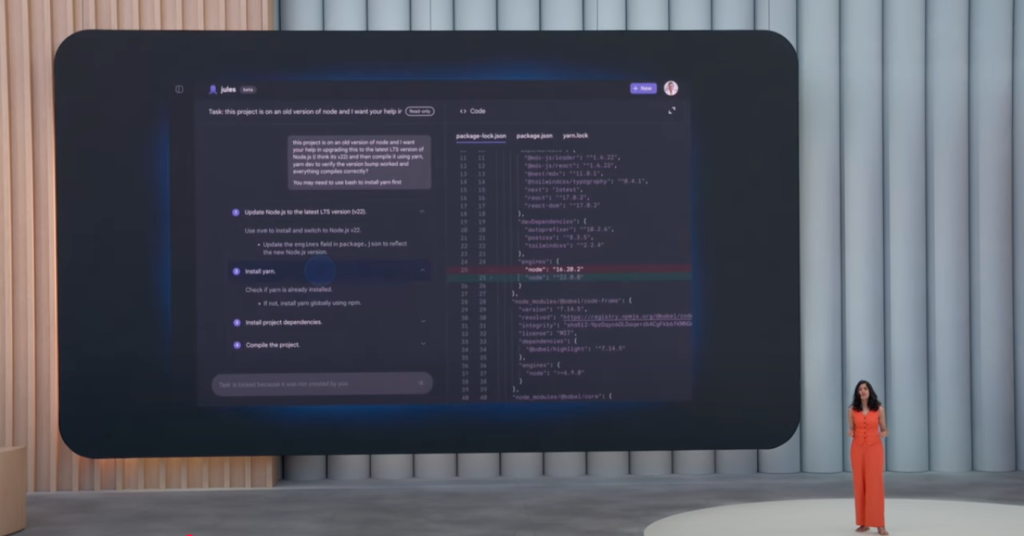

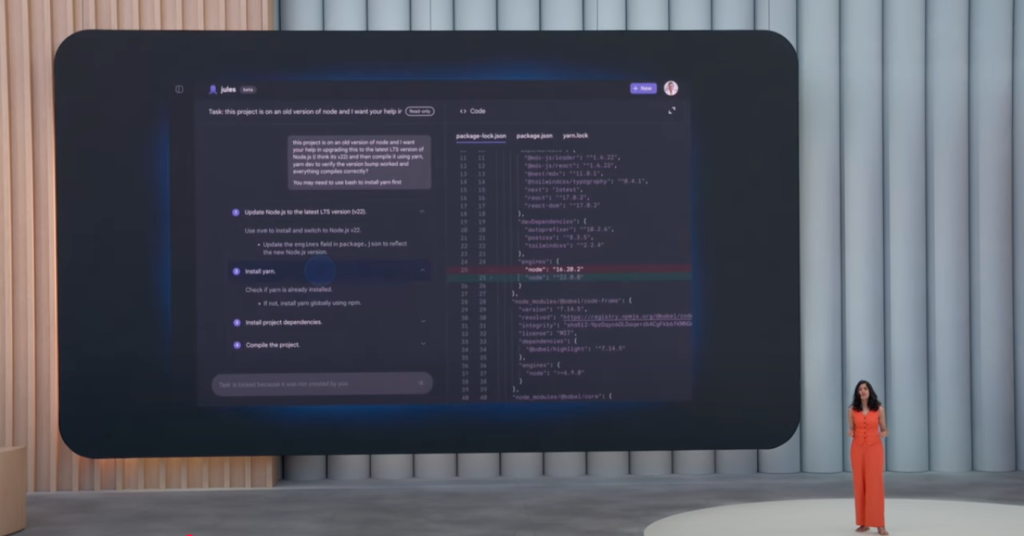

Jules:AIコーディングエージェントの登場と開発支援

AIコーディングエージェント「Jules」のパブリックベータ版が提供開始。

Julesは、複雑なコーディングタスク(例:古いNode.jsで書かれた大規模コードベースの更新)を自律的に処理します。これは、従来人間が数時間から数日かけて行っていた作業を、AIが数分で完了できる可能性を示しています。

大規模プロジェクトのメンテナンスや、新しい技術への移行作業に追われる開発チームにとって、大幅な時間節約と生産性向上に繋がります。GitHubと連携し、jules.googleからサインアップ可能です。

上の画像は、JulesがCanvas内でコードを生成・修正する様子を示唆しています。

Google検索の未来 – Google I/O 2025で変わる情報アクセス

AI OverviewsとAI Mode:検索体験の根本的変革

Google検索の中核機能「AI Overviews」は、検索結果トップにAI生成の要約情報を表示し、月間15億人以上に利用されています。

今回、カスタム版Gemini 2.5搭載で情報品質と精度が向上。さらに進んだ「AI Mode」は、より高度な推論能力で長く複雑な質問にも対応。従来のキーワード検索では得られなかった、文脈を理解した包括的な回答をAIが生成します。

これは、複雑な情報を効率的に収集したい学生や研究者、あるいは具体的な問題を抱える一般ユーザーにとって、検索のあり方を大きく変えるものです。

AI Modeは米国で提供開始。

Personal ContextとDeep Search:パーソナルで深い情報探索

「Personal Context」は、ユーザーの許可のもとGmail等の情報をAIが活用し、よりパーソナライズされた検索結果を提供。例えば、過去の旅行履歴から次の旅行プランを提案するなど、個人の嗜好に合わせた情報提供が可能です。

一方、「Deep Search」は、AIがユーザーに代わって数十から数百の検索クエリを発行し、専門家レベルの詳細なレポートを生成。これは、特定のトピックについて徹底的に調べたいジャーナリストやアナリストにとって強力なツールとなります。

Personal Contextは今夏AI Modeで提供開始予定。

Search LiveとAIショッピング:リアルとデジタルを繋ぐ検索

「Search Live」は、スマートフォンのカメラで現実世界を写しながらAIと対話し情報を得る機能。

例えば、見慣れない植物の名前を尋ねたり、故障した家電の修理方法をリアルタイムで教えてもらったりできます。

これは、言葉で説明しにくい状況で即座に情報を得たい場合に非常に有効です。また、「AIショッピング」機能では、500億件以上の商品リストを持つShopping Graphと連携し、バーチャル試着やAIエージェントによる購入代行も可能に。オンラインショッピングでの試着の悩みや、煩雑な購入手続きから解放されます。

AIエージェントとパーソナライゼーション – Google I/O 2025の注目技術

Project AstraとProject Mariner:タスクを代行するAIエージェント

「Project Astra」は、カメラやマイクを通じて周囲の状況をリアルタイムで理解し、プロアクティブなサポートを目指す次世代AIアシスタントの研究プロジェクトです。

デモでは、自転車修理を手伝う様子(例:「Huffyマウンテンバイク」のマニュアル検索、「3/8インチ六角ナット」の特定)が紹介されました。これは、日常生活の様々な場面で、まるで有能なアシスタントがそばにいるかのようなサポートを受けられる未来を示します。

「Project Mariner」は、AIがウェブブラウザ等を操作しタスクを実行する技術。最大10タスクを同時実行できる「マルチタスキング機能」や、一度教えた作業を記憶・再現する「Teach and Repeat機能」を搭載。これらを活用したGeminiアプリの「Agent Mode」では、アパート探しのような複雑なタスクもAIが代行します。これは、情報収集や比較検討に多くの時間を費やしている人々にとって、大幅な負担軽減となります。

生成AIの進化 – Google I/O 2025で広がるクリエイティブの可能性

Imagen 4とVeo 3:高品位な画像・音声付き動画生成

画像生成モデル「Imagen 4」は、より豊かな色彩と緻密なディテール、そして自然なテキスト・タイポグラフィ表現を実現。

従来モデル比10倍高速なバリアントも登場。これは、デザイナーやマーケターが高品質なビジュアルコンテンツを迅速に作成するのに役立ちます。

動画生成モデル「Veo 3」は、ネイティブオーディオ生成機能を搭載し、映像に合わせた効果音、背景音、キャラクターのセリフまで自動生成。映画のような高品質な動画コンテンツを、専門知識がない人でも手軽に作成できるようになります。

上の画像は、Veo 3が生成する動画のワンシーンで、キャラクターの表情や背景のディテール、そしてこれに合わせた音声が生成されることを示唆しています。

Lyria 2、Flow、SynthID:音楽・映像制作とコンテンツ透明性

音楽生成モデル「Lyria 2」とプロ向けツール「Music AI Sandbox」は、高品質な楽曲や歌声の生成を可能にし、ミュージシャンの創造性を刺激します。

AIフィルムメイキングツール「Flow」は、Veo、Imagen、Geminiを組み合わせ、プロンプトベースで映像制作を支援。これは、映像クリエイターがアイデアを迅速に形にするための強力な手段となります。

AI生成コンテンツの透明性確保のため、電子透かし技術「SynthID」とその検出ツール「SynthID Detector」も強化。これらは、クリエイターがAIを安心して活用し、また視聴者がコンテンツの出自を理解する上で重要です。

Android XRと未来のデバイス – Google I/O 2025で描く新たな体験

Android XRプラットフォームと提携:没入型体験の拡大

AI時代の新コンピューティングプラットフォーム「Android XR」は、ヘッドセットから軽量メガネまで多様なデバイスをサポート。

Samsung開発のXRヘッドセット「Project Moohan」(今年後半発売予定)では、無限のスクリーンでアプリ探索やGeminiとの対話、MLB観戦などが可能に。また、日常利用しやすい「Android XRメガネ」のプロトタイプも披露。カメラ、マイク、スピーカー、レンズ内ディスプレイを搭載し、リアルタイム翻訳などのデモが行われました。

さらに、人気アイウェアブランド「Gentle Monster」と「Warby Parker」との提携も発表。これは、XR技術をより多くの人にとって身近でファッショナブルなものにしようというGoogleの意図を示しており、テクノロジーとデザインの融合を求めるユーザーにとって魅力的な選択肢が増えることを意味します。

Google I/O 2025で示されたAIの社会的応用と未来展望

FiresatとWing:AIによる災害対策と人道支援

AI技術の社会的応用例として、山火事対策プロジェクト「Firesat」が紹介されました。

衛星画像とAIで、わずか270平方フィートの火災も検知し、将来的には20分ごとに情報更新を目指します。これは、迅速な初期消火活動や避難誘導に繋がり、被害を最小限に抑えることに貢献します。

また、ドローン配送サービス「Wing」は、ハリケーン・ヘレン発生時にAIを活用し、リアルタイムのニーズに基づき救援物資を配送。これらは、AIが人命救助や社会インフラ維持に直接貢献できることを示しており、行政機関やNPO/NGOにとって、より効果的な支援活動を展開するための新たな手段となり得ます。

AlphaFold 3と科学技術への貢献:生命科学の革新

AIは基礎科学の進歩にも貢献。

タンパク質構造予測AI「AlphaFold」の最新版「AlphaFold 3」は、生命を構成するあらゆる分子の構造と相互作用を予測可能にし、創薬や疾患メカニズム解明を加速。既に世界の250万人以上の研究者に利用されています。

また、AI自身が科学的知識を発見する「AlphaEvolve」や、数学オリンピック問題を解く「AlphaProof」なども紹介。これらは、研究者や科学者が複雑な課題に取り組み、新たな発見をするための強力なツールとなり、医療、材料科学、環境科学など幅広い分野でのイノベーションを促進します。

Google I/O 2025が示すAIの未来と開発者への期待

Google I/O 2025は、AIが「研究から現実へ」と急速に移行し、生活、仕事、社会に大きな変化をもたらすことを示しました。

サンダー・ピチャイCEOは、この変革を実現するには開発者、テクノロジービルダー、問題解決に取り組む人々の力が不可欠と強調。講演の最後には、AIの言及回数を示すカウンターで「Geminiが95回でトップだ」というジョークも飛び出し、AIの進化が今後も続くことを示唆しました。

このイベントは、AIが拓く無限の可能性と、それを形にする開発者コミュニティへの大きな期待を示すものでした。