こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

Metaの「LCMs(Large Concept Models)」は、従来のトークンレベルの処理ではなく、より高次な「概念」レベルで言語を扱う新しいアーキテクチャの言語モデルです。「概念」とは、言語やモダリティに依存しない、抽象化された意味の単位を指します。

LCMsは、その概念ベースのアプローチにより、従来のLLMでは難しかった、異なる言語間やモダリティ間での知識の転移や、ゼロショット学習を実現する可能性を秘めています。しかし、「具体的にどのようにして概念を捉えているのか?」「従来のLLMと比較して、どのようなタスクで優れているのか?」など、まだまだ疑問点は多く、その内部構造や学習方法、そして、具体的な応用可能性など、さらに深く知りたいという方も多いのではないでしょうか。

この記事では、Metaの「LCMs(Large Concept Models)」の詳細な解説と、その仕組み、学習方法、アーキテクチャ、そして、他のモデルと比較した際の優位性、今後の展望について網羅的に解説します。

LCMs:トークンレベルを超える新しい言語モデル

LCMsとは?概念レベルで言語を捉える新たな試み

LCMs (Large Concept Models) は、従来のトークンレベルの処理ではなく、より高次な「概念」レベルで言語を扱う新しいアーキテクチャの言語モデルです。現在主流となっているLLMは、入力と出力をトークンレベルで処理します。これは人間が情報を分析したり、コンテンツを生成したりする際に、単語レベルをはるかに超えた複数の抽象化レベルで動作することとは対照的です。

LCMsでは、「概念」を言語やモダリティに依存しない、抽象化された意味の単位と定義しています。具体的には、この研究では、テキストにおける文、あるいはそれに相当する発話単位を「概念」として扱っています。そして、この「概念」を、最大200の言語とテキスト、音声モダリティをサポートする既存の文埋め込み空間であるSONARを用いて表現します。

この「概念」は、文や発話の意味を抽象化し、異なる言語やモダリティ間でも共通の意味空間で表現することを可能にします。例えば、「猫がマットの上に座っている」という文と、それに対応する音声や、他言語の文は、それぞれ異なるトークン列や音声波形を持ちますが、LCMsでは、それらを「猫がマットの上に座っている」という共通の「概念」として捉え、高次元の埋め込み空間上の近いベクトルとして表現します。

さらに、LCMsはこの「概念」を基盤として、言語の生成や理解を行うことで、従来のトークンベースのモデルでは難しかった、言語やモダリティを超えた高度な推論や、柔軟な知識の転移を実現する可能性を秘めているのです。そして、この新しいアプローチは、機械翻訳や多言語情報検索などの分野において、さらなるブレイクスルーをもたらすことが期待されています。LCMsは、自然言語処理の新たな地平を切り開く、革新的な技術と言えるでしょう。

従来のLLMとの違い:抽象化レベルと推論能力

従来のLLMとLCMsの主な違いは、情報の抽象化レベルと、それに伴う推論能力です。以下の表で、それぞれの特徴を比較します。

| 特徴 | 従来のLLM | LCMs |

|---|---|---|

| 抽象化レベル | トークンレベル | 概念レベル(文レベル) |

| 推論能力 | 局所的な文脈における推論に限定 | 高次レベルの抽象的な推論が可能 |

| 処理単位 | トークン(単語やサブワード) | 概念(文や発話) |

| 長い文脈の扱い | 計算コストが二次的に増加 | 効率的に処理可能 |

| 言語・モダリティへの依存 | 特定の言語やモダリティに依存 | 言語やモダリティに非依存 |

従来のLLMは、人間が情報を処理したり生成したりする際に行うような、複数の抽象化レベルでの明示的な推論や計画を欠いています。人間は複雑なタスクを解決したり、長い文書を作成したりする際に、まず高次のレベルで全体像を計画し、次に段階的に詳細をより低いレベルで追加していくトップダウンプロセスをとります。これは、研究者が講演や論文を準備する際の手順として具体例が示されています(Li et al., 2024、Sun et al., 2022)。

これに対し、LCMsは、抽象的な埋め込み空間で推論を行うことで、より人間に近い、階層的な情報処理と生成を可能にします。この「概念」レベルでの処理は、従来のトークンレベルの処理と比較して、より高度な推論能力をモデルにもたらすことが期待されます。

例えば、LCMsは、文と文の間の意味的なつながりや、文書全体の論理的な流れを捉えることが得意です。これにより、より一貫性のある、自然な文章を生成することが可能になります。

さらに、LCMsは、抽象的な「概念」を介して、異なる言語やモダリティ間の知識を関連付けることができます。例えば、ある言語で学習した知識を、他の言語での推論に活用したり、テキストで表現された知識を音声や画像と関連付けたりすることが可能になります。

このような、抽象化レベルでの推論能力の向上は、LCMsが従来のLLMを超え、より人間らしい柔軟な思考や推論を実現するための重要なステップとなると考えられます。このアプローチは、自然言語処理の分野に新たな可能性を切り開くものであり、今後の研究の進展が期待されます。

ちなみに、MetaのLLMといえばLlama(現時点での最新バージョンはLlama 3.3)です。Llama 3.3に関してはこちらの記事にまとめていますので、ぜひご覧ください!

関連記事:Meta社がLlama 3.3を発表|Llama 3.1の405Bに匹敵する性能を70Bで実現!

LCMsのアーキテクチャ:埋め込み空間での自己回帰予測

LCMsは、埋め込み空間での自己回帰的な文予測を行うように学習されます。具体的には、MSE回帰、拡散ベースの生成のバリエーション、量子化されたSONAR空間で動作するモデルなど、複数のアプローチが検討されています。これらの実験は、約1.3兆トークンの学習データを用いて、16億パラメータのモデルを使用して行われました。さらに、70億パラメータのモデルへとスケールアップした実験も行われ、より大規模なモデルにおける性能も検証されています。

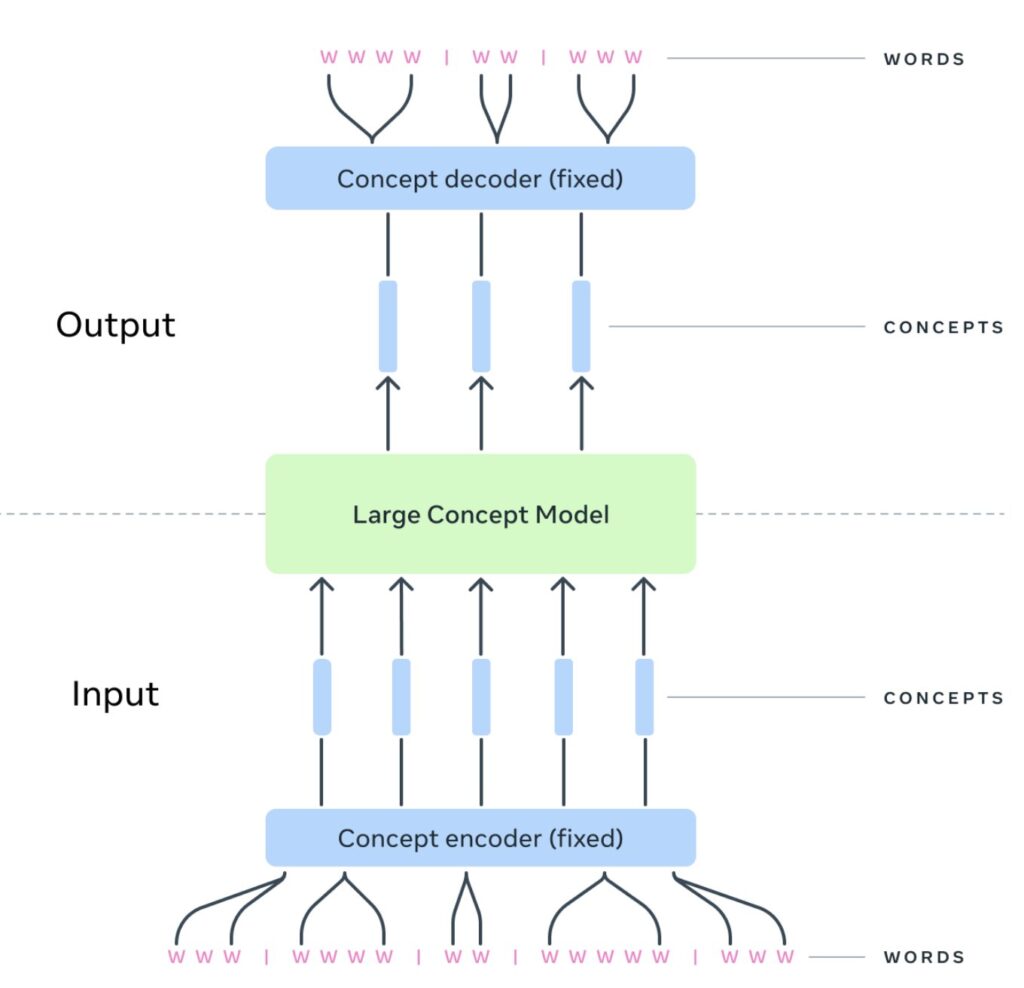

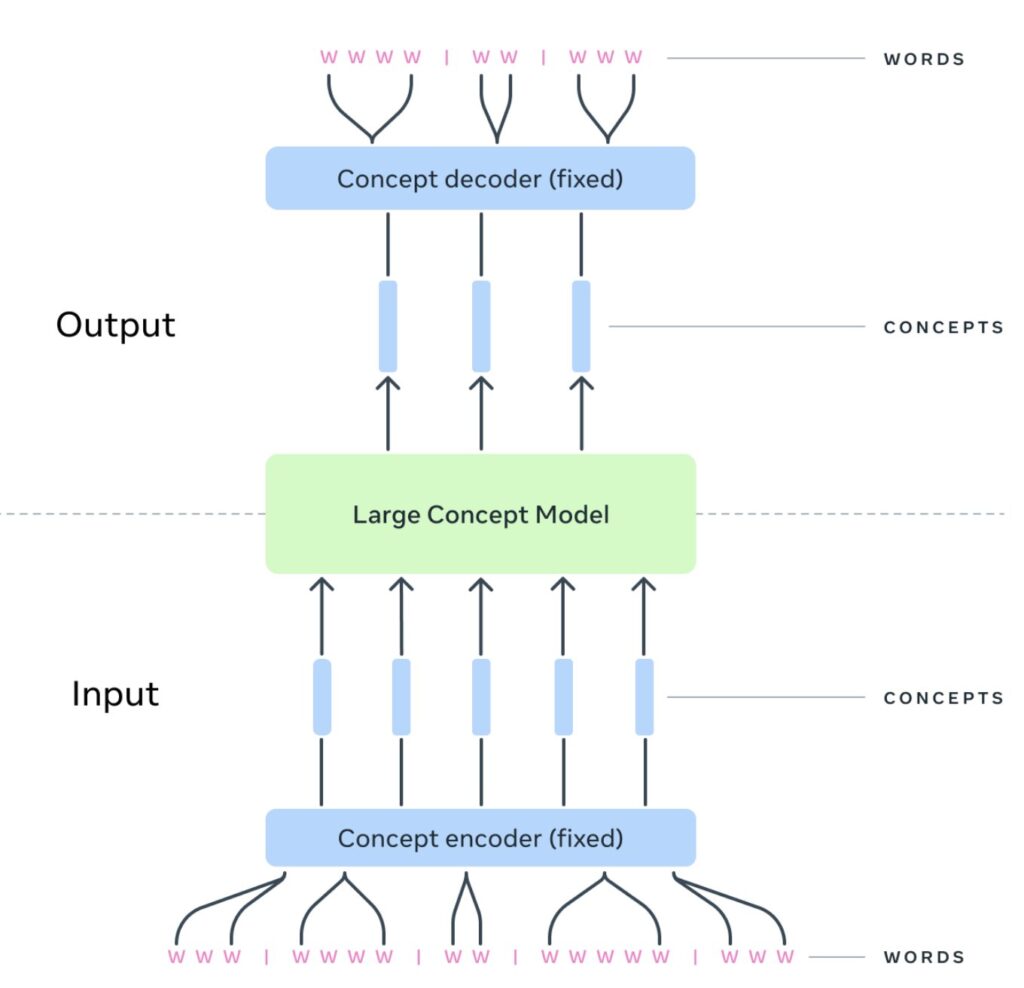

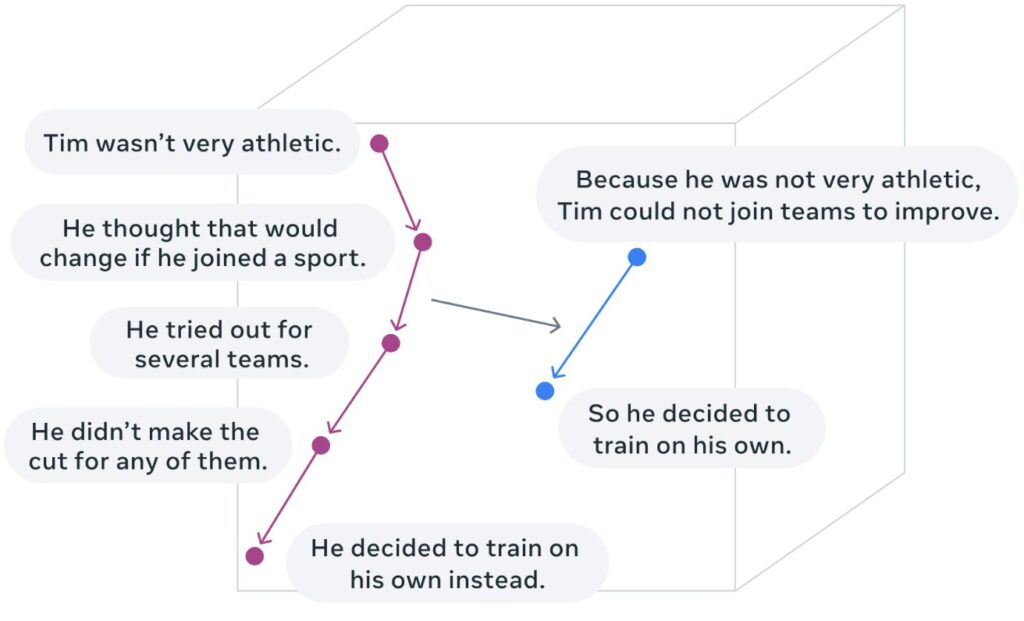

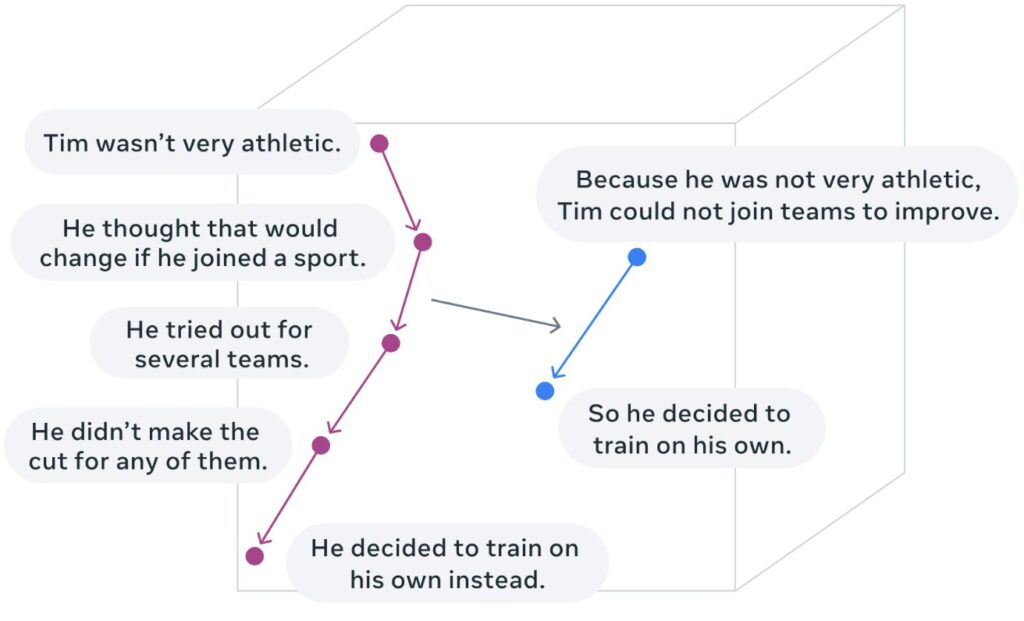

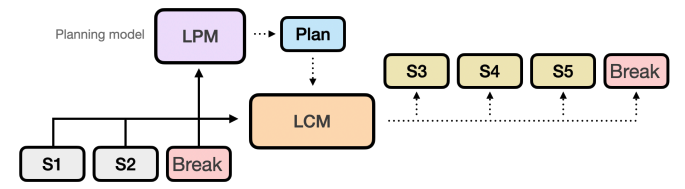

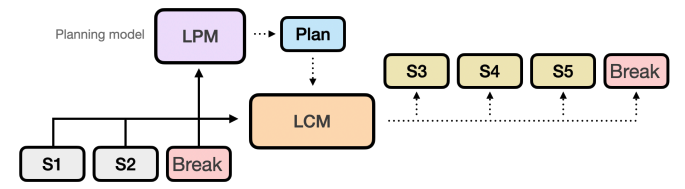

以下の図は、LCMsの全体的なアーキテクチャと処理フローを示しています。入力はまず文に分割され、各文はSONARによってエンコードされ、概念(文埋め込み)のシーケンスが得られます。この概念のシーケンスは、次にLCMによって処理され、出力として新しい概念のシーケンスが生成されます。最後に、生成された概念はSONARによってデコードされ、サブワードのシーケンスになります。

このプロセスにおいて、LCMは、過去の概念のシーケンスに基づいて、次の概念を予測するという自己回帰的なタスクを実行します。この自己回帰的な予測は、埋め込み空間内で行われるため、モデルは文と文の間の意味的な関連性を捉え、より一貫性のある文章を生成することが可能になります。また、埋め込み空間は連続的な空間であるため、離散的なトークン列を扱う従来のモデルと比較して、より柔軟な表現と生成が可能になります。さらに、SONARエンコーダとデコーダは固定されており、トレーニングは行われないことに注意することが重要です。つまり事前学習済みの、フローズンなSONARモデルを使用しています。

LCMsの利点:マルチモーダル、多言語への拡張性

LCMsのアーキテクチャは、モジュール性と拡張性に優れています。

モダリティの競合に悩まされる可能性のあるマルチモーダルLLMとは異なり、LCMsでは、概念のエンコーダとデコーダを個別に開発し、最適化することができます。そのため、例えば、テキスト、音声、画像など、異なるモダリティに対応したエンコーダとデコーダを別々に開発し、それらを組み合わせることで、マルチモーダルな処理を効率的に実現できます。これは、すべてのモダリティを同時に扱う必要のある従来のマルチモーダルLLMと比較して、大きな利点となります。

また、既存のシステムに新しい言語やモダリティを簡単に追加することも可能です。新しい言語に対応するには、その言語用のSONARエンコーダとデコーダを用意するだけでよく、LCM自体を変更する必要はありません。同様に、新しいモダリティに対応するには、そのモダリティ用のエンコーダとデコーダを開発し、既存のLCMに接続するだけで済みます。このモジュール性により、LCMsは非常に拡張性が高く、さまざまなタスクやドメインに適応させることが容易になります。

- モジュール性と拡張性:異なるモダリティに対応したエンコーダとデコーダを個別に開発し、組み合わせることができる

- 容易な拡張性:既存のシステムに新しい言語やモダリティを簡単に追加可能

- 効率的なマルチモーダル処理:テキスト、音声、画像など、異なるモダリティの組み合わせが可能

さらに、LCMsは、長いコンテキストと長い形式の出力を効率的に処理できます。バニラトランスフォーマーモデルの複雑さは、シーケンスの長さに対して2次的に増加します。これにより、長いコンテキストウィンドウの処理が困難になります。一方、LCMsは、少なくとも1桁短いシーケンスで動作するため、この問題が軽減されます。

具体的には、LCMsは文を単位として処理するため、トークンを単位とする従来のモデルと比較して、処理するシーケンスの長さが大幅に短くなります。これにより、長い文書や対話などの処理が効率化され、計算コストの削減にもつながります。さらに、LCMsは、長いコンテキストにおける依存関係を、より高次な「概念」レベルで捉えることができるため、より一貫性のある長い出力を生成することが可能になります。これらの特性は、LCMsが、要約、物語生成、対話システムなど、様々な応用分野において、従来のモデルを凌駕する可能性を示しています。

加えて、LCMsは、その設計上、強力なゼロショット汎化性能を示します。この論文では、英語のテキストのみでモデルをトレーニングし、追加のトレーニングデータ(整列データも非整列データも)なしに、他の言語のテキストに適用しました。LCMは、Llama-3.1-8B-ITを英語およびLLMで公式にサポートされている外国語の平均で上回りました。LCM自体は、これらのソースから知識を得るために、多言語およびモーダルデータでトレーニングすることもできます。将来のバージョンのLCMでは、この点を調査する予定です。要するに、すべての言語とモダリティは、LCMのすべての段階で平等に扱われる、第一級市民なのです。

LCMsの実験的評価:多様なタスクでの性能検証

要約タスクと要約拡張タスクにおける性能比較:LCMsの有効性検証

論文では、70億パラメータのモデルを用いて、要約と要約拡張を含む複数の生成タスクで実験的な評価が行われました。要約タスクでは、CNN DailyMailとXSumデータセット、および長い文書を入力とするLCFOコーパスが使用されました。

これらのデータセットは、ニュース記事とその要約から構成されており、要約の品質を評価するために広く使用されています。一方、要約拡張タスクでは、CNN DailyMailとXSumの要約を入力とし、長い文書を生成します。これらのタスクは、LCMsが長い文書を理解し、要約し、さらに、与えられた要約から元の文書のスタイルや内容を保持しつつ、より長い文書を生成できるかという能力を評価するために選ばれました。

比較対象として、T5 (Raffel et al., 2020)、Gemma-7B、Mistral-7B-v0.3 (Jiang et al., 2024)、Llama-3.1-8Bなどの既存のLLMが用いられました。これらのモデルは、要約タスクで高い性能を示していることが知られています。

評価指標としては、ROUGE-L (Lin, 2004)、OVL-3、REP-4、CoLA (Krishna et al., 2020)、SH-4、SH-5(Clark et al., 2023)などが使用されました。ROUGE-Lは、生成された要約と参照要約との間の最長共通部分列(LCS)に基づくF値であり、要約の精度を評価します。OVL-3は、生成された要約に含まれる、ソース文書からコピーされた3-gramの割合を示し、REP-4は、生成されたテキスト内の繰り返される4-gramの割合を示します(Welleck et al., 2019)。CoLAは、文の文法的な正しさを評価する指標であり、SH-4とSH-5は、それぞれ要約がソース文書に帰属できるかどうか、および要約がソース文書の主要なアイデアを捉えているかどうかを評価する指標です。

これらの指標を用いることで、生成された要約の品質を多角的に評価することができます。具体的には、以下の表のように、異なるモデルとタスクにおける結果がまとめられます。

| モデル | タスク | ROUGE-L | OVL-3 | REP-4 | CoLA | SH-4 | SH-5 |

|---|---|---|---|---|---|---|---|

| Ground truth | CNN/DailyMail | 100.00 | 0.170 | 0.684 | 0.850 | 0.683 | 0.586 |

| T5-3B | CNN/DailyMail | 37.56 | 0.174 | 0.854 | 0.946 | 0.773 | 0.503 |

| Gemma-7B-IT | CNN/DailyMail | 31.14 | 0.245 | 1.032 | 0.945 | 0.740 | 0.650 |

| Mistral-7B-v0.3-IT | CNN/DailyMail | 36.06 | 0.202 | 0.780 | 0.972 | 0.780 | 0.676 |

| Llama-3.1-8B-IT | CNN/DailyMail | 34.97 | 0.248 | 0.928 | 0.973 | 0.763 | 0.692 |

| Two-Tower-7B-IT | CNN/DailyMail | 36.47 | 0.177 | 0.757 | 0.767 | 0.723 | 0.459 |

| Ground truth | XSUM | 100.00 | 0.108 | 0.399 | 0.987 | 0.352 | 0.418 |

| T5-3B | XSUM | 17.11 | 0.221 | 0.671 | 0.939 | 0.680 | 0.450 |

| Gemma-7B-IT | XSUM | 18.20 | 0.177 | 0.620 | 0.769 | 0.546 | 0.446 |

| Mistral-7B-v0.3-IT | XSUM | 21.22 | 0.162 | 0.480 | 0.922 | 0.633 | 0.621 |

| Llama-3.1-8B-IT | XSUM | 20.35 | 0.186 | 0.501 | 0.941 | 0.687 | 0.658 |

| Two-Tower-7B-IT | XSUM | 23.71 | 0.106 | 0.464 | 0.683 | 0.358 | 0.284 |

結果として、LCMsは、CNN DailyMailとXSumの要約タスクにおいて、特にファインチューニングされたT5-3Bと比較して、競争力のあるROUGE-Lスコアを達成しました。また、LCMsは、LLMと比較して、より少ない繰り返しで、より抽象的な要約を生成する傾向があることが示されました。

これは、LCMsがトークンレベルではなく、より高次な「概念」レベルで処理を行うため、より多様で創造的な表現を生成できることを示唆しています。長いコンテキストの要約タスクでは、LCMsはMistral-7B-v0.3とGemma-7B-ITを上回り、特に5%と10%の条件で高いROUGE-Lスコアを示しました。これは、LCMsが長いコンテキストを効率的に処理し、重要な情報を抽出して要約する能力に優れていることを示しています。これらの結果から、LCMsは従来のLLMと比較して、特に長い文書の要約タスクにおいて、優れた性能を発揮する可能性が示されました。

要約拡張タスクでは、LLMがLCMsよりも高いROUGE-Lスコアを示しましたが、これは、LLMが元の文書とは異なる文を生成する傾向があるためと考えられます。一方、LCMsは、特にCNN DailyMailにおいて、より低い流暢さを示しました。これは、LCMsがまだ長い形式のテキスト生成において、改善の余地があることを示唆しています。しかしながら、このタスクは要約からより長い文書を生成する創造性を問うものであり、必ずしも元の文書を復元することを目的としていないことに注意する必要があります。そのため、ROUGE-Lスコアが低いことは、必ずしもLCMsの性能が劣っていることを意味するわけではありません。

これらの結果から、LCMsは要約タスクにおいて有望な性能を示すことが確認されました。特に、長いコンテキストの処理や、抽象的な表現の生成において、従来のLLMを上回る可能性が示唆されています。一方、要約拡張タスクでは、さらなる改善の余地があることも明らかになりました。今後の研究では、これらの課題を克服し、LCMsの潜在能力をさらに引き出すことが期待されます。

ゼロショット汎化性能の検証:多言語要約タスクでの評価結果

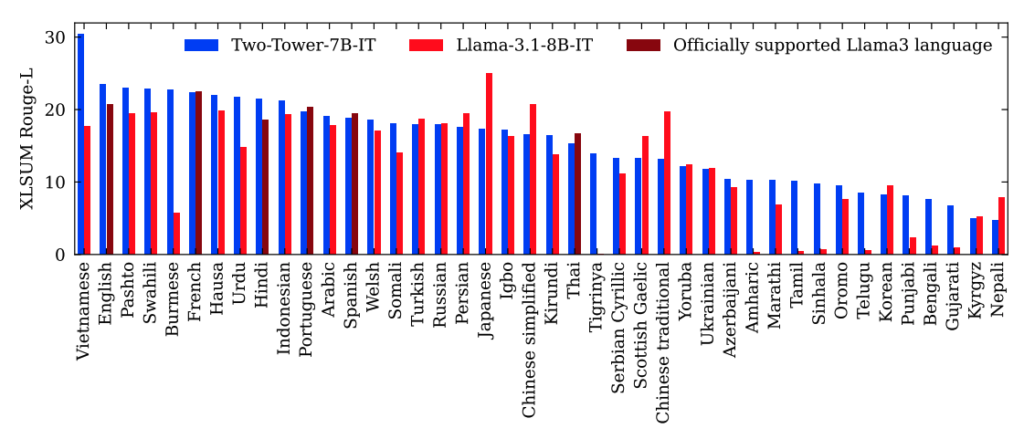

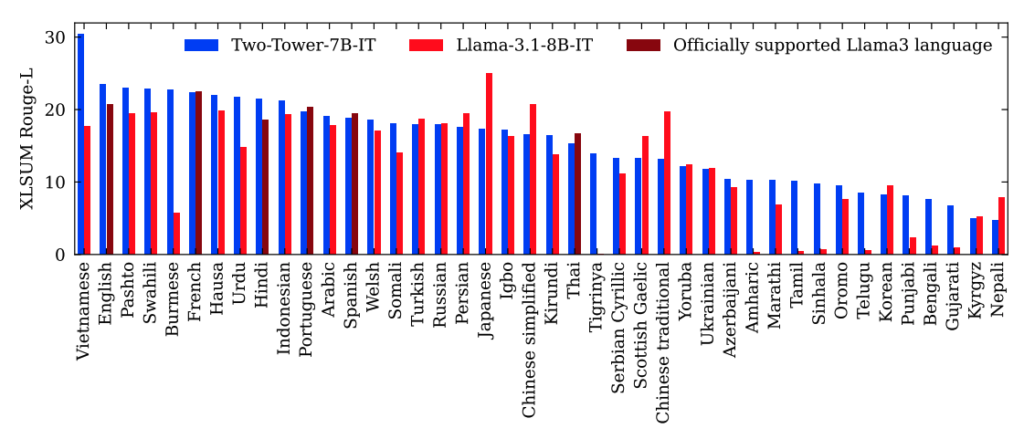

SONARは200の言語を表現できる意味空間です。この論文では、これまでに提示されたすべての実験は英語テキストで行われてきました。このセクションでは、提案されたLCMアプローチが、SONARの多言語データを表現する能力を活用して、他の言語をゼロショットで処理する能力を探ります。つまり、特定の言語でトレーニングされたLCMが、トレーニングデータに一切含まれていない他の言語に対しても、どの程度うまく機能するかを検証します。このゼロショット汎化性能は、LCMsの大きな利点の1つであり、多言語対応の容易さを示しています。具体的には、以下の点が評価されています。

- ゼロショット設定: LCMは英語データのみでトレーニングされ、他の言語のデータは一切使用されていない

- 評価対象言語: 42の言語(SONARでサポートされていない3言語を除く)

- 比較対象: Llama-3.1-8B-IT(8言語でファインチューニング)

- 評価指標: 多言語ROUGE-Lスコア

評価には、45の言語をカバーする大規模な多言語抽象的ニュース要約ベンチマークであるXLSUMコーパス(Hasan et al., 2021)を使用します。モデルの出力は、ベンチマークでリリースされた多言語ROUGEスコアリングスクリプトを使用してスコア付けされます。ROUGE-Lスコアは、言語固有のテキストトークン化とステミングに大きく依存することに注意してください。前述のスクリプトで提供されていない限り、モデルの出力と参照を、Lin(2004)のデフォルトのトークン化でトークン化します。韓国語、テルグ語、タミル語などの言語は、より適切なステミングとトークン化から恩恵を受ける可能性があります。

LCMのパフォーマンスを、英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語の8つの言語を公式にサポートするLlama-3.1-8B-ITと比較します。Llama3チーム(2024)によると、このモデルは事前学習中に追加の多くの言語を見てきましたが、これら8つの言語でのみ命令のファインチューニングが行われています。一方、LCMは英語以外の言語を一切見ておらず、英語のXLSUMトレーニングデータも使用していません。つまり、LCMは完全にゼロショットの設定で評価されます。

42の言語のROUGE-Lスコアを以下に示します。現在SONARでサポートされていない3つの言語(ピジン語、ラテン文字のセルビア語、キリル文字のウズベク語)は除外されています。LCMは、英語(23.5対20.7 ROUGE-L)と、両方のモデルで公式にサポートされ、XLSUMに含まれている6つの外国語の平均(20.2対19.7 ROUGE-L)で、Llama-3.1-8B-ITを大幅に上回っています。また、LCMは、南パシュト語、ビルマ語、ハウサ語、ウェールズ語など、すべてROUGE-Lスコアが20を超える多くの低リソース言語に非常によく汎化されていることがわかります。

他に優れたパフォーマンスを示す低リソース言語は、ソマリ語、イボ語、キルンジ語です。さらに、LCMはベトナム語で30.4のROUGE-Lスコアを獲得しています。全体として、これらの結果は、LCMがこれまで見たことのない言語への印象的なゼロショット汎化性能を示しています。これは、LCMsが、多言語情報検索や機械翻訳など、さまざまな応用分野で大きな可能性を秘めていることを示唆しています。特に、トレーニングデータが限られている低リソース言語においても高い性能を発揮できることは、LCMsの大きな強みと言えるでしょう。このゼロショット汎化性能は、LCMsが「概念」レベルで言語を捉えていることの証左であり、今後の多言語NLPの発展に大きく貢献することが期待されます。

明示的プランニングの導入:階層的生成の可能性をさらに探る

長い形式のテキストを人間が書く際には、通常、最初に全体の構造やアウトラインを計画し、その後、詳細を肉付けしていくというアプローチを取ります。この階層的なプランニングは、一貫性があり、論理的に整理された文章を作成するために有効です。同様に、LCMsにおいても、明示的なプランニング機構を導入することで、より人間らしい、自然な文章生成が実現できる可能性があります。ここでは、その可能性についてさらに詳細に説明します。

従来の課題と解決策

- 課題:

- 長い形式のテキスト生成において、一貫性や論理的な展開を維持するのが難しい。

- 従来のモデルでは、局所的な文脈のみに基づいて次のトークンを予測するため、大局的な視点からの制御が困難。

- 解決策:

- 明示的なプランニング機構の導入により、生成プロセスをより制御しやすくする。

- 高レベルの概要(プラン)を最初に生成し、それを基に詳細な文章を生成する階層的アプローチを採用する。

プランニングの手法

論文では、以下の2つのプランニング手法が紹介されています。

- アウトライン作成 (Li et al., 2024):

- 生成されるテキストの主要なポイントやセクションの見出しなど、高レベルの概要を作成する。

- Li et al., 2024 では、物語生成タスクにおいて、アウトラインを用いることで、一貫性と品質が向上することが示されている。

- 将来の要約作成 (Sun et al., 2022):

- モデルが後で拡張できるような、将来のテキストの要約を生成する。

- Sun et al., 2022 では、要約を条件付けることで、生成されたテキストの関連性と情報性が向上することが示されている。

LCMsにおけるプランニングの実装

LCMsでは、以下の図に示すように、プランニングモデルと生成モデルを組み合わせたアーキテクチャを採用することで、明示的なプランニングを実現します。

具体的には、以下の手順で文章が生成されます。

- プランニングモデルが、それまでのコンテキストに基づいて、次に生成すべき内容の計画(例:段落のトピックや要約)を生成する。

- 生成モデル(LCM)は、元のコンテキストと、プランニングモデルが生成した計画の両方を条件として、次の文(概念)を生成する。

- 生成された文は、コンテキストに追加され、次の計画と文の生成に使用される。

- このプロセスを繰り返すことで、計画に基づいた一貫性のある文章が生成される。

実験結果と考察

論文では、簡略化された単一モデルのアプローチ(Large Planning Concept Model: LPCM)を用いて、明示的プランニングの効果を検証しています。LPCMは、次の文の予測に加えて、次の段落の計画も予測するようにトレーニングされています。実験の結果、LPCMは、ベースラインのLCMと比較して、以下のような点で優れていることが示されました:

- 一貫性スコアの向上: LPCMは、Llama-3.1-8B-ITを用いて評価された一貫性スコアで、ベースラインのOne-Tower LCMよりも高いスコア(2.82 ± 0.62 対 2.74 ± 0.70)を達成。

- 人間による評価との高い相関: LPCMの一貫性スコアは、Jwalapuram et al. (2022) のデータセットを用いた人間による評価とも高い相関(Krippendorff’s α = 0.48)を示す。

これらの結果は、LCMsにおける明示的プランニングの有効性を示唆しており、今後の研究でさらに探求されるべき有望な方向性と言えるでしょう。特に、より洗練されたプランニングモデルの開発や、プランニングと生成のより高度な統合方法を探求することが、今後の課題として挙げられます。

LCMsの今後の展望:課題と可能性

埋め込み空間の選択と設計に関する課題:より良い空間を求めて

LCMsのアプローチにおいて、埋め込み空間の選択と設計は重要な役割を果たします。SONARの埋め込み空間は、優れた多言語およびマルチモーダル表現と、翻訳と自動エンコーディングの両方で優れた結果を達成する大規模な多言語デコーダの利用可能性のために選択されました。しかし、SONARモデルは、非常に特定のトレーニングデータ、つまりかなり短い文を含むバイテキスト機械翻訳データでトレーニングされていました。これにはいくつかの結果が伴います。具体的には、以下の点が課題として挙げられます。

- 局所性と大域性のバランス: SONARは、幾何学的に近い意味を持つ文が局所的な幾何学を維持するようにトレーニングされていますが、大まかに関連するだけの文については特別な保証がありません。しかし、次の文の分布を予測するには、空間がグローバルにうまく機能する必要があります。つまり、文間の意味的な関連性を大域的に捉え、適切な距離関係を維持することが求められます。

- 特異なテキストへの対応: SONARは、リンク、参照、または単なる数字やコードデータを含むテキストを驚くほどうまく自動エンコードします。しかし、そのようなテキストは脆弱である傾向があり、SONARのトレーニングデータと一般的に使用されるLLMの事前トレーニングテキストコーパスとの間の分布の不一致を浮き彫りにしています。したがって、そのようなコンテンツを含む文の正確な予測(LCMの事前トレーニングデータでは無視できない)は、SONARベースのLCMモデルにとっては難しいでしょう。たとえば、脆弱な生成された文の事実は簡単に損なわれる可能性があります。

- 凍結されたエンコーダの限界: 異なるデータコンテキストで学習され、LCMモデリングへの強い事前接続がない凍結されたエンコーダは、エンドツーエンドで学習されたエンコーダ(デコーダからの損失を伴う)と比較して最適ではない可能性があります。同時に、エンドツーエンドのトレーニング内でエンコーダを学習することは困難な場合があり、結果として得られる空間は、言語やモダリティ間で共有される優れた意味表現をもたらすとは限りません。概念表現とLCMをエンドツーエンドでトレーニングすることは、すべてのモデリングデータが多言語およびマルチモーダルである必要があるため、データと計算効率も低下し、モダリティの競合のリスクが生じます。

これらの課題を克服するためには、LCMsのタスクにより適した埋め込み空間の設計や、エンコーダとLCMを共同でトレーニングする方法論の開発が重要な研究課題となります。例えば、より多様なドメインやタスクを含むデータセットでエンコーダをトレーニングすることや、埋め込み空間に明示的な構造を導入することなどが考えられます。

さらに、以下の式は、この節で言及されている脆さ(fragility)を定量化するための式です。

fragility(w) := −E_{α∼U([0,1]), ε∼N(0,I)} [score(w, w_{α,ε})]

x_{α,ε} = denormalize (√1 − α normalize(x) + √α ε)

w_{α,ε} = decode(x_{α,ε})ここで、xはテキストの断片wのSONARコード、normalizeとdenormalizeは正規化および非正規化演算子、scoreは摂動されたテキストと元のテキストの類似度を測る関数です。

概念の粒度と抽象化レベルの最適化:より柔軟な概念表現へ

現在、LCMsでは「概念」を文レベルで定義していますが、これは必ずしも最適な粒度であるとは限りません。より柔軟な概念表現を実現するためには、以下の点を考慮し、改善する必要があります。

課題

- 文の長さのばらつき:

- 長い文は複数の概念を含む可能性があり、単一の埋め込みで表現するには限界がある。

- 短い文は情報量が少なく、曖昧性が高くなる可能性がある。

- データのスパース性:

- 文レベルの「概念」は多様性が高く、同じ「概念」が繰り返し出現する頻度が低い。

- 特に、学習データに少ない表現は、学習が不十分になる可能性がある。

- 固定された概念の粒度:

- 現在の文レベルという固定された粒度では、多様なテキスト構造や内容に柔軟に対応できない。

解決策の方向性

- より細かい粒度の導入:

- 文よりも短い単位(例:節、句)で「概念」を定義することで、長い文に含まれる複数の概念を適切に表現する。

- 例:

- 文:「犬がボールを追いかけて、公園を走っている。」

- 節:「犬がボールを追いかけて」「公園を走っている」

- より粗い粒度の導入:

- 複数の文をまとまりとして扱い、段落やセクションなど、より大きな単位で「概念」を定義することで、文脈情報をより豊かに捉える。

- 例:

- 文:「犬がボールを追いかけている。楽しそうに走っている。」

- 段落:「犬がボールを追いかけている。楽しそうに走っている。」(2つの文をまとめて1つの概念とする)

- 可変的な粒度の導入:

- 文脈に応じて、動的に「概念」の粒度を調整することで、より柔軟な表現を可能にする。

- 例:

- 複雑な内容を扱う場合は、細かい粒度で「概念」を定義する。

- 大局的な要約を生成する場合は、粗い粒度で「概念」を定義する。

- 階層的な概念表現:

- 「概念」を階層的に表現することで、異なる抽象化レベルの情報を同時に扱う。

- 例:

- 低レベル:「犬」「ボール」「走る」(単語レベル)

- 中レベル:「犬がボールを追いかける」「公園を走る」(句レベル)

- 高レベル:「犬が公園で遊んでいる」(文レベル)

これらの解決策を導入することで、LCMsはより多様なテキスト構造や内容に柔軟に対応できるようになり、文脈に応じた適切な粒度で情報を処理することが可能になると考えられます。今後の研究では、これらの解決策を具体的に実装し、その効果を検証することが重要です。

連続表現と離散表現のトレードオフ:より良いモデリング手法の探求

LCMsでは、概念を連続的な埋め込みベクトルとして表現していますが、これは従来の離散的なトークン表現とは対照的です。それぞれに利点と課題があり、トレードオフの関係にあります。ここでは、そのトレードオフを整理し、より良いモデリング手法を探求するための指針を示します。

連続表現(埋め込みベクトル)の利点と課題

- 利点:

- 意味の類似性を捉えやすい: 近いベクトルは意味的に近い概念を表す。

- 柔軟な表現: 離散的なトークンでは表現しきれない微妙な意味の違いを表現できる。

- 汎化性能の向上: 未知の単語や表現に対しても、意味的に近い既知の表現から推測できる。

- 課題:

- 学習の難しさ: 連続空間上での最適化は、離散空間と比較して難しい場合がある。

- 解釈性の低さ: ベクトルが何を意味するのか直感的に理解するのが難しい。

- 計算コストの高さ: 特に、高次元のベクトルを扱う場合、計算コストが高くなる。

離散表現(トークン)の利点と課題

- 利点:

- 明確な意味: 各トークンが明確な意味を持つ(例:単語、文字)。

- 学習のしやすさ: クロスエントロピー損失など、最適化手法が確立されている。

- 計算効率: 離散的な処理は、連続的な処理よりも効率的な場合が多い。

- 課題:

- 意味の類似性の捉えにくさ: 離散的なトークンでは、意味の類似性を表現しにくい(例:「犬」と「イヌ」は異なるトークンとして扱われる)。

- 語彙の制限: 未知語や新語に対応するのが難しい。

- 柔軟性の低さ: 離散的なトークンでは、微妙な意味の違いを表現しにくい。

解決策の方向性

これらのトレードオフを踏まえ、以下の解決策が考えられます。

- ハイブリッド表現:

- 連続表現と離散表現を組み合わせることで、両者の利点を活用する。

- 例:

- Huang et al., 2020 の INSET アーキテクチャでは、文のエンコードに固定サイズのベクトルを使用し、デコードには離散的なトークンを使用。

- Ye et al., 2024 では、離散拡散を言語モデルに適用し、複数ステップの計画を必要とするタスクに適した、非自己回帰的な生成の代替手段を提案。

- 離散表現の強化:

- 離散表現の意味表現力を高めることで、連続表現の必要性を低減する。

- 例:

- Yin et al., 2024 の Semformer では、将来のトークンについて情報を与える特別なプランニングトークンを含めることで、トランスフォーマー言語モデルが複数ステップ先を計画できるようにトレーニングすることを提案。

- 連続表現の改善:

- 連続表現の学習方法やアーキテクチャを改善することで、その有効性を高める。

- 例:

- Assran et al., 2024 の I-JEPA や Bardes et al., 2024 の V-JEPA など、Joint Embedding Predictive Architecture (JEPA) は、埋め込み空間で次の状態を予測するという考え方を、自己教師あり表現学習として画像や動画に適用。

- An et al., 2024 の SentenceVAE は、入力と出力の埋め込み空間を結び付けないため、推論は各予測文をテキストにデコードしてから、コンテキストに追加するために再エンコードすることによってのみ可能。

- Zhang et al., 2023 の PLANNER アーキテクチャは、段落の変分オートエンコーダと、テキストコンテキストまたはクラスラベルを条件として潜在オートエンコーダ表現を予測するようにトレーニングされた拡散モデルで構成。

- Lovelace et al., 2024 は、デコーダのみの言語モデルを、継続テキストのエンコードされた意味提案で拡張し、簡単にガイド可能な拡散モデルが次の提案の埋め込みを予測。

- Shabalin et al., 2024 の TEncDM モデルは、コンテキスト化されたトークン埋め込みの空間で拡散を実行し、その後、非自己回帰的にデコード。

これらの解決策を組み合わせることで、連続表現と離散表現のトレードオフを克服し、より効果的な言語モデリング手法を開発できる可能性があります。今後の研究では、これらの方向性をさらに探求し、LCMsの性能向上につなげることが期待されます。

アブレーション実験の詳細:モデル設計の妥当性検証

LCMのアーキテクチャの設計上の選択肢を検証するために、16億パラメータのモデルを用いて一連のアブレーション実験が行われました。具体的には、ベースラインとなるMSE回帰モデル(Base-LCM)、2種類の拡散ベースモデル(One-Tower LCMとTwo-Tower LCM)、および量子化ベースのモデル(Quant-LCM)の性能が比較されました。これらのモデルは、Fineweb-eduデータセットを用いて25万ステップの事前学習が行われました。

評価指標

評価は、教師ありモードでの次文予測の質に基づいて行われました。使用された指標は以下の通りです。

- L2距離: 予測された埋め込みと正解の埋め込みの間のユークリッド距離

- 往復L2距離: 予測された埋め込みをデコードして再エンコードした後の埋め込みと、正解の埋め込みの間のユークリッド距離

- 対比精度(CA): 予測された埋め込みよりも正解の埋め込みの方が近いサンプルの割合

- 言い換え(PAR): 生成された埋め込みとコンテキストの埋め込みとの間の最大コサイン類似度を、正解の文のスコアで正規化したもの

- 相互情報量(MI): GPT-2を用いて推定された、次の予測文と前の10個の正解文との間の相互情報量

主な結果

- 拡散ベースのモデルとQuant-LCMは、学習目標が大きく異なるにもかかわらず、類似したL2距離と往復L2距離を示した。

- Base-LCMは、他のモデルよりも大幅に低いL2距離を示したが、往復L2距離は他のモデルと比較して改善されておらず、これは、Base-LCMが、多くの可能な次の文の平均を生成し、それがSONAR空間内のどの関連するポイントにも対応していない可能性があることを示唆している。また、Base-LCMは、CAとMIのスコアが低く、この仮説を裏付けている。

- 拡散ベースのモデル間では、One-TowerとTwo-Towerの間に一貫した差は見られなかった。

- Quant-LCMは、拡散ベースのモデルと比較して、一貫して低いMIスコアを示したが、それでもBase-LCMよりは優れていた。

- Quant-LCM-cはQuant-LCM-dよりも優れた性能を示した。これは、クロスエントロピー損失を用いたコードブックインデックスの予測が、MSE目的関数よりも難しく、Quant-LCM-cが次の文の埋め込みのために左コンテキストベクトルの組み合わせをより簡単に学習できるためと考えられる。

追加実験

- ファインチューニング: 命令チューニング後のモデルの性能を評価するために、Cosmopediaのストーリーサブセットを用いてファインチューニングを実施。

- 結果: ROUGE-LとCoherenceのスコアが、事前学習の評価で得られたMIスコアの順序と相関。具体的には、Quant-LCMは拡散ベースのモデルに劣り、両者ともBase-LCMを大幅に上回った。また、同じトレーニングデータとファインチューニングデータを用いた小規模なLlamaモデル(SmallLlama)は、両方の指標でLCMを上回った。

結論

これらの結果は、拡散ベースのアプローチが、LCMのアーキテクチャとして有望であることを示唆しています。しかし、現時点では、従来のLLMには及ばないことも示されました。特に、Base-LCMの性能が低いことは、埋め込み空間における単純なMSE回帰の限界を示しています。一方、拡散ベースのモデルは、より多様で自然な文を生成できる可能性を示しています。また、量子化ベースのアプローチは、離散表現と連続表現のトレードオフを克服する可能性を示唆していますが、さらなる改善が必要です。これらの実験結果は、今後のLCMの研究開発において、モデルのアーキテクチャや学習方法を検討する上で、貴重な指針となるでしょう。

SONAR空間の脆さに関する分析:信頼性の高い埋め込み表現に向けて

潜在空間でモデリングを行う場合、主に誘導された幾何学(L2距離)に依存します。しかし、任意の潜在表現の均質なユークリッド幾何学は、基礎となるテキストの意味と完全には一致しません。これは、埋め込み空間でのわずかな摂動が、デコード後の意味情報の劇的な損失をもたらす可能性があるという事実によって証明されます。このような埋め込みを「脆弱」と呼びます。このため、LCMのトレーニングデータの品質と、この脆さがLCMのトレーニングダイナミクスをどのように妨げるかを理解するために、意味埋め込み(すなわちSONARコード)の脆さを定量化することを目指します。

テキストの断片wとそのSONARコードx = encode(w)が与えられたとき、wの脆さを次のように定義します。

fragility(w) := −E_{α∼U([0,1]), ε∼N(0,I)} [score(w, w_{α,ε})] ・・・ 式1

x_{α,ε} = denormalize (√1 − α normalize(x) + √α ε) ・・・ 式2

w_{α,ε} = decode(x_{α,ε}) ・・・ 式3上記の式において、xはテキストの断片wのSONARコード(式2中のencode(w)で算出)です。normalizeとdenormalizeは、正規化および非正規化演算子です。「エンコード」操作はテキストの断片をSONAR空間にマッピングし、「デコード」操作はSONAR空間内の与えられたベクトルからテキストの断片を生成します。[0, 1]の各αについて、x_{α,ε}はxの摂動バージョンであり、分散αのノイズベクトルがxと線形結合されます。摂動されたベクトルは、次にテキストの断片w_{α,ε}にデコードされます。この摂動は、拡散LCMで使用される分散保持ノイズ化(セクション2.3.2を参照)に似ています。

式1の「スコア」演算子は、摂動されたテキストw_{α,ε}を元のwと比較する意味的類似性メトリックであるように設定されます。以下のオプションが検討されました。

- 自動エンコーディングBLEU: score(w, w_{α,ε}) = BLEU(w, w_{α,ε})

- 外部コサイン類似度: 外部テキストエンコーダ(SONARとは無関係)がテキストの断片wをencode_{ext}(w)にエンコードすると仮定すると、score(w, w_{α,ε}) = CS(encode_{ext}(w), encode_{ext}(w_{α,ε}))となります。ここで、CSはコサイン類似度です。自動エンコーディングBLEUと比較して、この方法は通常、言い換えに対してより堅牢です。

この脆さ分析のテストベッドとして、新しい英語テキスト用のSONARデコーダが、事前トレーニングデータのサンプルでファインチューニングされました。LCMから生成された不完全な埋め込みに対するデコーダの堅牢性を向上させるために、式2に従い、トレーニング中にSONARの埋め込みにランダムなノイズベクトルを追加します。以下の表に示すように、ファインチューニングされたSONARデコーダは、さまざまな公開コーパスで優れたパフォーマンスを示しています。

| モデル | Flores | CNN DailyMail | Gutenberg | C4 |

|---|---|---|---|---|

| ベースSONARデコーダ | 79.5 | 75.9 | 70.5 | 75.7 |

| ファインチューニングされたSONARデコーダ | 88.0 | 87.6 | 85.6 | 87.5 |

表中の数値は、各データセットからランダムに抽出した1万文(Floresはdevセット全体)に対する自動エンコーディングBLEUスコアを表しています。

5000万個のランダムなテキストの断片をサンプリングし、各サンプルについて、異なるノイズレベルα∈[0.1, 0.2, …, 0.9]に対応する9つの摂動を生成しました。外部コサイン類似度メトリックには、外部エンコーダとしてMGTEを使用しました(Zhang et al., 2024)。

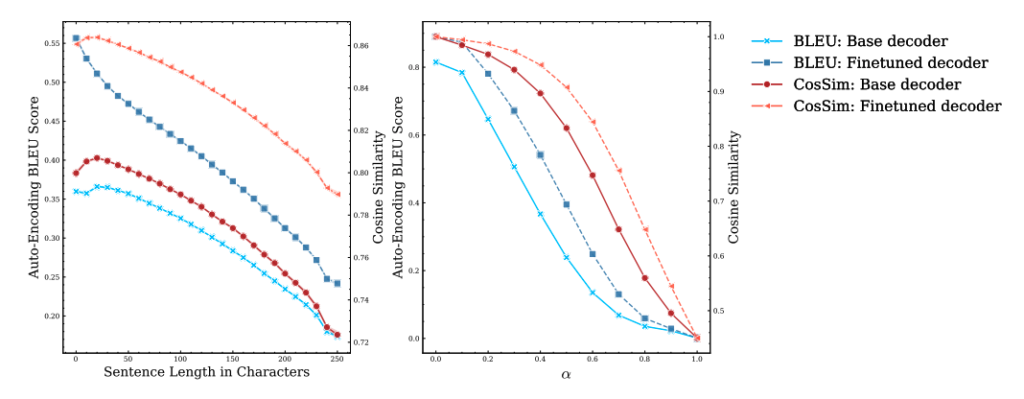

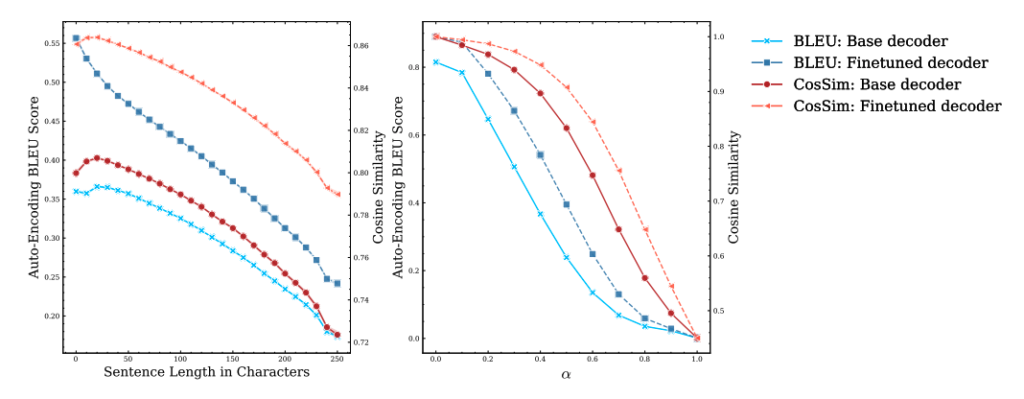

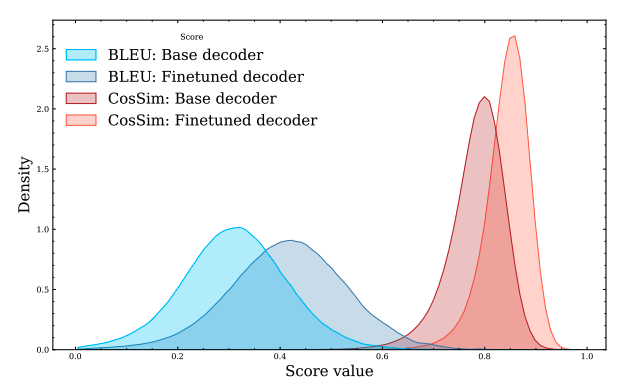

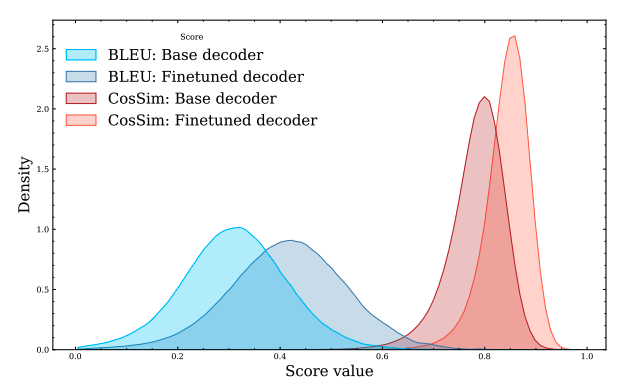

以下のグラフは、ノイズレベルαに関する両方のスコア関数の曲線が示されています。BLEUスコアはコサイン類似度よりも速く低下することがわかります。最も重要なことは、脆さスコアはデコーダの選択に敏感であるということです。特に、自動エンコーディングBLEUとコサイン類似度スコアの両方が、ノイズの量が増加するにつれて、ベースのデコーダよりもファインチューニングされたデコーダの方が著しく緩やかに減少します。

また、以下に示すすべてのαで平均化した後の全体的なスコア分布は、SONARサンプル全体で脆さスコアが大きく広がっていることを示しています。

このような不一致を説明できる要因の1つは、テキストの長さです。長い文の場合に1〜2%しか低下しない自動エンコーディングBLEUメトリックと比較して、脆さは文の長さに対してより敏感であり、両方の類似性メトリックでより速く低下します。これは、250を超える最大文長を使用すると、SONARとLCMモデルにとって非常に困難になる可能性があることを示しています。一方、短い文は平均してより堅牢ですが、長い文を間違った場所で分割すると、より短いがより脆弱な部分文が生じる可能性があります。

最も脆弱な5%の埋め込みを詳しく見ると、それらが非常にノイズが多いことがわかります。通常、それらはハイパーリンク、参照、一意のID、コードスイッチ、または数値エントリに対応しています。これらは、SONARモデルがトレーニング中に公開されなかったアーティファクトであるか、SONARトークナイザが失敗した場所である可能性があります。したがって、脆さは、トレーニングデータから難しいサンプルを除外するために使用できます。また、短いが複雑な技術的フレーズは、同じ長さの一般的な言語フレーズよりも脆弱である可能性があることもわかります。