こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

最近、AI業界で注目を集めている「Performance of DeepSeek-R1」。このモデルは、OpenAIのChatGPT-4やAnthropicのClaude-3.5-Sonnetに匹敵する、さらにはそれ以上の性能を発揮すると噂されています。特に、費用対効果の高さが際立っており、低コストながら高性能な推論モデルを求める多くの研究者や開発者にとって魅力的な選択肢となっています。では、なぜ「Performance of DeepSeek-R1」がこれほど注目されているのでしょうか?

この記事では、「Performance of DeepSeek-R1」の技術的な詳細や、OpenAI o1との比較、そしてその優れた性能を実現する要因について詳しく解説します。

Performance of DeepSeek-R1:DeepSeek-R1とは?

まず、DeepSeek-R1について知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:DeepSeek-R1 : 最大6710億パラメータで推論能力を飛躍的に向上させたAI

まず、DeepSeek-R1について知りたいという方は、ぜひこちらの記事を先にご覧ください。

関連記事:DeepSeek v3 の実力と活用法:6710億パラメータのオープンソースMoEモデル

Performance of DeepSeek-R1の概要

「Performance of DeepSeek-R1」は、中国のAIスタートアップDeepSeekが開発したオープンソースの推論モデルであり、DeepSeek-AIの技術を基盤としています。DeepSeek-AIは、AIシステムの問題解決能力と分析能力の向上に特化しており、DeepSeek-R1はその最新成果として位置付けられています。特筆すべきは、このモデルがOpenAIのChatGPT-4やAnthropicのClaude-3.5-Sonnetと同等、あるいはそれ以上の性能を有しながらも、開発コストを大幅に削減している点です。これにより、高性能なAI推論モデルをより身近な存在とすることに成功しています。

DeepSeek-R1は、特に数学的推論や創造的なタスクにおいて優れた性能を発揮しており、MATH-500やAlpacaEval 2.0といったベンチマークで高いスコアを記録しています。また、オープンソースとして提供されているため、研究者や開発者が自由にアクセスし、改良を加えることが可能です。このような特徴が、DeepSeek-R1をAI業界で注目される存在に押し上げています。

Performance of DeepSeek-R1の特徴

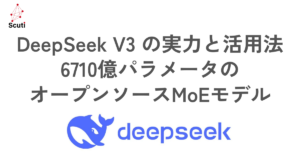

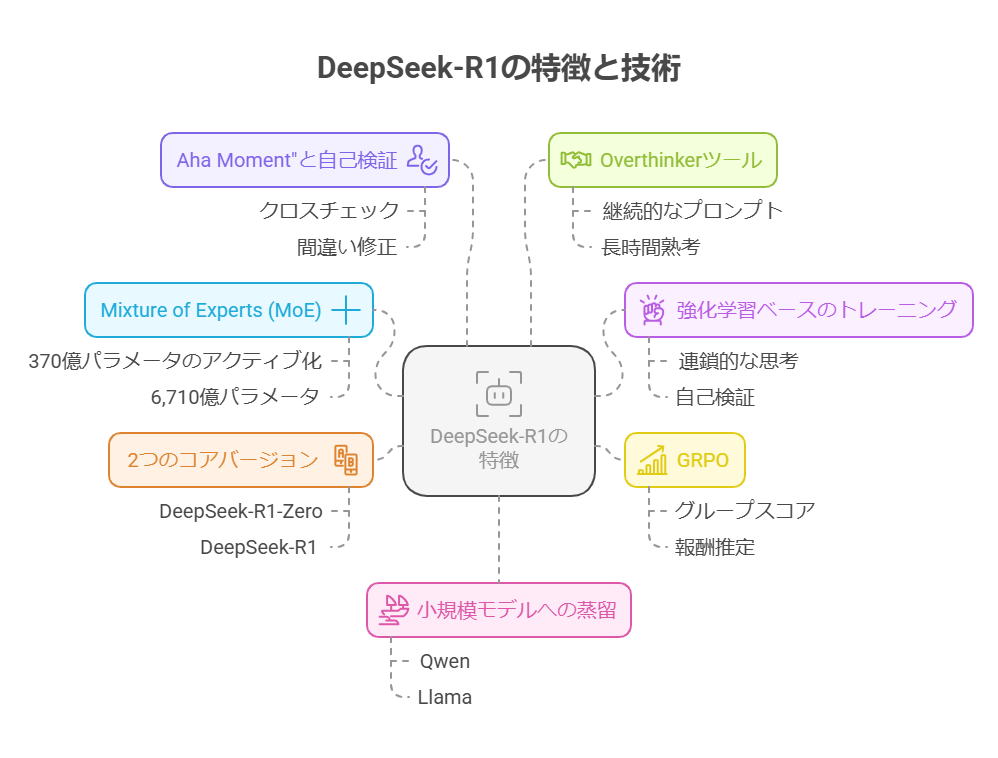

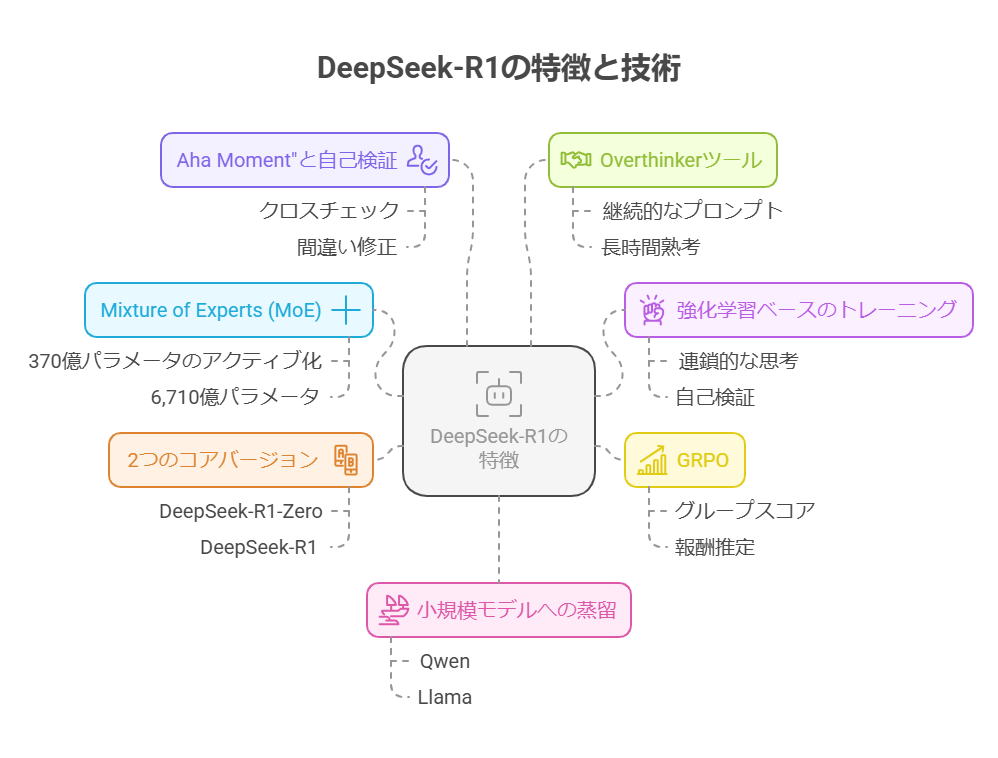

「Performance of DeepSeek-R1」は、他の主要なAIモデルと比較して以下のような際立った特徴を備えています:

- Mixture of Experts (MoE)アーキテクチャ: DeepSeek-R1は、6,710億のパラメータを持つMoE設計を採用しており、フォワードパスごとに370億のパラメータのみをアクティブ化します。この設計により、効率的な計算とリソースの使用が可能となっています。

- 強化学習 (RL) ベースのトレーニング方法: 深い推論能力を自律的に開発するために、DeepSeek-R1はRLを基盤としたトレーニング方法を採用しています。これにより、連鎖的な思考(Chain-of-Thought)推論や自己検証が可能となり、高度な推論能力を実現しています。

- GRPOを用いた強化学習: グループ相対ポリシー最適化(GRPO)を用いることで、従来の批評家モデルを使用する代わりに、グループスコアに基づいて報酬を推定し、学習効率を向上させています。

- 2つのコアバージョン: DeepSeek-R1には、「DeepSeek-R1-Zero」と「DeepSeek-R1」の2つのコアバージョンが存在します。R1-Zeroは教師ありファインチューニングを一切行わず、強化学習のみでトレーニングされており、R1はその上にコールドスタートフェーズと多段階RLを追加することで、推論能力と可読性を向上させています。

- 「Aha Moment」と自己検証: R1-Zeroは自己検証機能を備えており、回答をクロスチェックし、自分の間違いを修正する能力を持っています。これにより、モデルは自己反省的な行動を取ることが可能です。

- 「Overthinker」ツール: R1モデル用に開発された「overthinker」ツールを使用することで、ユーザーは思考の連鎖を拡張し、モデルの推論能力をさらに向上させることができます。このツールは、継続的なプロンプトを注入することで、モデルに長時間熟考させる仕組みを提供します。これにより、複雑な問題に対する深い洞察を得ることが可能となります。

- 小規模モデルへの蒸留: DeepSeek-R1の強力な推論能力は、小規模で効率的なモデル(例:QwenやLlama)への蒸留により、計算効率の高い形で展開可能となっています。

Performance of DeepSeek-R1:OpenAI o3との比較

Performance of DeepSeek-R1とOpenAI o3のパフォーマンス比較

「Performance of DeepSeek-R1」とOpenAIのo3はどちらも優れた推論能力を持つモデルですが、その性能と特性にはいくつかの重要な違いがあります。まず、o3は一般的にコーディングベンチマークでDeepSeek-R1を上回る結果を示しており、Codeforcesではより高いEloレーティングを達成しています。また、SWE-bench Verifiedでもo3の方が良好なスコアを記録しています。

これに対し、DeepSeek-R1は数学と推論のベンチマーク、特にMATH-500において競争力のあるパフォーマンスを発揮しており、97.3%のPass@1スコアを記録しています。このことから、DeepSeek-R1は数学的推論問題の処理において優れた能力を持つことが示唆されます。

さらに、DeepSeek-R1は創造的なタスクにおいても高い評価を得ています。例えば、AlpacaEval 2.0では87.6%、ArenaHardでは92.3%の勝率を達成しており、これらの分野での優位性が際立っています。一方で、o3は複雑なコーディングタスクにおいて優れた性能を発揮しており、用途に応じた使い分けが重要となります。

オープンソースであることの意義

「Performance of DeepSeek-R1」がオープンソースであることは、AIコミュニティにとって非常に重要な意味を持ちます。具体的には以下のような利点があります:

- アクセシビリティと費用対効果: オープンソースで提供されることにより、研究者や開発者は高性能なAIモデルに低コストでアクセスできるようになります。これにより、AI技術の民主化が進み、さまざまな分野でのイノベーションが促進されます。

- コミュニティ主導の開発: オープンソースプロジェクトとして、世界中の研究者や開発者が協力してモデルの改良や最適化を行うことが可能です。この共同作業により、特定のニーズに合わせたバージョンの開発が加速し、モデルの適応性と柔軟性が向上します。

- 透明性と信頼: コードとトレーニングデータが公開されていることで、モデルの能力や限界に対する透明性が確保されます。これにより、ユーザーはモデルの内部動作を理解しやすくなり、より責任ある倫理的なAI開発が推進されます。

Performance of DeepSeek-R1:優れた性能を実現する要因

Performance of DeepSeek-R1の訓練方法の革新

「Performance of DeepSeek-R1」の高い性能は、その革新的な訓練方法に大きく起因しています。従来のモデルは大量の教師データと教師ありファインチューニング(SFT)に依存していましたが、DeepSeek-R1はこれから一歩進んだアプローチを採用しています。具体的には、DeepSeek-R1-Zeroでは初期のSFTを完全に排除し、大規模な強化学習(RL)のみを使用してモデルを訓練しています。

この方法は、子供に段階的な指示を与えるのではなく、試行錯誤を通じてパズルを解く方法を学ばせる教育手法に似ています。その結果、DeepSeek-R1-Zeroは自己検証や反省といった高度な推論能力を自律的に発展させることができました。この革新により、コストのかかる教師データへの依存度が大幅に減少し、時間と費用の両面で効率的な訓練が可能となりました。

Performance of DeepSeek-R1のアーキテクチャの工夫

「Performance of DeepSeek-R1」の成功のもう一つの重要な要因は、その独自のMixture of Experts (MoE)アーキテクチャにあります。従来のAIモデルは、すべてのタスクに対して全パラメータをアクティブ化していましたが、DeepSeek-R1はこれを改良し、6,710億のパラメータの中から関連するサブセットのみをアクティブ化する仕組みを採用しています。これは、専門家のチームを編成し、適切な専門家のみが特定の問題に取り組むようなものです。

この選択的なアクティブ化により、メモリ使用量と計算要求が大幅に削減され、DeepSeek-R1は限られたハードウェアリソースで複雑なタスクを効率的に処理することが可能となりました。例えば、ChatGPTは1万個のハイエンドGPUを必要とすると言われていますが、DeepSeek-R1はわずか2,000個のGPUで同等の結果を達成しています。この最適化されたアーキテクチャが、DeepSeek-R1の高性能とコスト効率を支える基盤となっています。

Performance of DeepSeek-R1のオープンソースによるコラボレーション

「Performance of DeepSeek-R1」は、オープンソースとして提供されていることも大きな特徴です。MITライセンスの下でリリースされたこのモデルは、世界中の研究者や開発者が自由にアクセスし、研究・改良・強化を行うことが可能です。このオープンソースの利点として、以下の点が挙げられます:

- 多様な視点からの改良が可能となり、モデルの性能向上が加速します。

- 特定の分野や用途に特化したバージョンの開発が容易になります。

- コミュニティによる迅速なフィードバックとバグ修正が実現します。

これにより、DeepSeek-R1は単なるモデル以上の存在となり、AI技術の進歩と普及に貢献しています。オープンソースとしての協調的な開発精神は、AI技術の民主化を促進し、独自システムの開発にかかる高コストを排除する役割も果たしています。これにより、世界中のAI愛好家が共同で技術を発展させることが可能となり、イノベーションのスピードが飛躍的に向上しています。

Performance of DeepSeek-R1の戦略的なリソース最適化

「Performance of DeepSeek-R1」の成功には、戦略的なリソース最適化も欠かせません。DeepSeekチームは、米国の高度な半導体に対する輸出規制といった課題に直面しながらも、創意工夫によって効率を最大化するためのプロセスを再設計しました。具体的には、トレーニングパイプラインの最適化や既存のハードウェアの効果的な活用により、必要なリソースを最小限に抑えつつ、高い性能を維持しています。

結果として、DeepSeek-R1のトレーニング費用はわずか600万ドルと報告されており、これはMetaのLLaMAのような競合他社が数千万ドルから数億ドルを費やす中で、非常に低コストであることが強調されています。このようなコスト効率の高さは、トップレベルのAI技術が高額な費用を伴わずとも実現可能であることを示しています。

まとめ:Performance of DeepSeek-R1の今後

「Performance of DeepSeek-R1」は、先進的な訓練方法、最適化されたアーキテクチャ、オープンソースによるコラボレーション、そして戦略的なリソース最適化を通じて、AI業界に新たな地平を切り拓いています。これにより、DeepSeek-R1はChatGPTやGeminiといった業界の巨人に対抗できるだけでなく、より効率的で手頃な価格のAI推論モデルとして、多くの研究者や開発者にとって魅力的な選択肢となっています。今後も「Performance of DeepSeek-R1」の進化とその影響に注目が集まることでしょう。

DeepSeek-R1とその蒸留バージョンは、Hugging FaceやDeepSeekの公式ウェブサイトなどで入手可能です。AIの未来はここにあり、よりスマートで効率的、かつアクセスしやすい形で私たちの手の届くところに広がっています。

本記事では「Performance of DeepSeek-R1」の技術的な詳細や、OpenAI o1との比較、そしてその優れた性能を実現する要因について詳しく解説します。弊社では、より柔軟で多様な業界ニーズに対応した生成AIコンサルティングサービスを提供しています。生成AIを活用した業務効率化や新たな価値創出にお悩みの方はぜひご連絡ください。