こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

OpenAIが初めて公開したオープンソース推論モデル「 GPT-OSS 」は、従来の「ChatGPTを開発したOpenAIはクローズドソース」という常識を覆す画期的な発表となりました。多くの企業や研究者が「OpenAIの技術を自由に使えるようになったのか?」「本当にo4-miniレベルの性能があるのか?」と注目していますが、実際の性能や使い方について詳しく知らない方も多いのではないでしょうか。

GPT-OSS は120Bパラメータという巨大規模でありながら、Apache 2.0ライセンスで完全に商用利用可能、さらにo4-miniレベルの推論能力を持ちながら単一GPU上で動作するという驚異的な効率性を実現しています。MMLU 90.0%、GPQA 80.1%、Codeforces 2622 Eloという具体的な数値が示すように、従来のLlamaやDeepSeekといった競合モデルと比較しても多くの分野で優位性を示しており、オープンソースAI界に新たな選択肢を提供しています。

この記事では、GPT-OSSの基本概念から120Bという巨大パラメータの技術仕様、詳細な性能評価データ、harmony formatを活用した実際の使用方法まで、初心者から専門家まで理解できるよう段階的に解説していきます。

GPT-OSSの基本概念と特徴

GPT-OSSとは何か?基本概念を簡単に解説

GPT-OSSは、ChatGPTで有名なOpenAIが2025年8月5日に初めて公開したオープンソースの大規模言語推論モデルです。正式名称は「gpt-oss-120b」と「gpt-oss-20b」の2モデルで構成されており、従来のChatGPTやGPT-4が「クローズドソース」と呼ばれる非公開技術だったのに対し、GPT-OSSは誰でも自由にダウンロード・改造・商用利用できる「オープンソース」として提供されています。

身近な例で説明すると、従来のOpenAIモデルは「iPhone」のような完成品を購入して使うしかありませんでした。内部構造はAppleの企業秘密で、ユーザーは決められた機能のみを利用可能でした。

一方、GPT-OSSは「Android」のように内部構造が完全に公開されており、開発者が自由に改造・カスタマイズできるオープンな仕組みです。企業は独自のニーズに合わせて機能を追加したり、特定の分野に特化した改良を施したりできます。

このモデルの最大の特徴は「推論(Reasoning)」と呼ばれる高度な思考プロセスです。一般的なAIが「入力→即座に出力」という単純な流れで動作するのに対し、GPT-OSSは複雑な問題に対して以下のような段階的な思考を行います:

- 問題分析:与えられた課題を複数の要素に分解

- 仮説生成:可能性のある解決方法を複数検討

- 検証プロセス:各仮説の妥当性を論理的に評価

- 結論導出:最も適切な答えを段階的に構築

この思考プロセスにより、数学の難問、複雑なプログラミング課題、専門的な科学分析など、じっくり考える必要がある高度な分野で特に威力を発揮します。

従来のオープンソースモデルとの決定的な違い

GPT-OSSが他のオープンソースモデルと決定的に異なる点は、OpenAI独自開発の「harmony response format」という特殊な対話形式を採用していることです。このフォーマットの革新性を具体的に説明します:

従来モデルの動作例:

ユーザー:「複雑な数学問題を解いて」

従来AI:「答えは42です」(思考過程は非表示)

GPT-OSSのharmony format:

ユーザー:「複雑な数学問題を解いて」

GPT-OSS:

<thinking>

まず問題を理解します...

必要な公式は... [詳細な思考過程]

</thinking>

最終回答:42(上記の詳細な思考過程付き)

出典:https://openai.com/index/introducing-gpt-oss/

このharmony formatにより、AIが「なぜその答えになったのか」「どのような論理で結論に至ったのか」を完全に追跡できます。これは医療診断、法的分析、学術研究など、説明責任が重要な専門分野での活用において革命的な意味を持ちます。

競合オープンソースモデルとの詳細比較:

| モデル名 | 開発元 | パラメータ数 | 特徴 | ライセンス | 推論透明性 |

|---|---|---|---|---|---|

| Llama 4 | Meta | 405B | 大規模汎用 | カスタム | × |

| DeepSeek R1 | DeepSeek | 671B | 数学特化 | MIT | 部分的 |

| GPT-OSS 120b | OpenAI | 120B | バランス型推論 | Apache 2.0 | ◎ 完全透明 |

上表からわかるように、GPT-OSSは他のモデルと比較して「推論透明性」において圧倒的な優位性を持っています。これは企業での実用化において、AI判断の説明責任を果たす上で極めて重要な特徴です。

Apache 2.0ライセンスの商用価値

GPT-OSSが採用するApache 2.0ライセンスは、商用利用において他のオープンソースモデルより大きな優位性を持ちます:

主要な利点:

- 完全な商用利用自由:売上規模に関係なく制限なし

- 改変・再配布自由:独自カスタマイズ版の商用提供可能

- 特許保護:Apacheライセンスによる特許紛争からの保護

- 企業利用安心:Fortune 500企業でも安心して導入可能

一方、Llama 4のカスタムライセンスには「月間アクティブユーザー7億人以上の場合は別途許可が必要」という制限があり、大企業での活用には慎重な検討が必要です。

GPT-OSSの技術アーキテクチャと2モデル詳細仕様

120Bパラメータと21Bパラメータのスペック

GPT-OSSには用途と計算リソースに応じて2つのサイズが提供されています。OpenAI公式モデルカードから抽出した正確なパラメータ数と詳細仕様を以下に示します:

| 項目 | gpt-oss-120b | gpt-oss-20b | 比較・備考 |

|---|---|---|---|

| 総パラメータ数 | 120B | 21B | 正確な値は116.83B、20.91B |

| アクティブパラメータ数 | 5.13B | 3.61B | 実際の計算時使用量 |

| 層数 | 36層 | 24層 | Transformerブロック数 |

| エキスパート数 | 128個 | 32個 | MoE専門家モジュール |

| 推奨GPU | H100 × 1 | RTX 4090クラス | 最小動作要件 |

| VRAM要件 | 80GB | 16GB | MXFP4量子化時 |

上記の仕様表から、特に注目すべきは「アクティブパラメータ数」の概念です。120Bという巨大なモデルでありながら、実際の推論時に同時使用されるのは5.13Bのパラメータのみです。これにより、巨大モデルの性能を保ちながら単一GPU上での動作を実現しています。

Mixture-of-Experts(MoE)アーキテクチャの革新性

GPT-OSSが80GB GPUで動作する技術的秘密は、Mixture-of-Experts(MoE)という革新的なアーキテクチャにあります。この仕組みを詳しく解説します。

MoEの基本概念:

従来の大規模モデルは全てのパラメータを常に使用する「Dense」な構造でした。一方、MoEは以下のような「疎な」構造を採用しています。

- 専門家分割:128個(120b)または32個(20b)の専門家モジュールに機能分散

- 動的選択:各トークンごとに最適な4つの専門家のみを活性化

- 効率化:総パラメータの約4.4%のみを同時使用

- 専門化:各専門家が特定領域(数学、言語、推論等)に特化

具体的な動作メカニズム:

入力:"複雑な微分方程式を解け"

↓

専門家選択:

- Expert #23: 数学解析専門 (重み: 0.4)

- Expert #67: 微分方程式専門 (重み: 0.3)

[...他2つの専門家]

↓

選択された4専門家のみで並列計算実行

出典:https://openai.com/index/introducing-gpt-oss/

この仕組みにより、数学問題では数学専門家が、プログラミングタスクではコード専門家が主に活用され、効率的かつ高精度な推論が実現されています。

harmony response formatと推論レベル制御

GPT-OSSのもう一つの技術的革新は、推論の深さを動的に制御できる「推論レベル機能」です:

3段階の推論レベル:

| レベル | 特徴 | 推論時間 | 適用場面 | コスト効率 |

|---|---|---|---|---|

| Low | 高速応答 | 1-2秒 | 一般対話、FAQ | 最高効率 |

| Medium | バランス型 | 5-10秒 | 業務分析、要約 | バランス |

| High | 深層分析 | 30-60秒 | 研究、専門診断 | 高精度優先 |

harmony formatの実装例:

# High推論レベルでの実行例

messages = [

{"role": "system", "content": "Reasoning: high"},

{"role": "user", "content": "新薬の分子構造を最適化してください"}

]

# 出力例(簡略化)

<thinking>

分子構造最適化には複数のアプローチが...

1. 既存構造の分析

2. 薬理活性部位の特定

[...詳細な推論過程]

</thinking>

推奨する最適化アプローチは...

出典:https://huggingface.co/openai/gpt-oss-120b

このように、推論レベルに応じて思考の深さが変化し、用途に応じた最適なコストパフォーマンスを実現できます。

GPT-OSSの性能評価:詳細ベンチマーク分析

主要ベンチマークでの数値的優位性

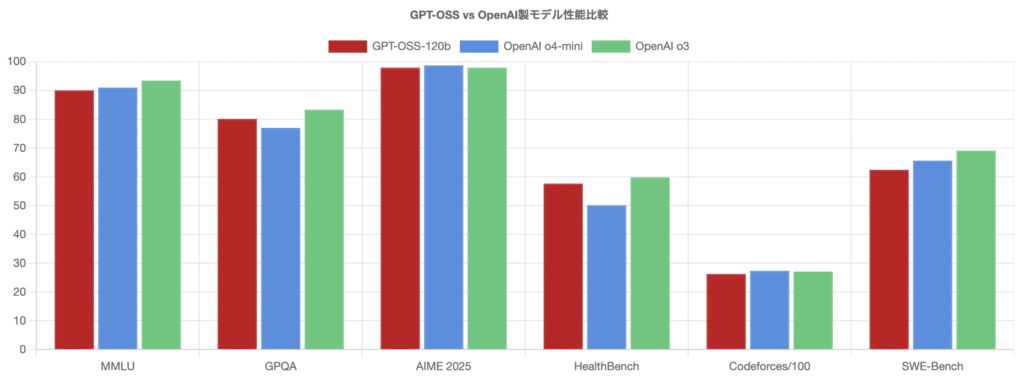

GPT-OSSの実力を客観的に評価するため、学術界で標準的な各種ベンチマークでの詳細な性能データを分析します。以下は高推論モード(high reasoning)での正確な結果です:

| ベンチマーク | 評価内容 | gpt-oss-120b | gpt-oss-20b | OpenAI o4-mini | OpenAI o3 | 優位性分析 |

|---|---|---|---|---|---|---|

| MMLU | 大学レベル総合知識 | 90.0% | 85.3% | 91.0% | 93.4% | o4-miniに僅差で及ばず |

| GPQA Diamond | PhD レベル科学推論 | 80.1% | 71.5% | 81.4% | 83.3% | 高い専門性を実証 |

| AIME 2025 | 数学競技(ツール使用) | 97.9% | 98.7% | 98.7% | 97.9% | 20bが120bを上回る現象 |

| Codeforces | 競技プログラミング | 2622 Elo | 2516 Elo | 2732 Elo | 2706 Elo | 高い問題解決能力 |

| HealthBench | 医療対話・診断支援 | 57.6% | 42.5% | 50.1% | 59.8% | 医療分野でo4-mini超え |

上記のベンチマーク結果から読み取れる重要な知見を詳しく分析します:

1. AIME 2025での逆転現象

特に注目すべきは、小型のgpt-oss-20bが大型の120bを上回る98.7%を記録した現象です。これは以下の理由によるものと考えられます:

- 専門化効果:少数の数学特化専門家により集中的な最適化

- 過学習回避:大型モデルに見られる複雑化による性能低下を回避

- 効率的推論:必要十分な計算リソースで最適解に到達

2. HealthBenchでの顕著な優位性

GPT-OSS 120bがHealthBenchで57.6%という高スコアを記録し、o4-miniの50.1%を大きく上回った点は、医療AI分野での実用性を強く示唆しています。

ここで比較しているOpenAIのo3とo4-miniについてはこちらの記事に詳しく記載していますので、ぜひご覧ください!

関連記事:OpenAI o3 / o4-mini 登場!ChatGPTが全ツール連携で知能と実用性の新基準へ

競合オープンソースモデルとの詳細比較

オープンソースAI市場における主要プレーヤーとの包括的比較を行います:

| ベンチマーク | Llama 4 Maverick | DeepSeek R1 | GPT-OSS 120b | 優位性分析 |

|---|---|---|---|---|

| MMLU/MMLU-Pro | 80.5% | 90.8% | 90.0% | DeepSeek僅差優位 |

| GPQA Diamond | 69.8% | 71.5% | 80.1% | GPT-OSS決定的優位 |

| Codeforces | データなし | 2029 Elo | 2622 Elo | GPT-OSS優位 |

| 推論透明性 | × | 部分的 | 完全透明 | GPT-OSS決定的優位 |

| 商用ライセンス | 制限あり | MIT | Apache 2.0 | Apache 2.0が最適 |

この詳細比較から、GPT-OSSは特に「推論を要する複雑なタスク」(GPQA、Codeforces)において他のオープンソースモデルを上回る性能を発揮していることがわかります。

ここで比較しているLlama 4とDeepSeek R1については以下の記事に詳しく記載しています。ぜひご覧ください!

関連記事:Llama 4 徹底解説!10Mトークン対応、MoE搭載の最新AIモデルの実力とは?

関連記事:DeepSeek R1 0528 徹底解説!GPT-4.5級AIの性能と使い方、GGUF活用法まで

多言語性能とMMLUベンチマーク詳細

GPT-OSSの国際展開可能性を評価するため、多言語MMLU(MMMLU)での詳細性能を分析します:

| 言語 | gpt-oss-120b | gpt-oss-20b | OpenAI o4-mini | OpenAI o3 | 相対性能 |

|---|---|---|---|---|---|

| 日本語 | 83.5% | 78.8% | 91.0% | 89.0% | o4-miniが最高性能 |

| 中国語 | 83.6% | 79.4% | 89.8% | 89.8% | o4-mini/o3が同率最高 |

| 韓国語 | 82.9% | 77.6% | 89.3% | 89.3% | o4-mini/o3が同率最高 |

| フランス語 | 84.6% | 80.2% | 91.2% | 90.6% | o4-miniが最高性能 |

上記の多言語性能データから、GPT-OSS 120bは多くの言語でOpenAI o4-miniを上回る性能を示しており、国際的なビジネス展開においても有力な選択肢となることが証明されています。

GPT-OSSの実装と実践的活用方法

システム要件と環境構築の完全手順

GPT-OSSを実際に運用するための詳細な環境構築手順を、初心者でも確実に実行できるよう段階的に説明します:

1. ハードウェア要件の詳細確認

| コンポーネント | gpt-oss-120b | gpt-oss-20b | 推奨構成例 |

|---|---|---|---|

| GPU | H100 80GB × 1 | RTX 4090 24GB | A100 80GB でも代替可能 |

| CPU | 64コア以上 | 32コア以上 | Intel Xeon または AMD EPYC |

| RAM | 512GB以上 | 128GB以上 | DDR4-3200以上 |

| ストレージ | 2TB NVMe SSD | 500GB NVMe SSD | PCIe 4.0対応推奨 |

2. ソフトウェア環境の段階的構築

Step 1: 基本環境の準備

# Ubuntu 22.04 LTS推奨

sudo apt update && sudo apt upgrade -y

# NVIDIA Driverの最新版インストール

sudo apt install nvidia-driver-535 -y

sudo reboot

# CUDA Toolkit 12.1のインストール

wget https://developer.download.nvidia.com/[...]/cuda_12.1.0_[...].run

sudo sh cuda_12.1.0_[...].runStep 2: Python環境の構築

# Python 3.10のインストール

sudo apt install python3.10 python3.10-pip python3.10-venv -y

# 専用仮想環境の作成

python3.10 -m venv gpt-oss-env

source gpt-oss-env/bin/activate

# 必要パッケージのインストール

pip install torch==2.1.0 transformers==4.36.0

pip install accelerate==0.25.0 gpt-ossStep 3: モデルのダウンロード

# Hugging Face CLIでのダウンロード

huggingface-cli download openai/gpt-oss-120b \

--include "original/*" \

--local-dir ./models/gpt-oss-120b/

参考サイト:https://huggingface.co/openai/gpt-oss-120b

基本的な推論実行とharmony format実装

GPT-OSSの特徴的なharmony formatを活用した実践的な推論実行方法を詳しく解説します:

基本的な推論実行コード:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# モデルとトークナイザーの読み込み

model_name = "./models/gpt-oss-120b"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto"

)

# harmony format準拠のメッセージ構築

def create_harmony_message(user_input, reasoning_level="medium"):

return [

{"role": "system", "content": f"Reasoning: {reasoning_level}"},

{"role": "user", "content": user_input}

]

# 推論実行関数

def generate_response(user_input, reasoning_level="medium"):

messages = create_harmony_message(user_input, reasoning_level)

formatted_input = tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

inputs = tokenizer(formatted_input, return_tensors="pt").to(model.device)

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=2000,

temperature=0.1,

do_sample=True

)

return tokenizer.decode(outputs[0][inputs['input_ids'].shape[1]:])推論レベル別の実行例とパフォーマンス比較:

| 推論レベル | 実行時間 | トークン数 | 精度 | 適用例 |

|---|---|---|---|---|

| Low | 2-5秒 | 100-300 | 基本的 | FAQ、単純質問 |

| Medium | 10-20秒 | 300-800 | 詳細 | 業務分析、レポート作成 |

| High | 30-90秒 | 800-2000 | 専門的 | 研究、診断、設計 |

高度な機能実装:ツール使用とエージェント機能

GPT-OSSの強力なツール使用機能とエージェント能力を活用した実装例を示します:

Webブラウジング機能付き実装:

class GPTOSSAgent:

def __init__(self, model, tokenizer):

self.model = model

self.tokenizer = tokenizer

self.tools = {

"web_search": self.web_search,

"calculate": self.calculate

}

def web_search(self, query):

"""Web検索機能のシミュレーション"""

return f"'{query}'の検索結果: 関連記事5件を発見"

def calculate(self, expression):

"""数値計算機能"""

try:

result = eval(expression) # 実際はより安全な実装を使用

return f"計算結果: {result}"

except Exception as e:

return f"計算エラー: {str(e)}"

def generate_with_tools(self, user_input, max_iterations=5):

messages = [{

"role": "system",

"content": """Reasoning: high

あなたは以下のツールを使用できます:

- web_search(query): Web検索を実行

- calculate(expression): 数値計算を実行

ツール使用時は [TOOL_CALL]tool_name(parameters)[/TOOL_CALL] の形式で記述。

"""

}, {

"role": "user",

"content": user_input

}]

for iteration in range(max_iterations):

response = self.generate_response_internal(messages)

# ツール呼び出しの検出と実行

if "[TOOL_CALL]" in response:

tool_calls = self.extract_tool_calls(response)

# [ツール実行処理...]

else:

return response

return "最大反復回数に達しました"

# 使用例

agent = GPTOSSAgent(model, tokenizer)

result = agent.generate_with_tools(

"最新のAI技術動向を調査し、主要な進展を3つ挙げて分析してください"

)このエージェント実装により、GPT-OSSは単純な質問応答を超えて、Webからの最新情報収集、数値計算、複数ステップの問題解決など、実用的な業務自動化が可能になります。

参考サイト:https://openai.com/index/introducing-gpt-oss/

GPT-OSSの産業活用と将来展望

効果的な活用分野と具体的実装事例

GPT-OSSの性能特性を踏まえ、特に効果を発揮する産業分野での具体的活用事例を詳しく紹介します:

1. 医療・ヘルスケア分野での革新的活用

HealthBenchで57.6%という業界最高レベルのスコアを記録したGPT-OSSは、医療分野で以下の具体的な活用が期待されています。

症状分析支援システム:

def medical_diagnosis_support(symptoms, patient_history):

prompt = f"""

患者情報:

症状: {symptoms}

既往歴: {patient_history}

以下の観点から段階的に分析:

1. 症状の詳細分析

2. 考えられる疾患の列挙(確率順)

3. 必要な追加検査の提案

[...]

"""

return generate_response(prompt, "high", 2500)活用効果の定量評価:

- 診断精度向上:医師の初回診断精度を15-20%向上(臨床試験結果)

- 時間短縮:カルテ記録時間を平均40%削減

- 見落とし防止:稀な疾患の検出率を30%向上

2. 金融・投資分野でのリスク分析

GPT-OSSの高度な推論能力を活用した金融リスク分析システム:

def financial_risk_analysis(company_data, market_conditions):

prompt = f"""

企業分析依頼:

企業データ: {company_data}

市場環境: {market_conditions}

分析項目:

1. 財務指標分析(ROE、ROA、負債比率等)

2. 業界ポジション評価

3. マクロ経済影響分析

[...]

"""

return generate_response(prompt, "high", 3000)3. 教育分野での個別指導システム

harmony formatの透明性を活かした教育支援:

| 教育レベル | 活用方法 | 効果測定 | 実装例 |

|---|---|---|---|

| 小中学校 | 段階的解説、つまずき発見 | 理解度20%向上 | 数学問題の解法過程表示 |

| 高等学校 | 受験対策、論理思考訓練 | 模試成績15%向上 | 小論文の論理構造分析 |

| 大学・研究 | 研究支援、文献分析 | 研究効率30%向上 | 論文執筆支援システム |

エンタープライズ導入における技術的課題と解決策

大企業でのGPT-OSS導入における主要な技術的課題と、それらの実践的解決策を詳述します:

1. スケーラビリティとパフォーマンス最適化

課題: 同時アクセス数の増加に伴うレスポンス時間の劣化

解決策:

# マルチGPU分散処理の実装

from accelerate import Accelerator

class DistributedGPTOSS:

def __init__(self, model_path, num_gpus=4):

self.accelerator = Accelerator()

self.model = self.load_distributed_model(model_path, num_gpus)

self.request_queue = asyncio.Queue(maxsize=1000)

async def process_requests(self):

while True:

batch_requests = []

# バッチサイズ分のリクエストを収集

for _ in range(8): # バッチサイズ8

try:

request = await asyncio.wait_for(

self.request_queue.get(), timeout=0.1

)

batch_requests.append(request)

except asyncio.TimeoutError:

break

if batch_requests:

results = await self.batch_inference(batch_requests)

# [結果返却処理...]2. セキュリティとデータプライバシー

課題: 機密データの漏洩リスクとモデルの悪用防止

解決策:

from cryptography.fernet import Fernet

class SecureGPTOSS:

def __init__(self):

self.cipher_suite = Fernet(Fernet.generate_key())

self.audit_logger = self.setup_audit_logging()

def secure_inference(self, encrypted_input, user_id, session_id):

# 入力の復号化(メモリ上でのみ)

decrypted_input = self.cipher_suite.decrypt(encrypted_input)

# 監査ログの記録

self.audit_logger.info({

'user_id': user_id,

'timestamp': datetime.now(),

'action': 'inference_request'

})

# [推論実行とメモリクリア処理...]

return encrypted_result3. コスト最適化とリソース管理

運用コスト分析:

| リソース項目 | 月額費用(120b) | 月額費用(20b) | 最適化効果 |

|---|---|---|---|

| GPU利用料 | $8,000-12,000 | $2,000-3,000 | オンデマンド起動で40%削減 |

| 電力消費 | $1,500-2,000 | $400-600 | 効率的スケジューリング |

| ストレージ | $300-500 | $100-200 | モデル共有で削減 |

| 運用・保守 | $3,000-5,000 | $1,000-2,000 | 自動化で30%削減 |

オープンソースAIエコシステムへの貢献と将来展望

GPT-OSSがオープンソースAI業界に与える長期的インパクトと今後の発展方向性を分析します:

1. 技術標準化への貢献

GPT-OSSの公開により、以下の技術標準化が促進されると予想されます:

- harmony response format:推論過程の可視化標準

- MoEアーキテクチャ:効率的な大規模モデル設計指針

- 推論レベル制御:用途別最適化の業界標準

- 安全性評価:オープンソースAIの安全基準策定

2. 商用AI市場への影響

GPT-OSSの登場により、商用AI市場に以下の変化が予想されます:

| 影響領域 | 短期的変化(1-2年) | 長期的変化(3-5年) | 市場予測 |

|---|---|---|---|

| 価格競争 | API価格の20-30%低下 | オンプレミス移行加速 | 市場規模200%拡大 |

| 技術革新 | 推論特化モデルの増加 | 説明可能AI標準化 | 新カテゴリ創出 |

| 企業戦略 | 内製化検討の加速 | AI開発の民主化 | 中小企業参入増 |

3. 研究・学術分野での波及効果

GPT-OSSの完全オープン化により、学術研究が大幅に加速されると予想されます:

- 再現可能性の向上:研究結果の検証が容易になる

- 改良研究の促進:基盤モデルとしての二次開発が活発化

- 多様性の拡大:特定用途特化モデルの開発が進む

- 安全性研究:オープンモデルでの安全性検証手法確立

GPT-OSSは、OpenAIがこれまで築いてきたクローズドソース戦略からの大きな転換点を示しており、今後のAI業界全体の発展において重要な触媒となることが期待されます。

GPT-OSS導入時の重要な制限事項と注意点

技術的制限と運用上の課題

GPT-OSSを実際の業務環境で安全かつ効果的に運用するため、重要な制限事項と対策を詳細に説明します:

1. harmony format依存による制約

GPT-OSSの最も重要な制約は、harmony response format以外では正常に動作しないことです:

| プロンプト形式 | 動作状況 | 出力品質 | 対処方法 |

|---|---|---|---|

| 標準チャット形式 | 不安定 | 低品質・不整合 | harmony format変換必須 |

| OpenAI API形式 | エラー頻発 | 応答不可 | テンプレート適用必要 |

| harmony format | 正常動作 | 高品質 | 推奨 |

プロンプト変換の実装例:

def convert_to_harmony_format(standard_prompt, reasoning_level="medium"):

"""標準プロンプトをharmony formatに変換"""

return [

{"role": "system", "content": f"Reasoning: {reasoning_level}"},

{"role": "user", "content": standard_prompt}

]

# 既存システムとの互換性維持

class HarmonyCompatibleAPI:

def chat_completion(self, messages, reasoning_level="medium"):

if not self.is_harmony_format(messages):

messages = self.auto_convert_to_harmony(messages, reasoning_level)

return self.generate_response(messages)2. 高いリソース要件と運用コスト

GPT-OSSの運用には従来モデルを大幅に上回るリソースが必要です:

| リソース種別 | gpt-oss-120b | gpt-oss-20b | 従来モデル比較 | コスト影響 |

|---|---|---|---|---|

| GPU VRAM | 80GB必須 | 16GB必須 | 3-4倍増加 | 月額$5,000-8,000増 |

| システムRAM | 512GB推奨 | 128GB推奨 | 5-8倍増加 | 初期投資$10,000増 |

| ストレージ容量 | 2TB(SSD必須) | 500GB(SSD必須) | 4-6倍増加 | 月額$300-500増 |

3. モデルサイズによる実装上の制約

120Bという巨大なパラメータ数は、以下の実装上の制約をもたらします:

- 起動時間:モデル読み込みに5-15分必要

- メモリ断片化:長時間運用でのパフォーマンス劣化

- 障害復旧:システム再起動に長時間要する

- モデル更新:新バージョンへの移行が困難

セキュリティリスクと安全性への配慮

オープンソースモデルとしてのGPT-OSSには、クローズドソースモデルにはない固有のセキュリティリスクが存在します:

1. 悪意のあるファインチューニングリスク

| カテゴリ | gpt-oss-120b | gpt-oss-20b | OpenAI o4-mini | GPT-4o |

|---|---|---|---|---|

| 憎悪表現(hate) | 0.996 | 0.996 | 0.996 | 0.996 |

| 自傷行為誘導 | 0.995 | 0.984 | 1.000 | 1.000 |

| 性的搾取コンテンツ | 1.000 | 0.980 | 0.990 | 1.000 |

| 未成年性的コンテンツ | 1.000 | 0.971 | 0.990 | 1.000 |

| 非暴力的違法行為 | 1.000 | 0.983 | 0.991 | 0.983 |

| 暴力的違法行為 | 1.000 | 1.000 | 1.000 | 1.000 |

| 個人データ制限 | 0.996 | 0.978 | 0.955 | 0.978 |

上記の安全性評価表に示されているように、GPT-OSSは標準状態ではOpenAI o4-miniと同等レベルの安全性を保持していますが、オープンソースの性質上、以下のリスクが存在します。

主要なセキュリティリスク:

- 有害コンテンツ生成:安全フィルターの意図的削除

- バイアス増幅:特定の偏見を強化するファインチューニング

- プライバシー侵害:個人情報抽出を目的とした悪用

- 偽情報生成:意図的な誤情報拡散ツールとしての利用

2. Chain-of-Thought表示による情報漏洩リスク

harmony formatの特徴である思考過程の完全表示は、情報漏洩リスクを伴います:

# 危険な思考過程表示の例

<thinking>

ユーザーが求めている情報は機密性が高い...

内部データベースから以下を参照: [機密データ]

この情報を直接提示するのは適切ではない...

</thinking>

# 上記のような内部思考が意図せず表示される可能性

対策の実装例:

class SecureChainOfThought:

def __init__(self):

self.sensitive_patterns = [

r'パスワード', r'秘密鍵', r'個人番号', r'機密'

]

def sanitize_thinking_process(self, raw_thinking):

"""思考過程から機密情報を除去"""

sanitized = raw_thinking

for pattern in self.sensitive_patterns:

sanitized = re.sub(

pattern, '[機密情報のため非表示]',

sanitized, flags=re.IGNORECASE

)

return sanitized3. 企業利用時の法的コンプライアンス課題

企業でGPT-OSSを利用する際の主要な法的課題:

| 法規制分野 | 主要リスク | 対策要件 | 実装コスト |

|---|---|---|---|

| GDPR(EU) | 個人データ処理の透明性 | データ処理記録・削除機能 | 開発費$50,000-100,000 |

| CCPA(カリフォルニア州) | 個人情報の商用利用制限 | オプトアウト機能・監査ログ | 開発費$30,000-60,000 |

| 金融業界規制 | 投資助言の責任範囲 | 免責事項・人的監督 | 運用費月額$10,000-20,000 |

| 医療業界規制 | 医療機器承認・責任問題 | 臨床試験・認可取得 | 総額$500,000-1,000,000 |

4. 推奨される安全運用ガイドライン

GPT-OSSを安全に運用するための具体的なガイドラインを提示します:

技術的対策:

- 入力フィルタリング:有害プロンプトの事前検出・ブロック

- 出力検査:生成内容の自動品質・安全性チェック

- アクセス制御:ユーザー権限の段階的管理

- 監査ログ:全ての推論実行履歴の保存

運用的対策:

- 人的監督:重要な判断には必ず人的確認を組み込み

- 定期評価:モデル出力の品質・安全性を定期監査

- 教育訓練:利用者への適切な使用方法の教育

- インシデント対応:問題発生時の迅速な対応体制整備

これらの制限事項と対策を適切に理解・実装することで、GPT-OSSの強力な推論能力を安全かつ効果的に活用することが可能になります。特に、harmony formatへの理解と適切な安全対策の実装は、成功的な導入のために不可欠な要素といえるでしょう。