こんにちは、スクーティー代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

Llama 4 って何?他のAIと何が違うの?Metaが発表した最新AI「 Llama 4 」は、画像も理解できるマルチモーダル機能と、MoE(専門家混合)アーキテクチャによる驚異的な効率性が特徴です。Llama 4は、これまでのAIとは一線を画す、分かりやすい「すごさ」を持っています。

例えば、Scoutモデルは業界最長クラスの1000万トークン(小説数冊分!)を扱え、Maverickモデルはトップクラスの性能を驚くほど低コストで実現します。GPT-4oやGeminiといった他の有名モデルと比較しても、特に効率性や長文処理能力で優位性があります。さらに、オープンなライセンス(条件付きで商用利用可)により、多くの開発者が自由に利用・改良できる点も大きな魅力です。

この記事では、Llama 4の核心的な機能と性能、ライセンス、技術的な仕組み、そして安全な使い方まで、重要なポイントに絞って分かりやすく解説します。

Llama 4とは? – 新世代AIの核心

Llama 4の登場:Metaが打ち出すAIの新基準

Llama 4は、Meta社が2025年4月5日にリリースした、最新の大規模言語モデル(LLM)シリーズです。これまでのAIモデルの常識を覆すような、いくつかの重要な特徴を持っています。

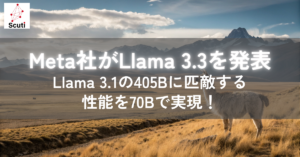

まず一つ目は、「ネイティブマルチモーダル」である点です。これは、テキスト(文字)だけでなく、画像の情報も一緒に理解できる能力を持っているということです。従来のモデルの多くはテキスト専門でしたが、Llama 4は最初から画像と言葉の両方を扱えるように設計されています(早期融合)。これにより、画像の内容について質問したり、画像に基づいた文章を作成したりといった、より高度なタスクが可能になります。

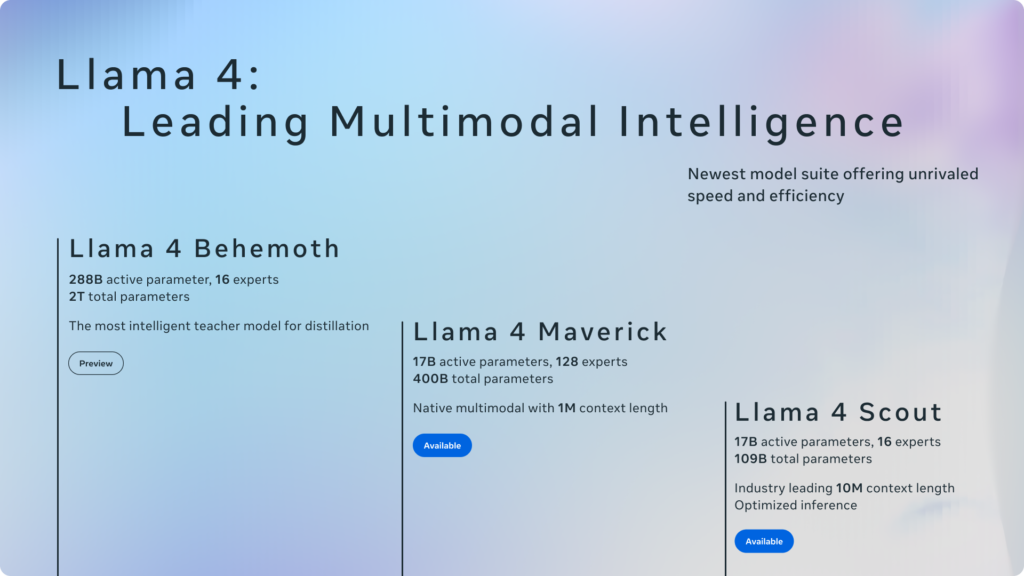

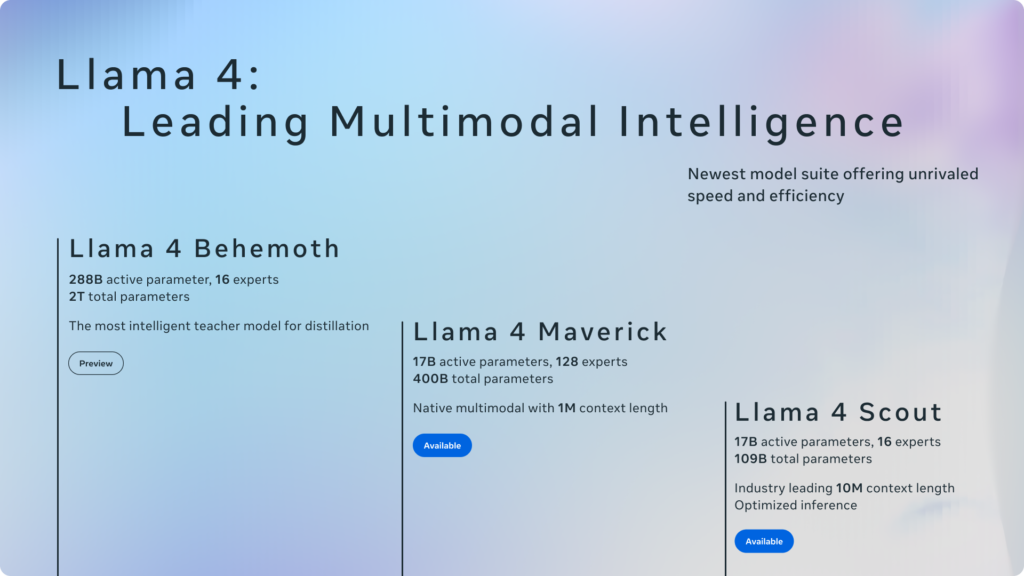

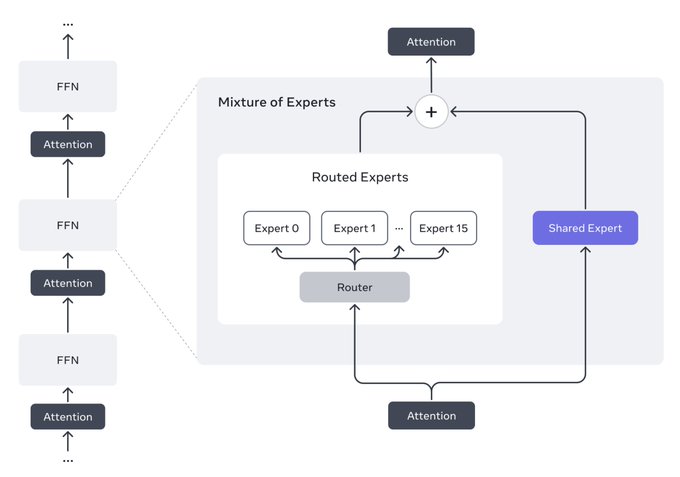

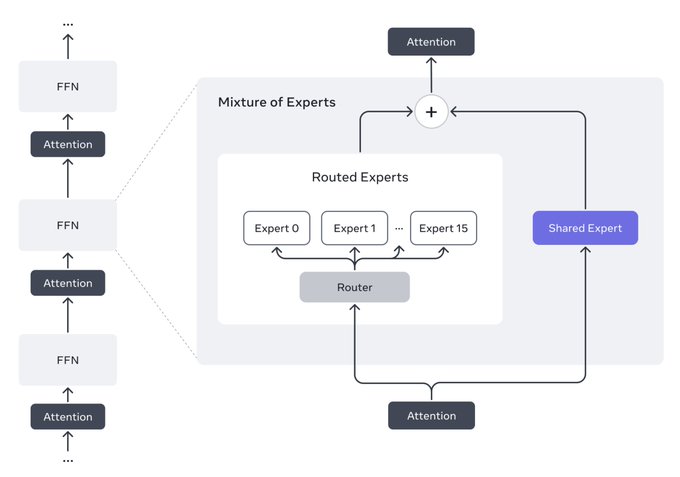

二つ目の大きな特徴は、「MoE(Mixture-of-Experts:専門家混合)」というアーキテクチャを採用している点です。これは、一つの巨大な頭脳で全てを処理するのではなく、それぞれ特定の得意分野を持つ複数の小さな「専門家(エキスパート)」が協力して答えを導き出す仕組みです。Llama 4には、モデルの種類に応じて16個(Scout)または128個(Maverick)のエキスパートが搭載されています。実際に計算を行うパラメータ(アクティブパラメータ)は170億に抑えつつ、モデル全体ではScoutが1090億、Maverickが4000億という膨大なパラメータ数を持ちます。これにより、モデル全体の規模を抑えつつ、非常に高い性能と処理速度、そして電力効率を実現しています。例えるなら、一つの問題に対して、その分野の専門家たちが集まって最適な答えを出すようなイメージです。

さらに、Llama 4は「オープンなアプローチ」を重視しています。Meta社は、Llama 4を研究者や開発者が自由に利用・改変できるように、「Llama 4 Community License」というカスタム商用ライセンスの下で公開しています。このライセンスでは、Llama 4またはその派生物を含む製品やサービスの月間アクティブユーザー数が7億人を超える場合、別途Meta社からのライセンス許諾が必要となりますが、それ以外の場合は基本的に自由な利用が可能です。また、Llama 4を利用して製品やサービスを提供する際には、「Built with Llama」という表示をウェブサイトやドキュメント等に行う必要があります。Llama 4を利用して新たなAIモデルを開発・公開する場合はモデル名の先頭に「Llama」を含める必要があり、ライセンスのコピー添付や著作権表示の保持も求められます。このオープンな姿勢は、AI技術の民主化を促進し、より多くの人々がAIの恩恵を受けられるようにするというMeta社の考えに基づいています。

Llama 4は、これらの特徴により、これまでのAIモデルよりも賢く、速く、効率的で、かつアクセスしやすい存在となっています。まさに、AIの新時代の幕開けを告げるモデルと言えるでしょう。

Llama 4は何がすごい?他のAIとの違いを簡潔に

Llama 4は、既存のAIと比較して以下の点で優れています。

- 深いマルチモーダル理解: テキストと画像を設計段階から統合(早期融合)しているため、単に両方を扱えるだけでなく、その関連性を深く理解できます。

- 圧倒的な効率性 (MoE): 必要な部分(エキスパート)だけが計算を行うため、大規模モデルでありながら少ない計算資源で高速・省電力に動作します。特にMaverickは、競合のDeepSeek v3.1と比較してアクティブパラメータが半分でありながら同等以上の性能を示します。

- 驚異的な長文処理 (Scout): 最大1000万トークンという業界最長クラスのコンテキスト長を扱い、長大な文書分析や長期記憶が必要なタスクを可能にします。

- 高度な多言語対応: 12言語に正式対応し、さらに多くの言語への拡張性も持ちます。

- オープンなライセンスと活発なエコシステム: 開発者が自由(条件付き)に利用・改良でき、多くのパートナー企業やツールによってサポートされています。

これらの点、特に効率性、長文処理、オープン性において、GPT-4oやGeminiなどの他の主要モデルに対するLlama 4の優位性が見られます。

Llamaの前バージョンについては以下の記事をご覧ください!

関連記事:Meta社がLlama 3.3を発表|Llama 3.1の405Bに匹敵する性能を70Bで実現!

Llama 4の主要技術:MoEとマルチモーダル

ネイティブマルチモーダルとは?テキストと画像の「早期融合」

Llama 4の最も注目すべき特徴の一つが「ネイティブマルチモーダル」であり、その核心は「早期融合(early fusion)」にあります。これは、モデルの学習初期段階からテキスト情報と視覚情報を一緒に処理させる設計思想です。

従来の後期融合モデルとは異なり、Llama 4はテキストと画像を別々に理解してから統合するのではなく、最初から両者の関連性を学習します。大量のラベルなしテキスト・画像データを用いたこの学習方法により、人間が目と耳からの情報を自然に統合するように、より深く文脈に即した理解が可能になります。

この能力により、Llama 4は画像に関する詳細な質問応答、画像に基づいた創造的なテキスト生成、複数画像の比較分析といった高度なタスクで優れた性能を発揮します。ただし、現状のモデルでは画像入力は最大5枚まで、画像に関する応答は主に英語で行われる点に注意が必要です。

この画像は、Llama 4のネイティブマルチモーダル機能を示す動画のポスターで、テキストと画像(犬とスケートボード)の組み合わせによるインタラクションを表現しています。

MoEアーキテクチャ:効率性と性能を両立する仕組み

Llama 4が採用する「MoE(Mixture-of-Experts)」は、高性能と高効率を両立させるための重要なアーキテクチャです。これはLlamaシリーズで初めて導入されました。

従来のDenseモデルが全ての計算ユニットを常に使うのに対し、MoEモデルは複数の「エキスパート」を持ち、入力に応じて最適なエキスパートを選択して計算を行います。Llama 4では、Scoutが16個、Maverickが128個のエキスパートを持ちますが、実際に計算に関与するアクティブパラメータ数はどちらも170億に抑えられています。

MoEの利点は以下の通りです。

- 計算効率の向上: アクティブパラメータ数が少ないため、推論やトレーニングに必要な計算コストと時間を大幅に削減できます。

- スケーラビリティ: モデル全体のパラメータ数を増やしても、アクティブパラメータ数を抑えられるため、性能向上とコスト抑制を両立できます。

- 高い性能: 専門家が協力することで、大規模なDenseモデルに匹敵、あるいは凌駕する性能(例: MaverickのMMLU Proスコア80.5)を、より少ない計算量で達成します。

このMoEアーキテクチャが、Llama 4の「アクセスしやすくスケーラブル」な性質を実現する鍵となっています。

Llama 4は、MoE(Mixture of Expert)アーキテクチャを採用したMetaの最初のモデルです。これにより、Llama 4 Maverickのようなモデルを単一のH100 DGXホスト上で実行することが可能になり、展開が容易になります。

Llama 4 モデルラインナップ:Scout, Maverick, そしてBehemoth Preview

Llama 4 Scout (17Bx16E):超長文対応&高効率

Llama 4 Scoutは、特に効率性と長文コンテキスト処理に優れたモデルです。

- スペック: 17Bアクティブパラメータ / 16エキスパート / 109B総パラメータ

- 特徴:

- 業界最長の1000万トークンコンテキスト対応。

- INT4量子化により単一H100 GPUでの動作が可能。

- ネイティブマルチモーダル(テキスト+画像入力、テキスト出力)。

- 12言語対応。

- 同クラスでトップレベルの性能(例: Instructモデル MMMU Pro 52.2、MathVista 70.7)。

- 主な用途: 長文読解・要約、長期記憶を持つエージェント、メモリ効率重視のアプリケーション。

Scoutは、これまで計算資源の制約でLLM導入が難しかった分野に可能性を開きます。

Llama 4 Maverick (17Bx128E):最高レベルの性能とコスト効率

Llama 4 Maverickは、ファミリーの主力であり、高性能と優れたコスト効率を両立しています。

- スペック: 17Bアクティブパラメータ / 128エキスパート / 400B総パラメータ

- 特徴:

- 多くのベンチマークで競合モデルを上回る業界最高レベルの性能(例: Instructモデル MMLU Pro 80.5, GPQA Diamond 69.8)。

- ネイティブマルチモーダル(テキスト+画像入力、テキスト出力)。

- 12言語対応(例: Instructモデル MGSM 92.3)。

- 100万トークンコンテキスト対応。

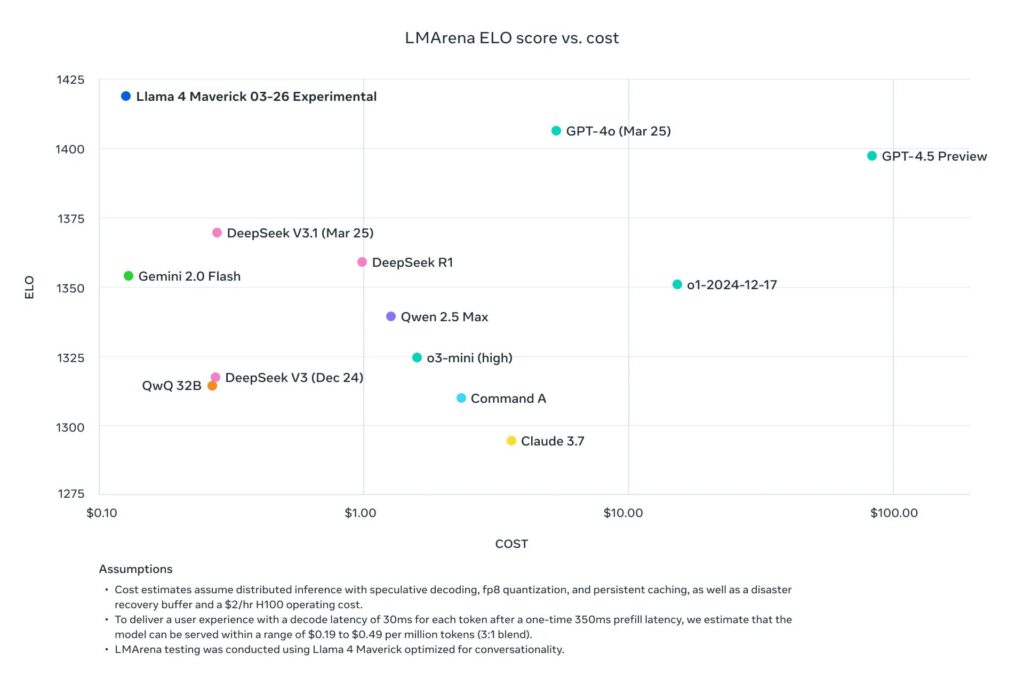

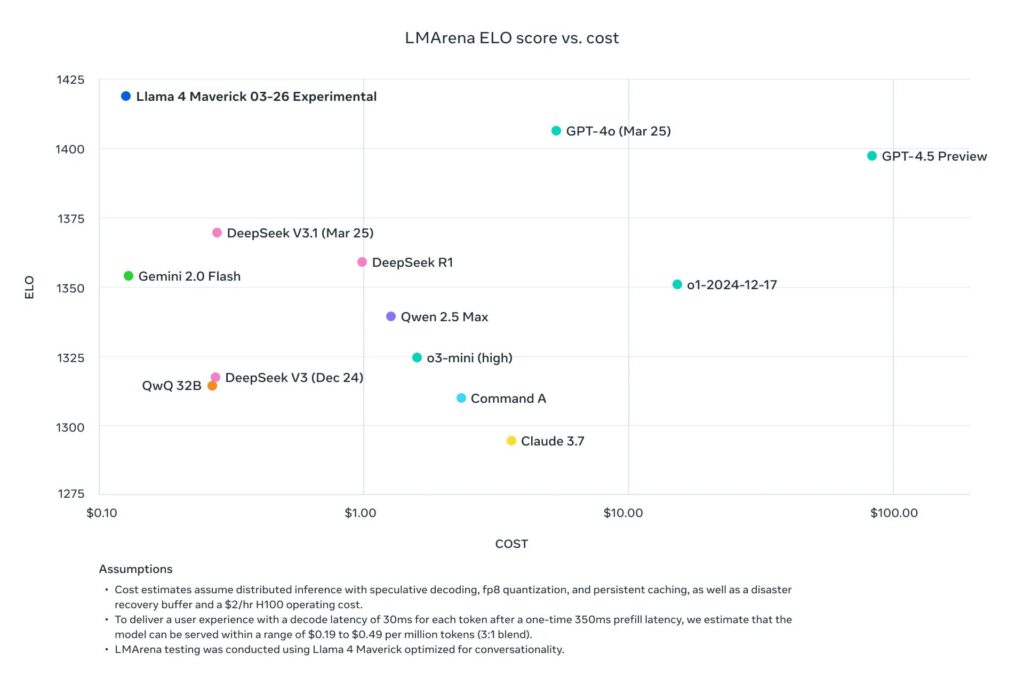

- MoEによる高速応答と圧倒的な低コスト($0.19-$0.49⁵/Mtok)。

- FP8量子化により単一H100 DGXホストで動作可能。

- 主な用途: 高性能チャットボット、画像を含むコンテンツ生成、複雑な問題解決、コーディング支援、多言語サービス。

Maverickは、最先端のAI性能を現実的なコストで利用可能にする、汎用性の高いモデルです。

上記グラフは、Llama 4 Maverickの性能とコスト効率を視覚的に示しています。MMMUベンチマークスコア(縦軸)とトークンあたりの推論コスト(横軸)をプロットしており、Llama 4 Maverickが左上の、つまり「高性能かつ低コスト」の領域に位置していることがわかります。同等以上の性能を持つ他のモデルと比較して、コストが大幅に低いことが示されています。

Llama 4 Behemoth Preview:開発中の「教師モデル」

Llama 4ファミリーには、ScoutとMaverickに加え、現在開発中の巨大モデル「Llama 4 Behemoth」のプレビュー版が存在します。これは、ScoutとMaverickを開発する際の「教師モデル」として重要な役割を果たしました。

教師モデルとは、より小さなモデル(ScoutやMaverick)を効率的に訓練するための手本となる、非常に高性能なモデルです。小さなモデルは教師モデルの出力を学習(蒸留)することで、少ない計算量で高い性能を獲得できます。

Behemoth Previewに関する現在の情報は以下の通りです。

- 位置づけ: Llama 4 ScoutおよびMaverickの蒸留元となった教師モデル。

- 開発状況: Metaによると、リリース時点(2025年4月)でまだトレーニングが継続中の初期プレビュー版です。完成版ではありません。

- 公開状況: モデル自体は一般公開・ダウンロードされていませんが、その存在意義についてはMeta AIブログ (リンク) で解説されています。

- 性能: 教師モデルであるため、ScoutやMaverickを上回る潜在能力を持つと考えられます。実際に一部ベンチマークでは非常に高いスコアが報告されていますが、これらは開発途中の参考値です。

現時点ではBehemothを直接利用することはできませんが、その存在はLlama 4 Scout/Maverickの高い性能と効率性の背景を示すとともに、Metaの今後のモデル開発への期待を高めるものです。

Llama 4の実力は? – ベンチマークと性能評価

Instructモデルの性能:競合モデルとの比較

ユーザー指示に応えるLlama 4 Instructモデルの性能を、主要な競合モデルと比較します。以下の表は、Llama 4 Maverick InstructモデルとGemini 2.0 Flash, DeepSeek v3.1, GPT-4oの性能および推論コスト(100万トークンあたり、入力:出力=3:1の場合)を示したものです。この比較により、Llama 4 Maverickの市場における位置づけがより明確になります。

以下の表は、Llama 4 Maverick Instructモデルと主要な競合モデル(Gemini 2.0 Flash, DeepSeek v3.1, GPT-4o)の性能および推論コスト(100万トークンあたり、入力:出力=3:1の場合)を比較した結果です。この比較により、Llama 4 Maverickの市場における位置づけがより明確になります。

| カテゴリ | ベンチマーク | Llama 4 Maverick | Gemini 2.0 Flash | DeepSeek v3.1 | GPT-4o |

|---|---|---|---|---|---|

| 推論コスト | 1Mトークンあたりコスト (入力:出力=3:1) | $0.19-$0.49⁵ | $0.17 | $0.48 | $4.38 |

| 画像推論 | MMMU | 73.4 | 71.7 | マルチモーダル非対応 | 69.1 |

| 画像推論 | MathVista | 73.7 | 73.1 | マルチモーダル非対応 | 63.8 |

| 画像理解 | ChartQA | 90.0 | 88.3 | マルチモーダル非対応 | 85.7 |

| 画像理解 | DocVQA (test) | 94.4 | – | マルチモーダル非対応 | 92.8 |

| コーディング | LiveCodeBench (10/01/24-02/01/25) | 43.4 | 34.5 | 45.8/49.2³ | 32.3³ |

| 推論 & 知識 | MMLU Pro | 80.5 | 77.6 | 81.2 | – |

| 推論 & 知識 | GPQA Diamond | 69.8 | 60.1 | 68.4 | 53.6 |

| 多言語 | Multilingual MMLU | 84.6 | – | – | 81.5 |

| 長文コンテキスト (chrFスコア) | MTOB (書籍翻訳: 半分) (英⇄KJV) | 54.0 / 46.4 | 48.4 / 39.80⁴ | 128Kコンテキスト長 (評価困難) | 128Kコンテキスト長 (評価困難) |

| 長文コンテキスト (chrFスコア) | MTOB (書籍翻訳: 全体) (英⇄KJV) | 50.8 / 46.7 | 45.5 / 39.6⁴ | 128Kコンテキスト長 (評価困難) | 128Kコンテキスト長 (評価困難) |

注釈:

- Llamaモデルの結果は0ショット評価(temperature=0、多数決や並列計算なし)。高分散ベンチマーク(GPQA Diamond, LiveCodeBench)は複数回の平均。

- 非Llamaモデルは、利用可能な自己報告の最高値を参照(APIやオープンウェイトで再現可能な思考なしモデルのみ)。コストはArtificial Analysisから引用。

- DeepSeek v3.1のLiveCodeBenchは日付範囲不明(49.2)のため、定義された日付範囲での内部結果(45.8)を提供。GPT-4oの結果はLCBリーダーボードから。

- MTOBのような特殊な長文コンテキスト評価は、通常、競合モデルでは結果が公開されていません。そのため、Gemini 2.0 FlashのスコアはMeta社による内部評価の結果であり、Llama 4の優れた長文処理能力を示すための参考値です。DeepSeekとGPT-4oはコンテキスト長が128Kトークンと短いため、このベンチマークでの評価は困難です。

- $0.19/Mトークンは分散推論、$0.30-$0.49/Mトークンは単一ホストでの推定コスト(3:1ブレンド)。

結果のポイント:

- Maverickの優位性: 上記の表が示す通り、Llama 4 Maverickは、多くのベンチマークで主要な競合モデルを上回る性能(例: MMLU Pro 80.5, GPQA Diamond 69.8, Multilingual MMLU 84.6)を示しながら、圧倒的なコスト効率($0.19-$0.49⁵/Mtok)を実現しています。特に、推論、コーディング、長文コンテキスト処理で高い能力を発揮します。

- マルチモーダル性能: 画像関連のベンチマークでは、Llama 4 Maverickは競合のマルチモーダルモデル(Gemini 2.0 Flash, GPT-4o)と比較しても遜色ない、あるいはそれを上回る結果(例: MMMU 73.4, MathVista 73.7)を出しています。DeepSeek v3.1はこの比較ではマルチモーダルをサポートしていません。

これらの結果は、Llama 4 Instructモデル、特にMaverickが、性能、効率性、多機能性のすべてにおいて高いレベルを達成していることを示しており、幅広いアプリケーション開発の強力な基盤となることを裏付けています。

上記で比較されている他の言語モデルに関しては、以下の記事で紹介しています。ぜひご覧ください!

関連記事:Gemini 2.0 全モデル完全解説: Flash, Lite, Proを比較

関連記事:【とにかくすごい】GPT-4oとは?最新モデルと新機能のまとめ

Llama 4を使ってみよう – プロンプトと使い方ガイド

基本的なプロンプト形式と使い方

Llama 4と対話する際の基本的な形式と、Python (Transformersライブラリ) での簡単な使い方を説明します。

基本形式:

モデルへの入力は、役割(system, user, assistant)と内容、そして区切りトークン(<|header_start|>, <|header_end|>, <|eot|>)で構成されます。システムプロンプトでモデルの振る舞いを指示し、ユーザーとアシスタントのターンを交互に記述します。

<|begin_of_text|><|header_start|>system<|header_end|>

(システムへの指示)<|eot|><|header_start|>user<|header_end|>

(ユーザーの入力)<|eot|><|header_start|>assistant<|header_end|>

<!-- ここでプロンプトを終え、応答生成を促す -->Transformersライブラリでの簡単な例:

以下のPythonコードは、Transformersライブラリを使ってLlama 4 Maverick Instructモデルにテキスト指示を与え、応答を得る基本的な流れを示します。

from transformers import AutoProcessor, Llama4ForConditionalGeneration

import torch

model_id = "meta-llama/Llama-4-Maverick-17B-128E-Instruct"

processor = AutoProcessor.from_pretrained(model_id)

model = Llama4ForConditionalGeneration.from_pretrained(model_id, device_map="auto", torch_dtype=torch.bfloat16)

# チャットメッセージの作成 (システムプロンプトとユーザー入力)

messages = [

{"role": "system", "content": "あなたは親切なアシスタントです。"},

{"role": "user", "content": "Llama 4について簡単に教えてください。"}

]

# プロンプト処理

inputs = processor.apply_chat_template(messages, add_generation_prompt=True, return_tensors="pt").to(model.device)

# 応答生成

outputs = model.generate(**inputs, max_new_tokens=100) # 出力長を制限

# デコードして表示

response = processor.batch_decode(outputs[:, inputs["input_ids"].shape[-1]:], skip_special_tokens=True)[0]

print(response)このコードを実行することで、ライブラリが適切なプロンプト形式を生成し、モデルからの応答を得ることができます。画像入力や関数呼び出しも同様の枠組みで行います(詳細は公式ドキュメントやCookbook参照)。

ライセンスと利用条件:オープンな利用のために

Llama 4 Community Licenseの要点

Llama 4は「Llama 4 Community License」というカスタム商用ライセンスの下で提供されています。これは、研究者や開発者がモデルを広く利用・改変できることを目指したものですが、いくつかの重要な条件があります。

- 基本的な利用許可: 非独占的、世界的、譲渡不可、ロイヤリティフリーの限定ライセンスが付与され、Llamaマテリアル(モデル、ドキュメント等)の使用、複製、配布、派生物作成、変更が許可されます。

- 再配布と表示義務:

- Llamaマテリアルやその派生物、またはそれらを含む製品やサービスを配布・提供する場合、本ライセンスのコピーを添付する必要があります。

- 関連するウェブサイト、UI、ブログ投稿、製品ドキュメントなどに「Built with Llama」と目立つように表示する必要があります。

- Llamaマテリアルを使用して新たなAIモデルを開発・公開する場合、そのモデル名の先頭に「Llama」を含める必要があります。

- 配布物には、指定された著作権表示(”Llama 4 is licensed under the Llama 4 Community License, Copyright © Meta Platforms, Inc. All Rights Reserved.”)を含むNOTICEファイルを保持する必要があります。

- 商用利用の制限 (MAU): Llama 4のリリース日(2025年4月5日)時点で、ライセンシーまたはその関連会社の製品・サービスの月間アクティブユーザー数(MAU)が7億人を超える場合は、Meta社から別途ライセンスを取得する必要があります。許諾なしに本契約の権利を行使することはできません。

- 利用規約と法令遵守: 利用は、適用される法律・規制(貿易コンプライアンスを含む)およびAcceptable Use Policyを遵守する必要があります。

- 保証の否認と責任制限: Llamaマテリアルは「現状有姿」で提供され、Metaはいかなる保証も行いません。利用に関するリスクは利用者が負い、Metaはいかなる間接的・結果的損害についても責任を負いません。

- 知的財産権と訴訟:

- 商標ライセンスは付与されません(表示義務に必要な「Llama」マークを除く)。

- 利用者が作成した派生物の所有権は利用者に帰属します。

- 利用者がMetaまたは他者に対し、Llamaマテリアル等が知的財産権を侵害するとして訴訟等を提起した場合、本契約に基づくライセンスは即時終了します。

- 利用者は、Llamaマテリアルの使用・配布に関連する第三者からの請求に対し、Metaを免責し補償する必要があります。

- 契約期間と終了: 本契約は、利用者が同意またはアクセスした時点で開始し、違反があった場合にMetaによって終了されるまで有効です。終了時にはLlamaマテリアルの使用を停止し、削除する必要があります。

- 準拠法と裁判管轄: カリフォルニア州法に準拠し、紛争はカリフォルニア州の裁判所が専属管轄権を持ちます。

利用を開始する前に、必ずライセンス全文を確認し、内容を理解・遵守することが重要です。

安全性と考慮事項:責任あるAI利用のために

Metaの安全戦略とシステムレベルの保護

MetaはLlama 4の安全性を重視し、開発者が責任を持って利用できるよう、モデル自体のチューニングに加え、システムレベルでの保護策を提供しています。

安全戦略の3本柱:

- 開発者支援: 安全で柔軟な体験構築をガイドラインやツールで支援。

- 悪用からの保護: 悪意ある利用を防ぐためのモデル・システム強化。

- コミュニティ保護: ライセンスや連携による誤用防止。

システムレベル保護ツール (Llama Protections):

- Llama Guard: 入力プロンプトとモデル出力を監視し、有害コンテンツをフィルタリングするモデル。

- Prompt Guard: プロンプトインジェクション攻撃を検知・防御。

- Code Shield: 生成されたコードの脆弱性を検出。

これらのツールはPurpleLlamaリポジトリで公開されており、Llama 4アプリケーションへの組み込みが推奨されます。Metaの参照実装ではデフォルトで有効になっています。

評価、レッドチーミング、利用上の注意点

Llama 4の安全性は継続的に評価されています。

- 評価: 一般的なユースケース(チャットボット等)と特定能力(長文、多言語等)の両面から、敵対的データセットや専用ベンチマークを用いてリスクを測定します。

- レッドチーミング: 専門家チームが意図的にモデルの弱点を突き、未知のリスク(CBRNE悪用、児童安全、サイバー攻撃支援など)を発見・評価し、改善に繋げます。

利用上の注意点:

- 予測不可能性と不正確さ: LLMの性質上、出力は完全には予測できず、不正確な情報(ハルシネーション)や不適切な応答を含む可能性があります。知識は2024年8月でカットオフされています。

- テストの限界: 全てのシナリオを網羅したテストは不可能です。特にサポート外言語や限界を超える画像枚数での利用は慎重な検証が必要です。

- 開発者の責任: アプリケーション固有の安全性テスト、チューニング、ガードレールの導入、継続的な監視が不可欠です。Meta提供のリソース活用とライセンス遵守が求められます。

Llama 4は強力なツールですが、その限界とリスクを理解し、責任ある姿勢で利用することが重要です。

Llama 4の情報源とコミュニティ

最新情報と公式リソース

Llama 4の進化に追随するためには、以下の公式情報源の活用が推奨されます。

- Llama公式サイト (https://www.llama.com/): モデル概要、特徴、ベンチマーク、パートナー情報、最新ニュース、ドキュメント、ダウンロードリンクが集約されています。

- ニュースレター (登録ページ): 最新リリースやイベント情報をメールで受け取れます。

- GitHub (meta-llama): モデルカード、ライセンス、使い方レシピ、安全ツール(PurpleLlama)、参照実装などが公開・更新されます。

- Hugging Face Hub (meta-llama): モデルファイルやモデルカードが公開されています。

- Meta AI Blog (https://ai.meta.com/blog/): 詳細な技術解説や研究発表が行われます。

これらのリソースを定期的に確認することで、Llama 4の最新機能を活用し、安全な開発を進めることができます。

エコシステムとコミュニティイベント(LlamaCon)

Llama 4は広範なパートナーエコシステムに支えられています。AWS, Google Cloud, Azureといったクラウドプラットフォーム、Hugging Face, Fireworks AIなどのAI/MLプラットフォーム、NVIDIA, AMDなどのハードウェア企業が連携し、開発者は多様な環境でLlama 4を利用できます。

上記画像(一部抜粋)は、Llama 4をサポートするパートナー企業ロゴの一部を示しており、多様なプラットフォームでの利用可能性を示唆しています。

さらに、MetaはAIコミュニティイベント「LlamaCon」を2025年4月29日に開催予定です。これはLlamaに関する最新情報や技術交流の場となる限定イベントであり、公式サイトから最新情報のためのサインアップが可能です。

Metaは、オープンソースツール提供、業界団体連携、助成金プログラム(Llama Impact Grants)、フィードバック受付などを通じて、コミュニティとの連携を深め、責任あるAIエコシステムの発展を目指しています。